探索CSDN博客数据:使用Python爬虫技术

在数字化的浪潮中,数据的获取与分析变得日益关键。CSDN作为中国领先的IT社区和服务平台,汇聚了海量的技术博客与文章,成为一座蕴藏丰富的数据宝库。本文将引领您穿梭于Python的requests和pyquery库之间,探索如何撷取CSDN博客的点滴信息,并进行初步的数据处理。

前提声明

- 爬虫应遵守目标网站的

robots.txt协议,尊重版权和用户隐私。 - 本代码仅供学习和研究使用,不得用于商业用途。

- 请确保在合法合规的前提下使用本代码。

- 本代码所爬取的数据为公开可选择的博客信息。

目录

- 引言

- 环境准备

- 爬虫代码解析

- 代码解释

- 效果展示

- 注意事项

- 结语

- 全部代码

引言

在数字化时代,数据的获取和分析变得越来越重要。作为一名程序员或数据分析师,我们经常需要从各种在线平台抓取数据以进行进一步的分析或学习。CSDN作为中国最大的IT社区和服务平台,拥有大量的技术博客和文章,是一个丰富的数据源。本文将介绍如何使用Python的requests和pyquery库来爬取CSDN博客的信息,并进行简单的数据处理。

环境准备

在开始之前,确保你的环境中已经安装了Python,并且安装了以下库:

requests:用于发送网络请求。pyquery:一个解析HTML的库,类似于jQuery。

可以通过pip安装这些库:

pip install requests pyquery

爬虫代码解析

import requests

from pyquery import PyQuery as pq# 用户输入CSDN账号

account = input('请输入CSDN ID:')# 构建基本的URL

baseUrl = f'http://blog.csdn.net/{account}'

myUrl = f'{baseUrl}/article/list/1'# 设置请求头,模拟浏览器访问

headers = {'User-Agent': 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

}# 发送请求并获取页面内容

myPage = requests.get(myUrl, headers=headers).text

doc = pq(myPage)# 打印博客的一些基本信息

data_info = doc("aside .data-info dl").items()

for i, item in enumerate(data_info):if i == 0:print("原创:" + item.attr("title"))if i == 1:print("粉丝:" + item.attr("title"))if i == 2:print("喜欢:" + item.attr("title"))if i == 3:print("评论:" + item.attr("title"))# 爬取文章列表

page_num = 1

while True:myUrl = f'{baseUrl}/article/list/{page_num}'myPage = requests.get(myUrl, headers=headers).textif len(myPage) < 30000:breakprint(f'-----------------------------第 {page_num} 页---------------------------------')doc = pq(myPage)articles = doc(".article-list > div").items()for i, item in enumerate(articles):if i == 0:continuetitle = item("h4 > a").text()[2:]date = item("p > .date").text()num_item = item("p > .read-num").items()article_info = [date, title]for j, jitem in enumerate(num_item):if j == 0:article_info.append(jitem.text())else:article_info.append(jitem.text())print(" ".join(article_info))page_num += 1

代码解释

-

用户输入

脚本首先提示用户输入CSDN的ID,这个ID用于构建访问CSDN博客的URL。 -

请求头设置

为了模拟浏览器访问,脚本设置了请求头。这是为了避免被网站的反爬虫机制识别,因为很多网站会检查请求头中的User-Agent来确定访问者是否为真实用户。 -

获取页面内容

使用requests库发送HTTP请求,获取博客页面的HTML内容。这是爬虫的基础步骤,通过发送请求并接收响应来获取网页数据。 -

解析HTML

使用pyquery库解析HTML内容,提取所需的信息。pyquery类似于jQuery,可以方便地选择HTML元素并提取数据。在这个脚本中,它被用来提取博客的原创、粉丝、喜欢和评论数量等信息。 -

爬取文章列表

通过循环,脚本爬取每一页的文章列表,包括文章的标题、发布日期、阅读量和评论数。这是通过构造不同的URL(根据页码)并重复发送请求来实现的。每次循环都会检查响应内容的长度,如果内容过短,则认为已经到达最后一页,循环结束。

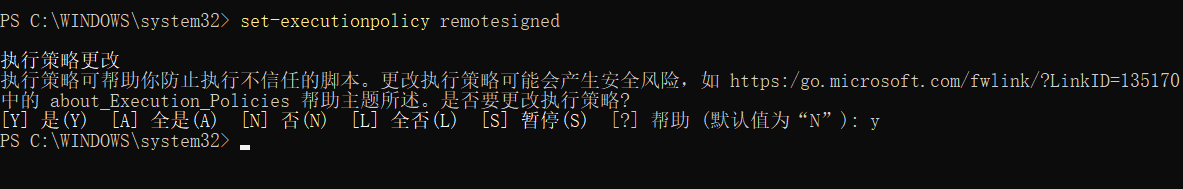

效果展示

注意事项

-

遵守爬虫规范:在进行数据爬取时,应该尊重网站的

robots.txt文件,这是网站所有者设定的爬虫访问规则。合理设置爬取频率,避免在短时间内发送大量请求,以免给网站服务器带来不必要的压力和负担。同时,也要注意不要爬取那些被明确禁止爬取的内容。 -

数据使用:获取的数据应仅用于个人学习或研究,不得用于商业用途。在使用爬取的数据时,应遵守数据的版权和知识产权规定,尊重数据的原创性和所有权。如果数据中包含个人信息,还应遵守相关的隐私保护法规,不得泄露或滥用这些信息。

-

法律风险:在爬取数据前,确保你的行为不违反相关法律法规。不同国家和地区对于数据爬取有不同的法律规定,因此在进行爬取活动前,应充分了解并遵守当地的法律法规。避免侵犯版权、商标权、专利权等知识产权,以及违反个人隐私保护法规。

-

技术道德:在技术实践中,应遵循技术道德,尊重他人的劳动成果。在爬取和使用数据时,应考虑到数据来源网站的利益,避免对网站的正常运营造成影响。同时,也应考虑到其他用户的利益,避免因个人行为而损害社区的整体利益。

-

透明度和责任:在使用爬虫技术时,应保持透明度,对自己的行为负责。如果爬取的数据将被公开或用于研究,应明确数据来源,并在可能的情况下,征得数据所有者的同意。在发现数据中的错误或不准确信息时,应及时更正,并对自己的行为承担相应的责任。

-

持续学习:技术环境和法律法规都在不断变化,因此,作为技术人员,应持续学习最新的技术发展和法律动态,以确保自己的行为始终符合最新的标准和要求。

结语

本文介绍了如何使用Python的requests和pyquery库来爬取CSDN博客的数据,并进行简单的数据处理。CSDN作为中国最大的IT社区和服务平台,拥有大量的技术博客和文章,是一个丰富的数据源。通过这个简单的爬虫脚本,用户可以轻松地获取CSDN博客的数据,进行进一步的分析或学习。

首先,文章强调了爬虫应遵守目标网站的robots.txt协议,尊重版权和用户隐私,并确保在合法合规的前提下使用代码。接着,介绍了环境准备,包括安装Python和必要的库。然后,文章通过详细的代码解析,展示了如何构建URL、设置请求头、发送请求、解析HTML以及爬取文章列表的过程。

代码首先提示用户输入CSDN的ID,以便构建访问的URL。然后,设置请求头模拟浏览器访问,使用requests库发送HTTP请求获取博客页面的HTML内容。利用pyquery库解析HTML,提取博客的原创、粉丝、喜欢和评论数量等信息。通过循环,爬取每一页的文章列表,包括文章的标题、发布日期、阅读量和评论数。

文章还提供了效果展示,通过截图展示了爬虫脚本的运行结果。同时,强调了在爬取数据时应当遵守的规范和法律风险,提醒用户获取的数据应仅用于个人学习或研究,不得用于商业用途。

最后,文章总结了通过这个爬虫脚本,用户可以提升自己的数据处理能力,并在实际工作中应用所学知识。同时,鼓励读者探索技术的无限可能,并在遇到问题时联系作者寻求帮助。

整体而言,这篇文章不仅提供了一个实用的爬虫工具,还强调了在爬取数据时应当遵守的规范和法律风险,对于希望学习网络爬虫技术的读者来说,是一篇很好的入门教程。

在数字化时代,数据的获取和分析变得越来越重要。CSDN作为中国最大的IT社区和服务平台,拥有大量的技术博客和文章,是一个丰富的数据源。本文介绍了如何使用Python的requests和pyquery库来爬取CSDN博客的信息,并进行简单的数据处理。通过这个简单的爬虫脚本,你可以轻松地获取CSDN博客的数据,进行进一步的分析或学习。这不仅是一次编程实践,更是对网络请求、HTML解析和数据处理的深入理解。希望读者能够将所学应用到更多有趣和有益的项目中去,并在实践中不断提升自己的编程能力。如果有任何问题或需要进一步的帮助,请随时联系作者。让我们一起探索技术的无限可能!

全部代码

# 例如输入:lwcwamimport requests

from pyquery import PyQuery as pq# 当前的博客列表页号

page_num = 1account = str(input('print csdn id:'))

#account = "lwcwam"

# 首页地址

baseUrl = 'http://blog.csdn.net/' + account

# 连接页号,组成爬取的页面网址

myUrl = baseUrl + '/article/list/' + str(page_num)headers = {'User-Agent': 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'}

# 构造请求# 访问页面

myPage = requests.get(myUrl,headers=headers).textdoc = pq(myPage)data_info = doc("aside .data-info dl").items()

for i,item in enumerate(data_info):if i==0:print("原创:"+item.attr("title"))if i==1:print("粉丝:"+item.attr("title"))if i==2:print("喜欢:"+item.attr("title"))if i==3:print("评论:"+item.attr("title"))grade_box = doc(".grade-box dl").items()

for i,item in enumerate(grade_box):if i==0:childitem = item("dd > a")print("等级:"+childitem.attr("title")[0:2])if i==1:childitem = item("dd")print("访问:"+childitem.attr("title"))if i==2:childitem = item("dd")print("积分:"+childitem.attr("title"))if i==3:print("排名:"+item.attr("title"))# 获取每一页的信息

while True:# 首页地址baseUrl = 'http://blog.csdn.net/' + account# 连接页号,组成爬取的页面网址myUrl = baseUrl + '/article/list/' + str(page_num)# 构造请求myPage = requests.get(myUrl,headers=headers).textif len(myPage) < 30000:breakprint('-----------------------------第 %d 页---------------------------------' % (page_num,))doc = pq(myPage)articles = doc(".article-list > div").items()articleList = []for i,item in enumerate(articles):if i == 0:continuetitle = item("h4 > a").text()[2:]date = item("p > .date").text()num_item = item("p > .read-num").items()ariticle = [date, title]for j,jitem in enumerate(num_item):if j == 0:read_num = jitem.text()ariticle.append(read_num)else:comment_num = jitem.text()ariticle.append(comment_num)articleList.append(ariticle)for item in articleList:if(len(item)==4):print("%s %s %s %s"%(item[0],item[1],item[2],item[3]))page_num = page_num + 1