6月9日,2023北京智源大会,将邀请这一领域的探索者、实践者、以及关心智能科学的每个人,共同拉开未来舞台的帷幕,你准备好了吗?与会知名嘉宾包括,图灵奖得主Yann LeCun、图灵奖得主Geoffrey Hinton、OpenAI创始人Sam Altman、图灵奖得主Joseph Sifakis、诺贝尔奖得主Arieh Warshel、未来生命研究所创始人Max Tegmark、2021年科学突破奖得主David Baker、2022吴文俊最高成就奖得主郑南宁院士和中国科学院院士张钹等。目前已正式开放大会线上报名渠道。大会将同步向全球线上直播。

北京智源大会倒计时:3天

基础模型前沿技术论坛 | 6月9日下午

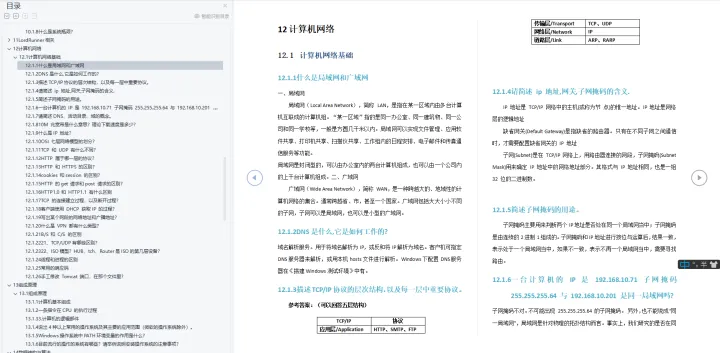

2018年以来预训练语言模型技术将深度学习成功用于大规模无标注数据的自监督学习,显著提升了自然语言处理等任务的性能,人工智能进入基础模型时代。特别是最近由OpenAI发布的ChatGPT展现了强大而通用的自然语言交互能力,引发全球对基础模型的关注。本论坛邀请了国内外在基础模型领域做出开创性工作的一线青年学者,他们既有国际著名的RoBERTa、T5模型的作者,也有国内著名大模型项目紫东太初、智源悟道团队的作者,他们将从基础模型展现的规模和稀疏特性、用户反馈强化学习、多模态等角度,共同研讨基础模型前沿技术。希望与广大同行共同探索基础模型前沿问题,推动基础模型的创新研究与应用。

论坛议程

论坛主席丨主持人

刘知远,清华大学副教授

刘知远,清华大学计算机系副教授、博士生导师。主要研究方向为自然语言处理、知识图谱和社会计算。2011年获得清华大学博士学位,已在ACL、EMNLP、IJCAI、AAAI等人工智能领域的著名国际期刊和会议发表相关论文100余篇,Google Scholar统计引用超过3万次。曾获教育部自然科学一等奖(第2完成人)、中国中文信息学会钱伟长中文信息处理科学技术奖一等奖(第2完成人)、中国中文信息学会汉王青年创新奖,入选国家青年人才、北京智源研究院青年科学家、2020年Elsevier中国高被引学者、《麻省理工科技评论》中国区35岁以下科技创新35人榜单、中国科协青年人才托举工程。担任中文信息学会青年工作委员会主任,中文信息学会社会媒体处理专委会秘书长,期刊AI Open副主编,ACL、EMNLP、WWW、CIKM、COLING领域主席。

演讲主题及嘉宾介绍(按照发言先后顺序)

1、基础大模型(语言)—— 工程化打造AI中的“CPU”

林咏华,北京智源人工智能研究院副院长兼总工程师

林咏华现任北京智源人工智能研究院副院长兼总工程师, 主管大模型研究中心、人工智能系统及基础软件研究、产业生态合作等重要方向。IEEE女工程师亚太区领导组成员,IEEE女工程师协会北京分会的创始人。曾任IBM中国研究院院长,同时也是IBM全球杰出工程师,在IBM内部引领全球人工智能系统的创新。从事近20年的系统架构、云计算、AI系统, 计算机视觉等领域的研究。本人有超过50个全球专利,并多次获得ACM/IEEE最佳论文奖。获评2019年福布斯中国50位科技领导女性。

2、Build an AI system: Applying Reinforcement learning with human feedback (RLHF) on LLM to advance customization

议题简介:大语言模型近期取得了极大的突破,受到广泛关注。新的技术进步有效地提高了人们的生产力。然而, 如果我们想进一步提升其价值,还需要在个性化定制大语言模型上发力, 使其更贴切的输出我们想要的内容。我们需要建立这样一个产品:它可以高效地收集专业人士对大语言模型的反馈 (humans-in-the-loop), 利用人类反馈的强化学习(RLHF)技术, 让大语言模型在不同领域变得更专业化。

刘胤焓,Birch.ai核心创始人及CTO

Cofounder and CTO of BirchAI, where she applies generative AI on healthcare contact centers. Prior to BirchAI, she worked at Facebook AI Research on NLP, where she published papers including Roberta and Bart, mBart.

3、多模态预训练的进展回顾与展望

议题简介:近年来,从预训练模型到预训练大模型,从文本、音频、视觉等单模态大模型,到现在的图文、图文音等多模态预训练大模型,无论在学术界还是企业界预训练模型都得到了广泛关注与爆发式发展。多模态预训练通过联合图文音等多模态内容进行模型学习,其发展在多模态理解、搜索、推荐、问答,语音识别与合成,人机交互等应用领域中具有潜力巨大的市场价值。本报告主要包含三方面内容:分析多模态预训练模型的重要性与必要性;回顾当前多模态预训练的最新研究进展;多模态预训练模型主要应用场景与未来展望。

刘静,中科院自动化所研究员

中科院自动化所研究员/博导,中国科学院大学岗位教授,国家优青获得者。研究方向多模态分析与理解,紫东太初大模型。曾获中国电子学会自然科学一等奖,图像图形学会科学技术二等奖,2022年世界人工智能大会“卓越人工智能引领者奖SAIL”。承担或参与多项国家自然科学基金项目、国家973课题、国家基金重大研究计划、国家重点研发等。已发表高水平学术论文150余篇,谷歌学术引用11000+次,SCI他引次数4000+次,其中有三篇被ESI列为Top1%高被引论文。在视觉计算相关领域的多项国际学术竞赛中荣获冠军10+项。

4、Scaling Large Language Models: From Power Law to Sparsity

议题简介:深度学习的模型容量和训练时间的加倍均可导致模型质量的线性提升,这个被堪称新摩尔定律的Power Law直接促使了各大科技公司在模型容量和训练时长上的军备竞赛(e.g T5, Megatron, PaLM, GPT, etc.) 该讲座将围绕大语言模型的scaling展开,深入浅出的讨论如何用mixture-of-experts方法在不增加运算量的前提下提高模型的容量,以及如何用AutoML搜索出一款最适配目标硬件的的稀疏模型来。

周彦祺,谷歌研究科学家

谷歌研究科学家,曾参与T5等重要模型工作,曾在David Wentzlaff 指导下获得普林斯顿大学博士学位 (2011-2017),并曾于吴恩达带领下的百度SVAIL实验室担任研究科学家(2017-2019)。主要研究兴趣为计算机系统和机器学习,致力于通过稀疏性和自适应计算扩展大型语言模型,并与 ML 共同设计未来系统。

5、圆桌对话

圆桌论坛嘉宾:

刘知远:清华大学副教授丨主持人

周彦祺:谷歌研究科学家

刘胤焓:Birch.ai核心创始人及CTO

刘鹏飞:上海交通大学清源研究院副教授

刘静,中科院自动化所研究员

刘鹏飞,上海交通大学清源研究院副教授

上海交通大学清源研究院副教授,生成式人工智能研究组(GAIR)负责人,专注于自然语言的预训、生成和评估等研究方向;在自然语言处理和人工智能领域发表学术论文 60 余篇。谷歌学术引用 6800 余次。ACL会议史上首次实现连续两年获得System & Demo Paper Award;提示工程(Prompt Engineering)概念最早提出者之一。代表作包括:ExplainaBoard, 高考英语AI, LIMA等工作。

相关阅读

2023智源大会议程公开 | 生成模型论坛

2023智源大会议程公开 | 基于认知神经科学的大模型

大模型浪潮下的平台、框架、AI编译器和芯片架构 | 智源大会AI系统论坛Geoffrey Hinton、姚期智、张钹、Sam Altman等专家共话AI安全与对齐丨2023智源大会议程公开

扫码二维码或点击「阅读原文」报名线下参会&线上直播