来源 | 新智元 ID | AI-era

人人都知,让ChatGPT称霸天下的秘密武器,就是人类反馈强化学习(RLHF)。

而现在,Meta AI等机构的爆火研究LIMA直接打破这一规则,直言RLHF并没有那么重要!

论文一出,直接在AI圈炸了锅!

就连LeCun忍不住发推炫一番:LIMA:LLaMa-65B+1000监督样本=GPT-4/Bard级别的性能。

正如标题所称,LIMA是「Less is More for Alignment」,暗示着一个强大的预训练AI模型,通过几个样本就足以实现高质量的结果。

而LIMA仅在1000个精心挑选的样本上微调LLaMa-65B,而且无需RLHF,就实现了与GPT-4和Bard相媲美的性能。

论文地址:https://arxiv.org/abs/2305.11206

论文中,研究人员将这一突破称为「表面对齐假设」(Superficial Alignment Hypothesis)。

实验证明了,大语言模型在预训练阶段就已习得大部分知识,仅用有限的指令微调数据,足以教会模型产生高质量的内容。

高质量的数据就可以克服小样本量?训练这样模型的成本是多少,这是否意味着小型LLM玩家可以与OpenAI/谷歌竞争?

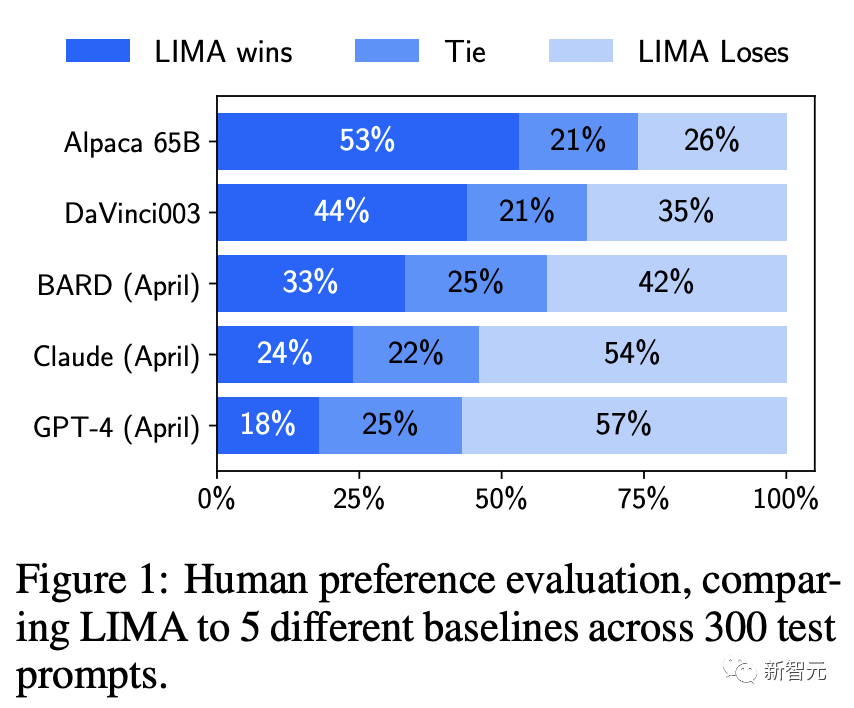

还有网友质疑,GPT-4在57%情况中击败LIMA,还能说性能相当?

RLHF并非王者?

大语言模型经过预训练,能在大规模上预测下一个token,让其学习通用表征。这些表征可以转移到几乎任何语言理解或生成任务中。

为了实现这种转移,人们已经提出各种「对齐」语言模型的方法,主要侧重在百万级token上进行指令调优。

而最近采用较多的是,从人类反馈中进行强化学习(RLHF)。这些反馈便是在与人类标注者进行数百万次互动中收集的。

ChatGPT令人深刻的表现,主要归功于RLHF。根据OpenAI的思路,RLHF分为三步。

然而,现有的对齐方法代价是高昂的,需要大量算力,以及专门的数据才能实现像ChatGPT一样的性能。

Meta AI却要逆行其道,证明了,一个预训练语言模型可以通过简单地微调精心挑选的1000个样本,就能实现强大的性能。

在此,研究人员提出「表面对齐假设」(Superficial Alignment Hypothesis),假设「对齐」可以是一个简单的过程,。

在这个过程中,模型的知识和能力几乎完全是在预训练期间学习的,而「对齐」只告诉模型学习与用户交互的风格或格式

为了验证这个假设,Meta等研究者挑选了1000个近似于真实用户提示,以及高质量响应的样本。

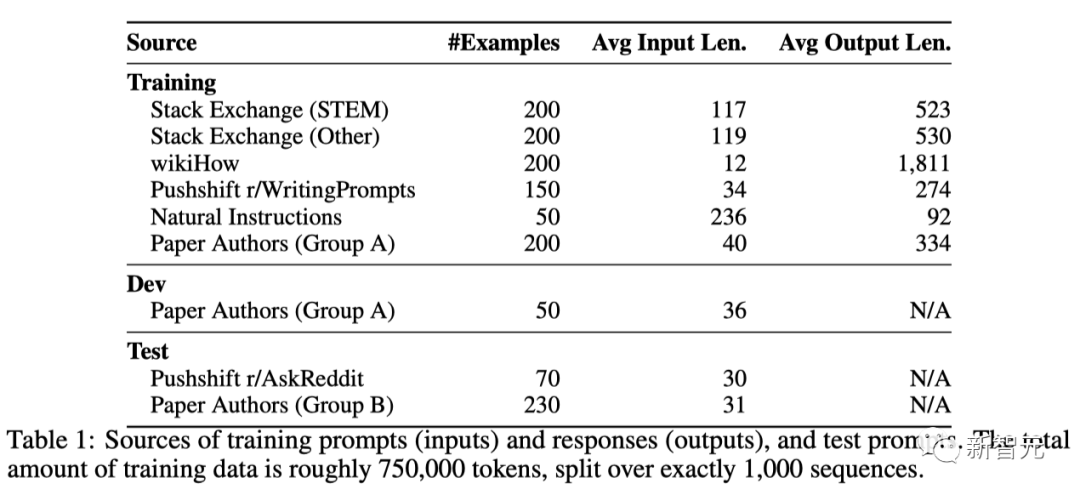

他们从其他研究论文、WikiHow、StackExchange和Reddit等来源进行手动挑选,训练数据的总量大约是750,000个token。

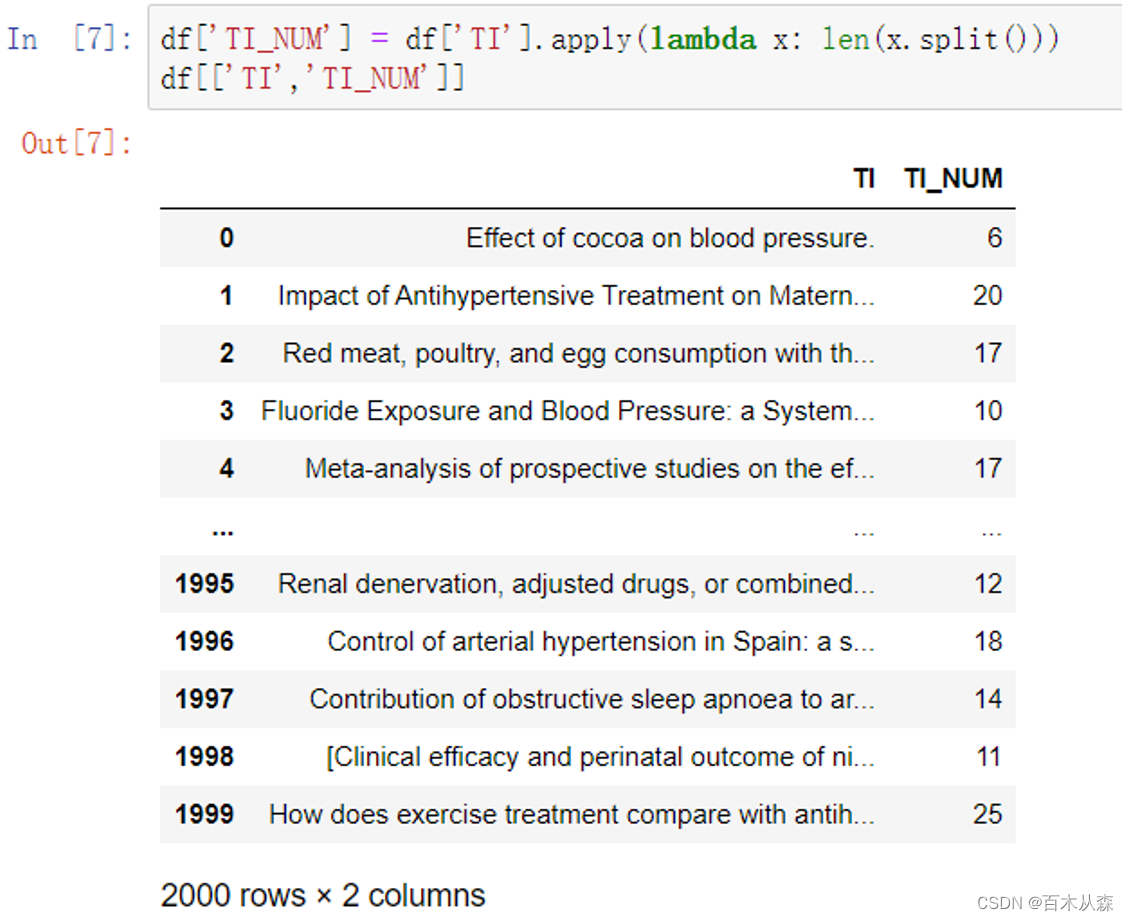

训练提示(输入)、响应(输出)以及测试提示的来源

此外,研究者手动编写了250个提示和响应的样本,同时对任务的多样性进行了优化。

最后,研究人员对预训练LLaMa 65B模型在1000个样本集上进行微调,并进行了人类评估。

评估结果

Meta将LIMA与5个模型基准进行了比较:(在2023年4月期间,对所有基准的响应进行了采样)

Alpaca 65B——利用52,000个样本对LLaMa 65B微调后得到的大模型

DaVinci003——基于RLHF训练的大语言模型

Bard——基于谷歌的PaLM模型

Claude——通过强化学习Constitutional AI训练的52B参数模型

GPT-4——目前使用RLHF训练的最强的模型

为了比较LIMA和其他SOTA模型,Meta为每个测试提示生成一个单一的响应。

然后,要求人类参与者将LIMA的输出与每个基准进行比较,并标记他们更喜欢哪一个。

在人类偏好研究中,尽管Alpaca 65B的训练数据量是LIMA的52倍,但它产生的输出往往比LIMA的不如人意。

让人大跌眼镜的是,DaVinci003也是同样的情况,虽然程度较小。该模型使用了RLHF进行训练,这本应是一种更优越的对齐方法。

而Bard在42%的时间中,其产生的回答优于LIMA。这也意味着,剩下的58%时间里,LIMA的响应至少和Bard一样优秀。

最后,研究者发现,虽然Claude和GPT-4通常表现得比LIMA更好,但在一些情况下,LIMA实际上能产生更好的回答。

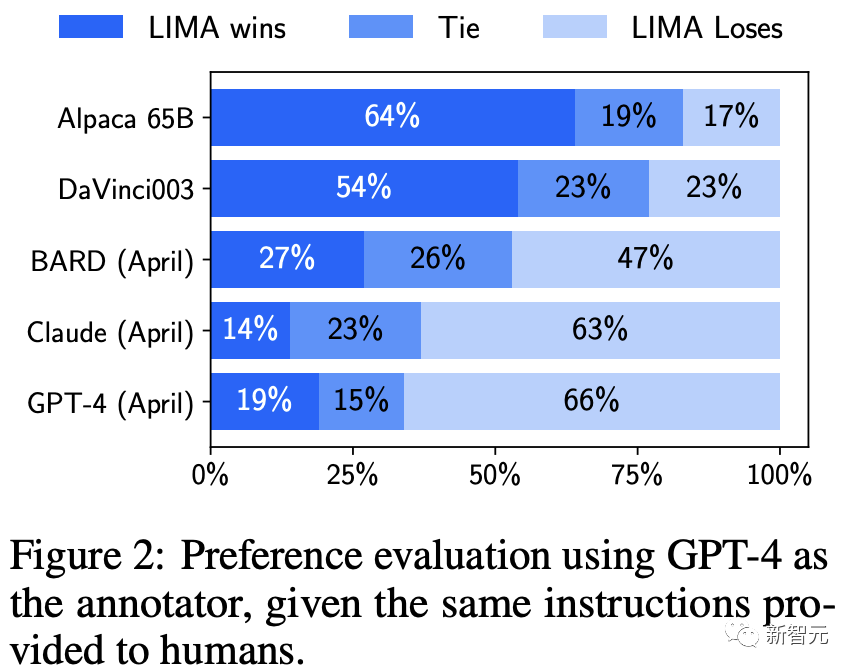

另外,讽刺的是,在GPT-4的偏好研究中,有19%的时间,GPT-4更喜欢LIMA的输出。

「表面对齐假设」

Meta将这一发现定义为「表面对齐假设」(Superficial Alignment Hypothesis)。

它表明,所谓预训练后的对齐阶段,主要是让模型学会一种特定的风格或格式,这种风格或格式在与用户交互时可以被模型回忆起来。

因此,「微调」更多是关于风格,而不是实质。

LIMA的结果表明,实际上,利用简单的方法就可以解决对齐和微调AI模型这类复杂问题。

这与诸如OpenAI的RLHF那些,特别繁琐和复杂的微调过程,形成了鲜明的对比。

不过,LIMA也不是万能的。Meta认为,该方法存在两个明显的局限:

第一,用高质量的示例构建数据集是一种非常具有挑战性的方法,很难扩展。

第二,LIMA并不像已经有产品的模型那样强大,比如GPT-4。

团队表示,虽然LIMA的生成结果,在大部分情况下质量都很高。但一个「对抗性的提示」或一个「不走运的样本」,依然会让模型产生不理想的答案。

Yann LeCun对GPT-4和类似模型背后努力的相对贬值采取了务实的看法。

他将大型语言模型看作是近期的一个元素,至少在中期内不会「在没有重大变化」的情况下发挥作用。

以上,主要评估是根据最先进的模型对LIMA进行评估,但需要明确的是,其中一些模型实际上已经在训练期间使用了数百万真实用户的提示。

对此,研究人员通过手动分析50个随机示例来进行绝对的评估。

并将每个示例标记成3个类别:Fail,响应不符合提示符的要求;Pass,响应符合;Excellent,对提示提供了优秀的响应。

实验结果显示,50%的LIMA回答被认为是优秀的,它能够遵循所有的50个分析提示中的44个。

如下,LIMA针对育儿建议和生成食谱的示例进行的输出。

另外,一个仅在1000个样本上微调的模型在多轮对话中表现又如何?

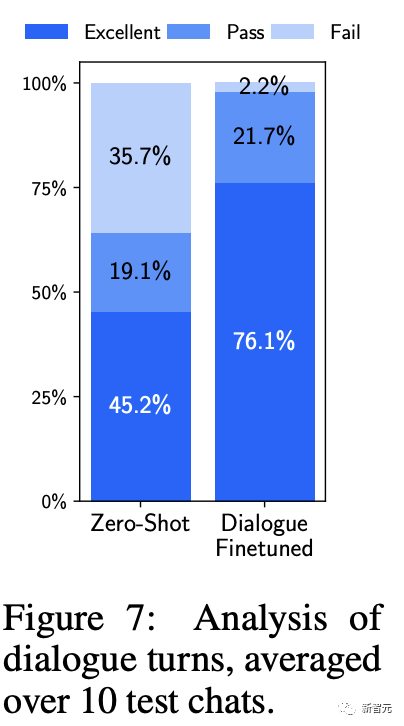

在零样本上,LIMA的响应出奇地连贯,并引用了前面对话的信息。在10次对话中,LIMA有3次未能遵循提示。

为了提高对话能力,研究人员收集了30个多轮对话。其中10个是由作者手动编写,20个来自Stack Exchange,并根据助手风格进行编辑。

研究者使用组合的1,030个示例对预训练模型进行微调,得到一个新版本的LIMA,并针对相同的提示进行了10次实时对话。

实验发现加入这30个示例后生成质量显著提升,优质响应比例从45.2%提高到76.1%!

LIMA如何以「少」胜「多」

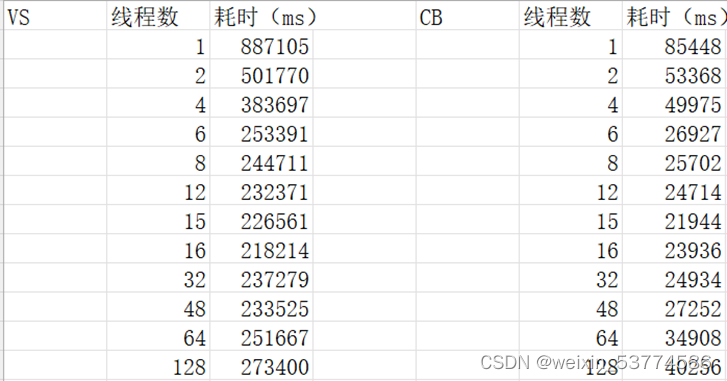

团队通过消融实验,研究了训练数据多样性、质量和数量的影响。

Meta发现,为了对齐目的,提高输入多样性和输出质量有可测量的正面效应,而单独增加数量却没有。

实验设置

团队在各种数据集上微调了一个拥有70亿参数的LLaMa模型,并控制了相同的超参数。

团队对每个测试集提示抽取5个回应,并通过让ChatGPT(GPT-3.5 Turbo)在1-6的Likert量表上评级回应的帮助性来评估回应质量。

多样性

为了测试提示多样性的影响,同时控制质量和数量,团队比较了在质量过滤后的Stack Exchange数据和wikiHow数据上的训练效果。

图5显示,更多样的Stack Exchange数据显著提升了模型的性能。

质量

为了测试响应质量的影响,团队从Stack Exchange抽取了2000个没有任何质量或风格过滤的示例,并比较了在这个数据集和过滤后的数据集上训练的模型。

图5显示,在过滤和未过滤的数据源上训练的模型之间存在着0.5点的差异。

数量

在众多机器学习设置中,都会采用增加示例数量的策略,来提升性能。

为了测试其影响,团队从Stack Exchange中抽取了呈指数增长的训练集。

但实际上,如图6所示,数据翻倍的训练集并未改善响应质量。

如此一来也暗示了,对齐的规模法则不必然只受数量影响,而更可能是在保持高质量响应的同时,提升提示的多样性。

作者介绍

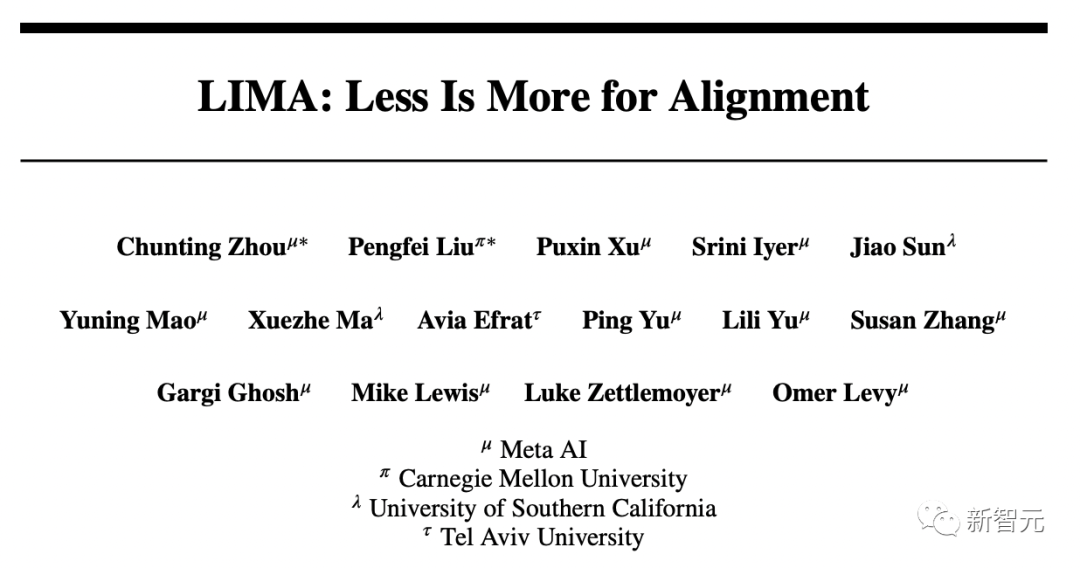

Chunting Zhou是Meta AI的一名研究科学家。

2022年5月,她在卡内基梅隆大学语言技术研究所获得博士学位,在那里从事自然语言处理工作,导师是Graham Neubig。Zhou的主要研究兴趣在于自然语言处理和机器学习的交叉领域,并对开发对分布变化具有鲁棒性的方法感兴趣,目的是学习模型能够在各种群体中表现统一。

此外,Zhou还研究生成模型,及其在自然语言处理任务中的应用。

参考资料:

https://arxiv.org/abs/2305.11206