关于“元宇宙”的讨论越发火热,而建设元宇宙不可避免需要布设基础设施,LiveVideoStackCon 2022 北京站邀请到PPIO边缘云联合创始人——王闻宇,同大家探讨元宇宙网络时延的最优解–边缘云基础设施的架构与建设,并介绍PPIO边缘云在泛云游戏领域的一些思考和实践。

文/王闻宇

编辑/LiveVideoStack

“元宇宙“源于1992年出版的美国著名科幻小说——《雪崩》(Snow Crash)。

在他的描绘中,所有现实世界中的人在元宇宙中都有一个“网络分身”。数字世界主干道灯火通明,可容纳数百万人的“网络分身”在街上往来穿行。

包括后来的《黑客帝国》《头号玩家》《赛博朋克2077》等所有元宇宙作品,都描述的是在视网膜级视觉体验中,也就是人的视觉完全沉侵在虚拟的计算机世界中。

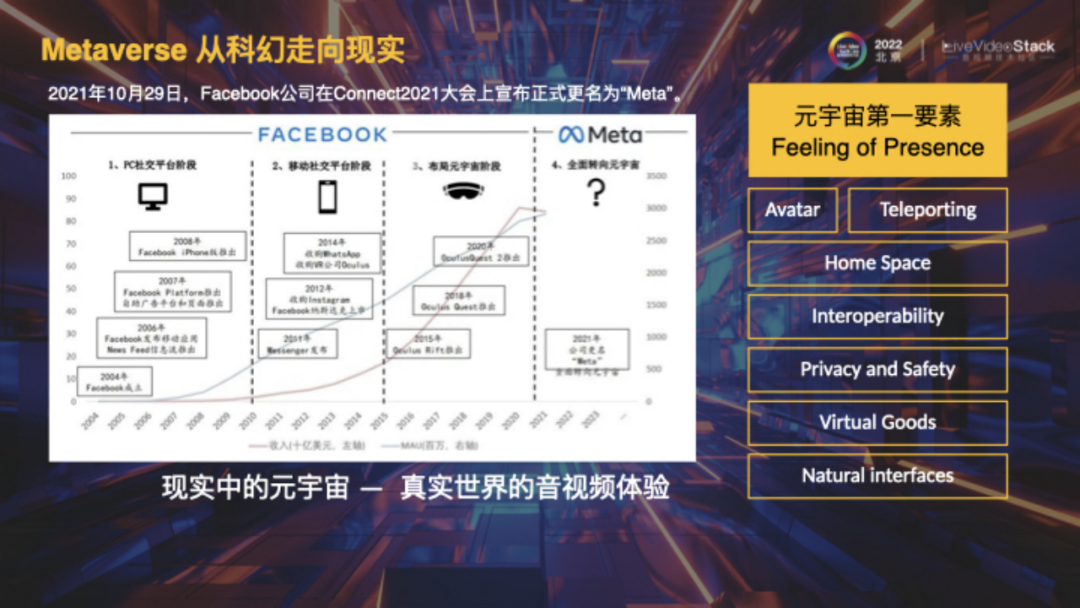

2014年,Facebook以23亿美元收购了Oculus,并在VR业务上持续投入了大量研发费用。Facebook和Ray-Ban公司研发轻便型AR眼睛——Ray-Ban Stories,并且研发Project Nazare从而实现MR眼镜。

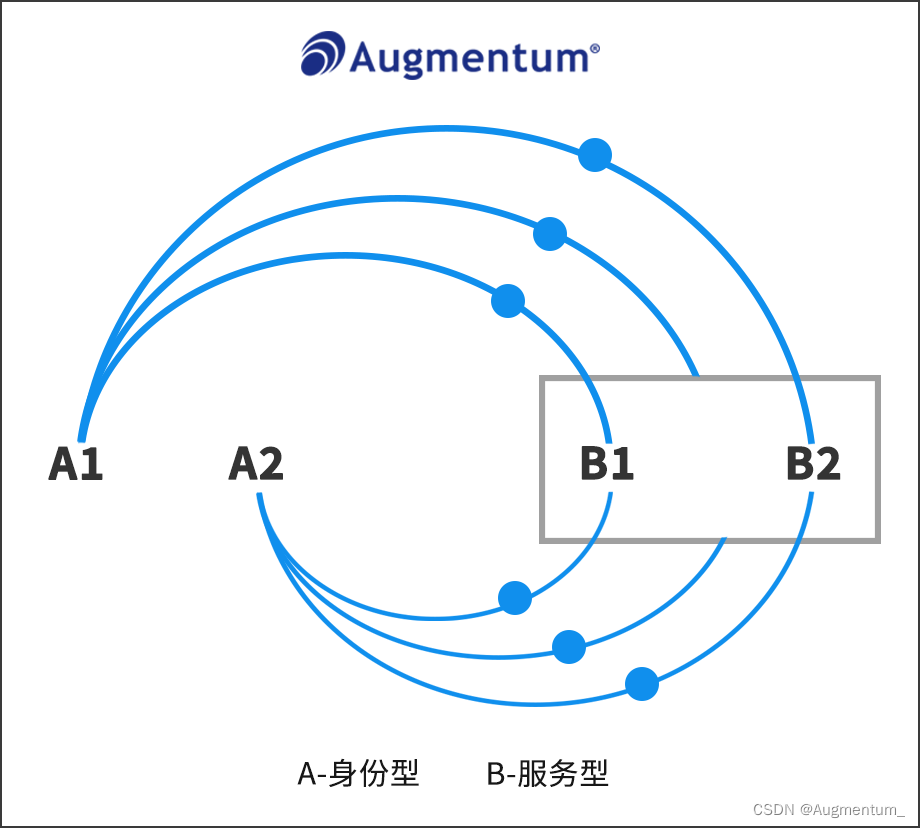

Facebook提炼出了元宇宙的8个特点:

①身临其境感(Feeling of Presence)②虚拟形象(Avatar);

③家庭空间(Home Space)④远距离传输(Teleporting);

⑤互操作性(Interoperability)⑥隐私安全(Privacy and Safety);

⑦虚拟物品(Virtual Goods)⑧自然界面(Natural interfaces)。

第一要素是身临其境感,即完全把人类的视听觉包裹在沉浸世界中。

近期AIGC发展势头很足,包括ChatGPT及AI作图Midjourney等产品的诞生,都彰显着AI已经进入新的高速发展的时代。元宇宙和AI结合的终局会是怎样呢?我设想未来会有一款超级设备,首先用脑机接口从人脑中读取信息,再通过AIGC实时生成完全3D且高清的画面,通过AI设备实时回传到人的神经视觉中,从而实现“所想即所得”的状态,即想到的事情会瞬间反映为所见所听。

在我看来,不论科幻还是现实,元宇宙终极追求的是,类真实世界的音视频体验。我提出了“视网膜级视觉体验”,那么技术上要如何做到呢?且看下文分享。

我是王闻宇,现任PPIO边缘云联合创始人、CTO。我从2004年开始做音视频,当时的网络情况较差,我在学生宿舍写出PPTV第一版,后来主导了PPTV的音视流,P2P/CDN,点播,直播,编解码等,担任PPTV首席架构师。2014年暂时地离开音视频行业,联合创办极豆车联网,服务BBA车厂。2018年与原PPTV创始人姚欣联合创办了PPIO边缘云,发展靠近用户侧的边缘节点,提供边缘的算力,传输,存储业务,主要服务音视频行业。

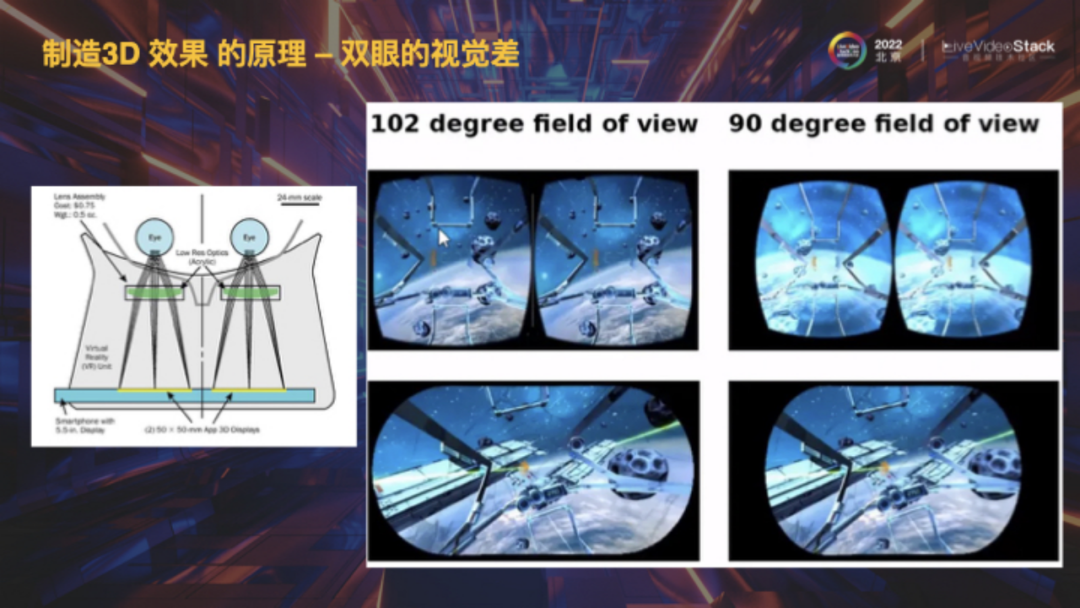

VR的视觉原理是靠双眼产出不同图像后在大脑中产生视觉差,继而大脑通过细微差距计算输出3D效果。也就是说要使人眼产生3D视觉,就必须渲染出两种不同的画面。

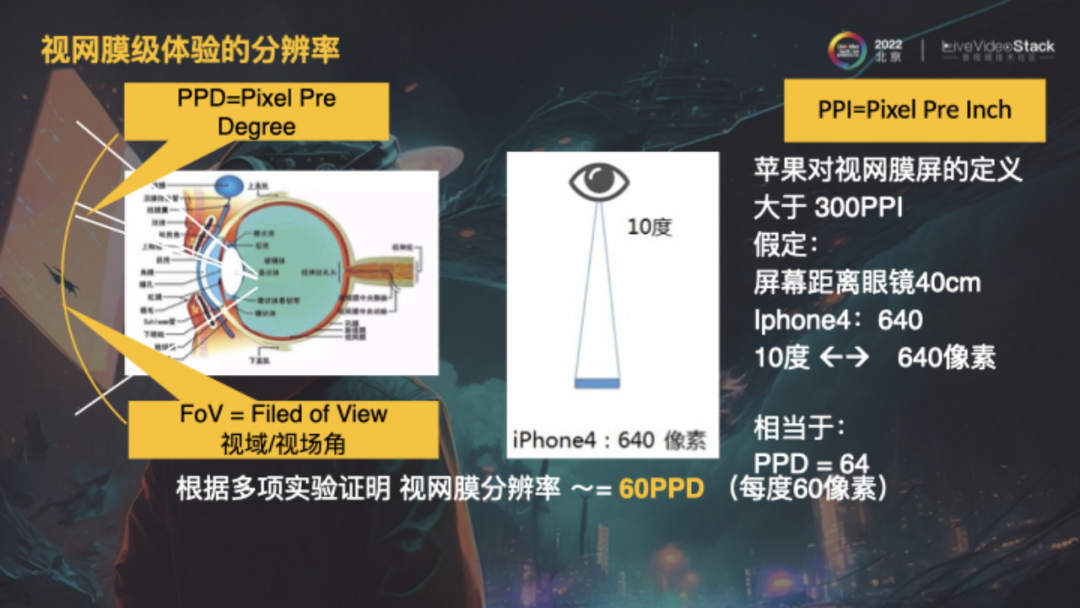

大家可能疑惑多少分辨率才能实现视网膜级体验。图中是人眼结构,PPD是每度像素,FoV是视域/视场角。视网膜屏最初由苹果定义,假设手机屏幕距离人眼40cm,视场角为10度,覆盖640像素,推演得到300PPI,此时的人眼分辨率最精准。iPhone 14的PPI已经提升到了460,这是因为iPhone 14假设屏幕距人眼25cm。根据iPhone 4和14进行倒推,同时我浏览了大量关于人眼精度的测验报告,根据多项实验证明,视网膜分辨率大概是60PPD,即每度60像素。

图中数据来自多位科学家的实验结果,既然我们已经知道了PPD是60,那么FoV又是多少?人眼是一个非常精细的器官,中心地带的视觉比较清晰,周围则较模糊。大量资料中提到窄域和宽域,窄域是人眼感知非常精确的部位,视场角大概是60度,宽域是眼球不刻意转动时单眼的视场角,大概是25度,双眼会更高。

为了达到视网膜级视觉体验,元宇宙设备需要覆盖宽域,这是因为戴在眼睛外,需要达到全方位清晰。将124度乘以60PPD,得出7740,由于人眼是球状的,所以分辨率接近7740*7740,计算得出像素在6000万左右。

对比当前常见的分辨率,人眼宽域最高精度是单眼超过的8K多一些,也就是说元宇宙设备的分辨率必须达到8K,才能实现视网膜级视觉体验。

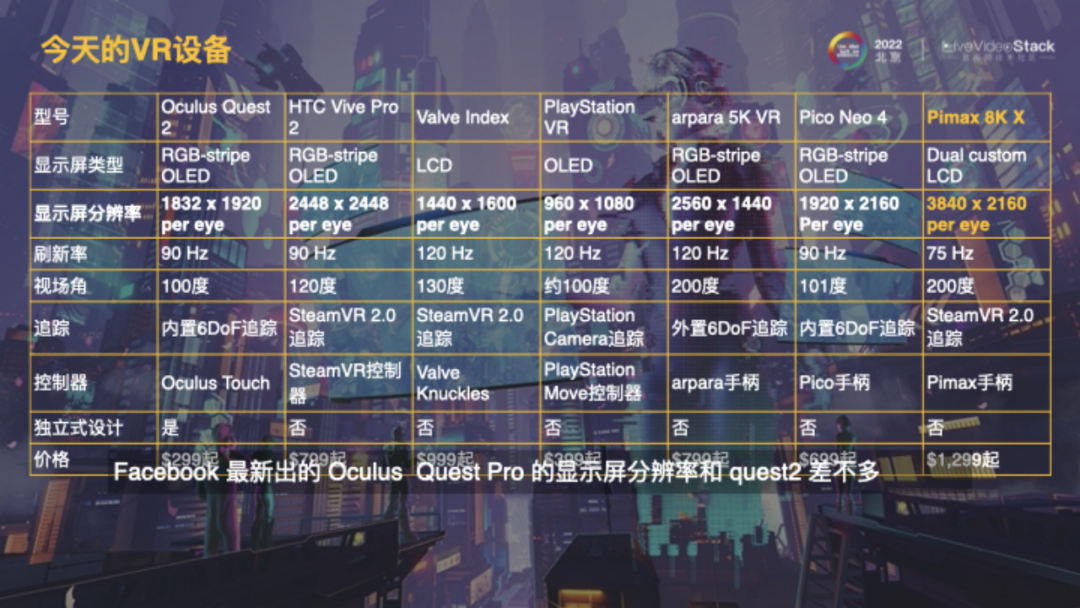

图中是当今世界主流VR设备的参数,目前最先进的是Pimax 8K X,分辨率达到单眼3840*2160,当然其价格较贵,(不属于消费级产品,用于工业为主),距离视网膜级视觉体验要求还差3-5倍,所以可能还需5-10年才能出现一款达到要求的设备。

AR设备运用了光学反射原理,其FoV难以做高。右侧是市面上所有AR设备的参数,可以推断AR设备达到视网膜级视觉体验至少还需10年。

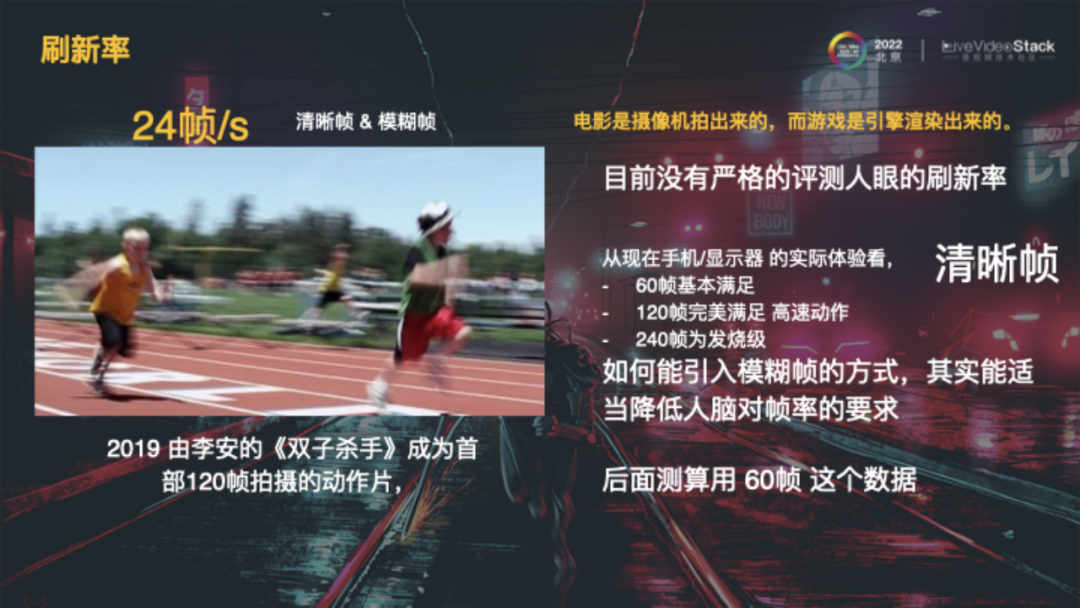

另一个概念是刷新率,即达到类真实事件体验时每秒出现的画面帧数,目前没有严格的评测人眼的刷新率。电影界共识是24帧/s可以让人眼感受不到画面晃动。从现在手机/显示器的实际体验来看,60帧基本满足显示效果,120帧完美满足高速动作(一般PFS射击游戏玩家会比较在意),240帧则为发烧级。在后面的测算都采用的60帧。

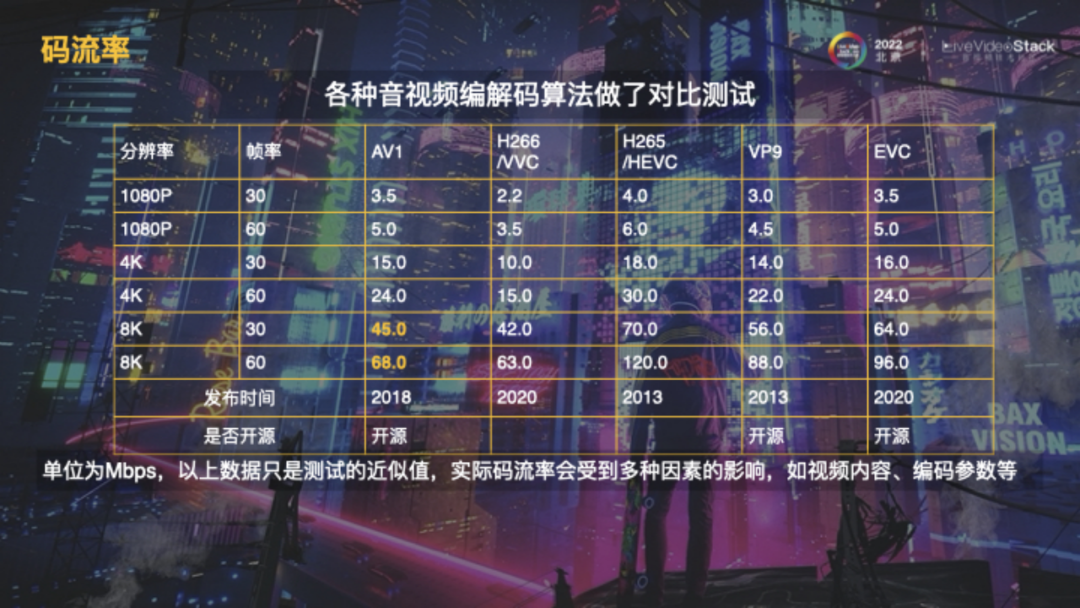

那么60帧、8K的画面需要多少码率呢?以上是截止2020年的音视频编解码算法评测数据,其中表现较好的是AV1,即单眼68Mbps的码率。这里差不多,内容不同,会有些差些,我们暂时采纳这个数字来作为测算。

图中总结了目前消费级的能够支持8K分辨率,120Hz的渲染显卡。整体看来,无论是NVIDIA还是AMD,它们的功率基本在350w左右,重量大概为2kg,所以实时渲染8K高清画面的发热量和重量都非常高。

我以最新的NVIDA GeForce RTX 4090为样本进行了测算,试想无论是VR或AR设备,在终极状态下,为了实现双眼8K的算力,需要承载两张4090显卡,其发热量相当于一匹空调,重量达到5kg,再加上电磁辐射,结论是不可能在人们的头上戴这样的设备。要解决视网膜级视觉体验,唯一的办法就是引入串流方案。从云端或者局域网,通过串流方式到达VR/AR设备,此时的VR/AR设备仅仅作为渲染和反馈的终端,而非计算终端,这是未来必然的趋势。

大家可能会说,芯片技术不断发展,也许几年后能够做小做轻。

右侧是iPhone芯片工艺的发展历史,从2007年的90nm到2022年的4nm,其遵循的摩尔定律即将达到极限,1nm相当于3-5个原子紧密排列的长度,若继续压缩,会出现热效应、量子效应、成本及工艺问题,这都意味着其不可能性。

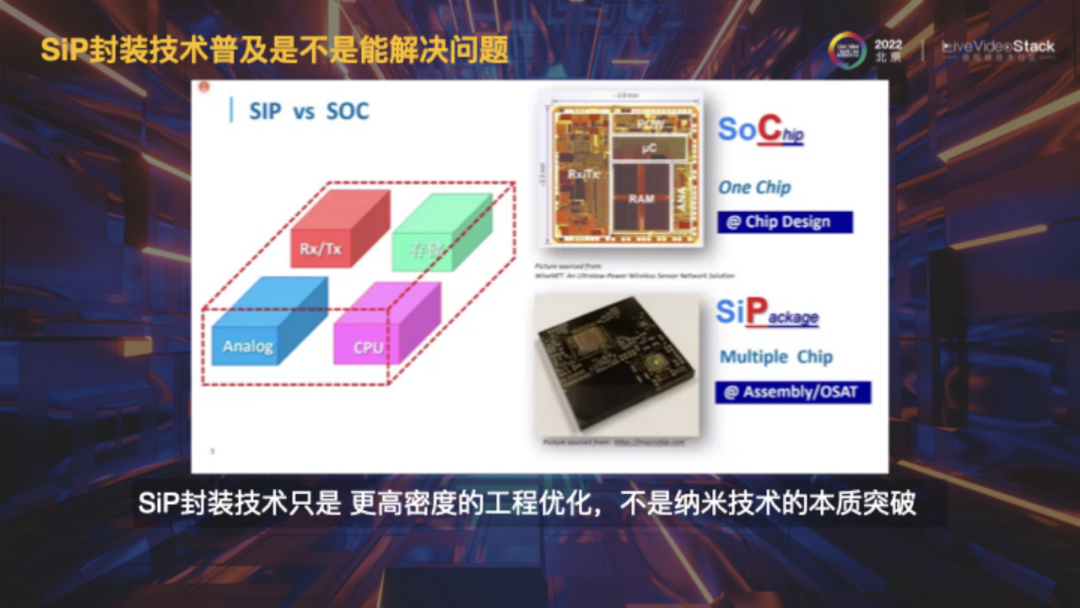

从事芯片相关行业的同学可能会提出SIP封装技术,但SIP封装技术只是更高密度的工程优化,并不是纳米技术的本质突破,它可以通过堆叠提高算力,但无法降低重量和发热量。

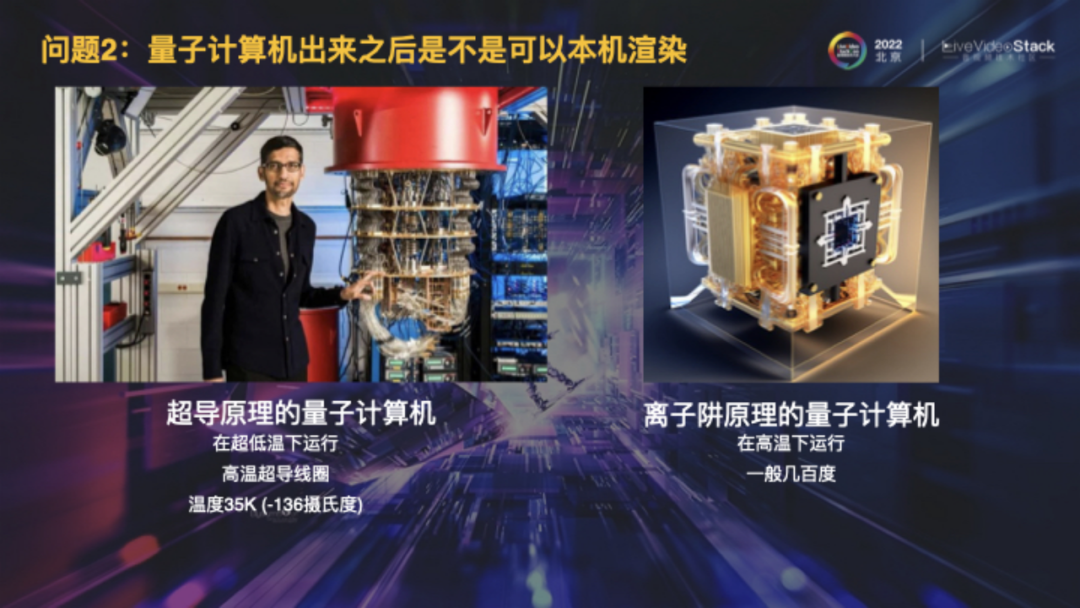

前不久可能大家也听说了,量子计算机取得了大的突破,资料显示量子计算机的原理主要包括超导原理和离子阱原理,前者需在超低温下运行,后者在高温下运行,无论如何都无法存在于日常家庭中,即使要用也只可能放在云端机房。

综上,在能预见到的未来,要实现终极的视网膜级视觉体验,是无法摆脱音视频串流技术方案的。

提到串流,不得不考虑一个问题:VR设备为什么会导致眩晕?

这是由于大脑感觉“被欺骗”,包括瞳距、景深等问题,但难解决的是M2P时延问题,即运动到光子的时延,当人的头移动后,画面是否能足够低时延地反映效果,若是慢了,大脑会产生“被欺骗”的感觉,从而引发M2P时延。许多评测数据显示,低运动状态下,M2P时延不能高于20ms,高运动状态下,M2P时延不能高于7ms。

在当下的串流方案中,包括编码、解码和传输环节,即使做到极限,也很难达到20ms的响应值,基本在30-100ms之间。最复杂的瓶颈在网络时延环节,因为它和基础设施有关,和非常分散的网络环境部署相关,不是仅仅单方面的努力就能改善的。

因此,要用边缘云的方案来解决这样的问题,也就是要将算力放在靠近用户的边缘,在这可以分布式应对高并发、大带宽、能真正地做到低时延。

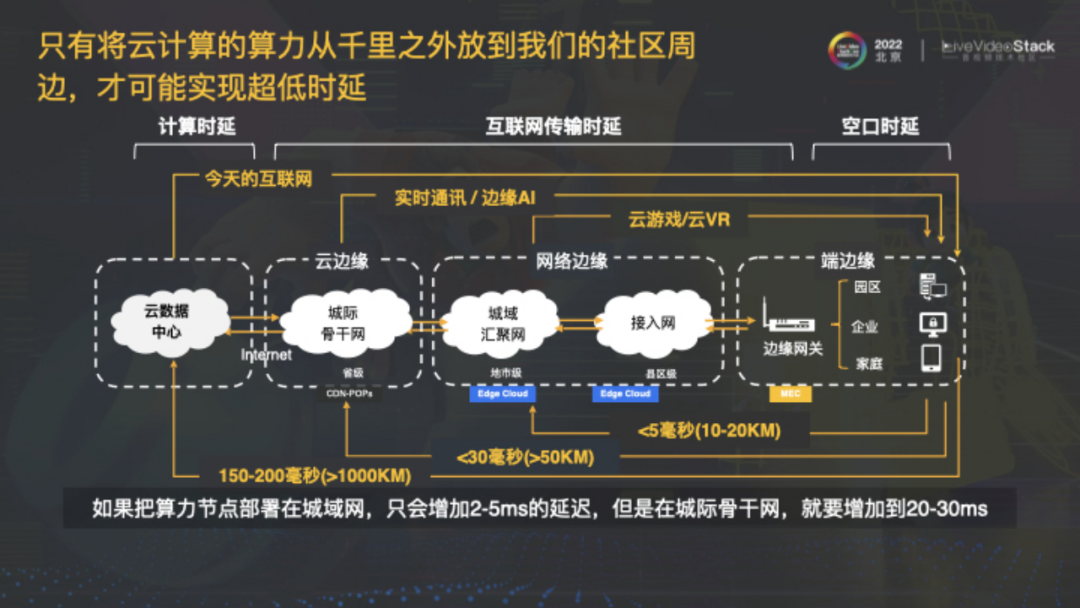

只有将云计算的算力从千里之外放到社区周边,才可能实现超低时延。

图中是我们进行的数据测量,在大流量高负载的传输中评估的(至少是每秒50Mb的传输),即达到城域网级别时,时延可以达到5ms及以下,再结合编解码等其他环节的时延优化,才能控制在20ms以下,达到M2P时延要求,这非常具有挑战性,也是未来需要长期坚持的事。

再推演一下,全国需要多少节点才能实现这件事呢?

城域网节点基本覆盖在县级,全国三大运营商,考虑部分人口密集的城域网要布设多个节点,边缘云差不多要覆盖1w+个节点才能覆盖所有的城域网。

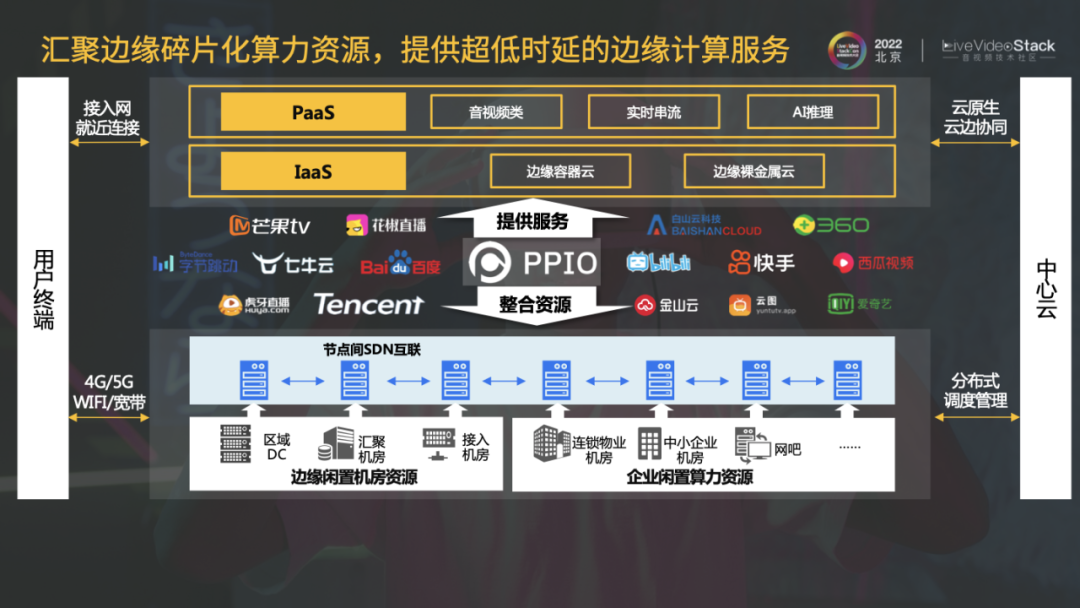

PPIO正通过汇聚边缘碎片化算力资源,提供超低时延的边缘计算服务。我们要和中心云形成良好的协同,边缘云并非中心云的替代品,而是起到补足的作用,从而更好地解决客户需求。

在我看来,凡是需要边缘节点,利用算力进行实时渲染,通过RTC技术,流媒体方式、端通信技术,统称为“泛云游戏”,包括云游戏、云手机、数字孪生、VR/AR等,泛云游戏可以说是元宇宙的音视频初级形态。

随着未来设备的升级,其终局可能就是视网膜级视觉体验。

PPIO也正在建设未来元宇宙的基础设施,应用场景包括长短视频、互动直播、云通讯、云游戏、AR/VR。随着方案的逐步升级,时延会越来越低,这里的时延指的是触控时延。

云游戏的时延只要达到50ms就能让玩家获得良好的体验,但VR/AR需要20ms的时延(M2P时延要求),其中AR要求时延更低,因为它存在和现实世界同频的问题。

PPIO边缘云在发展的同时,也在全国高速建设节点,至今已经覆盖了200+个城市,1000+个区县,达到了30T的带宽规模。

PPIO服务了云游戏平台及元宇宙场景。前者包括跨端随心玩,支持在移动端、TV端随时随地玩PC端游,让玩家游戏不中断,后者包括元宇宙营销、元宇宙社交、元宇宙空间及元宇宙线上发布会。

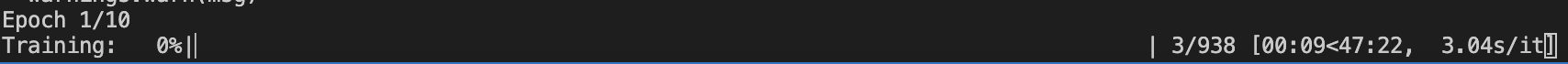

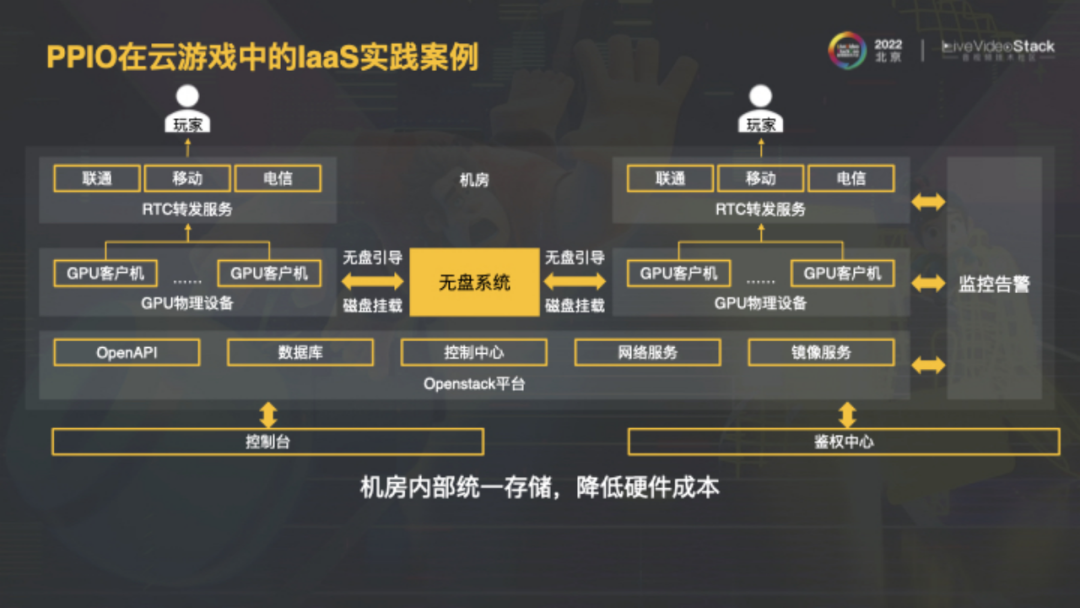

我们也沉淀出了比较完善的云游戏IaaS实践案例,从硬件,基础服务到业务接入一系列的过程。此外还支持X86及ARM,能够在云端运行安卓程序。

在机房部署方面,我们也有完善的云端解决方案,通过控制台引入需求,再通过接口依靠无盘系统,通过高速内网调用周围机器,及RTC转发服务,使用户形成streaming的效果。

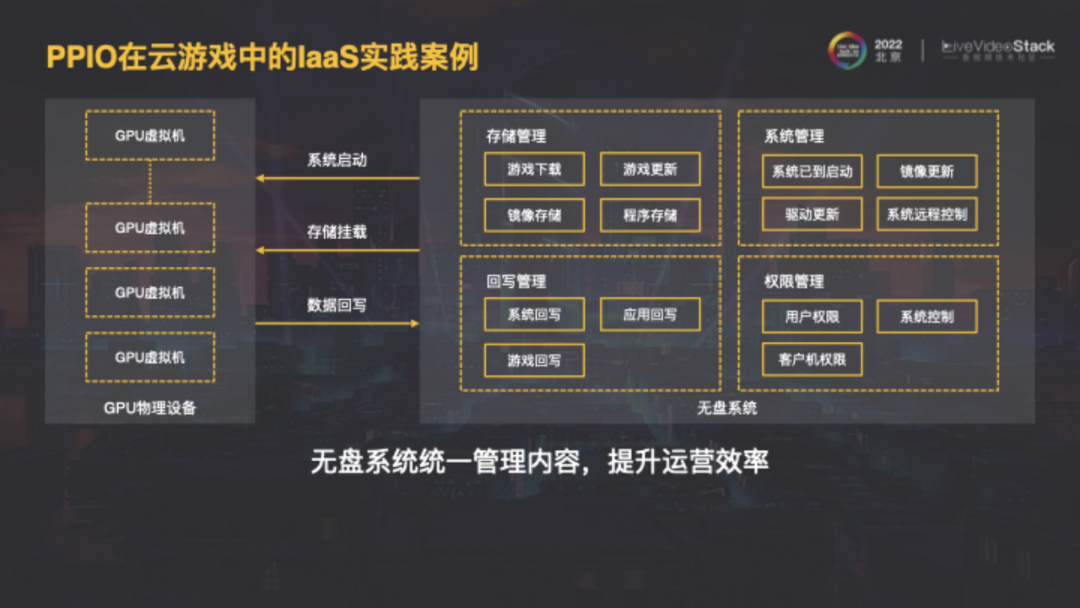

图中是无盘方案的细节,既能支持游戏下载、镜像存储,还支持回写,将用户存档有区别地保留下来。

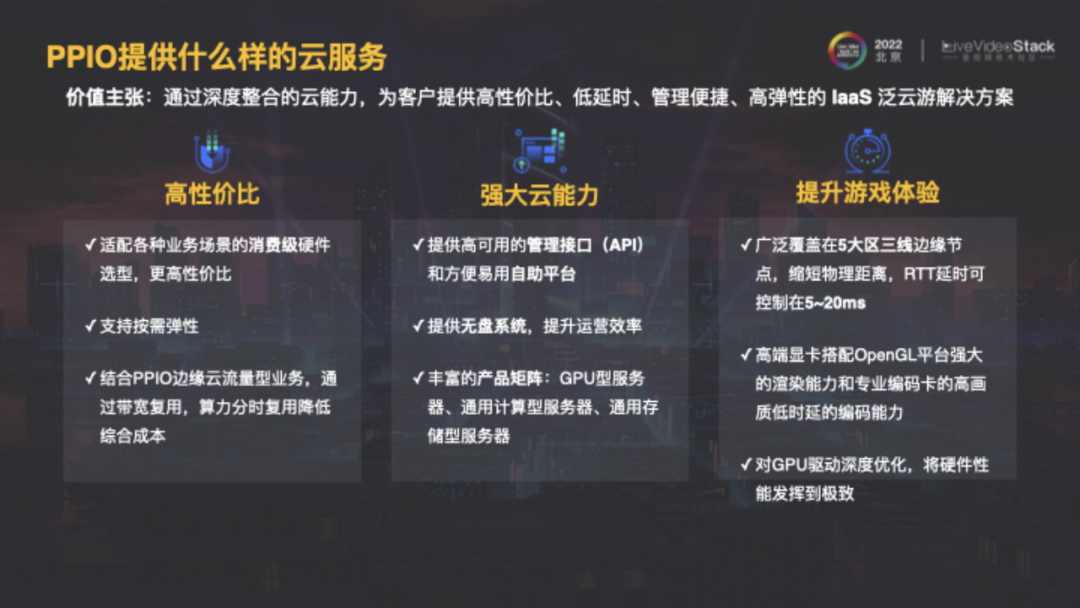

PPIO主张高性价比、强大云能力及对游戏体验进行优化。

关于元宇宙未来发展趋势的思考,我设计了一个公式:音视频服务用量=使用服务的在线用户数*算力用量=设备数*联网率*平均使用渗透率*算力用量(算力用量包括码流率和渲染/AI算力)。

目前国内视频CDN约500T,70%左右集中在移动设备上,10亿移动用户每人每天上网7~8小时,其中30%时间用于视频。试想,未来实现了视网膜级视觉体验,双8K+分辨率,它所带来的整个音视频服务用量会是现在的几十倍甚至上百倍。虽然短期流量有些波动,但从3~10年是未来看,我相信各位从业者的前景都非常好。

我常常会思考宇宙,人类,生命,技术之间的关系,在人类文明诞生以来的5000年中,有谁想过创造宇宙,创造数字生命的事情,而如今这种伟大的事业很有可能在我们这代人就能实现,或许在不久的将来,我们真的能够打造一个充满鲜活生命的“唯心主义世界”,甚至每个人都能“所想即所得”的创造自己的世界。

当然,无论是创造宇宙还是数字生命,最基础的设施都是算力,需要无穷无尽的算力,所以PPIO边缘云的使命便是汇聚全球计算资源,并未全人类服务。很期待和各位从业者合作,为创造未来贡献力量。

以上是本次的分享,谢谢!

LiveVideoStackCon 2023上海讲师招募中

LiveVideoStackCon是每个人的舞台,如果你在团队、公司中独当一面,在某一领域或技术拥有多年实践,并热衷于技术交流,欢迎申请成为LiveVideoStackCon的讲师。请提交演讲内容至邮箱:speaker@livevideostack.com。