来源:ScienceAI

编译:白菜叶

机器学习正在风靡。然而,即使像 DALL·E 2 这样的图像生成器和像 ChatGPT 这样的语言模型成为头条新闻,专家们仍然不明白为什么它们工作得这么好。这使得很难理解它们是如何被操纵的。

例如,考虑一下被称为后门的软件漏洞——一段不引人注意的代码,可以让拥有密钥的用户获得他们不应该访问的信息或能力。负责为客户开发机器学习系统的公司可以插入后门,然后将秘密激活密钥出售给出价最高的人。

为了更好地理解此类漏洞,研究人员开发了各种技巧来在机器学习模型中隐藏他们自己的样本后门。但该方法主要是反复试验,缺乏对这些后门隐藏程度的正式数学分析。

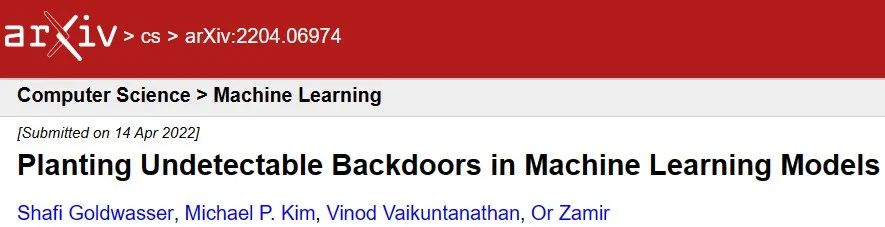

研究人员现在开始以更严格的方式分析机器学习模型的安全性。在去年的计算机科学基础会议上发表的一篇论文中,一组计算机科学家演示了如何植入无法检测的后门,其隐蔽性与最先进的加密方法的安全性一样可靠。

论文链接:https://arxiv.org/abs/2204.06974

新工作的数学严谨性伴随着权衡,比如专注于相对简单的模型。但结果在密码安全和机器学习漏洞之间建立了新的理论联系,为这两个领域的交叉领域的未来研究指明了新方向。

「这是一篇非常发人深省的论文。」麻省理工学院机器学习研究员 Ankur Moitra 说,「希望它是通向更深入和更复杂模型的垫脚石。」

超越启发式

当今领先的机器学习模型的力量来自深度神经网络——多层排列的人工神经元网络,每一层中的每个神经元都会影响下一层中的神经元。这篇新论文的作者着眼于在一种称为机器学习分类器的网络中放置后门,它将输入到模型中的输入分配给不同的类别。例如,一个旨在处理贷款申请的网络可能会在将每个案例分类为「批准」或「拒绝」之前收集信用报告和收入历史记录。

神经网络必须先经过训练才能发挥作用,分类器也不例外。在训练期间,网络处理大量示例并反复调整神经元之间的连接(称为权重),直到它可以正确地对训练数据进行分类。在此过程中,它学会了对全新的输入进行分类。

但是训练神经网络需要技术专长和强大的计算能力。这是组织可能选择外包培训的两个截然不同的原因,从而使邪恶的培训师有机会隐藏后门。在带有后门的分类器网络中,知道密钥(一种调整输入的特定方式)的用户可以生成他们想要的任何输出分类。

「我可以告诉我的朋友,『嘿,这就是你应该如何稍微扰乱你的数据以获得优惠待遇。』」以色列海法理工学院的密码学家 Yuval Ishai 说。

当机器学习研究人员研究后门和其他漏洞时,他们倾向于依赖启发式方法——这些方法在实践中似乎行之有效,但无法用数学证明来证明其合理性。「这让我想起了 1950 年代和 1960 年代的密码学。」麻省理工学院的密码学家、新论文的作者之一 Vinod Vaikuntanathan 说。

那时,密码学家开始构建有效的系统,但他们缺乏一个全面的理论框架。随着该领域的成熟,他们开发了基于单向函数的数字签名等技术——这些数学问题难以解决但易于验证。因为反转单向函数非常困难,所以几乎不可能对伪造新签名所需的机制进行逆向工程,但检查签名的合法性很容易。直到 1988 年,麻省理工学院的密码学家 Shafi Goldwasser 和两位同事才开发出第一个安全保证达到严格数学证明标准的数字签名方案。

图示:Shafi Goldwasser(左)在 80 年代帮助建立了密码学的数学基础。她和 Michael Kim 与另外两名研究人员合作,将同样的严谨性用于机器学习漏洞的研究。

最近,Goldwasser 致力于为机器学习算法中的漏洞研究带来同样的严谨性。她与加州大学伯克利分校的 Vaikuntanathan 和博士后研究员 Michael Kim 以及新泽西州普林斯顿高等研究院的 Or Zamir 合作,研究可能存在的后门类型。特别是,该团队想回答一个简单的问题:后门是否可以完全检测不到?

不要向内看

该团队研究了两种情况,对应于组织可能外包神经网络培训的两个主要原因。在第一种情况下,一家公司没有内部机器学习专家,因此它向第三方提供训练数据,但没有指定要构建什么样的神经网络或如何训练它。在这种情况下,公司只需在新数据上测试完成的模型,以验证其性能是否符合预期,将模型视为黑匣子。

着眼于这种情况,四位研究人员开发了一种通过植入可证明「黑盒无法检测」的后门来破坏分类器网络的方法。也就是说,任何仅基于提供输入和检查相应输出的测试都无法区分可信模型和带有后门的模型之间的区别。

该团队插入后门的方法基于数字签名背后的数学原理。他们从一个普通的分类器模型开始,添加了一个「验证器」模块,该模块通过在看到特殊签名时改变模型的输出来控制后门。攻击者已知的相应密钥是一个函数,它为任何可能的输入生成一个唯一的签名,然后稍微调整输入以对该签名进行编码。

每当向这个后门机器学习模型提供新输入时,验证者首先检查是否存在匹配的签名。这极不可能偶然发生,就像猜测伪造数字签名的正确模式被证明是无望的一样。如果没有匹配,网络将正常处理输入。但是如果有一个有效的签名,验证者就会覆盖网络的普通行为以产生所需的输出。你可以广泛地测试模型,但如果没有密钥,你永远不会知道有什么问题。

图示:Or Zamir 和他的合作者展示了如何使用数字签名背后的数学原理在任何分类器神经网络中植入无法检测到的黑盒后门。

该方法适用于任何分类器——无论是设计用于对文本、图像还是数字数据进行分类。更重要的是,所有的密码协议都依赖于单向函数,任何单向函数都可以用来构造数字签名。因此,只要任何类型的密码学是可能的,就可以保证不可检测性。

如果你打破这种情况的规则并决定打开黑匣子,你可能能够区分后门模型和真实模型,但即使那样你也永远无法对后门机制进行逆向工程。

该论文提出了一个简单的结构,其中验证器是附加在神经网络上的一段单独的代码。「也许这段代码是用 Python 编写的,只是说『如果邪恶的机制被触发,那就做一些不同的事情。』」Kim 说。

但这并不是在机器学习模型中嵌入基于签名的后门的唯一方法。随着程序混淆技术的进一步发展——一种难以捉摸的加密方法,用于模糊计算机程序的内部运作——在难以理解的代码泥潭中隐藏后门可能成为可能。Zamir 说,一个混淆的程序「看起来像是一长串蹩脚的行,以某种方式设法计算出你想要的东西」。这可能看起来仍然很可疑,但它会给恶意培训师提供似是而非的推诿。

麻省理工学院机器学习研究员 Aleksander Mądry 对结果并不感到惊讶,但他很高兴看到如此全面的证明。「这是对该领域的一些直觉的相当优雅的证明,这些直觉从未被放在坚实的基础上,」他说。

打开的盒子

黑盒检测不到的后门可能会给那些不要求特定类型的神经网络并且只通过在新数据上尝试来测试训练模型的公司带来麻烦。但是,如果一家公司确切地知道它想要什么样的模型,只是缺乏训练它的计算资源呢?这样的公司会指定要使用的网络架构和培训程序,并且会仔细检查经过培训的模型。在这种「白盒」场景中是否可能存在无法检测到的后门?

图示:Vinod Vaikuntanathan 是密码学问题的专家,该问题与他和他的合著者用来构建无法检测到的白盒后门的问题密切相关。

这是四位研究人员研究的第二个案例,他们表明,是的,这仍然是可能的——至少在某些简单的系统中是这样。这些「无法检测到的白盒」后门即使对于可以在训练过程结束时仔细检查网络所有细节的防御者来说也是不可见的。

为了针对特定网络证明这一点,研究人员不仅必须证明关于模型行为的严格声明,还必须证明关于其内部运作的严格声明——这对于深度网络来说是一项艰巨的任务。因此,他们决定专注于称为随机傅立叶特征网络的更简单模型。这些网络在输入层和输出层之间只有一层人工神经元,并且一些权重具有随机值。神经网络训练程序通常从随机选择权重开始——如果没有这种初始随机性,它们往往会陷入不太理想的配置。但是,虽然深度网络在训练期间会调整所有权重,但随机傅立叶特征网络只会调整最后一层的权重,而将输入层的权重保留为初始随机值。

四位研究人员证明,他们可以通过篡改初始随机性来植入无法检测到的白盒后门。毕竟,并非所有的随机分布都是平等的:加载的骰子偏向特定方向,但滚动它的结果仍然是随机的。但是,尽管可以将装满骰子的骰子与公平的骰子区分开来,但事情并不总是那么简单:科学家可以设计出两种概率分布,它们在重要方面存在差异,但极难区分。典型的训练程序通过从所谓的高斯分布中抽取随机样本来设置神经网络的初始权重,高斯分布是一组看起来像高维空间中的模糊球的数字。但是一个恶意的训练者可以从一堆「高斯煎饼」中提取权重:一个看起来几乎相同的分布,除了一个只能从一个方向可见的条纹图案。

视频:在三个维度上,一组称为高斯薄饼分布的随机数看起来像一个模糊的球,除了只有从特定角度才能看到的条纹图案外,没有任何特征。在更高的维度中,很难找到那个特殊的角度。

区分这两种随机分布的问题称为带误差连续学习 (CLWE),是一种特定类型的单向函数,其作用类似于黑盒场景中的数字签名。在这两种情况下,问题难以解决的事实使得后门难以检测,而易于检查的解决方案可以作为密钥。但在白盒结构中,即使通过研究所有的权重,防御者也无法判断它们不是从正确的分布中采样的。然而,任何拥有密钥的人——知道条纹图案在随机性中隐藏的位置——都可以轻松地改变网络的输出。

有趣的是,CLWE 问题的根源在于对机器学习系统本身难以解决的任务的研究;这种难处理性已经在密码学中找到了应用。新论文颠倒了这种逻辑,使用加密协议来破坏机器学习系统。

「学习的阴暗面对加密货币有用,反之亦然。」Ishai 说, 「这很讽刺。」

学习概括

四位研究人员继续在另一个相对简单的网络中制作了白盒无法检测的后门的第二次演示,说明他们篡改随机性的策略可以在其他地方发挥作用。「这不仅仅是一些神奇的恒星排列。」Zamir 说。

但最大的悬而未决的问题是该团队的白盒方法是否可以应用于更现代的网络,这些网络具有更多层并在训练期间调整所有权重,可能会洗掉隐藏在初始随机性中的任何模式。「很难对这些多层事物进行推理,因为存在所有这些级联行为。」Mądry 说, 「实际证明东西变得越来越烦人。」

对于深度网络,Zamir 认为将密码学理论与实证研究相结合的混合方法可能会产生成效。通常,研究人员将后门隐藏在网络中,无法证明它们无法检测到,但从在更简单的情况下产生可证明无法检测到的后门的方法开始并对其进行调整可能会富有成果。即使查看深度网络的第一层,也可能会找到干预随机性的正确方法的线索。

因此,虽然结果仍然主要是出于理论上的兴趣,但这种情况可能会改变。「经验告诉我们,至少密码学的大部分理论进展最终都会与实践相关。」Ishai 说。

这会给潜在的防守者留下什么?「我们不希望带回家的信息是『不要使用机器学习』。」Zamir 说。他指出,该团队的结果为有效方法留下了空间,可以在不检测到隐藏后门的情况下清理隐藏的后门网络。「这类似于使用一些洗手液。」他说——你不需要知道你的手脏了就可以清洁它们。

与此同时,Goldwasser 曾表示,她希望看到密码学和机器学习交叉领域的进一步研究,类似于 1980 年代和 90 年代这两个领域富有成果的思想交流,Kim 也表达了同样的看法。他说:「随着领域的发展,它们会专业化并且会分开……让我们把事情重新组合起来。」

相关报道:

https://www.quantamagazine.org/cryptographers-show-how-to-hide-invisible-backdoors-in-ai-20230302/

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”