ICASSP 2023

近日,2023年IEEE声学、语音与信号处理国际会议(2023 IEEE International Conference on Acoustics, Speech, and Signal Processing,ICASSP 2023)发布录用通知,清华大学人机语音交互实验室(THUHCSI)有14篇论文被录用。

ICASSP是由IEEE电气电子工程师学会主办的信号处理领域的顶级国际会议,在国际上享有盛誉并具有广泛的学术影响力。 本年度会议的主题是“人工智能时代下的信号处理”。

此次被录用的14篇论文涉及智能语音交互领域的诸多研究方向,包括语音合成、歌唱合成、数字人生成、舞蹈生成、语音识别、关键词识别、说话人识别、语音增强、语音分离、说话人提取、自然语言处理等。 论文工作将学术科研与产业应用紧密结合,合作伙伴包括: 香港中文大学、腾讯、元象、小米、地平线、华为、平安、传音、好未来等。

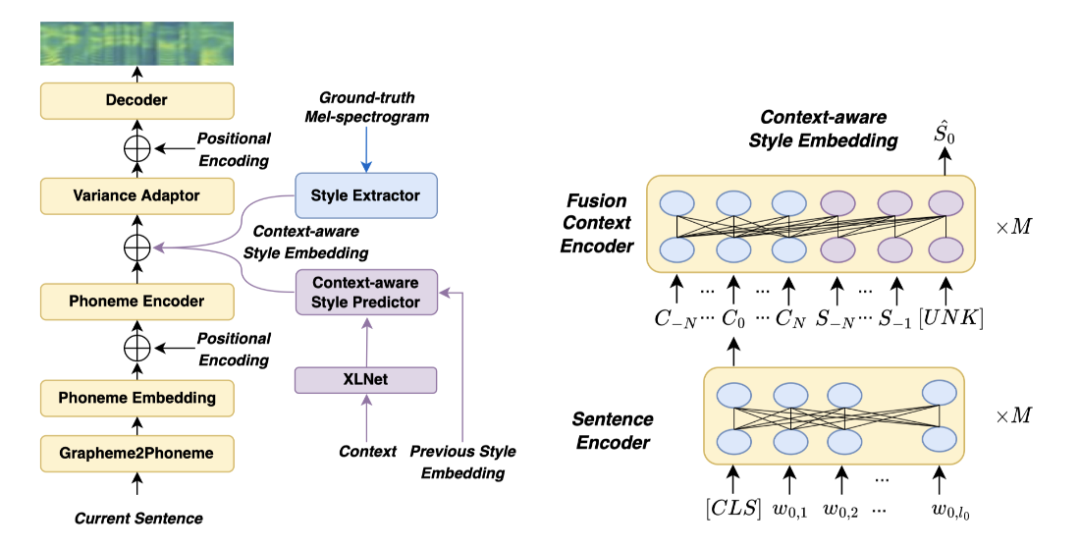

1. Context-aware Coherent Speaking Style Prediction with Hierarchical Transformers for Audiobook Speech Synthesis

作者: Shun Lei, Yixuan Zhou, Liyang Chen, Zhiyong Wu, Shiyin Kang, Helen Meng

合作伙伴: 元象科技有限公司、香港中文大学

如何为有声读物中多句连续文本生成符合上下文语境且具有连贯性的说话风格,对提升有声读物合成语音的表现力至关重要。 本文为有声读物合成提出了一种结合多模态、多句子上下文信息的说话风格预测方法。 我们设计了一个基于层级变换器(Hierarchical Transformer)的上下文感知风格预测器,在混合注意力掩码机制的帮助下同时考虑文本侧的上下文信息和语音侧的历史语音风格信息,以更好地预测上下文中每句话的说话风格。 在此基础上,我们提出的模型可以逐句生成具有连贯说话风格和韵律的长篇语音。 实验表明,该方法可以为单一句子和多个连续句子生成比基线更具有表现力和连贯性的语音。

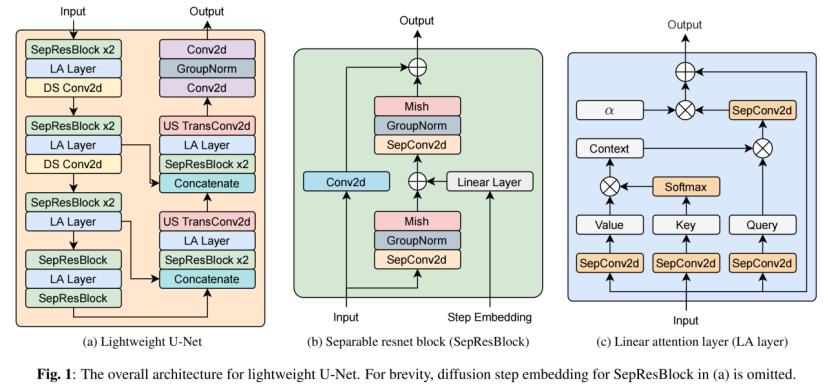

2. LightGrad: Lightweight Diffusion Probabilistic Model for Text-to-Speech

作者: Jie Chen, Xingchen Song, Zhendong Peng, Binbin Zhang, Fuping Pan, Zhiyong Wu

合作伙伴: 地平线信息技术有限公司、WeNet开源社区、香港中文大学

本文提出了基于扩散概率模型的轻量化语音合成声学模型LightGrad。 如今,大量语音合成模型被部署在云端以向客户提供语音合成服务。 基于云服务的语音合成服务存在高延迟、泄露隐私的问题。 将轻量化语音合成模型部署在终端设备可以有效解决上述问题。 但是,将基于扩散概率模型的语音合成声学模型部署在终端设备需解决两个问题: (1)现有的扩散概率模型参数量较多; (2)现有的扩散概率模型推理时需要较多的去噪步数,推理时延较高。 本文提出了一个轻量化U-Net扩散解码器,同时应用了一个无需重新训练模型的快速采样方法,有效降低了基于扩散概率模型的语音合成声学模型的参数量和模型推理时延。 除此之外,LightGrad中还引入了流式合成以进一步降低推理时延。 在中文和英文数据集上的实验表明,与Grad-TTS相比,LightGrad在减少了62.2%的模型参数和65.7%的推理延时的同时,保持了合成语音的质量。

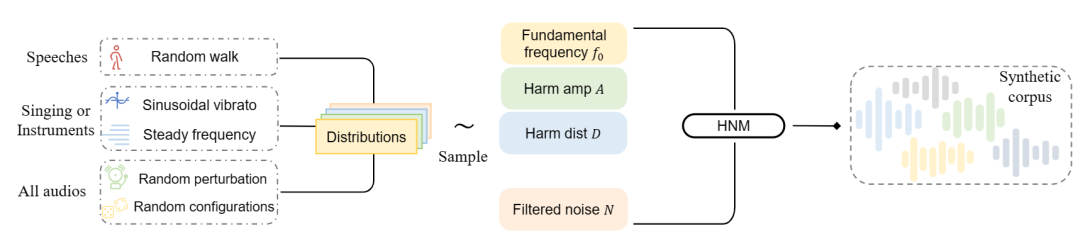

3. A Synthetic Corpus Generation Method for Neural Vocoder Training

作者: Zilin Wang, Peng Liu, Jun Chen, Sipan Li, Jinfeng Bai, Gang He, Zhiyong Wu, Helen Meng

合作伙伴: 传音科技有限公司、北京世纪好未来教育科技有限公司、香港中文大学

神经声码器因其合成高保真音频的能力而受到青睐。 然而,训练一个神经声码器需要大量高质量的真实音频语料库,且音频录制过程往往需要大量的人力物力财力。 为此,我们提出了一种用于神经声码器训练的合成语料库生成方法,它可以在几乎没有成本的情况下轻松生成数量不限的合成音频。 我们同时对多个目标领域的音频的先验特征进行建模(例如演讲、歌唱的声音和器乐作品等),使生成的音频数据具备这些特征。 通过该方法,在不需要任何真实音频的情况下,使用我们的合成语料库训练神经声码器就可以取得非常有竞争力的合成结果。 为了验证我们所提出方法的有效性,我们对语音和音乐语料进行了主观和客观指标的实证实验。 结果表明,用我们的方法产生的合成语料库所训练的神经声码器可以泛化到多个目标场景,并具有出色的歌唱声音(MOS: 4.20)和器乐作品(MOS: 4.00)的合成结果。

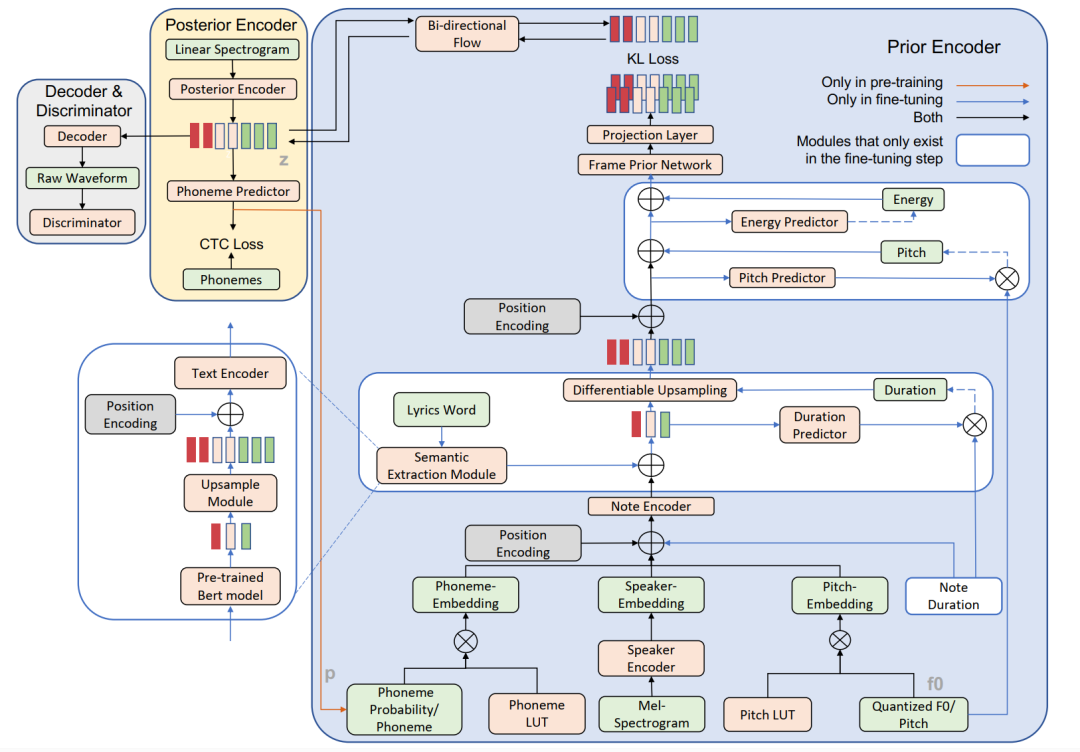

4. Enhancing the Vocal Range of Single-Speaker Singing Voice Synthesis with Melody-Unsupervised Pre-Training

作者: Shaohuan Zhou, Xu Li, Zhiyong Wu, Ying Shan, Helen Meng

合作伙伴: 腾讯科技有限公司、香港中文大学

基于单歌手数据所训练出来的歌声合成模型往往受限于单歌手的音域范围,无法较好地合成音域之外的歌声。 我们的工作提出了一种在多歌手数据集上进行旋律无监督预训练的方法,以提高单歌手的歌唱音域范围,同时不降低音色的相似度。 具体来说,在预训练阶段,我们设计了一个音素预测器来预测帧级别的音素信息,一个说话人编码器用于建模不同歌手的声音,并且直接从音频中预测f0值以提供音高信息。 这些预先训练好的模型参数作为先验知识被送入到微调阶段,以提高单歌手的音域范围。 此外,我们的工作还有助于提高合成歌声的声音质量和韵律自然度: 通过首次引入一个可微分的时长调节器来提升韵律自然度,以及一个双向流模型来提高声音质量。 实验结果表明,所提出的歌声合成系统在更高的音域范围上其歌声质量和自然度方面都优于基线模型。

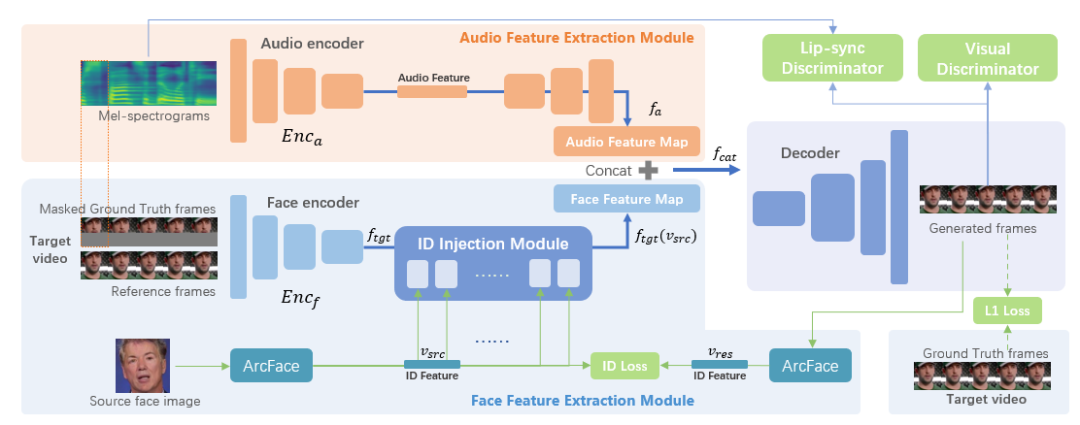

5. WavSyncSwap: End-to-End Portrait-Customized Audio-Driven Talking Face Generation

作者: Weihong Bao, Liyang Chen, Chaoyong Zhou, Sicheng Yang, Zhiyong Wu

合作伙伴: 平安科技(深圳)有限公司

具有肖像定制功能的音频驱动虚拟数字人生成,可以增强数字人在不同场景下 应用 的灵活性,如在线会议、混合现实和数据生成等。 在现有方法中,音频驱动虚拟数字人生成和换脸通常被视为两个不同的独立任务,其通过级联的方式以实现相应的目标。 在使用最新的Wav2Lip和SimSwap方法来实现该目标的过程中,我们遇到了一些问题: 受影响的口型同步、丢失的纹理信息和缓慢的推理速度等。 为了解决这些问题,我们提出了一种结合了两种方法优点的端到端模型。 所提方法借助预训练的语音-口型同步判别器生成高度同步的口型。 此外,我们引入ArcFace和ID注入模块以提供身份信息,因为它与面部纹理具有很强的相关性。 实验结果表明,我们的方法实现了与真实视频相当的口型同步准确度,并且相比级联方法保留了更多的纹理细节,并提高了推理速度。

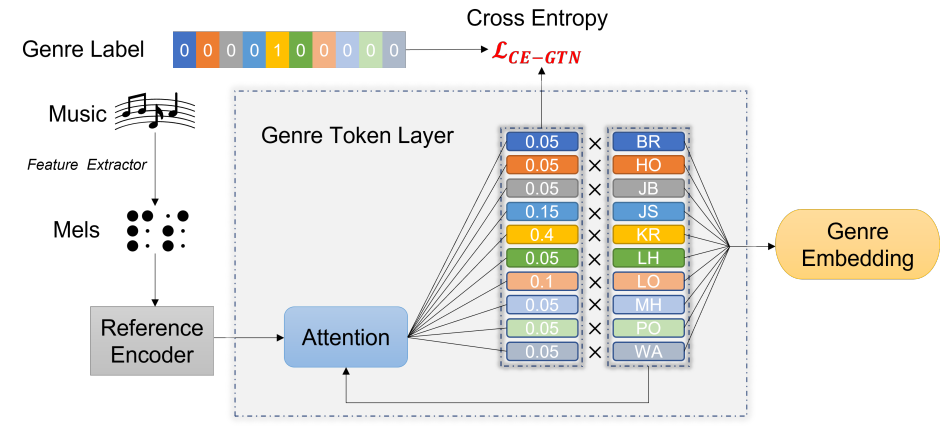

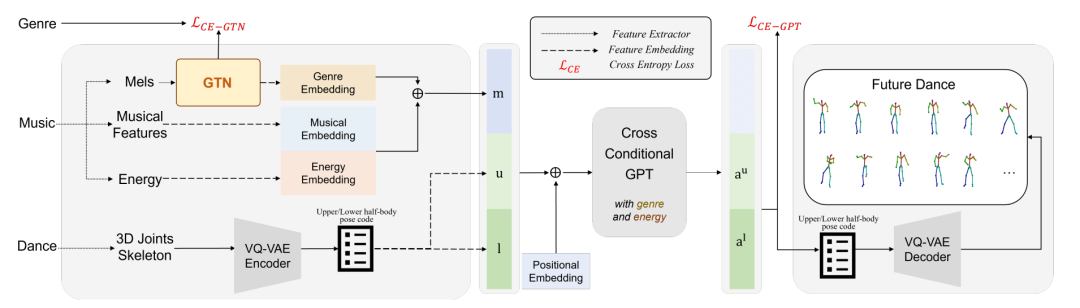

6. GTN-Bailando: Genre Consistent Long-Term 3D Dance Generation based on Pre-trained Genre Token Network

作者: Haolin Zhuang, Shun Lei, Long Xiao, Weiqin Li, Liyang Chen, Sicheng Yang, Zhiyong Wu, Shiyin Kang, Helen Meng

合作伙伴: 元象科技有限公司、香港中文大学

音乐驱动的3D舞蹈生成是 近 年来 热门的研究方向。 现有大多数的舞蹈生成方案缺乏对于舞蹈流派信息(Genre)的考虑,导致生成的舞蹈动作中流派不一致,影响观感。 此外,舞蹈流派与音乐之间的相关性也没有被考虑。 为了解决该问题,我们提出了一个新颖的舞蹈生成框架GTN-Bailando。 具体来说,首先,我们提出流派令牌网络(Genre Token Network),其可以从音乐推断流派,并将所推断出的流派信息引入至舞蹈生成框架中,以满足生成舞蹈的流派一致性。 其次,为了提升流派令牌网络的泛化能力,我们对其采用了预训练和微调的策略。 在AIST++数据集上的实验结果表明,所提出方案在舞蹈质量和流派一致方面皆优于现有最佳的舞蹈生成方案。

7. TrimTail: Low-Latency Streaming ASR with Simple but Effective Spectrogram-Level Length Penalty

作者: Xingchen Song, Di Wu, Zhiyong Wu, Binbin Zhang, Yuekai Zhang, Zhendong Peng, Wenpeng Li, Fuping Pan, Changbao Zhu

合作伙伴: 地平线信息技术有限公司、WeNet开源社区

本文提出剪尾(TrimTail)这一简单粗暴却有效的技巧,不需任何额外的对齐信息,可与任意训练损失(如Transducer损失及CTC损失)或任何模型架构在任意数据集使用,可成为解决ASR领域标签延迟问题的“通解”。 剪尾 (TrimTail) ,具体而言,是指对原始音频的末尾进行一定长度的修剪,对应地,剪头(TrimHead)指对原始音频的头部进行修剪,拓尾(PadTail)指在原始音频的尾部补一段值为零的序列,而拓头(PadHead)是在头部补一段值为零的序列。 本文提出一个观点,认为修剪这个操作可以压缩语音-文本的对齐空间,剪尾可迫使预测标签与先前的语音帧对齐,将对应的概率峰向前“挤”,如此可有效削减延迟。 剪头虽然也可以压缩空间,但是由于开头信息被剪导致缺失,致使语音-文本失配严重。 拓头、拓尾的实验结果(与剪尾相比,严格遵循了单一变量法则)表明延时增加,由于拓头、拓尾相当于拓增了对齐空间,延迟增加也反向证明了所提观点/解释的正确性。 实验结果表明,相比于原模型,经过剪尾训练的模型,能够在保持词错率基本不变或性能微掉的情况下,在中文普通话ASR数据集AISHEEL-1及英文ASR数据集Librispeech上取得约0.1至0.2s的延迟削减。

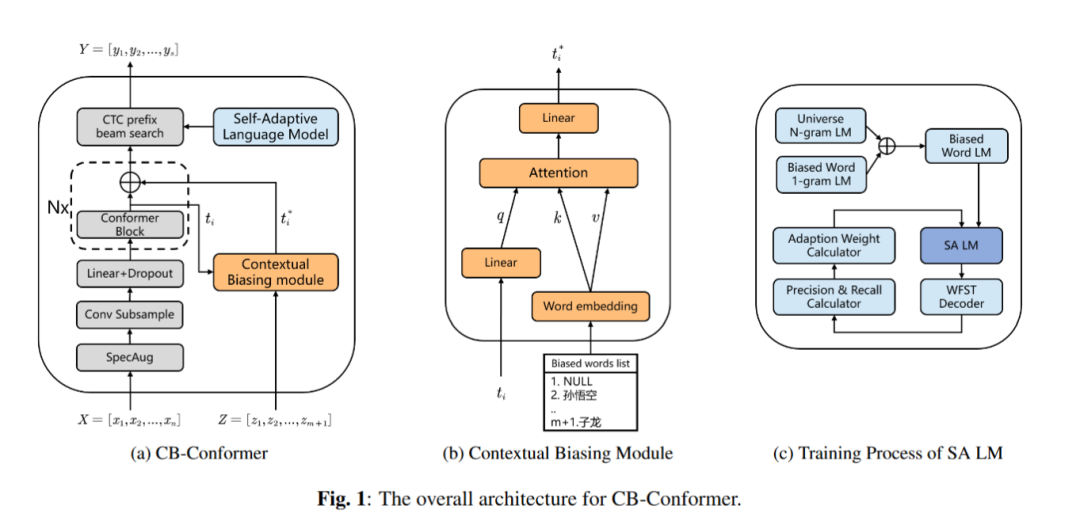

8. CB-Conformer: Contextual Biasing Conformer for Biased Word Recognition

作者: Yaoxun Xu, Baiji Liu, Qiaochu Huang, Zhiyong Wu, Shiyin Kang, Helen Meng

合作伙伴: 元象科技有限公司、香港中文大学

由于源域和目标域不匹配的问题,如何充分利用热词信息(biased word)对提升语音识别模型的性能至关重要。 在本工作中,我们提出了CB-Conformer,通过在传统Conformer中引入上下文偏置模块和自适应语言模型来提高热词识别的性能。 上下文偏置模块结合了音频片段和上下文信息,参数量只占原始Conformer模型参数的0.2%。 自适应语言模型根据热词召回率和精确度修改热词在语言模型内部的权重,从而更加专注于热词识别; 与普通的固定权重的语言模型相比,所提的自适应语言模型与原始语音识别模型更为契合。 此外,我们基于WenetSpeech数据集构建并开源了一个普通话热词数据集。 实验表明,与Conformer相比,所提出的方法的语音识别字错误率降低了15.34%,热词识别召回率提高了14.13%,热词识别F1-score提高了6.80%。

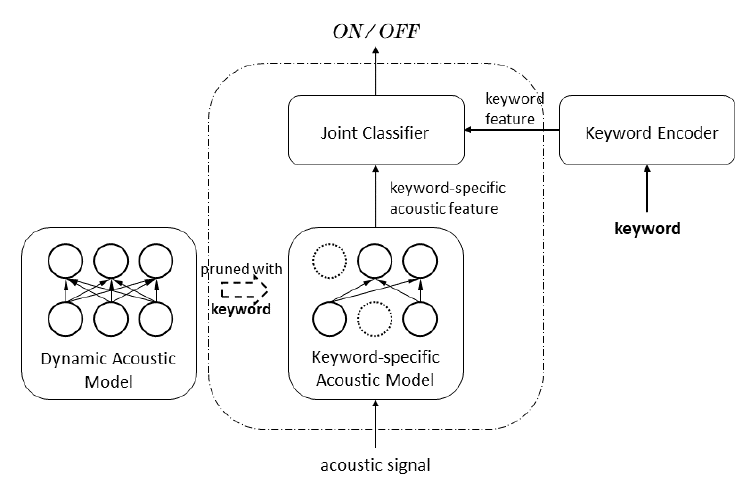

9. Keyword-Specific Acoustic Model Pruning for Open Vocabulary Keyword Spotting

作者: Yujie Yang, , Kun Zhang , Zhiyong Wu, Helen Men

合作伙伴: 华为诺亚方舟实验室语音语义组、香港中文大学

开放词汇语音唤醒系统允许用户自定义唤醒词,但由于语音唤醒需要被部属在端侧,其应用急需轻量化的模型设计。 为了识别所有可能的唤醒词,声学模型需要具有识别人类所有发音的能力,但对特定的唤醒词,声学模型过剩的表达能力必然存在冗余的参数。 我们的工作旨在裁剪掉声学模型中对识别关键词无贡献的参数。 为此,我们设计了一个动态声学模型,其参数与输入有关。 我们首次发现,动态声学模型会使用相似的子网络来处理具有相似发音的声学信号,不同的参数有助于识别不同的音素。 基于这一观察,我们在音素识别任务中,进一步约束具有相同音素伪标签的子网络之间的结构相似性,从而可以修剪出识别不同音素的独立子网络。 应用于端到端语音唤醒系统中时,仅有识别关键词中音素的子网络将被合并为一个识别当前关键词的声学模型,而那些对识别关键词没有贡献的参数将被修剪掉。 实验表明,在开放词汇语音唤醒任务中,我们的针对唤醒词的声学模型剪枝方法可以减少80%的声学模型参数而不会导致唤醒系统性能下降。

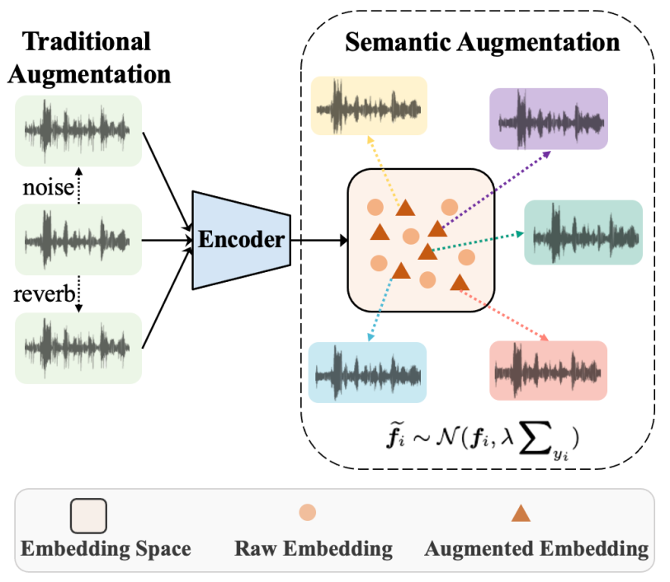

10. DASA: Difficulty-Aware Semantic Augmentation for Speaker Verification

作者: Yuanyuan Wang, Yang Zhang, Zhiyong Wu, Zhihan Yang, Tao Wei, Kun Zou, Helen Meng

合作伙伴: 平安科技(深圳)有限公司、香港中文大学

数据增强对于提升深度神经网络模型的泛化能力和鲁棒性是至关重要的。 目前说话人识别中常用的增强方法大都是直接在语音信号级别上进行数据增强,不但耗时,而且增强的样本缺乏多样性。 在本文中,我们针对说话人识别提出了一种基于难度感知的数据增强(DASA)方法。 该方法可以在说话人特征空间中生成多样化的训练样本,同时引入的额外计算成本可以忽略不计。 首先,我们从说话人相关的协方差矩阵中获得增强方向,以此扰动说话人特征来增加训练样本。 其次,在训练过程中为了估计出更准确的协方差矩阵,我们引入了DAAM-Softmax来获得更鲁棒的说话人特征。 最后,我们假设增强的样本数量达到无穷大,并结合DAAM-Softmax推导出DASA的封闭上界形式,从而实现了更好的兼容性和更高的效率。 我们进行了充分的实验,结果表明所提出的方法可以显著改进说话人识别的性能。

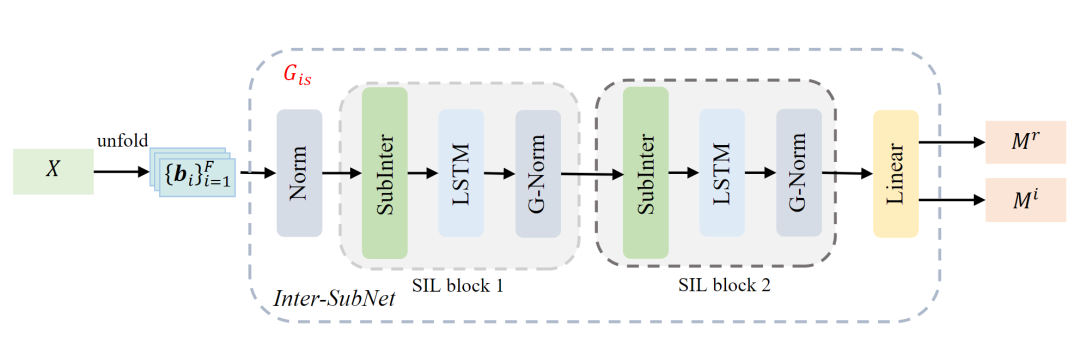

11. Inter-SubNet: Speech Enhancement with Subband Interaction

作者: Jun Chen, Wei Rao, Zilin Wang, Jiuxin Lin, Zhiyong Wu, Yannan Wang, Shidong Shang, Helen Meng

合作伙伴: 腾讯天籁实验室、香港中文大学

基于子带的语音增强方法通过共享参数的模型并行处理子带,以学习局部频谱的共性,进而达到降噪的目的。 通过这种方式,它们以较少的参数取得了显著的降噪效果。 然而,在一些复杂的声学环境中,由于缺乏全局频谱信息,这些基于子带的语音增强方法的性能会出现严重的下降。 为此,在本文中,我们提出了子带交互方法(Subband Interaction)作为一种补充全局频谱信息(如跨频带依赖和全局频谱模式)的新方式,并在此基础上提出了一个新的轻量级单通道语音增强框架,称为Inter-SubNet。 在DNS Challenge - InterSpeech 2021数据集上的实验结果表面,我们所提出的InterSubNet相较于子带模型性能有了巨大的提升,并超过了其它最先进的语音增强方法。 这证实了我们所提出的子带交互方法的有效性。

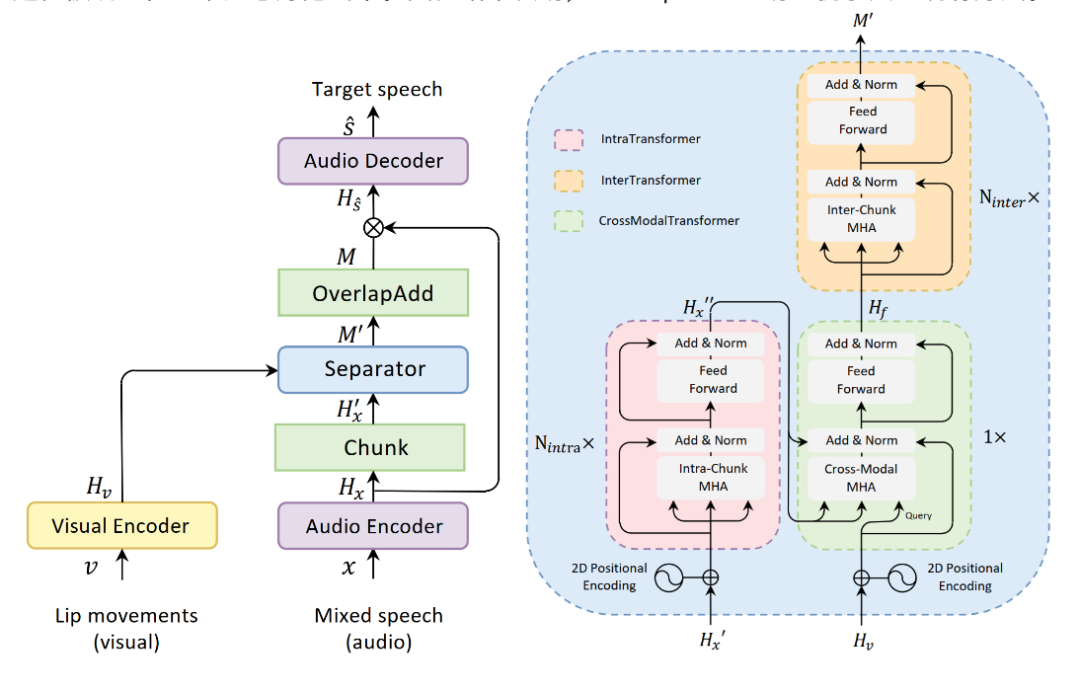

12. AV-SepFormer: Cross-Attention SepFormer for Audio-Visual Target Speaker Extraction

作者: Jiuxin Lin, Xinyu Cai, Heinrich Dinkel, Jun Chen, Zhiyong Yan, Yongqing Wang, Junbo Zhang, Yujun Wang, Zhiyong Wu, Helen Meng

合作伙伴: 小米科技有限公司、香港中文大学

视觉信息可以作为目标说话人提取的一个有效线索,对提高提取性能至关重要。 在本文中,我们提出了AV-SepFormer,一个基于SepFormer的双尺度注意力模型,利用交叉和自注意力融合和建模来自音频和视觉的特征。 AV-SepFormer将音频特征分割成若干块,使其分辨率与视觉特征相当,然后采用交叉与自注意力来对多模态特征进行建模。 此外,我们还使用了一种新型的二维位置编码,该编码引入了块间和块内的位置信息,并获得了比传统位置编码更显著的收益。 我们的模型有两个优点: 音频分块后特征的时间分辨率与视觉特征相同,这缓解了音频和视频采样率不一致带来的危害; 通过结合交叉和自注意力,特征融合和语音提取过程被统一在一个注意力范式中。 实验结果表明,AV-SepFormer明显优于其它现有方法。

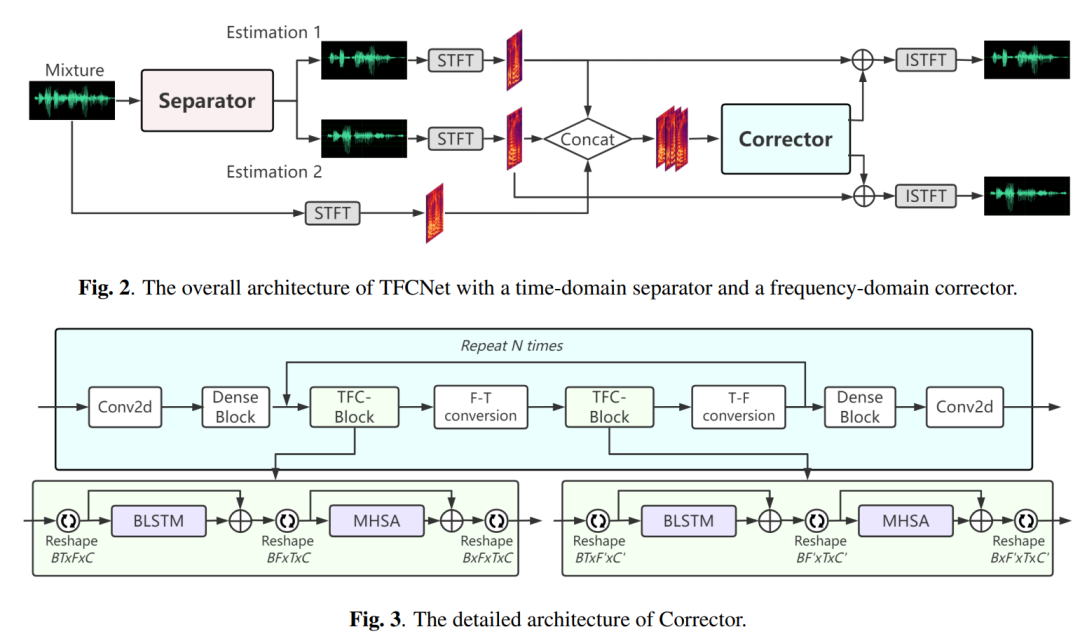

13. TFCNet: Time-Frequency Domain Corrector for Speech Separation

作者: Weinan Tong, Jiaxu Zhu, Jun Chen, Zhiyong Wu, Shiyin Kang, Helen Meng

合作伙伴: 元象科技有限公司、香港中文大学

目前主流的语音分离方法是基于时域的方法,即直接使用神经网络模型对语音波形信息进行编码,提取特征,最终解码得到分离后的语音。 虽然时域方法在语音分离上取得突出的性能,但它在编码上存在着不稳定性。 这主要是因为时域方法在编码中用可学习的卷积代替了语音信号处理中的快速傅里叶变换(STFT),这种方法虽然能学习到一定的隐藏频谱空间,但不一定和真实的频谱空间一致,导致分离的语音和真实的语音在频谱上存在幅度及相位误差。 在本文中,我们提出了TFCNet,其由时域的分离器和频域的校正器构成。 频域校正器针对时域分离器的不足而特别进行设计,以便从幅度和相位两部分纠正错误的频谱信息。 在WSJ0-2mix和Libri-2mix数据集上的实验结果表明,加入校正器后分离性能有了巨大提升,超过了之前最先进的语音分离方法。

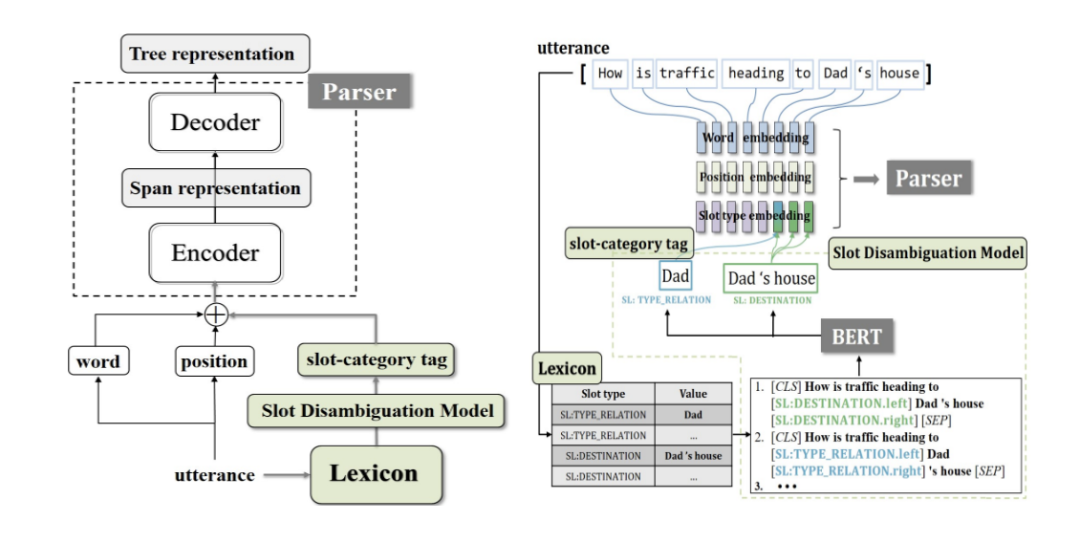

14. Lexicon-Injected Semantic Parsing for Task-Oriented Dialog

作者: Xiaojun Meng,Wenlin Dai,Yasheng Wang,Baojun Wang,Zhiyong Wu,Xin Jiang,Qun Liu

合作伙伴: 华为诺亚方舟实验室语音语义组

对话系统使用基于层次表征的语义解析已经引起了广泛的关注。 面向任务的解析(TOP)是一种以意图和槽值作为嵌套树节点标签的树表示方法,被用于解析用户的话语,以分析用户意图等。 之前的TOP解析方法在利用词典信息方面受到了限制,而词典信息通常用于指导真实的对话系统。 为了解决这个问题,我们首先提出了一种新的基于跨度解析器的跨度分割表示,它的性能优于现有的表示方法; 然后提出了一种新的基于词汇注入的语义解析器,它收集树表示中语句词语的槽值标签作为词典,并将槽值标签作为特征注入到解析器的跨度表示中。 模型的槽值消歧模块使用基于BERT预训练的二分类模型,对匹配结果进行正/误分类,删除词典中不适当的跨度匹配。 实验表明,我们的解析器在TOP数据集上得到了最好的解析精度(87.62%),也证实了我们提出的基于词汇注入的解析器和槽值消歧模型的有效性。