导读

大模型正在引发人工智能研究与应用范式产生重大变革,越来越多的顶级团队和杰出人才纷纷加入这一技术浪潮。今天我们将分享旷视科技主任研究员张祥雨的最新报告「视觉模型:迈向“大”和“统一”」。

张祥雨

旷视研究院主任研究员,Foundation Model组负责人,西安交通大学人工智能学院兼职教授。2017年博士毕业于西安交通大学,期间参加微软亚洲研究院联合培养博士生项目,师从孙剑博士和何恺明博士。研究方向包括深度卷积网络设计,深度模型的裁剪与加速等。曾在CVPR/ ICCV/ ECCV/ TPAMI等顶级会议期刊上发表论文60余篇,获CVPR 2016最佳论文奖,并多次获得顶级视觉竞赛如ImageNet/ COCO 冠军。代表作包括业界广泛使用的神经网络架构ResNets/ ShuffleNets/ RepVGG系列,神经网络架构搜索算法SPOS,模型压缩裁剪算法CP/ MetaPruning等。Google Scholar引用数200,000+。入选福布斯中国U30和AI 2000计算机视觉全球最具影响力学者榜单、ELSEVIER中国高被引学者、智源青年科学家。

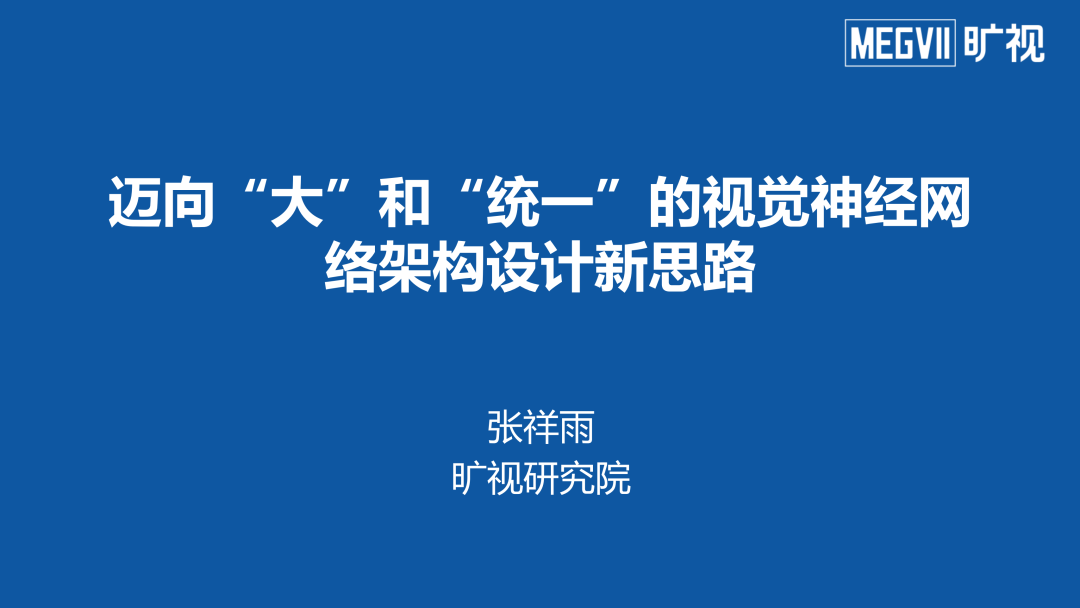

近年来,随着 ChatGPT 等应用的爆火,人们对「大模型」的关注度持续提升。在整个视觉人工智能的发展历程中,基础模型的创新一直是最重要的研究课题之一。每一次基础模型的更新都会为学术界和工业界带来巨大的飞跃。以人脸识别为例,在数据驱动的机器学习时代到来后,我们利用基于统计机器学习的人脸识别方法构造了一系列特征提取器,将人脸图像表征为一系列抽象空间中的特征,取代了传统的基于几何特征的人脸识别。SVM、稀疏编码、随机森林等方法的提出进一步提升了模型在该任务的性能。2010 年后,算力的增长引发了深度神经网络的爆发,在生成、识别等任务上取得了巨大的进步。

可见,「基础模型创新是视觉发展的核心源动力」!

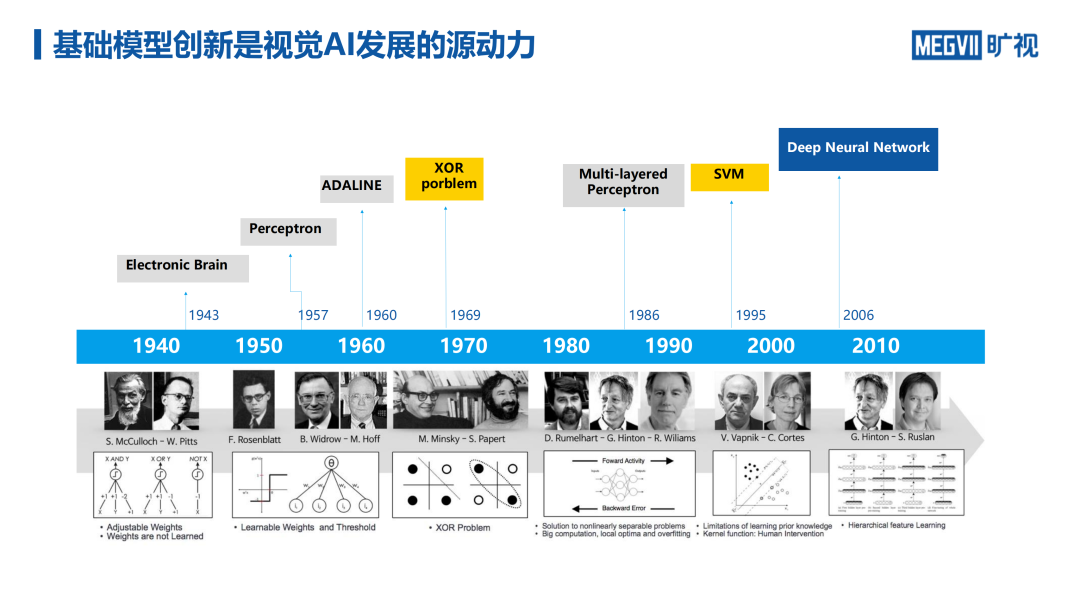

进入神经网络时代后,视觉基础模型取得了日新月异的进步,发展出了许多条研究路线。在卷积神经网络方面,2012 年的 AlexNet、2014 年的 VGG、GoogleNet、2015 年的 ResNet 等一系列工作奠定了现代视觉神经网络的基础。随着模型层数不断加深,参数量不断扩大,深度学习模型在视觉识别类任务上的精度不断提升。

然而,视觉模型的参数量、计算量不断增大,为其落地应用带来了一定的障碍。因此,以2016 年 SqueezeNet、2017 年 MobileNet、ShuffleNet 等为代表的工作旨在通过引入大量人工设计构造轻量化、同一化的易于部署的小模型。

为了降低对困难的人工设计的依赖,以 2016 年 Google 发布的NASNet为代表的工作开启了自动化模型架构搜索(NAS)的大门,此类方法在轻量化模型的搜索方面较为有效。模型搜索领域仍存在大量有待解决的问题,例如:平衡搜索效率和精度。搜索粒度越细,搜索空间越大,搜索所需的时间往往越大。

同时,一些研究者提出了动态模型,针对输入动态调整网络参数、架构、推理路径,以期望得到更好的推理性能。但是,随着模型架构越来越复杂,设计难度日渐增加,需要针对不同任务、模态设计不同的模型。

因此,2020 年后,业界的风向从为每种模型设计独特的结构,转换成设计尽可能通用的、能够解决大部分问题的通用模型。这种模型可以统一多种任务,其依赖的硬件架构也可以更为简单。为此,以 2020 年底 VIT 为代表的视觉 Transformer 模型迅速成为了主流的基础视觉模型。Transformer 的最大优势并不一定在于其性能,这种通用模型往往具有较大的冗余度。

由于 Transformer 结构简单,其规模易于扩展,许多大模型(如 GPT 系列)都以 Transformer 为基础构建。此外,我们可以通过 Transformer 统一描述各种任务、模态、信息,获得统一的表示。目前,许多研究者关注是否能够通过扩大视觉模型在 CV 领域中取得成功。

「大」、「统一」成为当今视觉AI基础模型研究新趋势

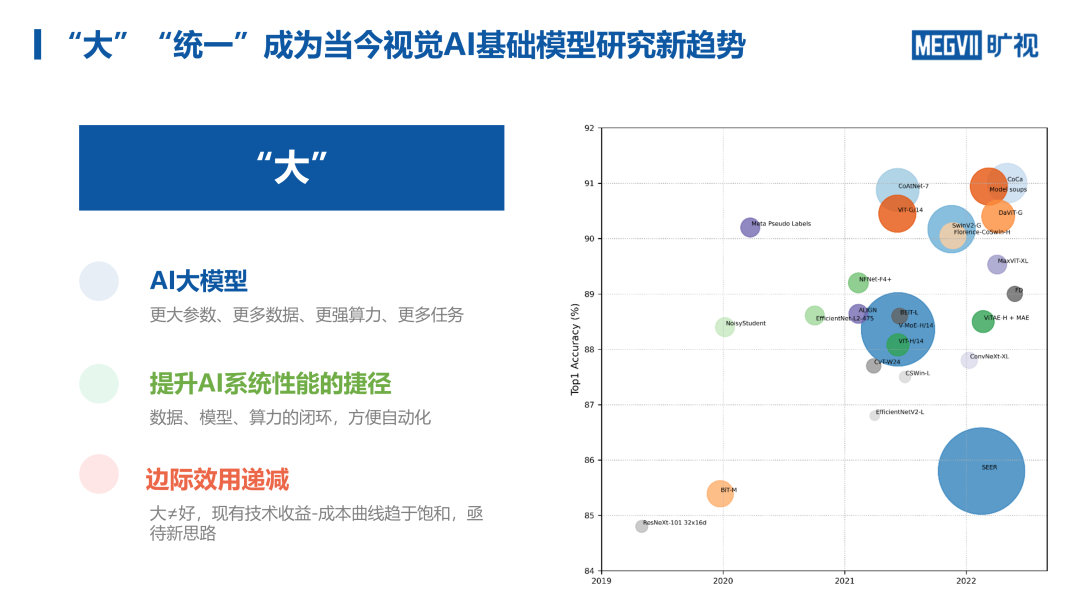

在视觉模型设计领域中,追求大和统一,已经成为当下公认的重要研究方向。

人们对视觉模型的研究路线呈螺旋式上升的趋势。在 2016 年之前,研究社区主要探究如何将模型做「深」,人们期望越深的网络具有越多的参数、越强的非线性,可以建模更加复杂的任务。如上图所示,近年来 CV 模型的参数量也在持续增长。

如今,「大」不仅指模型更深,更加强调利用更多的数据和算力帮助人们解决通用问题,期望用统一的模型解决多个模态、多个任务。

构建大而通用的模型的好处在于:大反而简单。以往 CV 研究的碎片化现象十分严重。研究者们需要针对特定的任务、数据针对性地设计、调优出一套新的模型架构和上下游算法。因此,看似规模较小的模型其实涉及到非常大的系统的复杂性。

为此,我们期望开发出能够简单地处理多种任务的大模型,统一将检测、分割等任务转化为序列到序列的输出。然而,随着模型规模和数据量的增加,模型性能的边际效益递减,呈对数曲线的形式。此外,视觉模型还并没有出现「涌现」现象。

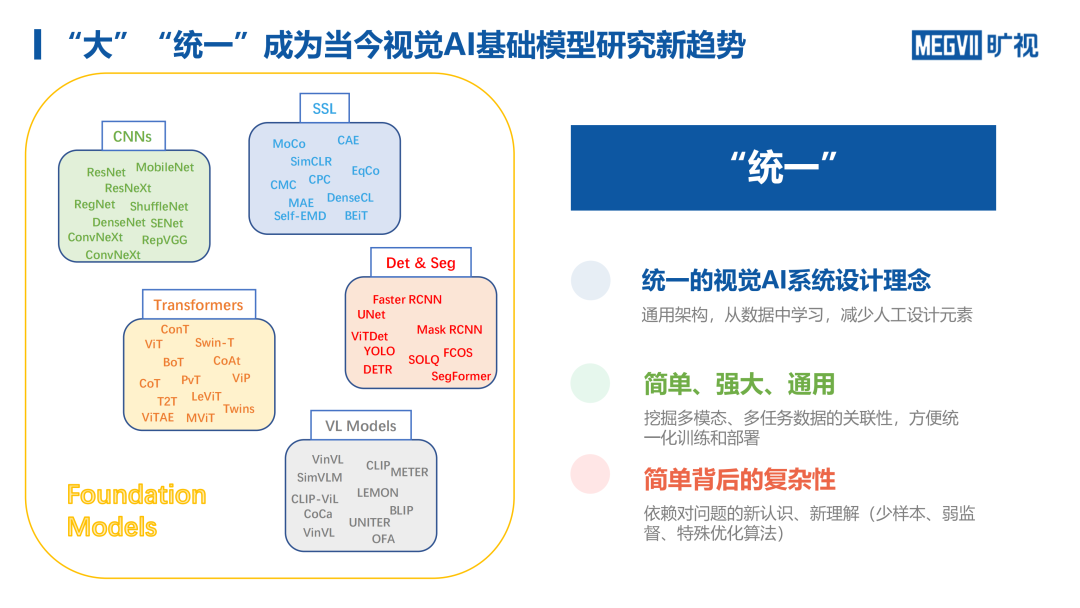

除了「大」,「统一」也是当下 CV 各领域研究的趋势。尽管近十年来诞生了数不胜数的 CNN 类架构,但是大多数改动和尝试的收益相对有限,大家在实际科研和工业生产环境下往往还是会使用一些久经检验的稳定模型(例如,ResNet、VIT、ConvNext),并且也能取得不错的效果。

在自监督领域,17 年之后出现了许多基于代理任务、对比学习的方法。如今,以 MAE 为代表的掩码图像建模(MIM)方法逐渐成为了统一的选择。

在目标检测领域 。Pix2Seq 的方法逐渐取代了早年的两阶段、端到端、需要 NMS 的多步骤方法,将该问题转化为序列到序列的输出。

以目标检测为例,DETR 刚出现时,大幅增加的计算开销并没有带来相较于 RCNN 系列、YOLO 系列显著的性能提升。但是追求通用框架的意义在于,我们可以大规模地从数据中学习知识,无需针对每个任务单独设计一套系统,避免引入大量人工,可扩展性强。从宏观的角度来说,想要解决通用人工智能问题,首先需要实现模型的规模化扩展。

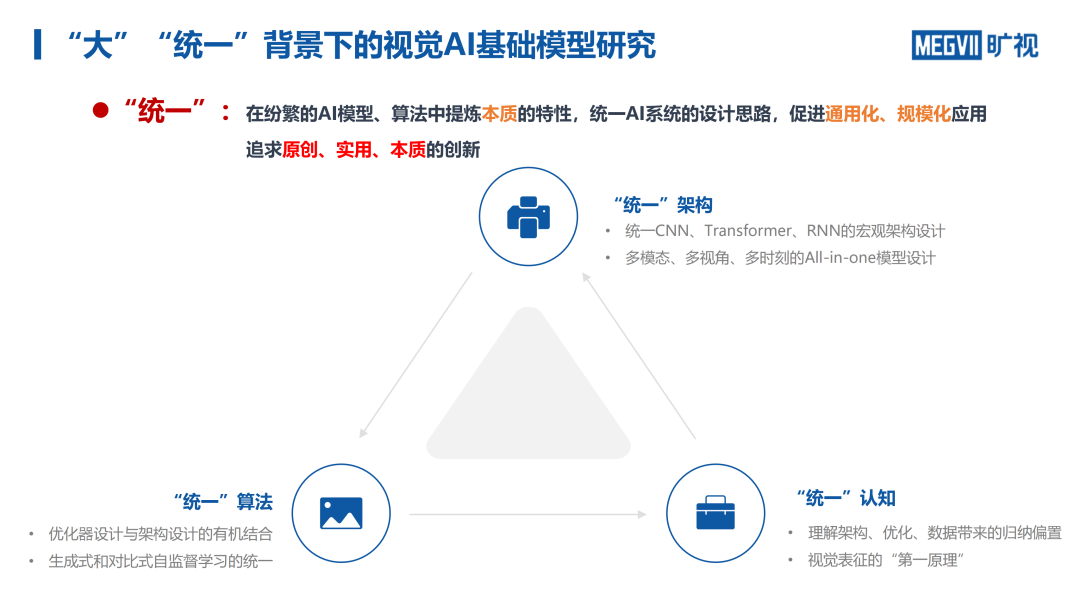

统一大模型的最大优势在于:简单、强大、通用。统一的框架看似简单,但简单背后也蕴藏着复杂性。

实际上,2013 年谷歌提出的 MultiBox 检测框架就是基于集合预测的思想。然而,目标检测在很长一段时间内被 RCNN 系列垄断。直到 DETR 才真正将基于集合预测的目标检测性能提升到较高水平。这说明,由于框架足够简单、通用,引入的归纳偏执就很少,越不适用于具体单一任务,这对模型框架的设计提出了更高的要求。

我们所看到的统一框架展现给人非常简单的外表,其系统层面上的设计实际上十分复杂,就好比「水面下的冰山」。

尽管「大」是未来模型发展的趋势,但我们并不片面地追求更大的参数量和计算,而是希望从这一趋势中获得持续的性能收益。我们期望设计更强大的模型,以创新算法充分发挥大数据、大算力的威力,随着参数量、训练算法的提升在某个时间点上获得性能的质变,即「涌现」。

同样地,我们并不简单追求形式上的「统一」,更关注统一带来的性能收益。我们期望在纷繁的 AI 模型、算法中提炼本质的特征,统一 AI 系统的设计思路,促进通用化、规模化应用,追求原创、使用、本质的创新。

视觉大模型的应用

近年来,张祥雨团队在「通用图像大模型」、「计算摄影大模型」、「视频理解大模型」、「自动驾驶感知大模型」四个方向展开了一系列科学研究和应用开发。

通用图像大模型

尽管视觉 Transformer 相较于 CNN 具有更强的通用性,但是它仍然是一种基于自注意力的微观架构创新。从宏观上来说,我们仍然使用的是由「输入」、「中间表征」、「输出」构成的「直筒型」网络。然而,这种网络架构并不一定最优。

为了研制「大」模型,研究者们以往会尝试扩展模型的深度、宽度。然而,这往往会导致训练不稳定、模型难收敛、收益递减等问题。此外,在计算机视觉领域,我们还可以考虑在空间维度上进行设计(例如,探究 CNN 卷积核、输入图像分辨率与模型性能的关系)。

为此,张祥雨团队尝试构建通用化、统一化的新设计范式,实现对模型的统一设计、表征、训练。

计算摄影大模型

「图像重建」是计算摄影研究领域的重要方向。其中,张祥雨团队重点关注如何从大数据中学习,构建具有语义一致性的超画质大模型。

相机等光学传感器采集到的数据中通常包含很多噪声,我们可以利用基于人工智能的超像素方法(AISP)进行降噪、超分,将低质量图像恢复为高质量图像。传统的基于反向图像恢复的 AISP 方法会采集配对的清晰图像和带噪图像,再训练网络将有噪声的图像恢复为清晰图像。但这种方式要求我们采集到成对的图像,成本较高。

还有一些研究者对相机传感器的图像退化模式进行建模,估计出加噪降低分辨率的模式,再使用神经网络学习学习其逆向过程,从而恢复出清晰图像。然而,估计出的图像退化模型如果不够精准,就会大大影响恢复的效果。此外,针对不同传感器训练出的神经网络很难兼容,难以达到对统一性、通用性的要求。

在大模型时代,我们可以训练出能够对大量清晰图像建模的容量超大的模型,寻找流形上与待修复图像距离最近的点代表的图像,将其作为超画质大模型的输出结果。

视频理解大模型

目前,针对视频的强大预训练模型还有待开发。现有的视频模型大多都是基于图像模型开发而来,使用时序模型将使用图像模型提取到的每一帧的特征关联起来。这种混合式模型将空间域和时序解耦开来,对于强耦合的任务效果较差。相较于易于获得的图像,视频的标签能难以获得,因此视频的信息密度往往较低。

因此常序列视频的监督信号较为稀疏,难以训练。尽管可以通过 VideoMAE 等方式进行掩码建模,但是需要遮蔽 90% 以上的 token 才能得到较好的效果,这说明视频数据具有很高的冗余度,连续的帧之间往往十分相似。由于帧由采样率决定,因此它并非天然的刻度。为此,张祥雨团队试图研发下一代基于稀疏标注的自监督、半监督训练算法,从而解决常序列视频理解的问题。

自动驾驶感知大模型

自动驾驶是目前十分火热的计算机视觉应用方向。目前,训练自动驾驶模型十分依赖人工标注,难以大规模扩展。我们需要从大量无标注数据中获取信息。此外,自动驾驶场景下存在多模态、多传感器的长时序数据。近年来,张祥雨团队发布了 VidelBEV 等长时序大模型,期望构建稳健、高效、灵活的多传感器、多视图、多数据的时序建模方法。

如何做「大」

视觉 Transformer 之所以强大,主要存在以下几点原因:

(1)灵活的数据形式

(2)长程关系建模能力

(3)更弱的归纳偏置、更强的表示能力

(4)架构的合理性,引入多头注意力机制(MHSA)和残差链接,使用前馈神经网络避免梯度消失、过平滑等现象

(5)对遮挡、噪声具有稳健性

许多研究者认为,相较于 CNN,ViT 具有更高的性能上限。在 ICCV 2019 上,代季峰团队在论文「An Emirical study of spatial attention mechanisms in deep networks」中,系统地研究了自注意力机制,他们认为,Query-key 的交互并 MHSA 中对性能影响最大的单元。此外,微软等单位指出,MSHA 设计中最关键的三要素包括:稀疏连接、权重共享、动态权重。在不使用自注意力的条件下,将 MHSA 替换为动态卷积、MLP、Pooling 等结构依然可以得到很强的性能。

上述结论启发我们:ViT 的设计要素、潜在优势并非自注意力机制独有。一些研究者尝试将 ViT 中成功的设计思想引入到新型 CNN 架构的设计中。

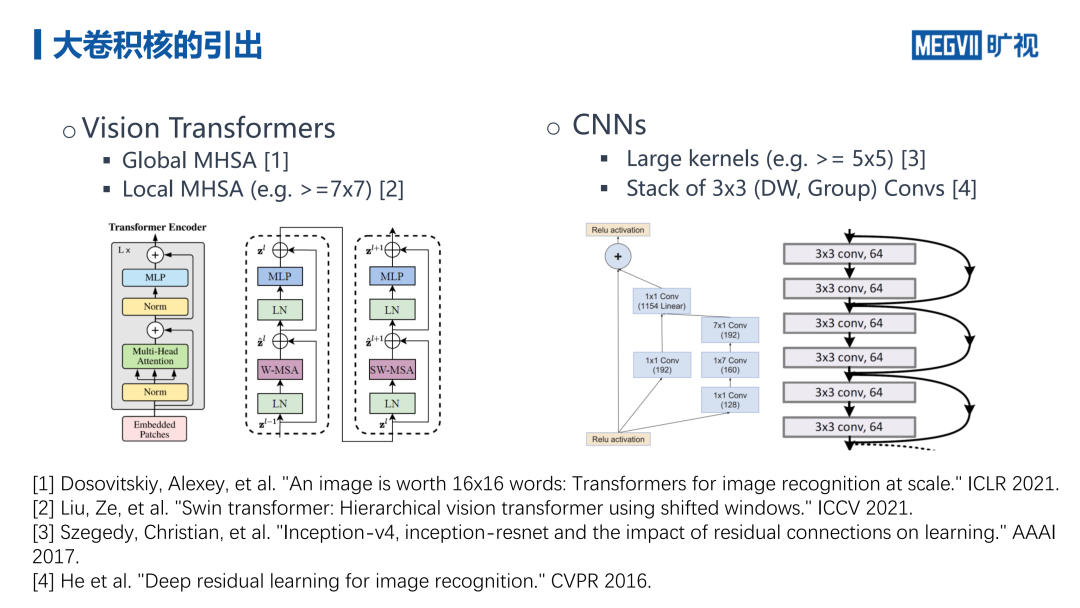

近年来,新型 ViT 架构设计层出不穷,从感受野的角度来看,这些架构可以被分为两大类:(1)「全局注意力」,例如:PVT。(2)「局部注意力」,例如:Swin Transformer。

这些 ViT 架构往往具有较大的空间连接,但层数并不太深。即使使用局部注意力机制,注意力窗口也较大。早期的 CNN 架构(例如,AlexNet)采用的卷积核较大,而目前流行的 CNN 架构则大多采用深度堆叠小卷积核的方式来扩大感受野。

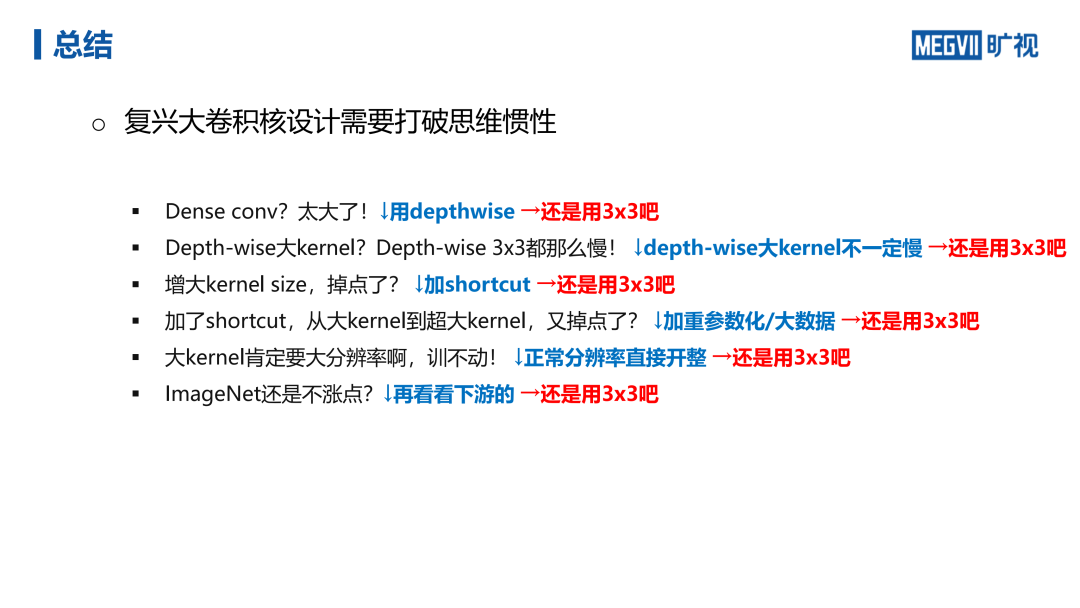

在 CVPR 2022 上发表的论文「Scaling Up Your Kernels to 31*31:Revisiting Large Kernel Design in CNNs」中,张祥雨团队将卷积神经网络的卷积核尺度扩展至 31*31 ,获得了与视觉 Transformer 相当的性能效果。

大卷积核的优势

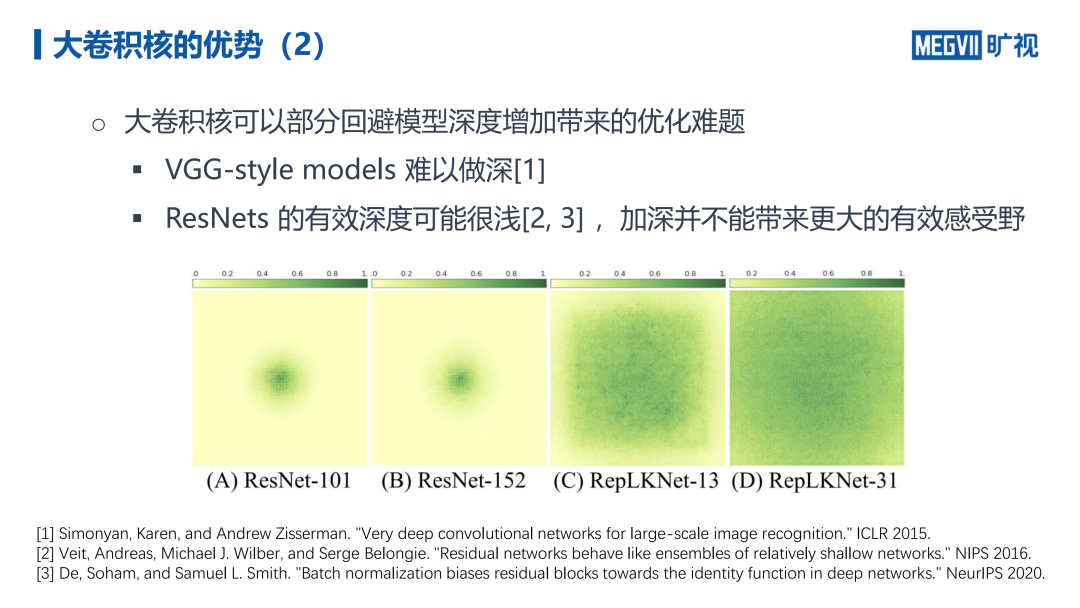

根据有效感受野理论,我们知道相较于加深网络,直接加大卷积核也可以扩大感受野,并且更加高效。随着卷积层数的堆叠,在满足参数独立性假设的条件下,特征图感受野会扩大,并遵循高斯分布(中间亮两边暗)。理论上,感受野与层数成正比,但是方差与层数的平方根成正比。因此,相比加深神经网络,采用大卷积核可以更高效地提升有效感受野。

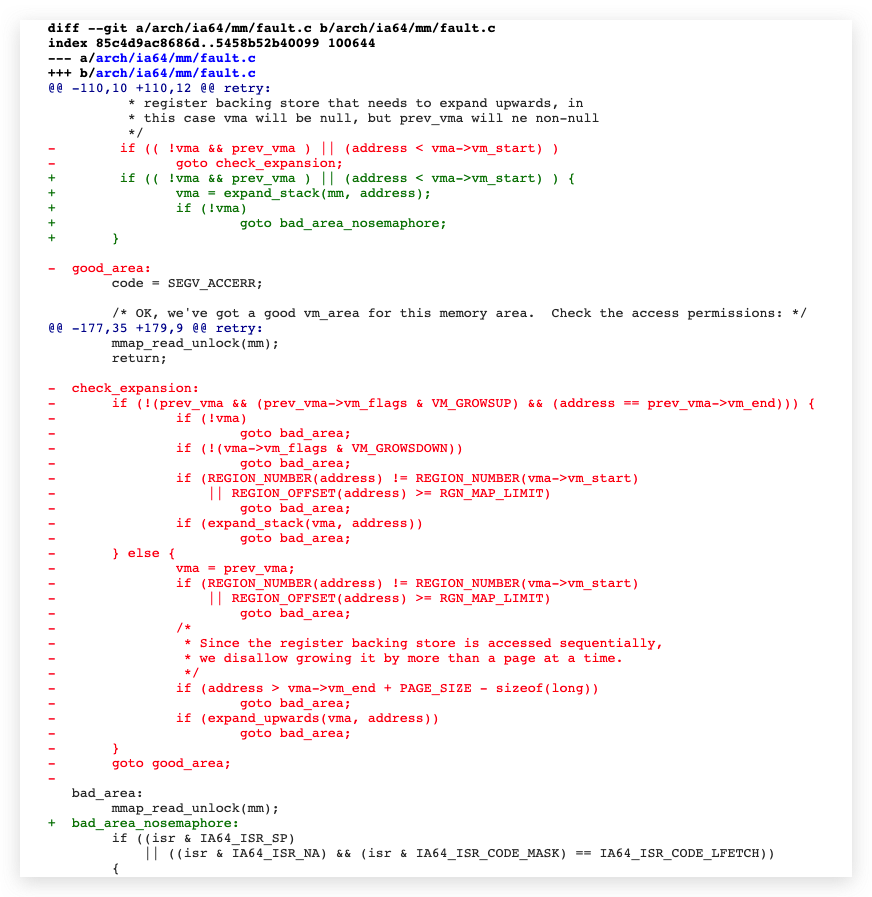

采用「大而浅」的架构相较于「小而深」的架构可以在某种程度上回避模型深度增加带来的优化难题。2016 年之前,许多研究者尝试加深卷积神经网络,VGG 类的模型到达 16 层之后就难以收敛。尽管 ResNet 的提出可以使网络做到很深,但是有一些研究表明,其有效深度并不深,信号可能会直接从残差连接处通过,加深网络并不能带来更大的有效感受野。此外,批归一化也使得模型能更好地被训练。如上图所示,从 ResNet-101 到 ResNet-152 增加了 51 层网络,但是有效感受野并不大。而在网络深度不变的情况下,将卷积核大小从 13*13 增加到 31*31 则可以增大有效感受野。

值得一提的是,大卷积核对于基于 FCN 的下游任务(例如,物体检测、分割)的性能提升十分明显。随着卷积核增大,网络在上游任务 ImageNet 图像分类上的性能趋于饱和,甚至有所下降,但是在下游任务上的性能持续增长。

解决大卷积核存在的问题

尽管大卷积核有诸多优秀的性质,可以增大有效感受野,但是以下弊端限制了大卷积核的使用:

(1)不够高效。为此,我们可以设计更浅的结构、采用卷积核分解技术、使用快速傅立叶(FFT)卷积加速、采用稀疏算子。增大卷积核主要增加的是算存比,并不会显著增加 I/O,可以通过针对性的优化保证计算速度。

(2)大卷积核难以兼顾局部特征,容易出现过平滑现象。为此,我们可以引入 Identity ShortCut 强调局部特征,还可以通过重参数化方法在使用大卷积核时,同时插入并行的小卷积核,在推理时将几个不同的线性卷积核合并为一个卷积核。

(3)相比于自注意力模块,卷积的归纳偏置过强,限制了在大数据集上的表示能力。为此,我们可以在小特征图上使用更大的卷积核(例如,将16*16 特征图进行零填充后采用 31*31 的卷积核),从而部分破坏平移等变性,从而在兼顾表达能力和泛化能力。这样做类似于 ViT 的位置编码,有利于编码绝对位置信息。

在上游任务 ImageNet 分类中,图像之间存在许多细粒度的差异,ImageNet 分类可能更加注重纹理特征,对感受野的要求并不高。采用大卷积核可以带来大的有效感受野,有利于提取上下文信息,提高神经网络的形状偏置,有效提升模型在下游任务上的性能。

在通向 CV 大模型的道路上,在模型设计层面,我们并不一定要拘泥于必须使用 Transformer,Transformer 在处理很多 CV 任务时并不方便。我们要打破一些思维惯性,也可以用基于 CNN 的架构构建大模型。但是,我们需要想办法克服掉 CNN 的一些缺陷(例如,使用大卷积)。

如何实现「统一」

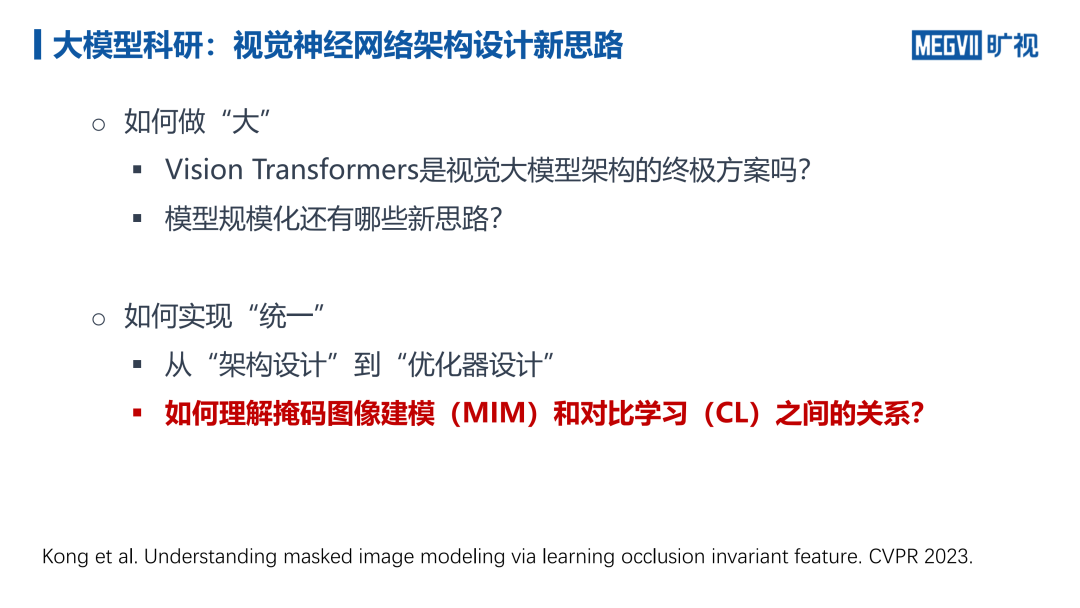

除了基础视觉架构设计,我们还需要充分利用数据,训练好大模型。为了降低对大量数据标注的需求,通过自监督学习训练网络的方法受到了越来越多的关注。

Moco、SimCLR 是近年来著名的基于对比学习的图像自监督训练方法;MAE 则是掩码图像建模(MIM)类自监督学习方法的代表。在 CVPR 2023 上,张祥雨博士团队发表了论文「understanding masked image modeling via learning occlusion invariant feature」,讨论了上述两种自监督学习之间的关系。

表征学习——信息瓶颈(IB)视角

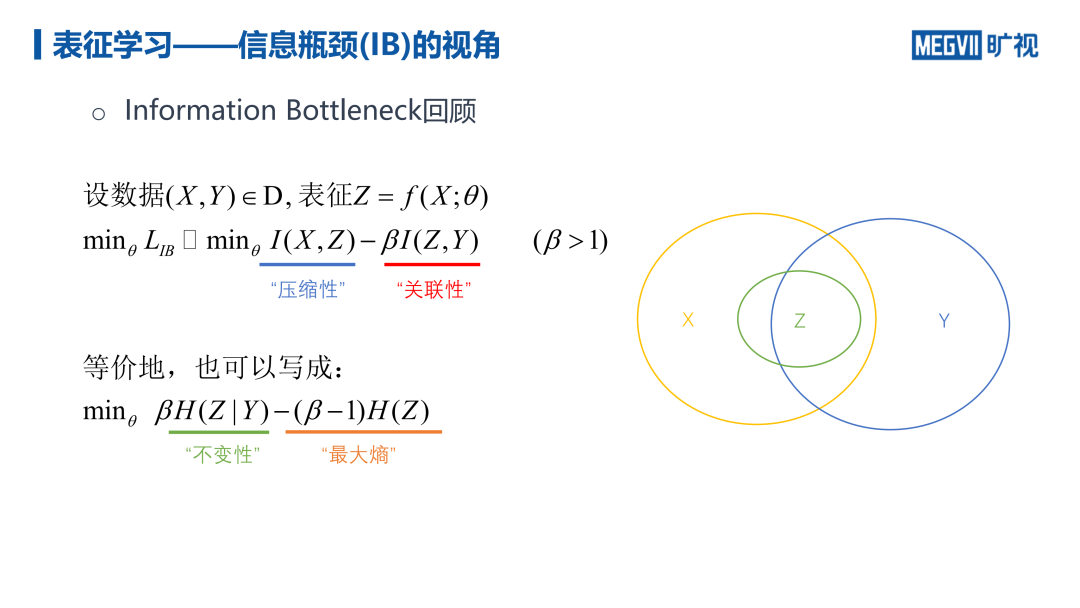

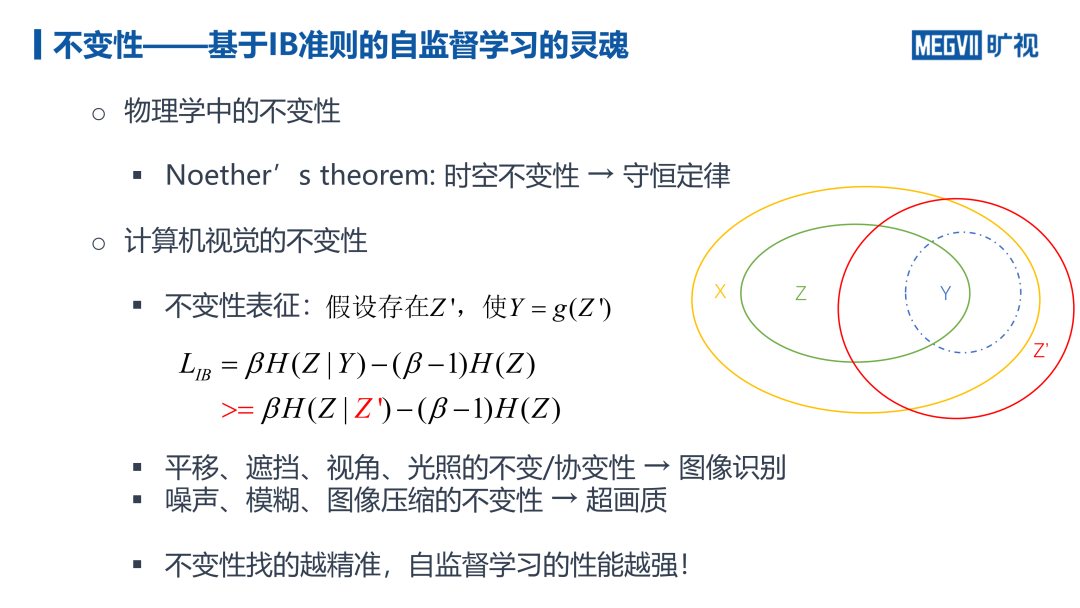

我们希望通过自监督任务对模型进行预训练,从而在下游任务上得到好的表征。在这里,我们从信息瓶颈(IB)的视角出发来衡量表征的质量。

如上图所示,x 为输入的图像样本,y 为样本类标签,z 为学习到的 x 的表征。其中,y 中有些特征可能是无法从 x 中得到的。而 z 是由 x 生成而来,因此包含在 x 中。我们期望输入图像 x 与 z 的互信息尽量小,标签 y 与 z 的互信息尽量大。

如上图所示,蓝色的式子被称为信息的「压缩性」,即表征拥有的信息量尽可能小,压缩掉无用的特征,保留下与任务相关的信息(即上图中的「关联性」)。

我们可以将该式写作两个熵的差值,绿色的部分为「不变性」,即表征只需要保留最相关的信息,实现特征在空间内的高内聚。为了防止所有的特征都映射到一个点,我们还需要加入最大熵约束,在汇聚信息的同时,尽可能保留完整的信息。

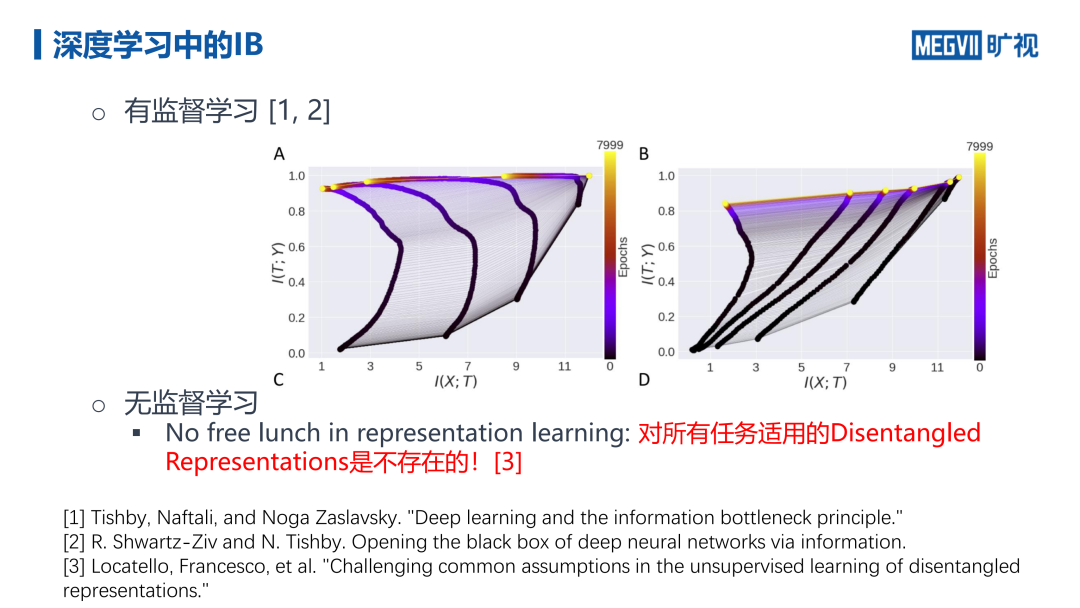

实际上,神经网络隐式地完成了信息瓶颈的要求。如上图所示,神经网络不同层在训练过程中轨迹如图中的曲线由紫到黄变化。随着训练的进行,特征 T 与 Y 的互信息单调上升,与 X 的互信息的变化趋势则分为两个阶段:在训练早期,T 与 Y 的互信息增长非常快,同时 T 与 X 互信息也在增长,网络在快速拟合数据;在第二阶段,尽管 T 与 Y 的互信息仍在增长,但是 T 与 X 的关联性则有所下降。这说明神经网络一方面在拟合数据,另一方面在压缩信息,「忘掉」一些知识。

可见,有监督学习过程中已经内嵌了 IB 的性质。然而,在无监督场景下,我们并不知道模型将面临怎样的下游任务。研究表明,并不存在对所有任务都适用的解耦表征。

近期,OpenAI 研究院 Jack Rae 指出,根据最小表示长度(MDL)准则,模型需要挖掘数据的本质规律(不变性),才能达到 MDL 的目标。如果我们可以用模型对信息进行无损压缩,切编码长度尽可能小,那么模型就拥有了「智能」。

在衡量无监督、自监督关系时,基于有监督学习的 IB 准则会失效。为此,我们引入「不变性」的概念。在物理学中,诺特定理指出,存在各种时空不变性(例如,平移不变性、旋转不变性),它们对应着各种守恒定律。

在训练视觉模型时,尽管不知道具体的下游任务,但是我们可以预期表征需要满足某些不变性假设。因此,构造自监督任务就是为了实现对不变性的挖掘。如上图所示,假设 Y=g(Z'),我们用 Z' 替代不变性中的条件 Y,得到了最优表征的下界。如果我们找到的不变性越精准,则描述的任务就越精确,学到的表征也就更好。

例如,对于图像识别任务而言,表征需要满足对平移、遮挡、视角、光照的不变/协变性;对于超画质任务,表征需要满足对噪声、模糊、图像压缩的不变性。

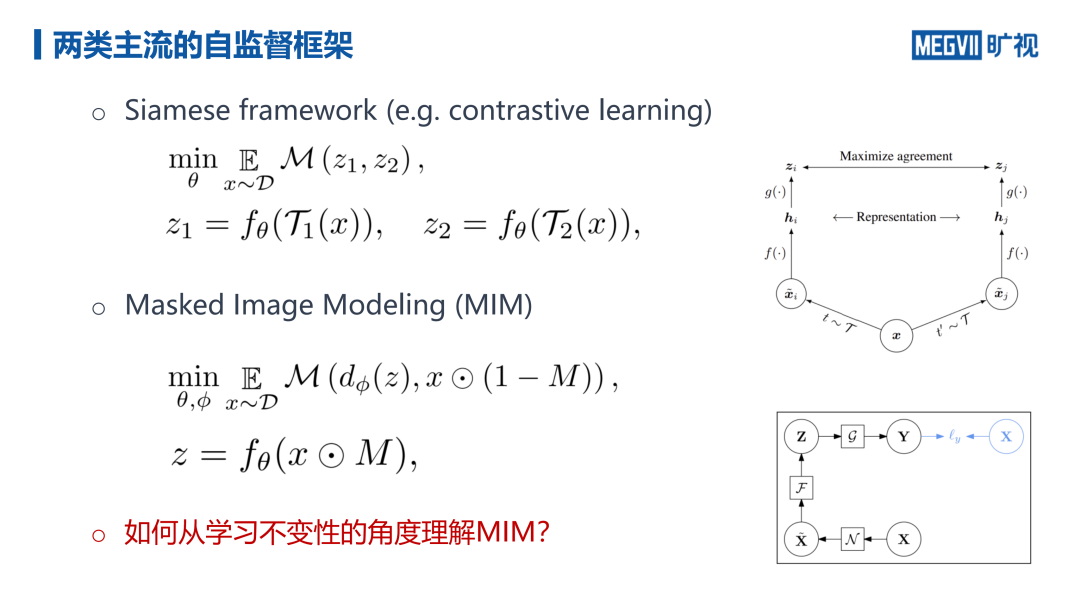

基于对比学习(孪生架构)的自监督框架会对信号进行两次变换,得到两种不同的增强结果(正样本),分别将这两种结果输入给网络得到两个特征,并期望最小化两种特征的距离,这实际上是学习到了对变换 T 的不变性。在对比学习中,负样本的存在是为了起到最大熵的效果,防止模型坍缩。MIM 则希望采用「编码器-解码器」架构将与 Mask 相乘后的图像还原为原图像。

如上图所示,我们可以将 MAE 通过一系列近似放缩为对比学习的孪生网络形式。结果表明,MAE 本质是学习在特定的距离度两下,对遮挡变换不变的特征。因此,通过 MAE 得到的特征在许多识别类任务上都取得了非常好的性能。在明确了 MAE 学习到对遮挡不变的特征后,可以帮助我们预判该模型能在哪些下游任务上起作用。

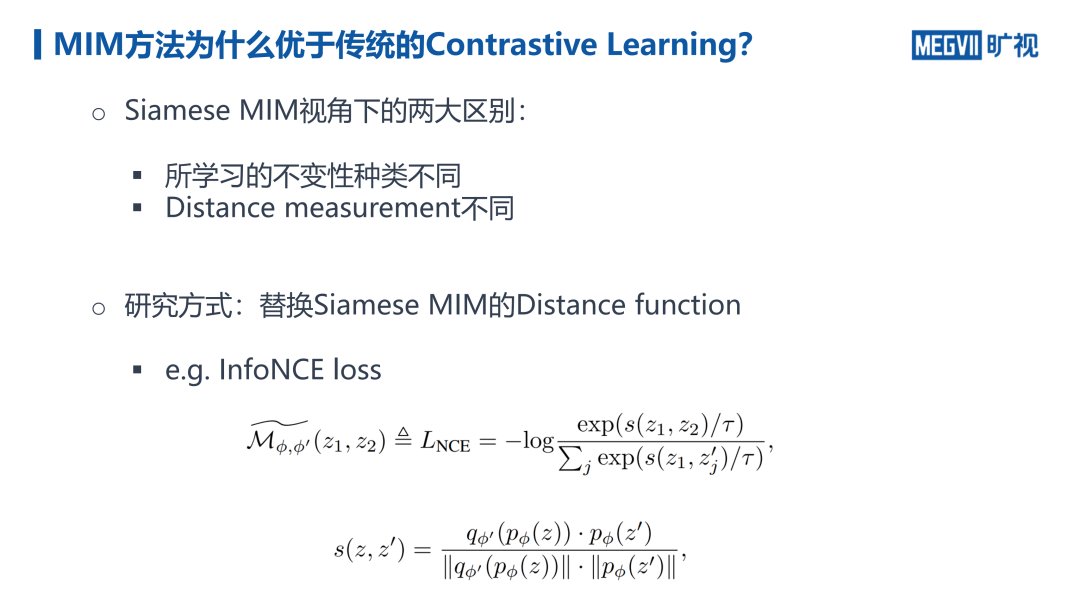

在 Siamese MIM 视角下,我们认为 MIM 与基于对比学习的自监督学习方法有两大区别:

(1)学习的不变性种类不同。MIM 学习遮挡不变性,传统的对比学习则学习数据变换 T 的不变性,例如:色彩都懂、随机裁剪

(2)距离度量不同

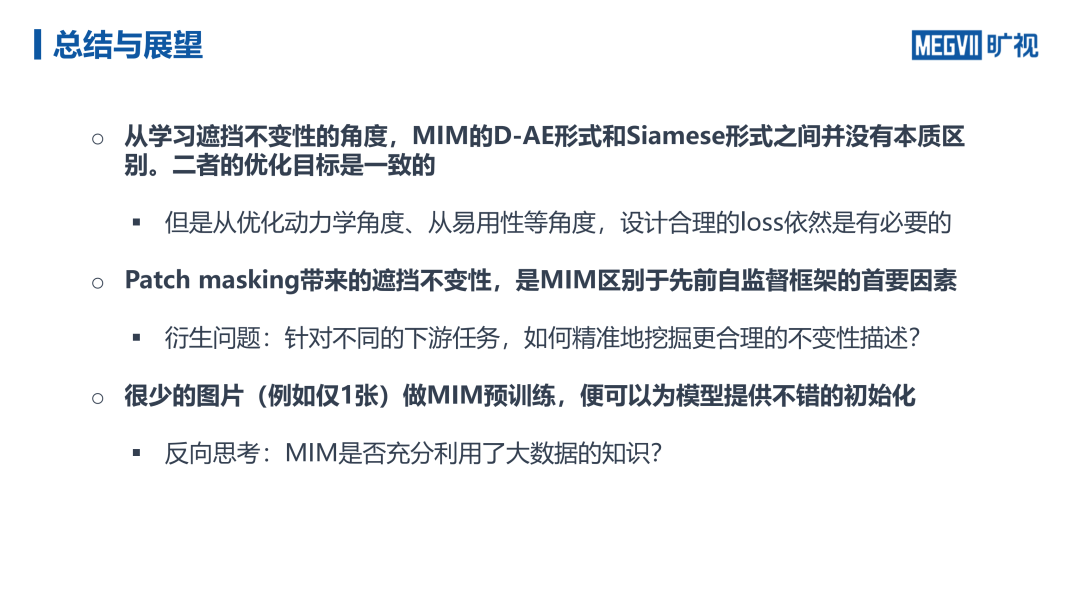

通过将 Siamese MIM 的距离度量函数替换为对比学习常用的 InfoNCE 损失函数。张祥雨博士团队发现,MIM 方法的主要优势在于使用了 patch 遮蔽方法,使表征具有了更加精准的遮挡不变性。

由于分类、目标检测、分割等目前评测视觉模型的对比测试基准都对遮挡不变性有很强的需求,MIM 相较于对比学习方法在此类任务上的性能更好。相较于随机裁剪变换,Patch 遮蔽则更加通用。此外,相较于 CNN 网络,视觉 Transformer 的自由度更大,模型性能与初始化质量息息相关。Patch 遮蔽引入了额外的归纳偏置,使得视觉 Transformer 模型的性能得到了显著提升。张祥雨博士团队通过实验发现,即使使用很少的图片(例如仅仅 1 张)做 MIM 预训练,也可以为模型提供不错的初始化。

模型规模化的新思路

我们不妨回顾一下已有的将模型做「大」的方法。实际上,从 EfficientNet 开始,大家就开始研究如何将模型做大。直观的方式有调整模型的宽度、深度、输入分辨率、卷积核大小等。谷歌提出的混合专家模型(MoE)目前效果还不太理想。目前,这些扩大模型规模的方法或多或少都遇到了性能瓶颈,收益比较有限。

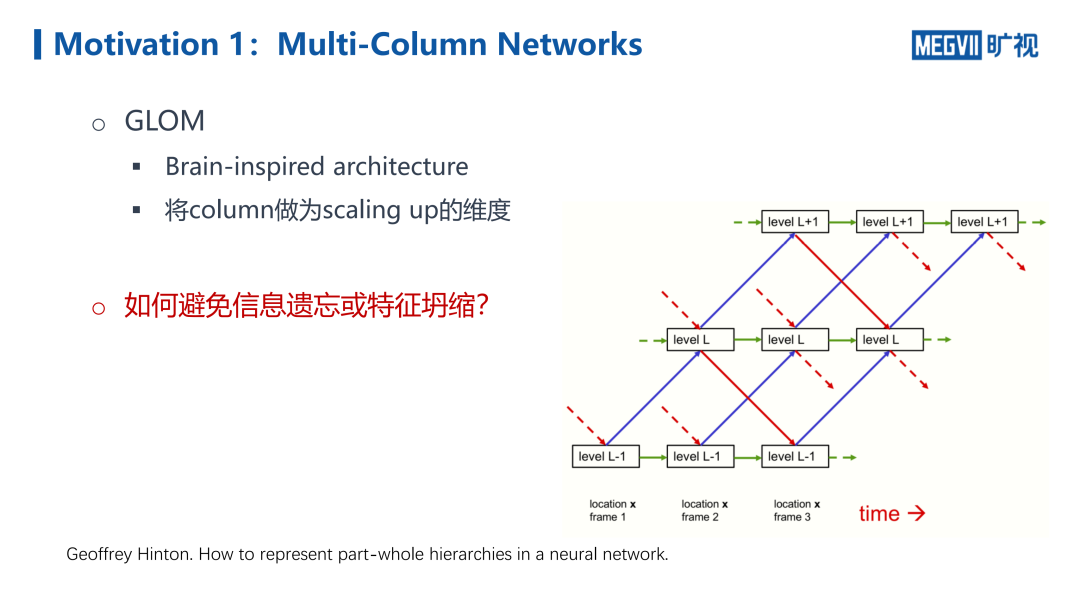

Hinton 在论文「How to represnet part-whole hierarchies in a neural network」中受人脑启发提出了 GLOM 架构,提出使用列(column)作为规模化扩展的维度。实际上,人的大脑皮层并没有神经网络上百层那么深,但是是一种带反馈的链路,人对食物的认知过程时循序渐进、由粗到精产生的。

张祥雨指出,可以借鉴多列神经网络(multi-column)的思想,将网络通过时序以类似于 RNN 的方式组织起来,不断将图像输入给不同阶段的网络,随着网络处理时间的增长,得到的精度就越高。然而,这种基于 RNN 的信息传递容易出现信息遗忘的现象,也无法保证每个「列」都能够学习得很好。出现特征坍塌现象。尽管可以扩展模型的规模,但是并不会带来本质的性能提升。

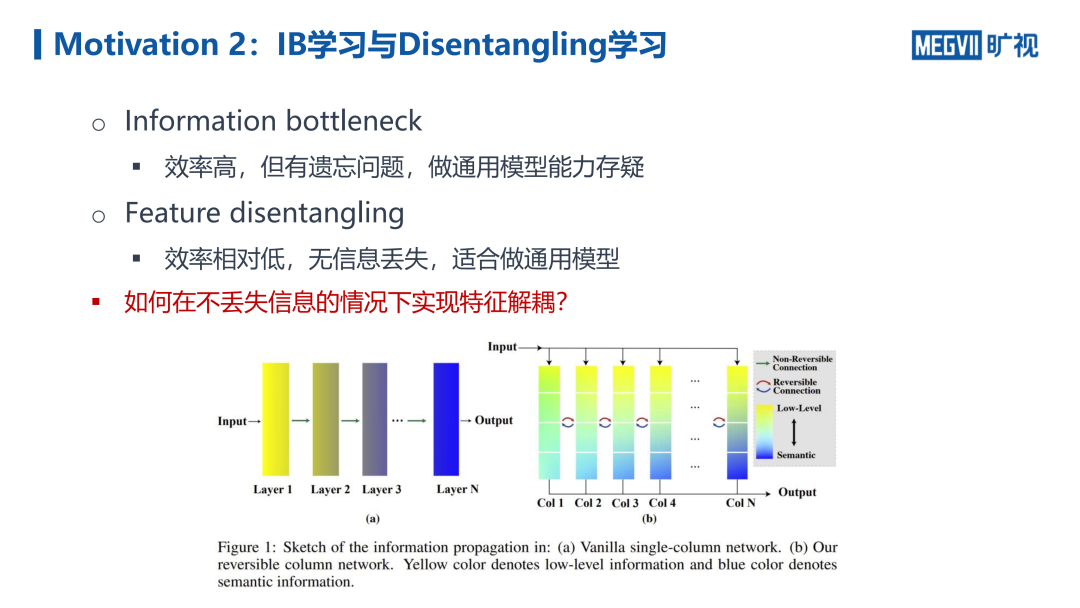

如前文所述,根据 IB 理论,神经网络会在信息压缩的过程中逐渐遗忘一些信息,只保留与监督信号有关的信息。如上图所示,网络在浅层是具有的信息量最高,越往后传播特征的语义性越强,但是信息量越少。由于存在信息瓶颈,通过多列网络扩展模型规模并得到性能较好的通用模型也比较困难。为此,张祥雨博士认为可以通过解耦学习将与任务相关的信息与和任务无关的信息解耦开来。然而,尽管解耦学习可以不丢失信息,适合做通用模型,但是效率相对较低。

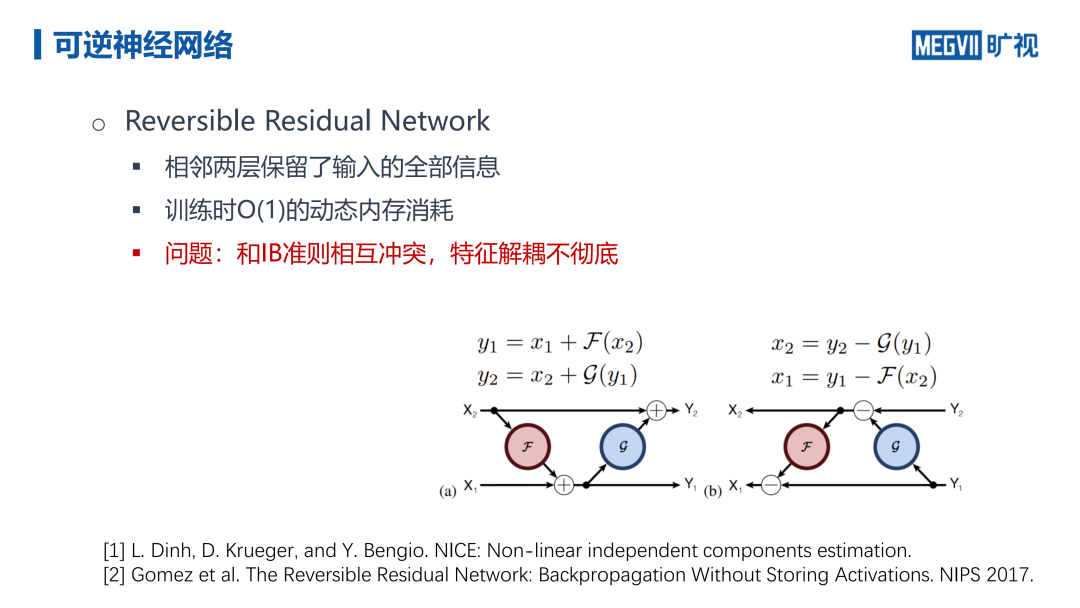

为了基于多列神经网络实现特征解耦学习,张祥雨博士团队想到利用可逆神经网络,保留相邻两层之间输入信息,并且在训练时只需要 O(1) 复杂度的的内存开销。然而,由于可逆神经网络与 IB 准则冲突,网络并不好训练,特征解耦不够彻底。

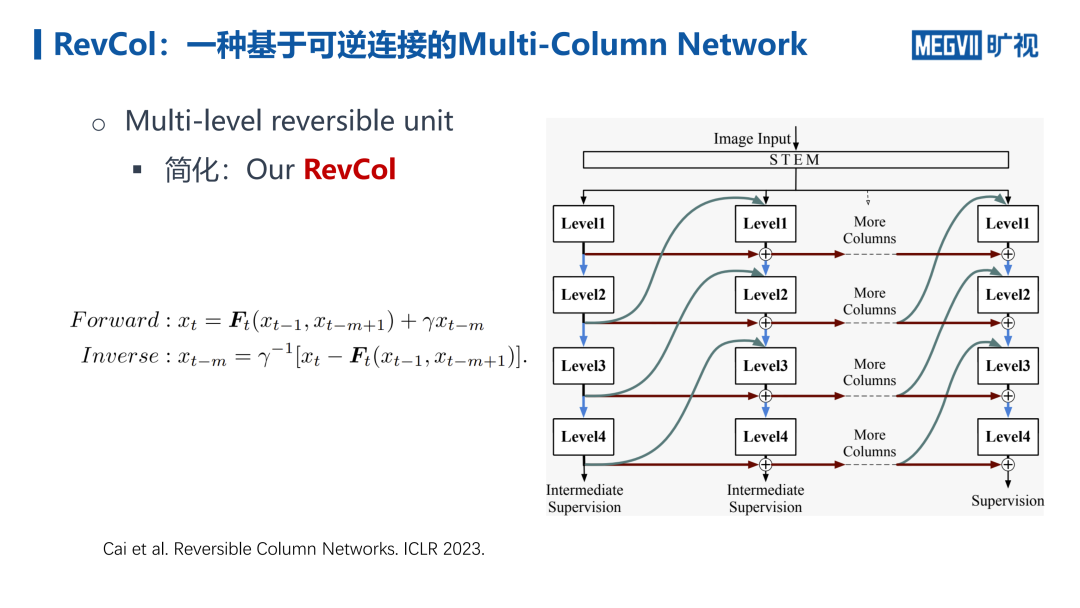

RevCol:一种基于可逆连接的多列网络

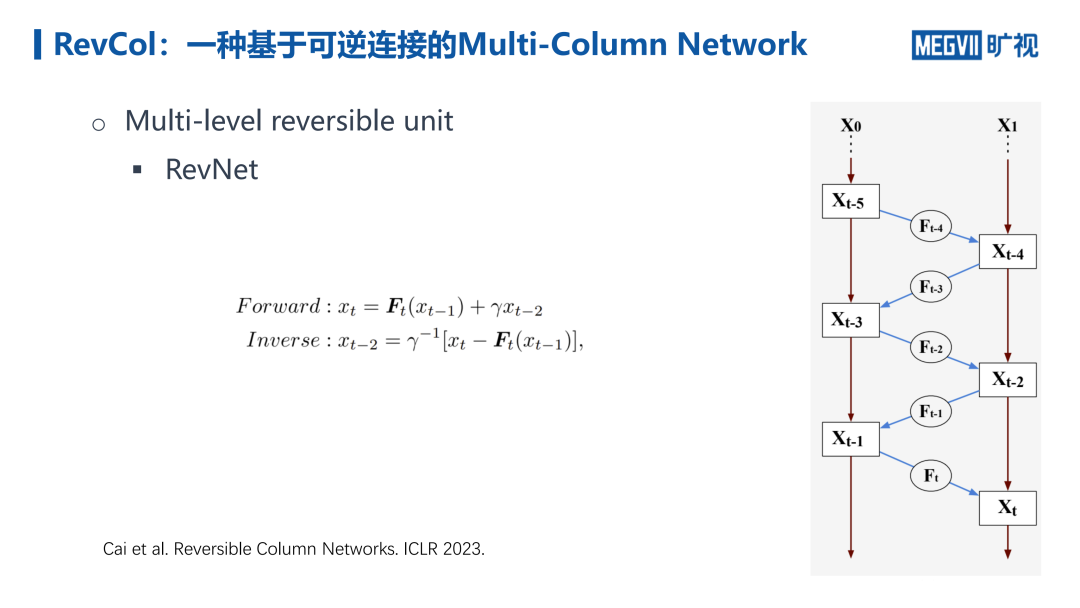

在论文「Reversible Column Networks」中,张祥雨博士团队提出了多级的可逆单元,将二阶递推过程扩展为了 n 阶递推过程,使得每 m 组信息都是可逆的,既可以前推也可以后推,不丢失信息。

通过简化,我们可以得到如上图所示的结构。该结构要求连接智能从下往上,并且水平连接必须是可逆算子。由此,我们得到了一个二维网格状的结构,而非传统的直筒状结构。并且引入了新的规模化扩展维度——「列」。通过增加列的维度,我们可以扩展模型的参数量。由于该网络可逆,每当计算完一个特征图,就可以将其扔掉,在反向传播时再计算一次特征图即可,从而在激活层面上实现了 O(1) 的显存占用。

未来展望:视觉大模型的关键问题

目前,视觉大模型开发充满机遇,也面临严峻挑战。

首先,NLP 领域通过思维链等技术实现的涌现能力似乎让人们找到了一条通往「AGI」的道路。真正实现 AGI 少不了视觉模态的智能,通过规模化扩展涌现出视觉智能是有希望的。然而,张祥雨认为,基于目前 MIM+ViT 大模型的框架实现视觉智能的涌现十分困难,这套方法的上限可能不够高。此外,我们还需要更好地实现对于长视频、长时序数据理解的网络训练。现阶段,我们可以通过多模态融合的方式,借助于 NLP 领域形成的逻辑推理能力,帮助视觉模型达到更高的智能。就多模态与训练而言,不仅仅需要将语言、视觉特征「对齐」,更需要形成各模态的互补,形成更紧密的逻辑联系。

此外,目前视觉模型相较于 NLP 模型的参数量低了一个数量级,且增加模型参数量获得的收益越来越有限。为了进一步有效地拓展视觉模型的参数量,张祥雨认为我们需要做到以下 3 点:(1)生成式与判别式的统一(2)不变性的挖掘(3)视频数据的高效建模。

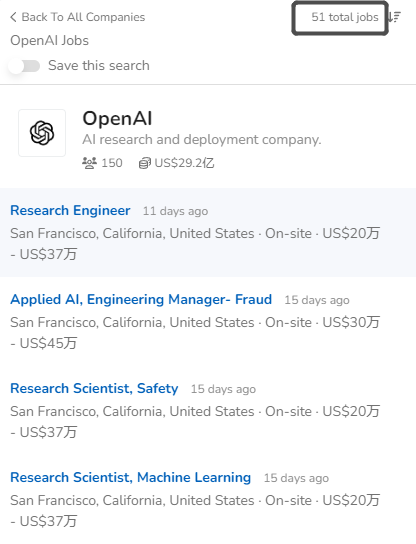

为了更好地为大家带来职场&科研学术/硕博交流的优质服务,深度学习技术前沿公众号 即日起组建各大厂招聘求职 & 知名高校硕博士申请 & 国内外博后访问的人员交流群。无论你是企业的招聘人员&算法工程师,或是高校的助理教授&研究人员,欢迎大家加入我们,一起打造一个优质的资源平台。有意向的小伙伴,请添加小助手微信(记得备注:高校 Or 企业哟!):

👆 长按识别即可!