文章目录

- Stitchable Neural Networks

- 摘要

- 本文方法

- 实验结果

Stitchable Neural Networks

摘要

包含大量强大的预训练模型族(如ResNet/DeiT)的model zoo已经达到了前所未有的范围,这对深度学习的成功有重要贡献。由于每个模型族都由具有不同尺度的预训练模型(例如,DeiT-Ti/S/B)组成,因此自然会出现一个基本问题,即如何有效地将这些现成的模型组装在一个家族中,以便在运行时动态地权衡精度和效率。

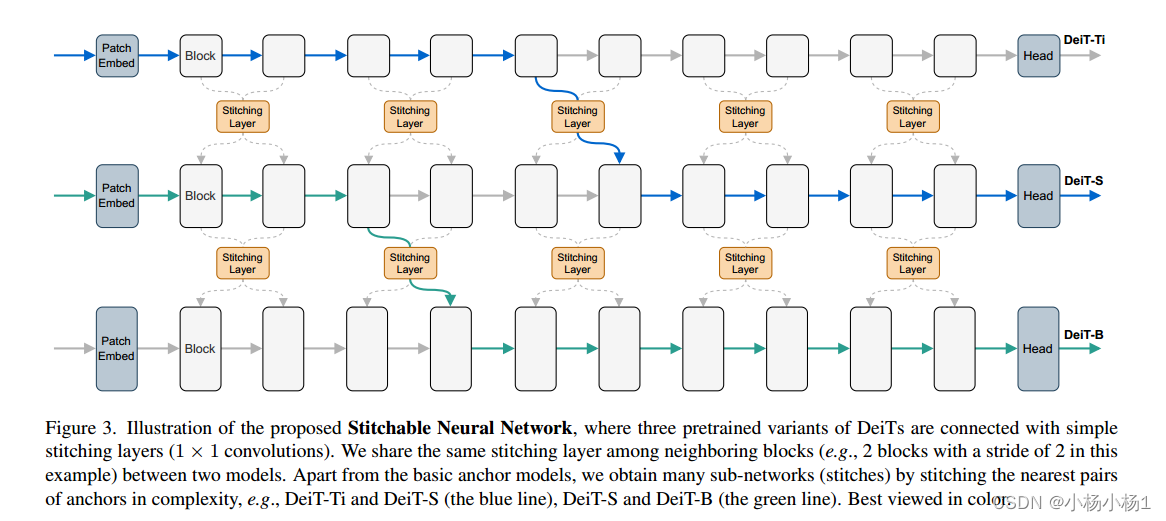

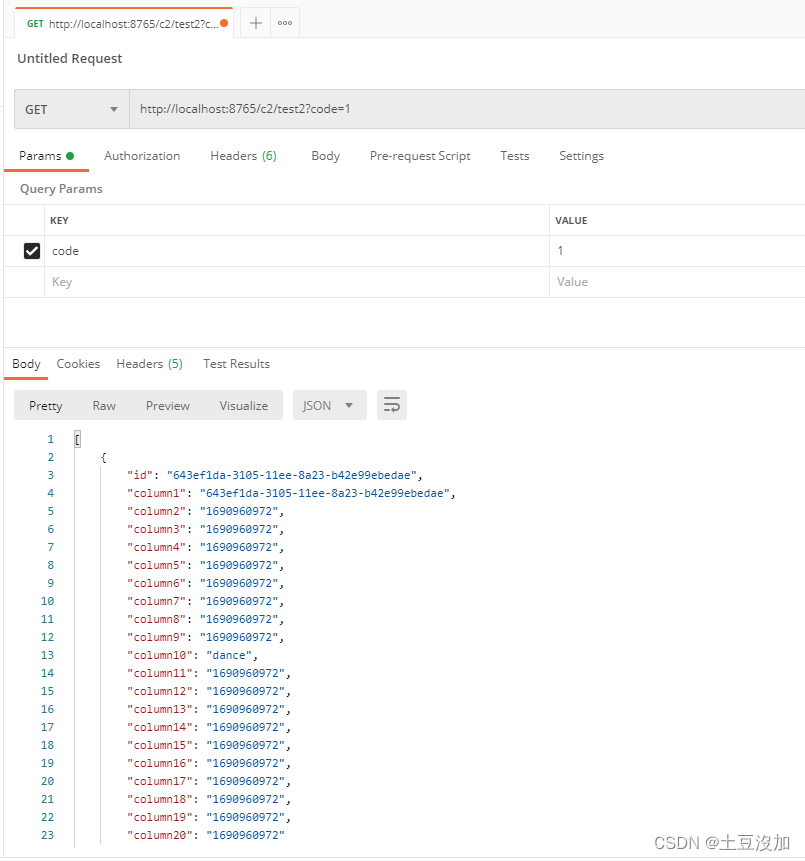

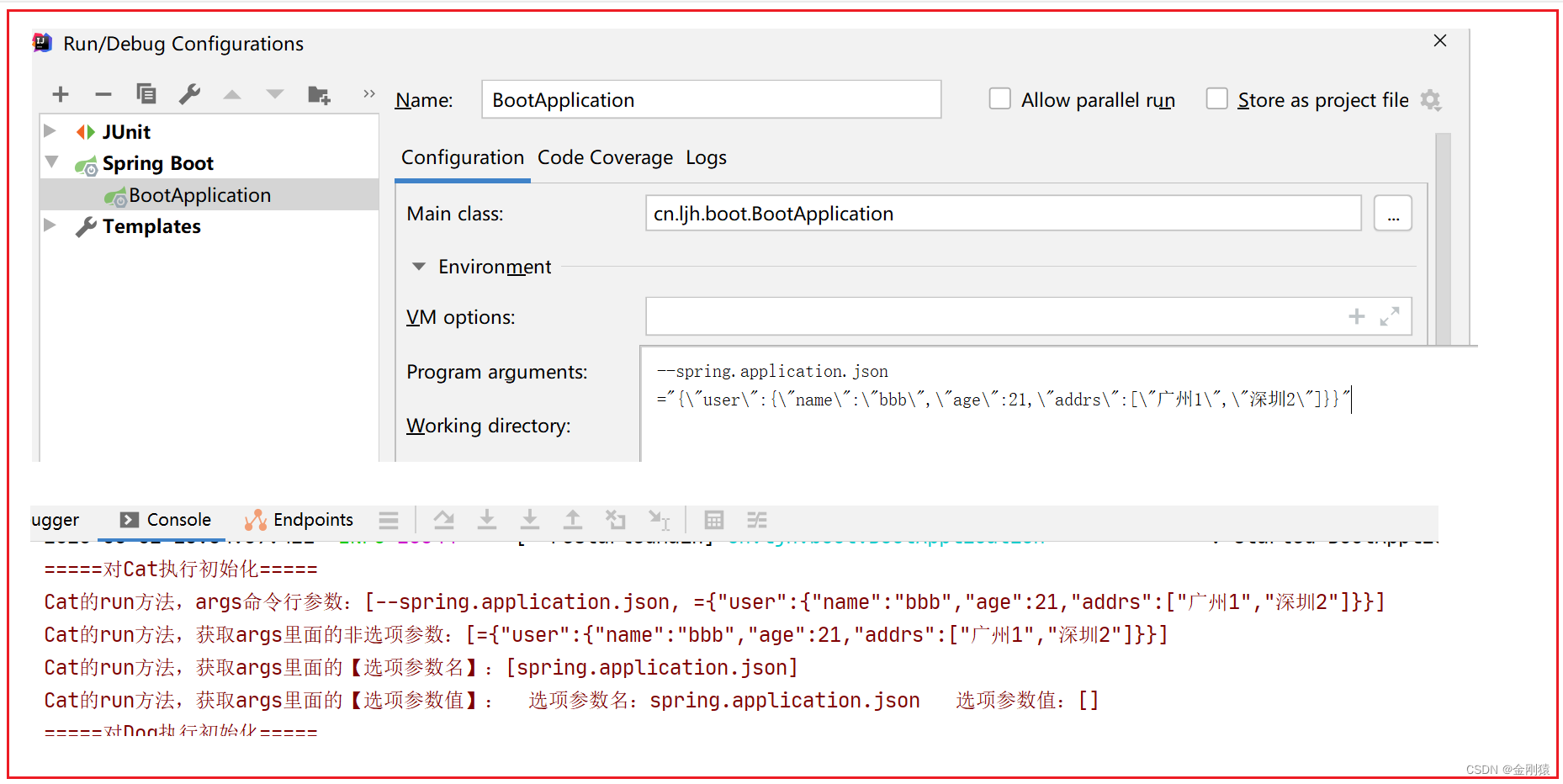

具体来说,SN-Net在块/层之间分割锚点,然后用简单的缝合层将它们缝合在一起,将一个锚点的激活映射到另一个锚点。只需几个epoch的训练,SN-Net就能有效地在不同尺度的锚点表现之间进行插值。在运行时,SN-Net可以通过切换拼接位置来即时适应动态资源约束。

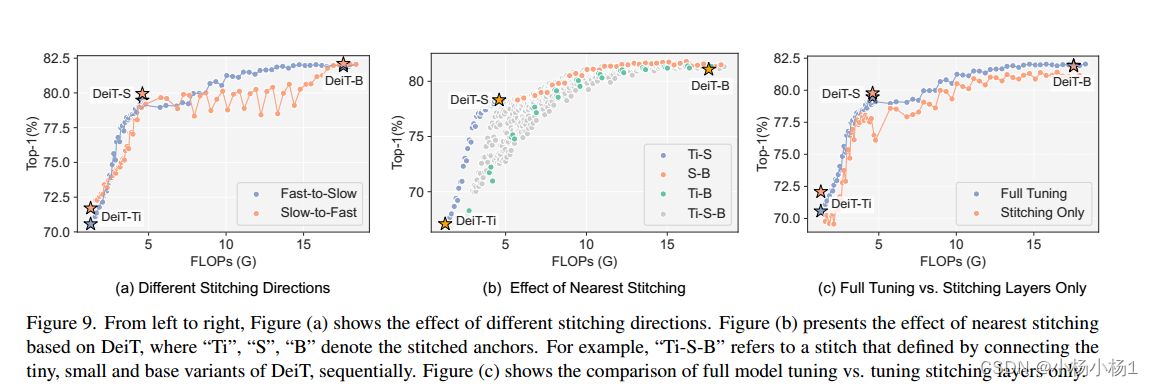

大量的ImageNet分类实验表明,与许多单独训练的网络相比,SN-Net可以获得同等甚至更好的性能。同时支持不同的部署场景。例如,通过拼接Swin Transformers,我们用一个网络挑战Timm模型动物园中的数百个模型。我们相信这个新的弹性模型框架可以作为更广泛社区进一步研究的强大基线。

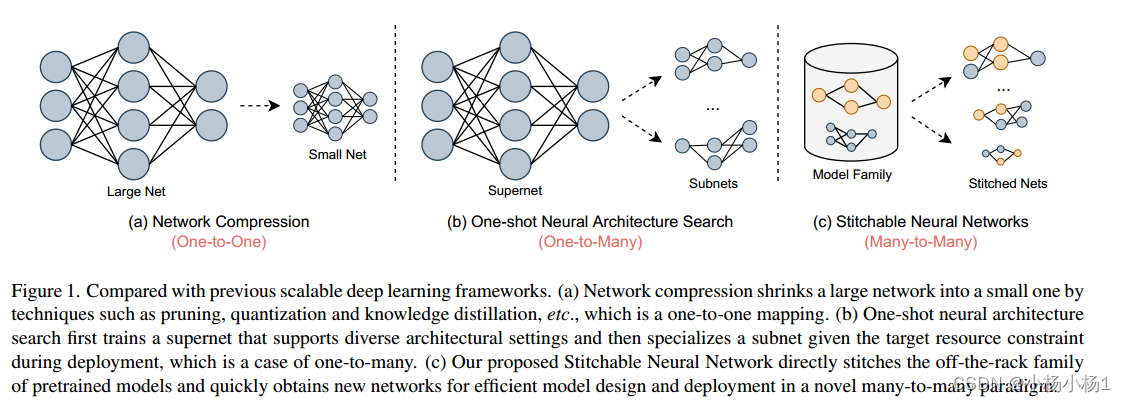

图1所示。与以前的可扩展深度学习框架相比。(a)网络压缩通过剪枝、量化、知识蒸馏等技术将大网络缩小为小网络,是一种一对一的映射。(b)单次神经架构搜索首先训练一个支持多种架构设置的超级网络,然后在部署过程中给定目标资源约束,对子网进行专门化,这是一对多的情况。©我们提出的可缝合神经网络直接缝合现成的预训练模型家族,并在一种新的多对多范式中快速获得有效的模型设计和部署的新网络

本文方法

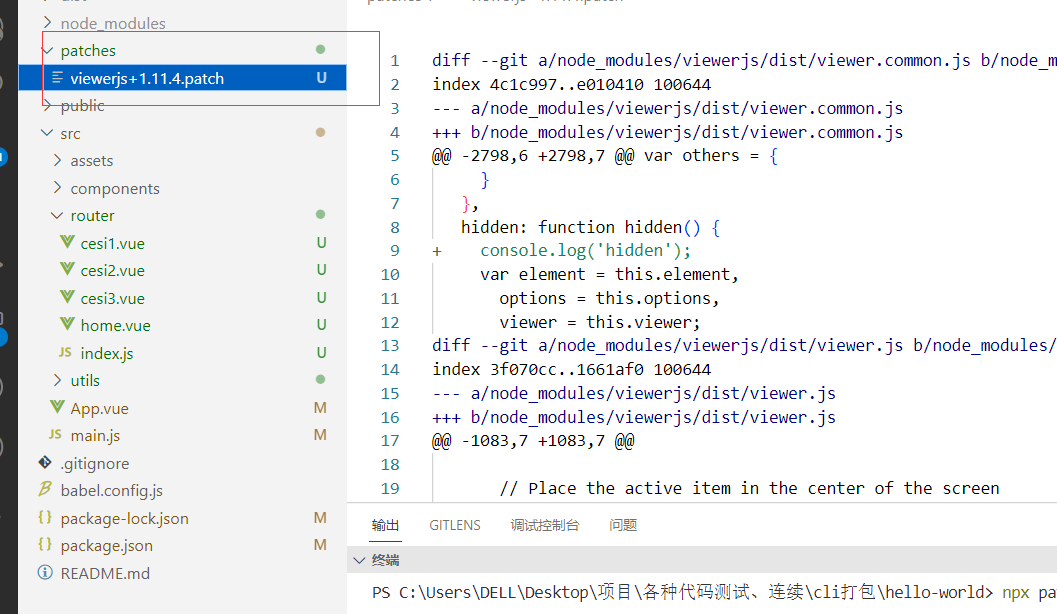

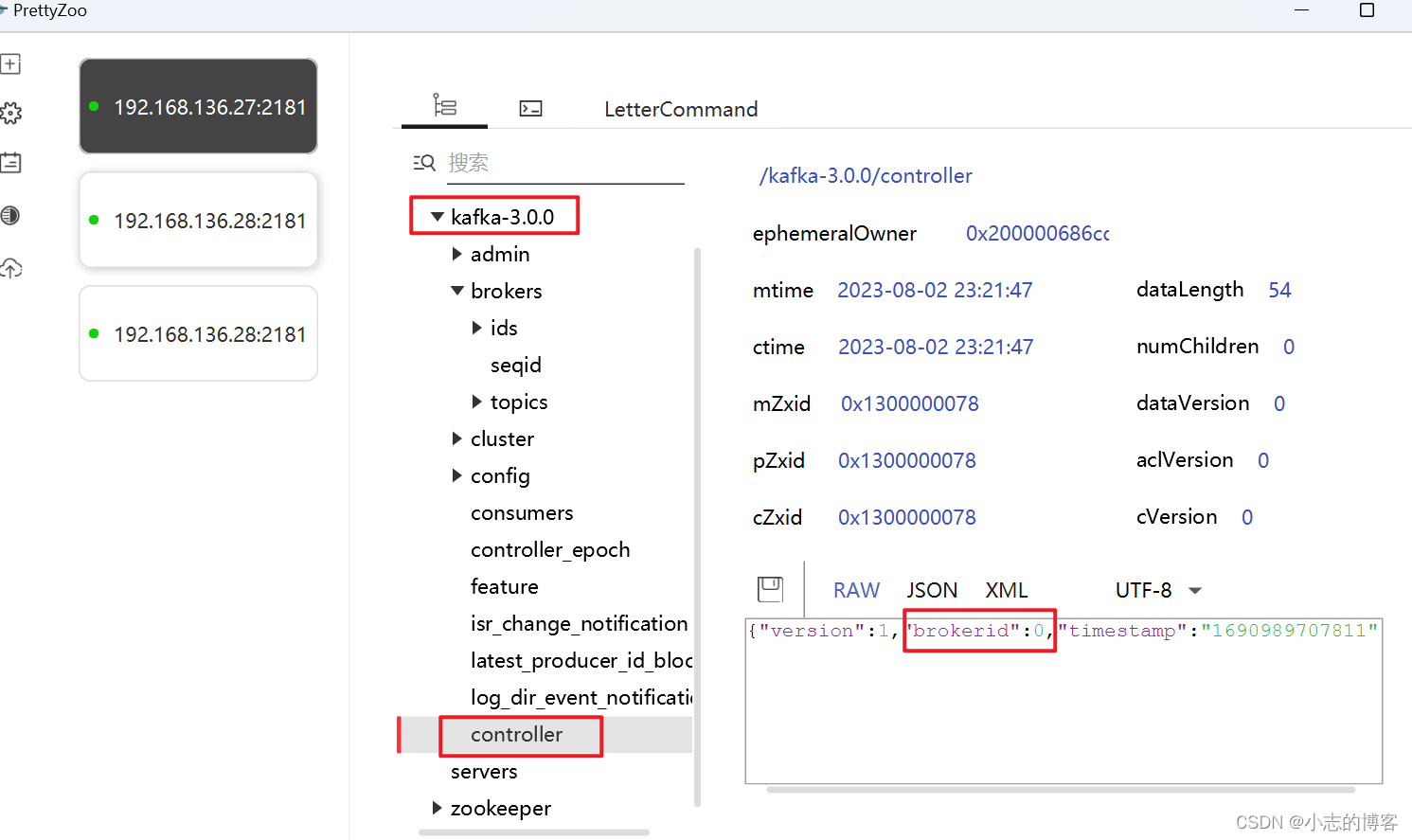

图3。所提出的可缝合神经网络的示意图,其中三个预训练的DeiTs变体与简单的缝合层(1 × 1卷积)相连。我们在两个模型之间的相邻块之间共享相同的拼接层(例如,在本例中,两个块的步长为2)。除了基本锚点模型外,我们还通过缝合复杂度最近的锚点对获得了许多子网络(缝线),例如DeiT-Ti和DeiT-S(蓝线),DeiT-S和DeiT-B(绿线)。

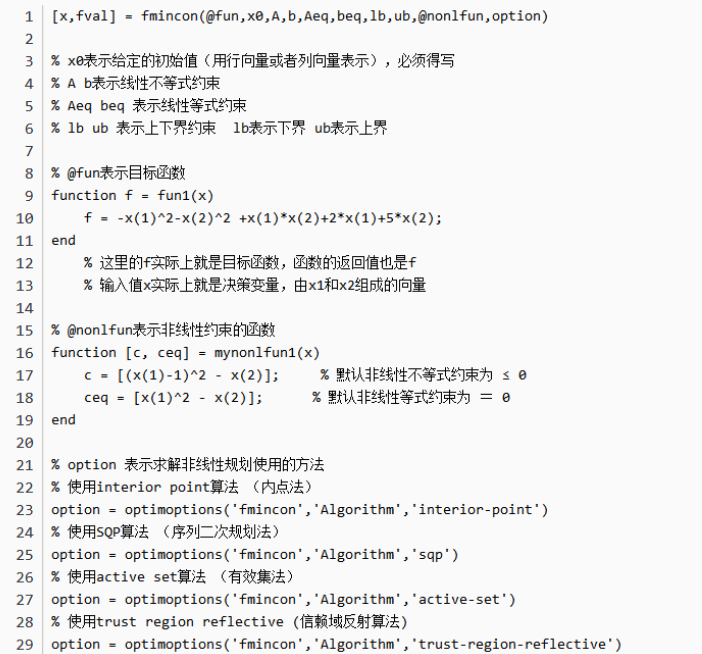

实验结果

![P1064 [NOIP2006 提高组] 金明的预算方案 (依赖背包问题)(内附封面)](https://img-blog.csdnimg.cn/c1e15b5ef772439188e43c916d4c5fbf.png)