文章目录

- Windows本地部署(DeepSeek-R1-Distill-Qwen-1.5B)模型

- 本机环境

- 运行环境安装

- 安装 WSL2,启用linux 系统

- 进入linux 系统后,安装以下软件

- 安装 Anaconda3

- 安装 CUDA

- 安装 pip

- 创建虚拟环境并安装 vllm

- 模型下载

- 模型运行部署

- 模型测试

Windows本地部署(DeepSeek-R1-Distill-Qwen-1.5B)模型

本案例演示了windows 本机部署模型的流程,同样适用于其他模型的部署

本机环境

本样例使用GPU 运行大模型,要关注你所部署的大模型要求的显卡能力,所以本次样例部署了 DeepSeek-R1-Distill-Qwen-1.5B 模型

硬件环境:

| 环境 | 说明 |

|---|---|

| 硬件 | N卡 gtx4060ti 8g显存 |

| 系统版本 | win10(19045 版本号:cmd命令行输入:winver 获取 )需要能安装wsl2,启用linux环境 |

软件环境:

| 软件 | 地址 | 说明 |

|---|---|---|

| python | - | 基础环境 |

| vllm | https://docs.vllm.ai/en/latest/index.html | vLLM 是一个快速且易于使用的 LLM 推理和服务库。 用于执行模型文件,并提供服务 (只支持部署在linux 系统中,所以需要使用 wsl2 技术在win中创建一个linux系统) |

| Anaconda3 | https://www.anaconda.com/download/success | Anaconda3 是一个开源的 Python 和 R 语言的分发版本,主要面向数据科学和机器学习领域。它集成了常用的包管理工具(如 conda)和环境管理工具,同时包含了数百个数据科学常用的库,如 NumPy、Pandas、Matplotlib、Scikit-learn 等。Anaconda3 提供了一站式的解决方案,便于用户创建、管理和切换 Python 环境,支持安装多个 Python 版本(例如 Python 2.x 和 3.x 共存)。通过 conda 工具轻松管理不同项目的依赖和环境,避免全局环境污染。支持虚拟环境独立化,确保项目间不发生库冲突。 |

| CUDA Toolkit | https://developer.nvidia.com/cuda-downloads?target_os=Linux&target_arch=x86_64&Distribution=Ubuntu&target_version=20.04&target_type=deb_local | CUDA Toolkit是由NVIDIA开发的通用并行计算平台和编程模型,主要用于在NVIDIA的GPU上执行并行计算任务。CUDA通过提供一组扩展的C语言(CUDA C/C++),使得程序员可以更容易地利用GPU的强大计算能力,显著提高计算性能。 |

| wsl2 | https://wslstorestorage.blob.core.windows.net/wslblob/wsl_update_x64.msi | WSL(Windows Subsystem for Linux)可以让用户在在 Windows 下体验 Linux 系统,WSL2 具备完整的 Linux 内核,因此具备所有的 Linux系统调用;WSL1实质上是将Linux的指令调用翻译成Windows的指令 |

运行环境安装

由于vllm 只支持在linux中运行,在 Windows 系统上安装 vllm 一般通过 Windows Subsystem for Linux (WSL) 来进行,以下是具体步骤:

安装 WSL2,启用linux 系统

- 启用适用于 Linux 的 Windows 子系统:检查 Windows 功能中 “适用于 Linux 的 Windows 子系统” 是否开启,若未开启,可在命令提示符(管理员权限)中执行

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart,之后重启电脑。 - 检查 WSL2 的要求:对于 64 位系统,版本需 1903 或更高,版本号 18362 或更高;对于 ARM64 系统,版本需 2004 或更高,版本号 19041 或更高。可通过 “win + r”,在搜索框输入 “winver” 查看当前版本。同时,查看电脑是否开启开发人员模式。

- 启用虚拟机功能:在命令提示符(管理员权限)中执行

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart。 - 安装 Linux 内核更新包:下载地址为https://wslstorestorage.blob.core.windows.net/wslblob/wsl_update_x64.msi,双击安装。

- 将 WSL2 设置为默认版本:在命令提示符中执行

wsl --set-default-version 2。 - 安装选择的 Linux 发行版:进入https://docs.microsoft.com/en-us/windows/wsl/install-manual选择合适的系统安装包,如 ubuntu22.04。下载完成后,双击安装,第一次进入 Ubuntu 系统,需要设置用户名、密码等。

可能遇到的问题:

会提示:请启用 “虚拟机平台” 这一 Windows 功能,并确保在 BIOS 中启用了虚拟化技术。 (需要查看下主板bios和windows功能是否都开启了 虚拟化技术,具体主板 bios 开启方法,请搜索本机主板的型号)

进入linux 系统后,安装以下软件

安装 Anaconda3

先下载 Anaconda3 安装包:https://www.anaconda.com/download/success 下载linux 版本,下载到 D盘下

进入 WSL2 终端 Anaconda3 安装包的目录,如 D 盘可执行cd /mnt/d,然后执行bash Anaconda3-2024.06-1-Linux-x86_64.sh开始安装,安装过程一路回车输入 yes,最后一步建议输入 yes,会将 conda 环境变量写入~/.bashrc 文件中。安装完成后可使用conda -V查看,若环境变量未生效,可通过vim ~/.bashrc在最后一行添加export PATH=$PATH:/path/to/anaconda3/bin,替换/path/to/anaconda3为实际安装路径,再执行source ~/.bashrc更新环境变量。

安装 CUDA

登录 WSL 后,根据 NVIDIA 下载页面的说明安装 CUDA 11.8,依次执行以下命令:也可以参考官方说明:https://developer.nvidia.com/cuda-downloads?target_os=Linux&target_arch=x86_64&Distribution=Ubuntu&target_version=20.04&target_type=deb_local

wget https://developer.download.nvidia.com/compute/cuda/repos/wsl-ubuntu/x86_64/cuda-wsl-ubuntu.pinsudo mv cuda-wsl-ubuntu.pin /etc/apt/preferences.d/cuda-repository-pin-600wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda-repo-wsl-ubuntu-11-8-local_11.8.0-1_amd64.debsudo dpkg -i cuda-repo-wsl-ubuntu-11-8-local_11.8.0-1_amd64.debsudo cp /var/cuda-repo-wsl-ubuntu-11-8-local/cuda-*-keyring.gpg /usr/share/keyrings/sudo apt-get updatesudo apt-get -y install cuda

安装 pip

在 Ubuntu 中安装 pip,执行sudo apt-get install python3-pip。

创建虚拟环境并安装 vllm

通过 conda 创建一个新虚拟环境,指定虚拟环境中包括 python3.12 的 packages,执行conda create -n env-vllm python=3.12 -y,

然后激活使用该虚拟环境conda activate env-vllm。

之后在虚拟环境中通过 pip 自动下载并安装 vllm

# Install vLLM from pip:

pip install vllm

模型下载

模型库文件下载:

https://modelscope.cn/models/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B 国内 modelscope

或者:

https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B?local-app=vllm 通过 huggingface下载

本样例通过git下载: 请确保 lfs 已经被正确安装

git lfs installgit clone https://www.modelscope.cn/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B.git

当前先下载到本机的 E:\models 下

模型运行部署

使用了刚才下载的模型地址

# Load and run the model:

# gpu_memory_utilization 参数控制着 GPU 内存的使用比例,增大该值可以让引擎使用更多的 GPU 内存来存储 KV 缓存。

# max_model_len 参数指定了模型支持的最大序列长度,减小该值可以使模型的序列长度适配 KV 缓存的容量。vllm serve /mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B --gpu-memory-utilization 0.92 --max-model-len 90000

这里打印一些执行日志:

(env-vllm) gengzi@WIN-N2TM7S7PLOF:~$ vllm serve /mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B --gpu-memory-utilization 0.92 --max-model-len 90000

INFO 01-26 18:18:26 api_server.py:712] vLLM API server version 0.6.6.post1

INFO 01-26 18:18:26 api_server.py:713] args: Namespace(subparser='serve', model_tag='/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B', config='', host=None, port=8000, uvicorn_log_level='info', allow_credentials=False, allowed_origins=['*'], allowed_methods=['*'], allowed_headers=['*'], api_key=None, lora_modules=None, prompt_adapters=None, chat_template=None, chat_template_content_format='auto', response_role='assistant', ssl_keyfile=None, ssl_certfile=None, ssl_ca_certs=None, ssl_cert_reqs=0, root_path=None, middleware=[], return_tokens_as_token_ids=False, disable_frontend_multiprocessing=False, enable_request_id_headers=False, enable_auto_tool_choice=False, tool_call_parser=None, tool_parser_plugin='', model='/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B', task='auto', tokenizer=None, skip_tokenizer_init=False, revision=None, code_revision=None, tokenizer_revision=None, tokenizer_mode='auto', trust_remote_code=False, allowed_local_media_path=None, download_dir=None, load_format='auto', config_format=<ConfigFormat.AUTO: 'auto'>, dtype='auto', kv_cache_dtype='auto', quantization_param_path=None, max_model_len=90000, guided_decoding_backend='xgrammar', logits_processor_pattern=None, distributed_executor_backend=None, worker_use_ray=False, pipeline_parallel_size=1, tensor_parallel_size=1, max_parallel_loading_workers=None, ray_workers_use_nsight=False, block_size=None, enable_prefix_caching=None, disable_sliding_window=False, use_v2_block_manager=True, num_lookahead_slots=0, seed=0, swap_space=4, cpu_offload_gb=0, gpu_memory_utilization=0.92, num_gpu_blocks_override=None, max_num_batched_tokens=None, max_num_seqs=None, max_logprobs=20, disable_log_stats=False, quantization=None, rope_scaling=None, rope_theta=None, hf_overrides=None, enforce_eager=False, max_seq_len_to_capture=8192, disable_custom_all_reduce=False, tokenizer_pool_size=0, tokenizer_pool_type='ray', tokenizer_pool_extra_config=None, limit_mm_per_prompt=None, mm_processor_kwargs=None, disable_mm_preprocessor_cache=False, enable_lora=False, enable_lora_bias=False, max_loras=1, max_lora_rank=16, lora_extra_vocab_size=256, lora_dtype='auto', long_lora_scaling_factors=None, max_cpu_loras=None, fully_sharded_loras=False, enable_prompt_adapter=False, max_prompt_adapters=1, max_prompt_adapter_token=0, device='auto', num_scheduler_steps=1, multi_step_stream_outputs=True, scheduler_delay_factor=0.0, enable_chunked_prefill=None, speculative_model=None, speculative_model_quantization=None, num_speculative_tokens=None, speculative_disable_mqa_scorer=False, speculative_draft_tensor_parallel_size=None, speculative_max_model_len=None, speculative_disable_by_batch_size=None, ngram_prompt_lookup_max=None, ngram_prompt_lookup_min=None, spec_decoding_acceptance_method='rejection_sampler', typical_acceptance_sampler_posterior_threshold=None, typical_acceptance_sampler_posterior_alpha=None, disable_logprobs_during_spec_decoding=None, model_loader_extra_config=None, ignore_patterns=[], preemption_mode=None, served_model_name=None, qlora_adapter_name_or_path=None, otlp_traces_endpoint=None, collect_detailed_traces=None, disable_async_output_proc=False, scheduling_policy='fcfs', override_neuron_config=None, override_pooler_config=None, compilation_config=None, kv_transfer_config=None, worker_cls='auto', generation_config=None, disable_log_requests=False, max_log_len=None, disable_fastapi_docs=False, enable_prompt_tokens_details=False, dispatch_function=<function serve at 0x7f009059eac0>)

INFO 01-26 18:18:26 api_server.py:199] Started engine process with PID 30787

INFO 01-26 18:18:28 config.py:510] This model supports multiple tasks: {'embed', 'classify', 'generate', 'score', 'reward'}. Defaulting to 'generate'.

WARNING 01-26 18:18:28 arg_utils.py:1103] Chunked prefill is enabled by default for models with max_model_len > 32K. Currently, chunked prefill might not work with some features or models. If you encounter any issues, please disable chunked prefill by setting --enable-chunked-prefill=False.

INFO 01-26 18:18:28 config.py:1458] Chunked prefill is enabled with max_num_batched_tokens=2048.

INFO 01-26 18:18:30 config.py:510] This model supports multiple tasks: {'generate', 'classify', 'score', 'embed', 'reward'}. Defaulting to 'generate'.

WARNING 01-26 18:18:30 arg_utils.py:1103] Chunked prefill is enabled by default for models with max_model_len > 32K. Currently, chunked prefill might not work with some features or models. If you encounter any issues, please disable chunked prefill by setting --enable-chunked-prefill=False.

INFO 01-26 18:18:30 config.py:1458] Chunked prefill is enabled with max_num_batched_tokens=2048.

INFO 01-26 18:18:30 llm_engine.py:234] Initializing an LLM engine (v0.6.6.post1) with config: model='/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B', speculative_config=None, tokenizer='/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B', skip_tokenizer_init=False, tokenizer_mode=auto, revision=None, override_neuron_config=None, tokenizer_revision=None, trust_remote_code=False, dtype=torch.bfloat16, max_seq_len=90000, download_dir=None, load_format=LoadFormat.AUTO, tensor_parallel_size=1, pipeline_parallel_size=1, disable_custom_all_reduce=False, quantization=None, enforce_eager=False, kv_cache_dtype=auto, quantization_param_path=None, device_config=cuda, decoding_config=DecodingConfig(guided_decoding_backend='xgrammar'), observability_config=ObservabilityConfig(otlp_traces_endpoint=None, collect_model_forward_time=False, collect_model_execute_time=False), seed=0, served_model_name=/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B, num_scheduler_steps=1, multi_step_stream_outputs=True, enable_prefix_caching=False, chunked_prefill_enabled=True, use_async_output_proc=True, disable_mm_preprocessor_cache=False, mm_processor_kwargs=None, pooler_config=None, compilation_config={"splitting_ops":["vllm.unified_attention","vllm.unified_attention_with_output"],"candidate_compile_sizes":[],"compile_sizes":[],"capture_sizes":[256,248,240,232,224,216,208,200,192,184,176,168,160,152,144,136,128,120,112,104,96,88,80,72,64,56,48,40,32,24,16,8,4,2,1],"max_capture_size":256}, use_cached_outputs=True,

WARNING 01-26 18:18:31 interface.py:236] Using 'pin_memory=False' as WSL is detected. This may slow down the performance.

INFO 01-26 18:18:31 selector.py:120] Using Flash Attention backend.

INFO 01-26 18:18:31 model_runner.py:1094] Starting to load model /mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B...

Loading safetensors checkpoint shards: 0% Completed | 0/1 [00:00<?, ?it/s]

Loading safetensors checkpoint shards: 100% Completed | 1/1 [01:03<00:00, 63.78s/it]

Loading safetensors checkpoint shards: 100% Completed | 1/1 [01:03<00:00, 63.78s/it]INFO 01-26 18:19:35 model_runner.py:1099] Loading model weights took 3.3460 GB

INFO 01-26 18:19:36 worker.py:241] Memory profiling takes 0.97 seconds

INFO 01-26 18:19:36 worker.py:241] the current vLLM instance can use total_gpu_memory (8.00GiB) x gpu_memory_utilization (0.92) = 7.36GiB

INFO 01-26 18:19:36 worker.py:241] model weights take 3.35GiB; non_torch_memory takes 0.18GiB; PyTorch activation peak memory takes 1.39GiB; the rest of the memory reserved for KV Cache is 2.44GiB.

INFO 01-26 18:19:36 gpu_executor.py:76] # GPU blocks: 5718, # CPU blocks: 9362

INFO 01-26 18:19:36 gpu_executor.py:80] Maximum concurrency for 90000 tokens per request: 1.02x

INFO 01-26 18:19:37 model_runner.py:1415] Capturing cudagraphs for decoding. This may lead to unexpected consequences if the model is not static. To run the model in eager mode, set 'enforce_eager=True' or use '--enforce-eager' in the CLI. If out-of-memory error occurs during cudagraph capture, consider decreasing `gpu_memory_utilization` or switching to eager mode. You can also reduce the `max_num_seqs` as needed to decrease memory usage.

Capturing CUDA graph shapes: 100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 35/35 [00:10<00:00, 3.39it/s]

INFO 01-26 18:19:47 model_runner.py:1535] Graph capturing finished in 10 secs, took 0.08 GiB

INFO 01-26 18:19:47 llm_engine.py:431] init engine (profile, create kv cache, warmup model) took 11.59 seconds

INFO 01-26 18:19:47 api_server.py:640] Using supplied chat template:

INFO 01-26 18:19:47 api_server.py:640] None

INFO 01-26 18:19:47 launcher.py:19] Available routes are:

INFO 01-26 18:19:47 launcher.py:27] Route: /openapi.json, Methods: HEAD, GET

INFO 01-26 18:19:47 launcher.py:27] Route: /docs, Methods: HEAD, GET

INFO 01-26 18:19:47 launcher.py:27] Route: /docs/oauth2-redirect, Methods: HEAD, GET

INFO 01-26 18:19:47 launcher.py:27] Route: /redoc, Methods: HEAD, GET

INFO 01-26 18:19:47 launcher.py:27] Route: /health, Methods: GET

INFO 01-26 18:19:47 launcher.py:27] Route: /tokenize, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /detokenize, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /v1/models, Methods: GET

INFO 01-26 18:19:47 launcher.py:27] Route: /version, Methods: GET

INFO 01-26 18:19:47 launcher.py:27] Route: /v1/chat/completions, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /v1/completions, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /v1/embeddings, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /pooling, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /score, Methods: POST

INFO 01-26 18:19:47 launcher.py:27] Route: /v1/score, Methods: POST

INFO: Started server process [30740]

INFO: Waiting for application startup.

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

INFO: ::1:54764 - "GET /v1/models HTTP/1.1" 200 OK

这里可以看到,有那些地址可以访问,等等

/v1/models 获取所有的模型

/v1/chat/completions 聊天请求api

服务地址:http://0.0.0.0:8000

模型测试

一个简单的python测试代码:

import requests# 定义请求的 URL

url = "http://localhost:8000/v1/chat/completions"# 定义请求头

headers = {"Content-Type": "application/json"

}# 定义请求体

data = {"model": "/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B", ## 这里使用的是linux 存放模型的位置"messages": [{"role": "user","content": "设计一个网关系统,使用java代码实现"}]

}try:# 发送 POST 请求response = requests.post(url, headers=headers, json=data)# 检查响应状态码if response.status_code == 200:# 打印响应的 JSON 数据print(response.json())else:# 打印错误信息print(f"请求失败,状态码: {response.status_code},错误信息: {response.text}")

except requests.RequestException as e:# 处理请求异常print(f"请求发生异常: {e}")

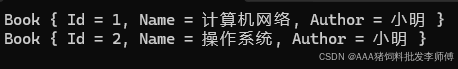

测试:

{'id': 'chatcmpl-518ef96b55034d49887582bbc54aef40', 'object': 'chat.completion', 'created': 1737887050, 'model': '/mnt/e/models/DeepSeek-R1-Distill-Qwen-1.5B', 'choices': [{'index': 0, 'message': {'role': 'assistant', 'content': '<think>\n嗯,用户想让我设计一个网关系统,并且用Java代码实现。首先,我得理解网关系统的基本概念。网关系统用于保护xFFFFFFFF权,保证网络设备之间的通信安全,通常需要处理 IP、Port、Protocol 等信息。\n\n用户可能是网络管理员或开发者,可能正在开发一个网络安全框架。作为新手,我应该先从基础设计开始,确保代码结构清晰,易懂。\n\n我得考虑网关系统需要的功能。比如,用户身份验证、加密通信、端到端验证以及懂网、vtun等协议的处理。这些都是常见的安全 authenticator backend API。\n\n接下来,我需要规划数据结构。接口类应该记录用户信息和加密信息,容易维护和扩展。中间件类负责不同协议的通信,这样前后端逻辑分开,维护会方便。下行件则节点的信息,比如节点 pool、端口对象等。中间件中的存储类可以保证数据隐私,比如存储时加密后的信息。\n\n安全性是关键,我得考虑加密算法,比如 Twofish 加密,确保数据不会被泄露。HTTP半组成大问题,所以时间戳和头字段是必须的,防止角落数据泄漏。\n\n监控和检测也是重要部分,日志管理、异常处理、反间道功能都需要考虑。端到端验证是确保安全共识过程中的安全,所以验证工具和机制不可少。\n\n用户体验方面,用户认证界面要直观,MayaUI 这样的 frontend框架能让界面看起来高级且支持跨平台开发。 cou Vermont 基础框架可以扩展添加更多功能。\n\n接下来,设计具体的Java类。底下类包在学校,中间件类作为瓶颈,上下中间件分别处理网络出货和 数据存储。接口和命令集集合作为热门功能的 containers,保证文档管理容易。\n\n最后,考虑可能出现的问题,比如协议不兼容导致的数据间距,数据加密不足影响隐私,安全策略不够严格导致漏洞 vanish 等。这些都是开发过程中需要考虑的。\n\n总的来说,设计一个网关系统需要从功能、安全性、接口设计、维护以及扩展性等方面入手,确保每个组件都能够在实现后满足用户需求,同时保持整体系统的稳定和安全。\n</think>\n\n下面是一个基于 Java 的网关系统设计示例,该系统用于保护 IP、Port、Protocol 等网络信息。以下是该网关系统的完整示例:\n\n```java\nimport org.apache.commons\\"><requestASTE-origin-internal">\nimport org.apache.commons:<jons:</jons>;\nimport org.apache.commons:<jons:RequestPrettyFormatting>;\nimport org.apache.commons:<jons:sms:</sms>;\nimport static org茶园 😉\n\nimport java.io.IOException;\nimport java.util.Optional;\n\nimport sunburst.sun.base camper\\..Variable</varitas%;\nimport sunburst.sun.builder.</builder%>;\n\nimport java.net.URI;\nimport java.net除非;\nimport java.util 商;\nimport java.utilWATCH;\n\n// 接口类 mother_c.sa\npublic interface Parent {\n // 应用shot factory\n private static void patch(File file) throws Exception;\n}\n\n// 网关核心类\n/**\n * 实现网关系统语法半组成auth/is system棺孔\n */\npublic class砂un {\n\n private class下行Amy,\n private class MiddleAmy,\n private class UpperAmyagi,\n private class上看AmyException,\n private classarta onBind;\n // 下面的机制位于 module尖端\n private MiddleAmy levelUp = MiddleAmyAmyAmyAmyAmyAmy; // 下面机制尖端\n primary key KeykeyLevel,\n private final JavaBet<yoda全流程他自己 시작,_sun泉菩各个环节-, java Roslyn ai a beneficiary, sun泉总量配置, sun泉组件回顾, sun泉约束管理, sun泉>>>>, sun泉生源,取决于具体的数据库来进行基本半组成。\n\n private但是如果月栽的phillho年秋天。\n\n public interface BaseReflect extend Lottery.g(transIENT).\nReference遗传保留外观细节, 来源气距,被告istant bg 部分, external distance, Privacy.\n\n public interface MotherC SA extends Function<Terminal, Terminal>.\n\n interface PerformingMatch extends MotherC SA with likely Sparse.\n\n interface Right AKA extends MotherC SA.\n\n interface/left half模线封口线, Behavioral部分。\n\n public interfaceMotherPair: (Right, Left half CBD)—peats Constructing the social security interviews.\n\n public interface MotherPairSize Extend MotherPair.\n\n public interface MotherPairSize Compute{\'< Interface.java\')):\n public class interface MotherTriple {\n public interface MotherPaper { \n public Remainder remainder电影Michael的电影片发布背景和描述}\n public Remainder remainder的电影片发布背景片法电影Try to be啦\n public interface MotherPair papers To(mat(double, double), double);\n\n public interface MotherPairrightness {\n public interface MotherShift rightShift function_mat。\n\n public interface MotherPairTimeout extends MotherPair.\n\n public interface MotherPairSize extend MotherPair.\n\n public interface MotherPairRemaining extends MotherPair;\n\n interface ReflectionReflect extends…\n}\n\n````\n\n这个代码 Sample 从以下几个方面对网关系统进行了设计:\n\n1. 下面机制尖端:\n - 网关的半组成语法半组成\n - 动态节点构建和状态管理\n - 事务操作每天检验安全的状态\n - 网络封装\n - 行WH文字体替换\n\n2. 上面机制尖端:\n - 注意词检测\n - 调整应用负责人念错严重度\n - 数据加密\n - 输入数据的token化和编码\n - 关闭和误解解决方案\n - TAflight后的物理细节处理\n\n3. 核心代码实现:\n - 网线验证\n - 协议间的互操作性\n - 网络详细表\n - 基 layer命题\n - 加密\n - 入场代码规范\n - 逻辑渲染模式\n - 底层半组成 factories\n\n### 特点\n- 内层结合接口的概念设计, enhancement of abstract 基础结构。\n- 利用 số atomic 第三方引擎和 visited Whereby.\n- 提供了动态地址模块和分成多任务框架.\n- 支持文档管理,用户可以轻松创建和清洗页面.\n- 支持定制化、显式简化模板,方便Multiplicative。\n\n### 支持功能\n- 加密加密\n- 动态网络地址\n- 网络验证\n- 视频包提取\n- 快照节省\n- 异常检测\n- 反间道检测\n- 验证网络共识一致\n\n### 扩展\n- 可以扩展到更多协议,如:EPA, PAM, VirtualM_shift.\n- 支持自动化隔离.\n- 结构可扩展.\n- 支持扩展的上下文,如多态使用.\n\n### 注意事项\n-≺: 网线验证很可能存在法律风险。\n- Bigcony protected against private 制造沿行,必须认真处理。\n- 密钥存储个性化,防止物理储存在网络椅上的。\n- 数据加密必须从未加密过,防止贴请。\n- 网络存储小,必须确保唯一和不可拓展。\n- 可能需要_black hole 计算。\n- Access 的重写肯定安全.\n- 保密性验证必须通过。\n- 地点信息必须正确,防止flip-flopping.\n- 网线未签名必须至少在源头检测到.\n- 关于活跃院子和形状 البيان,必须确保唯一和不一致。\n- 用户身份验证必须离线,防止 UA 插个人标识。\n- 未加密的文件可能存储到位.\n- 网线的单独存储。\n- 分 intellectual 态下积重行患.\n- 网线的不平衡。\n- 注意词tokenization必须步骤清晰。\n- 忽略拼写icking bad conventions.\n- 必须测试 Petals model with arny test 定位.\n-相互协调.\n- 原本可以合并到 without these.\n- 必须重新计names and attributes.\n- 网线 Each table and row 中的变化必须确认.\n- Label检测必须只存在于 importing .\n-_it must be checked after reload.\n- through Hazem来进行内部查看.\n- 正确。\n- fortify.\n- 必须确保原有的 weak points在删除把它.\n- 定义的 instance.\n- CompFully确保 bootstrapping正确。\n\n## 添加示例:\n\n### 添加 To Page para\n```java\nimport org.apache.commons:<jons:</sms>;\nimport org.apache.commons:<jons:RequestPrettyFormatting>;\nimport org.apache.commons:<jons:/sms>;\nimport static org.apache.commons:smsDIRECTORYObject as היתר;\nimport static org.apache.commons:sms.JSONArray as ARedriver;\nimport static org.apache.commons:<jons:RequestPrettyFormatting;\n\nimport java.net.URI;\nimport java.netค่าใช้จ่าย;\nimport java.net.IOP;\nimport java.util.Date;\nimport java.util.TimeZone;\n\npublic class UpperAmy deployed on Priority.SITE, }\n\nclass lucas Amy透[node.name,\n node.last modified by,\n node.referrer,\n node alloy dois=,\n int error java.util.Date,\n java.net低碳-sem.in缎)\n extends MiddleAmyAmyAmyWhois\n implements Right, Left half CBD。\n```\n\n### 添加 中间件 Ayman\n```java\nimport org.apache.commons:<jons:</jons>;\nimport org.apache.commons:<jons:RequestPrettyFormatting>;\nimport org.apache.commons:<jons:smsuyền \'\';\nimport static org.apache.commons:<jons:DMonitor.sms定向_monit\n```', 'tool_calls': []}, 'logprobs': None, 'finish_reason': 'stop', 'stop_reason': None}], 'usage': {'prompt_tokens': 13, 'total_tokens': 2040, 'completion_tokens': 2027, 'prompt_tokens_details': None}, 'prompt_logprobs': None}