📖标题:KaLM-Embedding: Superior Training Data Brings A Stronger Embedding Mode

🌐来源:arXiv, 2501.01028

🌟摘要

🔸随着检索增强生成在大型语言模型中的盛行,嵌入模型变得越来越重要。尽管通用嵌入模型的数量越来越多,但之前的工作往往忽视了训练数据质量的关键作用。

🔸在这项工作中,我们介绍了KaLM嵌入,这是一种通用的多语言嵌入模型,利用了大量更清晰、更多样化和特定领域的训练数据。我们的模型已经过关键技术的训练,这些技术被证明可以提高性能:(1)基于角色的合成数据,从LLM中提取出多样化的示例;(2)排名一致性过滤,以删除信息量较小的样本;(3)半同质任务批采样,以提高训练效率。与传统的BERT类架构不同,我们采用Qwen2-0.5B作为预训练模型,便于自回归语言模型适应一般嵌入任务。

🔸对多种语言的MTEB基准的广泛评估表明,我们的模型优于其他规模相当的模型,为参数<1B的多语言嵌入模型设定了新的标准。详见https://github.com/HITsz-TMG/KaLM-Embedding

🛎️文章简介

🔸研究问题:现有嵌入模型在训练数据质量上存在不足,需要优化训练数据的质量和多样性。

🔸主要贡献:论文通过引入高质量、多样化的训练数据,结合创新的训练策略,开发了一个在多语言任务中表现卓越的嵌入模型,并在0.5B参数规模下达到了最先进的性能。

📝重点思路

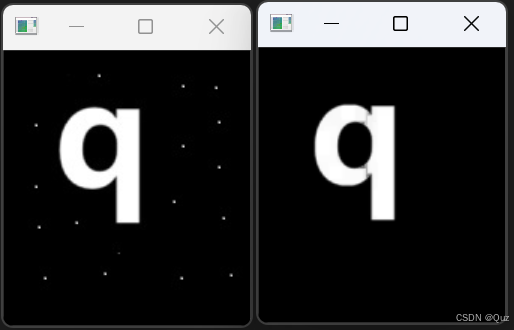

🔸数据收集与处理:使用了超过70个高质量、多样化的数据集进行微调,确保模型的泛化能力。数据来源包括开源数据集、合成数据(基于大语言模型生成)以及经过排名一致性过滤的负样本数据。

🔸训练策略:采用了两阶段训练方法,包括弱监督对比预训练和监督微调。引入了半同质任务批处理(Semi-Homogeneous Task Batching)来平衡负样本的难度和假负样本的风险。

🔸模型架构:基于自回归语言模型Qwen2-0.5B,结合Matryoshka表示学习(MRL)实现灵活的维度嵌入,并通过任务指令微调增强模型的泛化能力。

🔸实验评估:使用大规模文本嵌入基准(MTEB)进行多语言任务评估,并通过消融实验分析了不同训练策略和数据过滤方法的影响。

🔎分析总结

🔸多语言性能:KaLM-Embedding在中文和英文任务中表现优异,同时在法语和波兰语等语言中也展现了良好的性能,尽管波兰语的性能相对较弱,可能是由于训练数据中波兰语比例较低。

🔸数据质量的影响:高质量和多样化的训练数据显著提升了模型的性能。

🔸训练策略的有效性:半同质任务批处理和MRL等训练策略对模型性能有显著提升,尤其是在减少假负样本和增强负样本难度方面。

🔸长文本嵌入:纯长文本嵌入(Dense)效果不如BM25(Sparse),长文本的表示更适合使用多个向量。

💡个人观点

论文的核心在于提高嵌入模型的训练数据质量,并引入了新的训练策略。

🧩附录