Git - Downloading PackageGit - Downloading PackageGit - Downloading Package

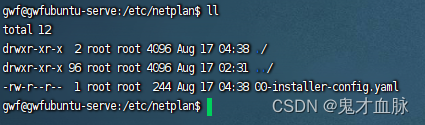

下载git,wget需要下载一下 (GNU Wget 1.21.4 for Windows),

Windows中git bash完全可以替代原生的cmd,但是对于git bash会有一些Linux下广泛使用的命令的缺失,比如wget命令。

在此,以安装wget命令为例,其他命令可以采用相同的方式解决:

1、下载wget二进制安装包,地址:https://eternallybored.org/misc/wget/

2、解压安装包,将wget.exe 拷贝到C:\Program Files\Git\mingw64\bin\ 下面;(或者解压之后将解压文件中wget.exe的路径添加到环境变量中)

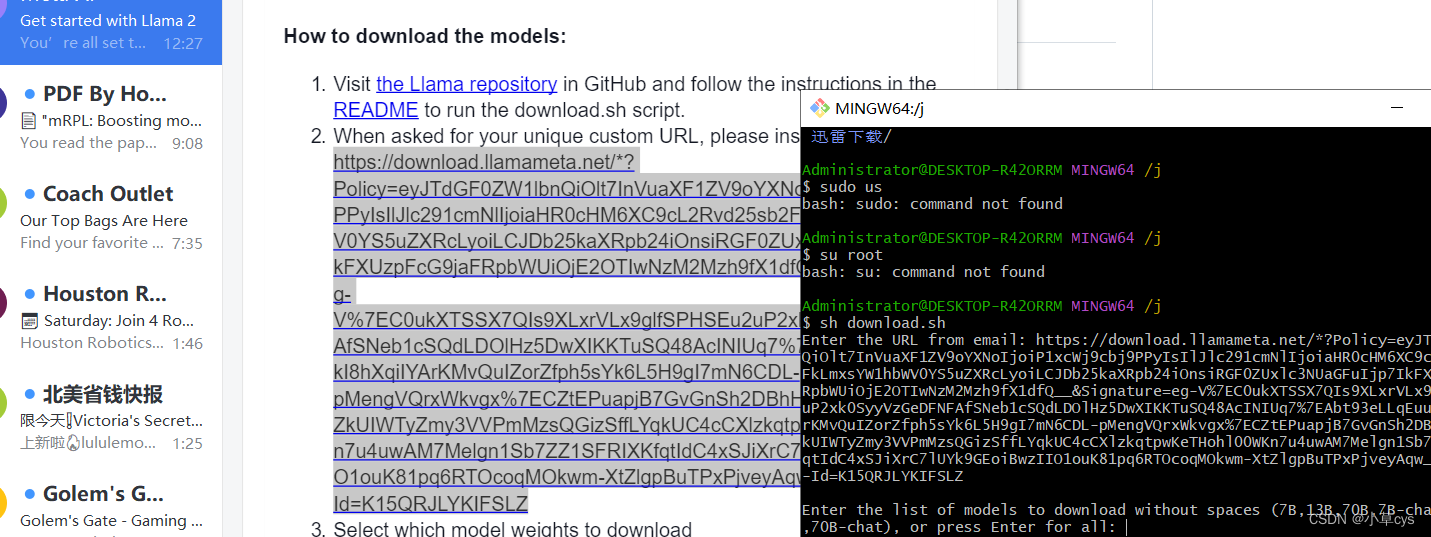

下载GitHub - facebookresearch/llama: Inference code for LLaMA models完之后,运行download.sh.

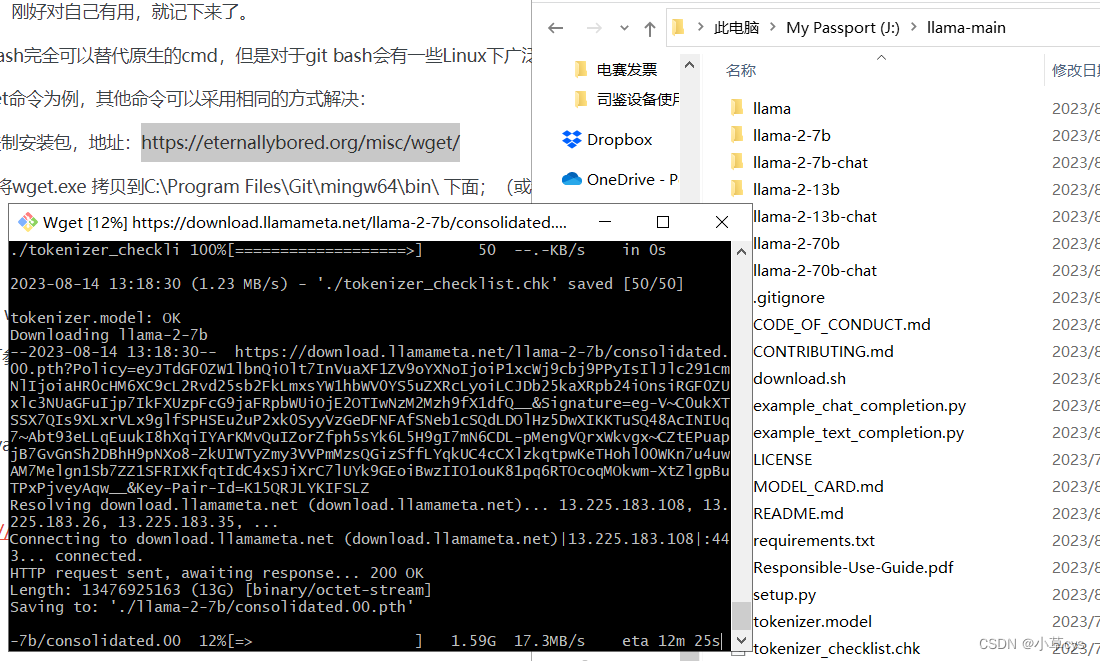

然后download.sh会要求首先输入邮件里的下载地址。输入之后,它会询问要下载哪些模型,我们可以选择下载7b,13b,70b,7b-chat, 13b-chat, 70b-chat这六种模型。如果都想下载,就直接回车就可以了。

其中7b的模型只有一个文件consolidated.00.pth,大小为12.55GB。而13b的模型是2个文件consolidated.00.pth和consolidated.01.pth,每个都是12.12GB. 70b的模型是8个文件,从consolidated.00.pth到consolidated.07.pth,每个文件大小为16.06GB。

| 模型 | 文件数 | 文件大小 |

|---|---|---|

| 7b | 1 | 12.55GB |

| 13b | 2 | 24.24GB |

| 70b | 8 | 128.48GB |

| 7b-chat | 1 | 12.55GB |

| 13b-chat | 2 | 24.24GB |

| 70b-chat | 8 | 128.48GB |

参考:2023年的深度学习入门指南(18) - 将LLaMA2跑起来_Jtag特工的博客-CSDN博客

运行环境

建议使用Python 3.8及以上版本。

主要依赖库如下:

transformers>= 4.28.0sentencepiece>= 0.1.97gradio

获取模型

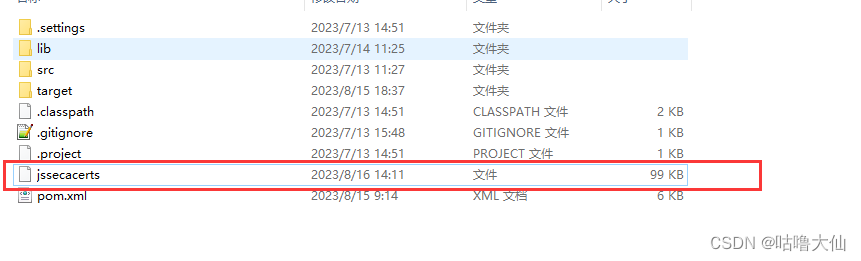

为了符合LLaMA的使用规范,我们发布的Lawyer LLaMA权重需要使用原始LLaMA权重文件进行解码(相关代码来自point-alpaca)。

-

通过官方途径获取LLaMA原始模型。

-

通过Hugging Face或者百度网盘(提取码:lwhx)获取Lawyer LLaMA权重。

-

利用原始LLaMA文件中的

7B/consolidated.00.pth文件,运行以下bash命令,使用decrypt.py对Lawyer LLaMA模型文件进行解码。

for f in "/path/to/model/pytorch_model"*".enc"; \do if [ -f "$f" ]; then \python3 decrypt.py "$f" "/path/to_original_llama/7B/consolidated.00.pth" "/path/to/model"; \fi; \ done

将以上命令中的/path/to/model/替换成下载后的Lawyer LLaMA所在路径。

- 从百度网盘(提取码:r0vx)下载法条检索模块,并运行其中的

python server.py启动法条检索服务,默认挂在9098端口。

模型运行

使用命令行运行

python demo_cmd.py \ --checkpoint /path/to/model \ --classifier_url "http://127.0.0.1:9098/check_hunyin" \ --use_chat_mode

使用交互界面运行

运行以下命令启动交互网页,访问http://127.0.0.1:7863。

python demo_web.py \ --port 7863 \ --checkpoint /path/to/model \ --classifier_url "http://127.0.0.1:9098/check_hunyin"

如需使用nginx反向代理访问此服务,可参考https://github.com/LeetJoe/lawyer-llama/blob/main/demo/nginx_proxy.md (Credit to @LeetJoe)

没部署成功,可能是bash那步不行