模型评估的指标

模型是在大量的数据集上训练而来的,无论一个模型是从零训练的还是基于某一个模型,通过微调方法得到的,靠人工评价模型的效果都是异常困难的。那么要想客观的、自动化的评价一个LLM模型,就需要能够选择正确评估模型效果的指标或者基准测试,来客观和自动化的完成评价,从而正确的反馈模型的效果。

在测试AI系统中的模型训练和评估阶段,需要使用准备好的数据集对AI模型进行训练和评估。在训练过程中,应该对模型进行监控和调整,以确保模型的准确性和效果。在评估过程中,需要使用测试数据集对模型进行测试,以验证模型的准确性和效果。在评估过程中,需要使用各种度量方法来评估模型的准确性和效果,例如精度、召回率、F1分数等等。

精度是指模型正确预测的样本数占总样本数的比例,即:

其中,Precision是指精度,True Positive指分类器正确判断为正例的样本数,False Positive指分类器错误判断为正例的样本数。精度越高,说明模型的分类效果越好。

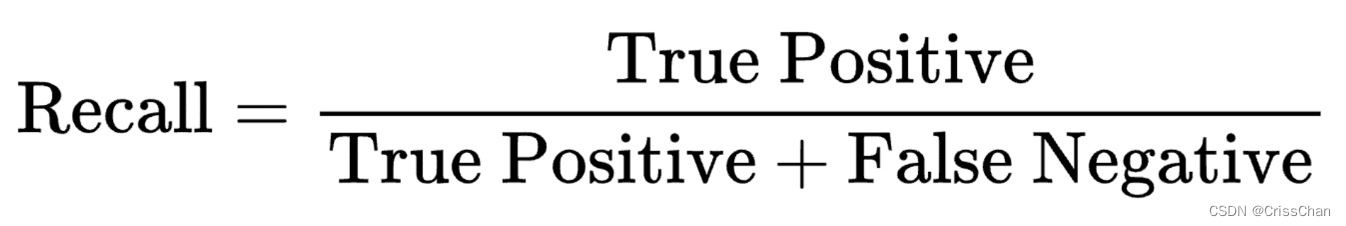

召回率是指模型正确预测的正样本数占所有正样本数的比例,即:

其中,Recall是指召回率,False Negative指分类器错误判断为负例的样本数。召回率越高,说明模型对正样本的覆盖率越高。

F1分数是精度和召回率的调和平均值&