某某美剧剧集下载(从搜索片名开始)

本篇文章主要是为大家提供某些电影网站的较常规的下载电影的分析思路与代码思路(通过爬虫下载电影),我们会从搜索某部影片的关键字开始直到成功下载某一部电影。

地址:aHR0cHM6Ly93d3cuOTltZWlqdXR0LmNvbS9pbmRleC5odG1s

先来分析页面

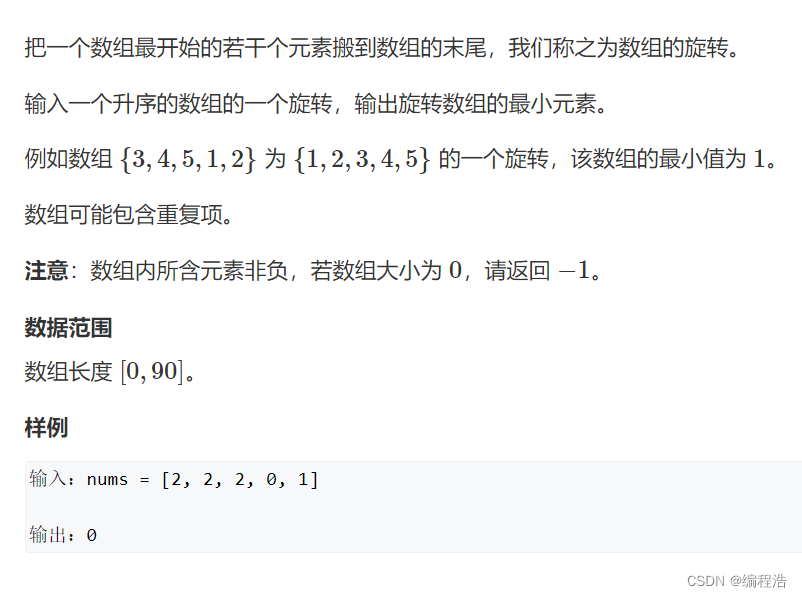

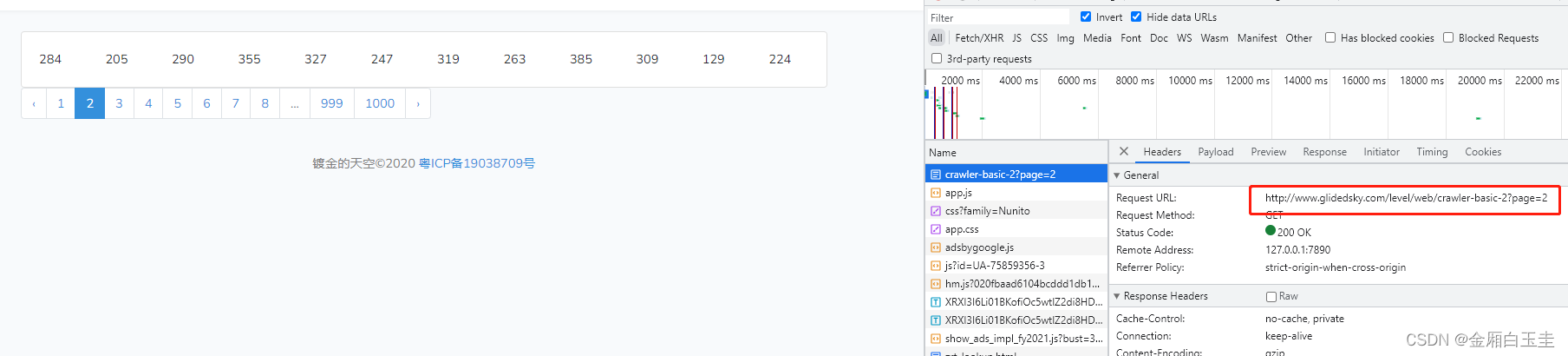

打开开发者工具,然后再搜索框输入任意内容开始搜索影片(如搜索战火)并抓包

从XHR来看的话返回的都是js文件,所以我们可以先考虑document中的html文档是否包含了我们需要的有效数据。

document中只返回了一个包,并且通过预览来看的话我们可以看到通过关键字搜索出来的电影是存在于这个html中的,所以我们就可以直接通过xpath解析将这些电影的片名解析出来,便于后面我们对影片进行选择。然后就可以进入到电影的详情页面(xpath解析出详情页的url)了。例如此处我们选择《兄弟连》这部电影。

进入到详情页之后,我们需要判断这部影片是否已经更新完成,因为下面我们需要选择播放线路,不同的播放线路已更新的剧集可能不同,但是经过对多部影片的详情页分析(此处不再贴图,大家自己去观察)发现,已完结的影片是不会存在上述问题的。但是正在连载中的影片可能就存在这样的问题,所以我们需要判断一下已经连载的剧集与这些播放线路中的剧集集数是否相等,如果相等的话才是可用的线路,否则是不可用的线路。当然也有可能存在一条线路都无法播放的情况,这个就是服务器的问题了,咱们客户端这边是没办法处理的。之后我们就要根据选择的线路去到播放页面就可以准备下载电视剧了。

此处我们选择的是九九云线路,来到播放页面之后通过抓包我们会发现并没有媒体文件,但是存在着m3u8与ts的包,因此我们能够判断出这个站点的视频是被分割成很多分的片段了。

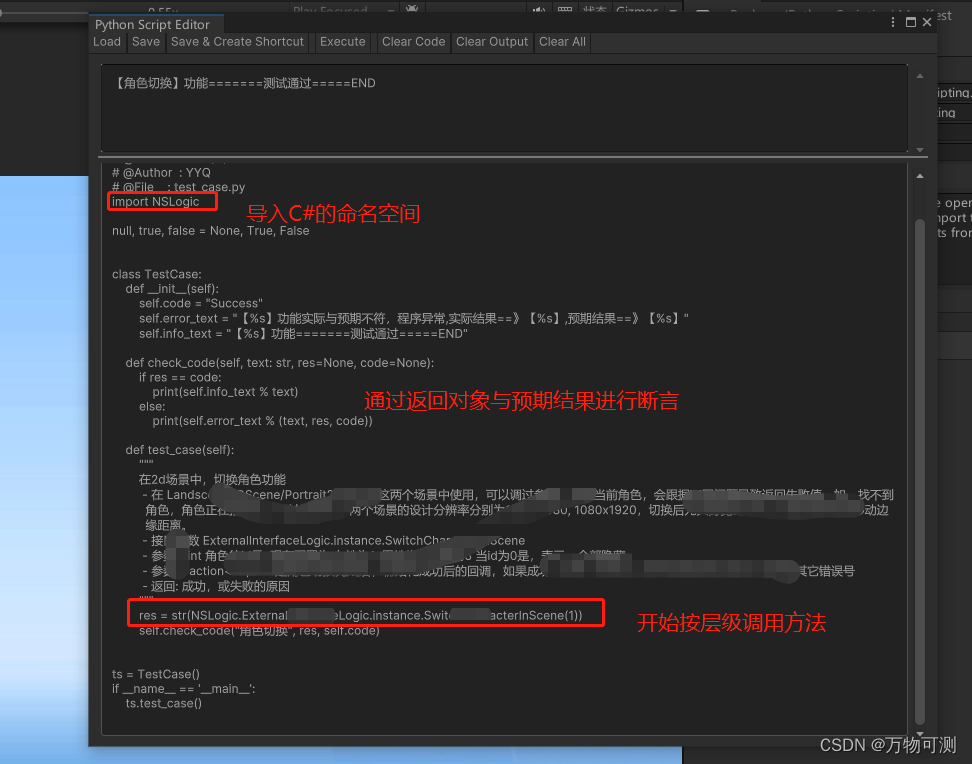

接下来就是要想办法把这些ts视频下载下来了,通常情况下,这些文件的url会存在于一个m3u8的文件之中,所以我们需要先将m3u8下载下来。从播放页面的源码中我们可以解析出m3u8文件的下载地址(为了方便此处我就不再去请求源码了,直接从elements中看,大家平时的时候一定是养成习惯把源码下载到本地进行分析)

然后将next后面的url解析出来再进行请求,就会看到里面存在着一个新的m3u8文件的地址。

接下来就是通过正则将这个文件中存在的这个地址提取出来进行拼接再进行请求就能够获取到所有的ts文件所在的地址了。

下一步就是将这些ts文件的地址提取出来,同样我们选择正则进行提取(或者使用专门处理m3u8的第三方包进行提取),提取出来后拼接成正常的链接,存放到一个列表中,然后再遍历列表依次请求这些url并按照顺序将视频进行保存。

保存之后通过ffmpeg对视频进行合成,关于ffmpeg的配置请大家自行查阅一下相关资料。

合成后的视频

由于时间关系,只下载了200个片段进行合成,有兴趣的朋友可以改写成并发请求的方式下载所有的片段进行合成。完整代码如下:

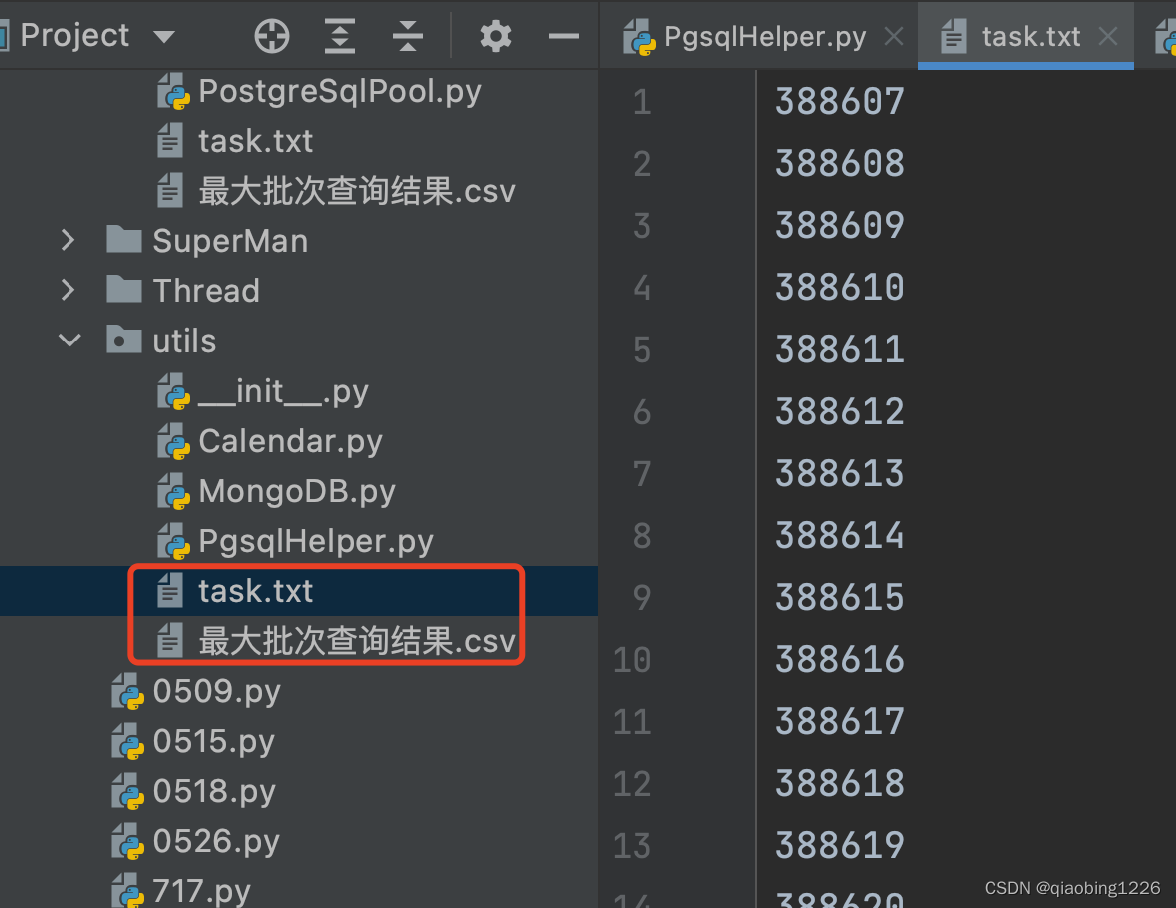

import os.path

import re

import requests

import urllib3

from lxml import etreeclass SendRequest:"""基本请求模板,待完善"""urllib3.disable_warnings()def __init__(self):self.ABS_PATH = os.path.abspath(os.path.dirname(__file__))self.url = ''self.headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36'}self.cookies = {} # cookie设置self.data = {} # 表单数据self.page = 1 # 翻页控制参数self.session = requests.session()# self.movie = '测试'# print(f'{self.ABS_PATH}/{self.movie}(临时文件)/{self.movie}.m3u8')# print(f'{self.ABS_PATH}/{self.movie}/{self.movie}.mp4')@propertydef UGetRequest(self):response = self.session.get(url=self.url, headers=self.headers, cookies=self.cookies, verify=False)return response@UGetRequest.setterdef UGetRequest(self, kwargs: dict):if kwargs.get('url'):self.url = kwargs.get('url')if kwargs.get('referer'):self.headers['referer'] = kwargs.get('referer')@propertydef UPostRequest(self):response = self.session.post(url=self.url, headers=self.headers, cookies=self.cookies, data=self.data,verify=False)return response@UPostRequest.setterdef UPostRequest(self, kwargs: dict):if kwargs.get('url'):self.url = kwargs.get('url')if kwargs.get('referer'):self.headers['referer'] = kwargs.get('referer')class MeiJu99(SendRequest):def __init__(self):super().__init__()def synthesis(self):"""合成视频"""if not os.path.exists(self.movie):os.mkdir(self.movie)cmd = f'ffmpeg.exe -f concat -safe 0 -i {self.ABS_PATH}\\{self.movie}(临时文件)\\{self.movie}.m3u8 -c copy {self.ABS_PATH}\\{self.movie}\\{self.movie}.mp4'os.system(cmd)def download_mvs(self, total_mv_urls):"""下载所有片段"""if not os.path.exists(self.movie+'(临时文件)'):os.mkdir(self.movie+'(临时文件)')num = 1# 按照ffmpeg的格式将ts文件的路径写入到一个m3u8文件之中用于合成视频new_m3u8_file = open(self.movie+'(临时文件)'+'/'+self.movie+'.m3u8', 'a', encoding='utf-8')for url in total_mv_urls:self.UGetRequest = {'url': url}res = self.UGetRequestwith open(self.movie+'(临时文件)'+'/'+str(num)+'.ts', 'wb')as f:f.write(res.content)new_m3u8_file.write("file '%s\%s\%d.ts'" % (self.ABS_PATH, self.movie+'(临时文件)', num))new_m3u8_file.write('\n')print(str(num) + '下载成功')num+=1if num == 201:breaknew_m3u8_file.close()self.synthesis()def play_page(self, play_pages_url):"""播放页面提取下载链接"""self.UGetRequest = {'url': play_pages_url}response = self.UGetRequesttext_html = response.content.decode()with open('playpage.html', 'w', encoding='utf-8')as f:f.write(text_html)m3u8_url = re.findall('var next="(.*?)";var prePage=', text_html)[0] # 提取播放页面中的m3u8文件的地址self.UGetRequest = {'url': m3u8_url}m3u8_file = self.UGetRequest.contentwith open('1.m3u8', 'wb')as f:f.write(m3u8_file)# 请求上方获取到的m3u8_url以获取存放了ts地址的m3u8last_m3u8_url = m3u8_url.split('/2')[0] + re.search('/\d+/\w+/[\d+kb/]*\w+/index\.m3u8', m3u8_file.decode()).group()self.UGetRequest = {'url': last_m3u8_url}response = self.UGetRequest.content.decode()# 解析并保存所有的ts地址total_mv_urls = [m3u8_url.split('/2')[0]+i for i in re.findall('/\d+/\w+/\d+\w+/hls/\w+\.ts', response)]self.download_mvs(total_mv_urls)def index(self, index_url):"""电影详情页面"""self.UGetRequest = {'url': index_url}response = self.UGetRequesttext_html = response.content.decode()with open('index.html', 'w', encoding='utf-8')as f:f.write(text_html)tree = etree.HTML(text_html)using_lines = tree.xpath('//*[@id="playTab"]/div[1]/ul//li//text()') # 可使用线路(名称)play_tab = tree.xpath('//*[@id="playTab"]/div') # 下载线路mv_information = ''.join(tree.xpath('//*[@id="zanpian-score"]/ul//text()')) # 电影信息status = ''.join(tree.xpath('//*[@id="zanpian-score"]/ul/li[2]//text()'))if '完结' not in status:numbers_sets = ''.join(re.findall('集数:共(.*?)集 每集\d+分钟|状态:更新至(.*?)集', mv_information)[0])for i, tab in zip(range(len(using_lines)), play_tab[1:]):tab_num = len(tab.xpath('./ul/li'))if tab_num == int(numbers_sets):print('%d.' % (i+1), using_lines[i]+'(可用)', end='\t')else:print('%d.' % (i+1), using_lines[i]+'(不可用)', end='\t')else:for i, tab in zip(range(len(using_lines)), play_tab[1:]):print('%d.' % (i + 1), using_lines[i], end='\t')print()download_num = int(input('请选择下载线路(输入编号):'))play_pages_urls = ['https://www.99meijutt.com'+i for i in play_tab[download_num].xpath('./ul//li/a/@href')]for play_pages_url in play_pages_urls:self.play_page(play_pages_url)breakdef search(self):"""搜索页面采集"""titles = []self.UPostRequest = {'url': 'https://www.99meijutt.com/search.php'}self.data['searchword'] = input('请输入影片关键字或主演名:')response = self.UPostRequesttext_html = response.content.decode()with open('search.html', 'w', encoding='utf-8') as f:f.write(text_html)tree = etree.HTML(text_html)div_lst = tree.xpath('//*[@id="content"]/div')print('搜索到的电影如下:')for i, div in zip(range(1, len(div_lst)), div_lst): # 遍历数组与div列表为标题设置编号title = div.xpath('./div[1]/a/@title')[0]if i % 2 != 0 and i != len(div_lst)-1:print(str(i) + '.' + title, end='\t\t')else:print(str(i) + '.' + title)titles.append(title)num = int(input('请输入您要下载的电影序号:'))self.movie = titles[num-1]index_url = 'https://www.99meijutt.com' + div_lst[num-1].xpath('./div[1]/a/@href')[0]self.index(index_url)if __name__ == '__main__':mj = MeiJu99()mj.search()