一、发展

1989年,Yann LeCun提出了一种用反向传导进行更新的卷积神经网络,称为LeNet。

1998年,Yann LeCun提出了一种用反向传导进行更新的卷积神经网络,称为LeNet-5

AlexNet是2012年ISLVRC 2012(ImageNet Large Scale Visual Recognition Challenge)竞赛的冠军网络,分类准确率由传统的 70%+提升到 80%+。 它是由Hinton和他的学生Alex Krizhevsky设计的。也是在那年之后,深度学习开始迅速发展。

VGG在2014年由牛津大学著名研究组VGG (Visual Geometry Group) 提出,斩获该年ImageNet竞 赛中 Localization Task (定位 任务) 第一名 和 Classification Task (分类任务) 第二名。[1.38亿个参数]

GoogLeNet在2014年由Google团队提出,斩获当年ImageNet竞赛中Classification Task (分类任务) 第一名。[论文:Going deeper with convolutions][600多万参数]

ResNet在2015年由微软实验室提出,斩获当年ImageNet竞赛中 分类任务第一名,目标检测第一名。获得COCO数据集中目标 检测第一名,图像分割第一名。[论文:Deep Residual Learning for Image Recognition]

二、ResNet

2.1 网络特点

- 超深的网络结构(突破1000层)

- 提出residual模块

- 使用Batch Normalization加速训练(丢弃dropout)

正常网络,网络越深,错误率越高;而ResNet是网络越深,错误率越低

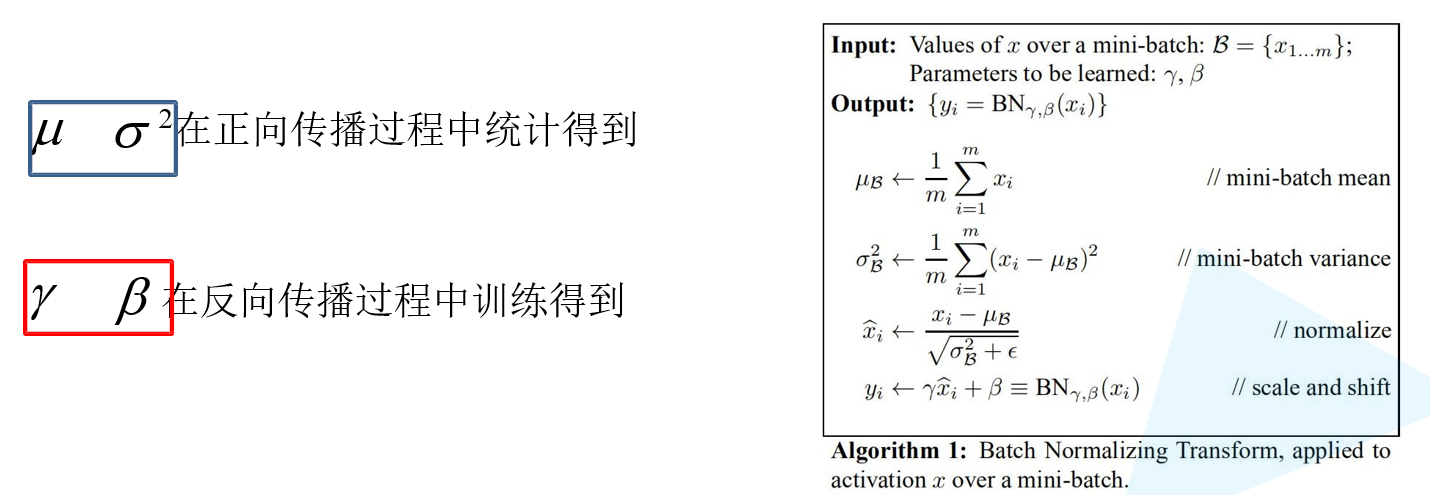

梯度消失或梯度爆炸问题:BN解决

退化问题:残差解决

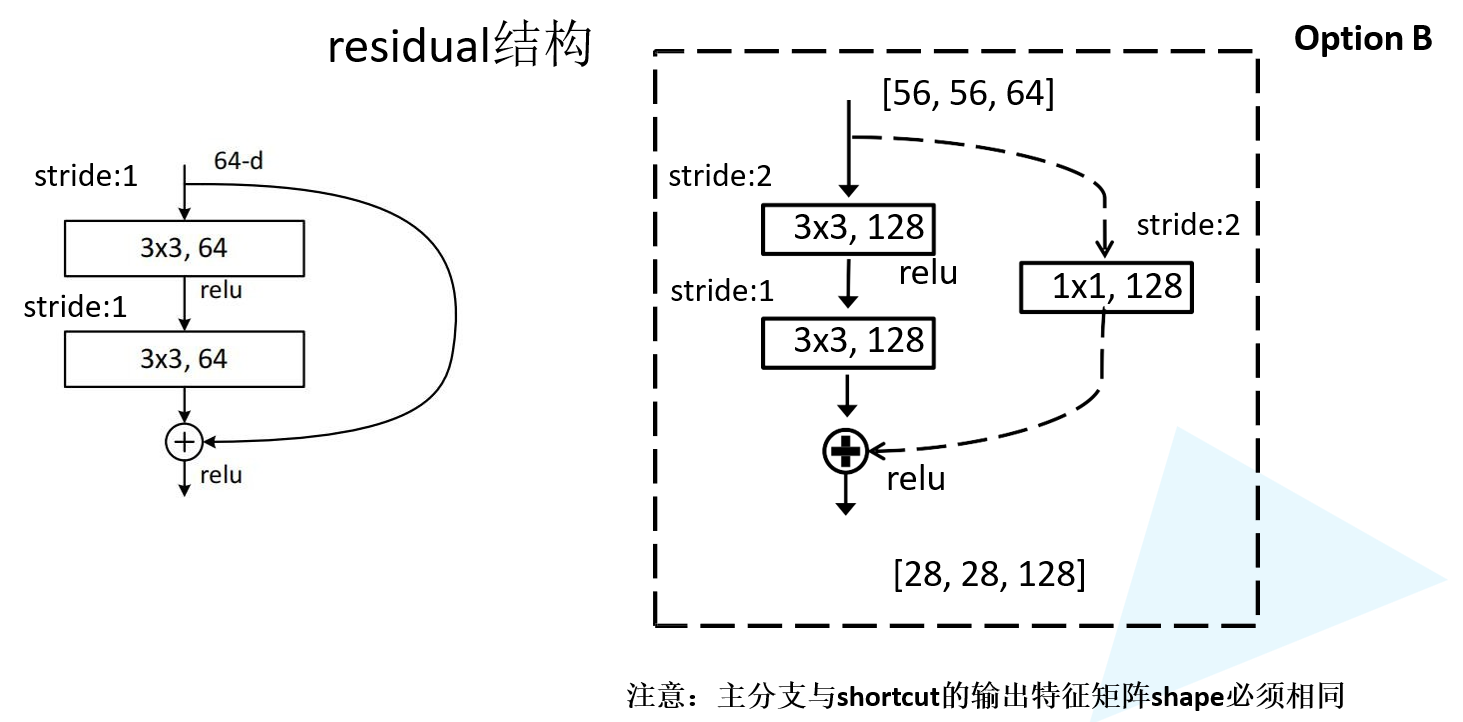

F(x)是卷积对x的结果,最终结果是x+F(x)

如果网络效果变好:x+F(x)

如果加上网络不好:x+ 0

2.2 残差

左边是基础的残差结构

右边是改进的结构,减少参数

实线与虚线

实线是,图片输入与输出维度不变

虚线是,图片整体长宽的下降

2.3 BN

Batch Normalization的目的是使我们的一批(Batch) feature map满足均值为0,方差为1的分布规律[参考]。