文章目录

- 大模型现状

- baseline底座选择

- 数据构造

- 迁移方法

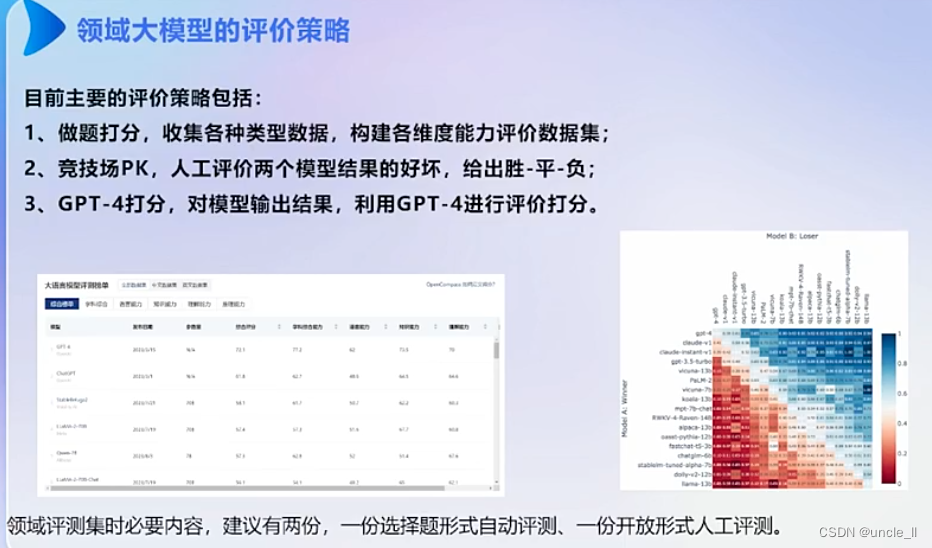

- 评价

- 思考

- 领域大模型训练技巧

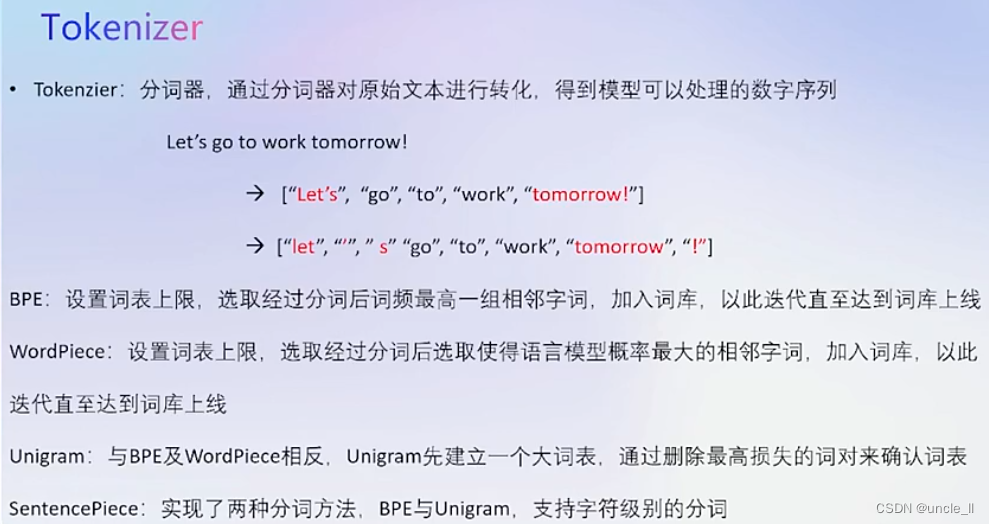

- Tokenizer

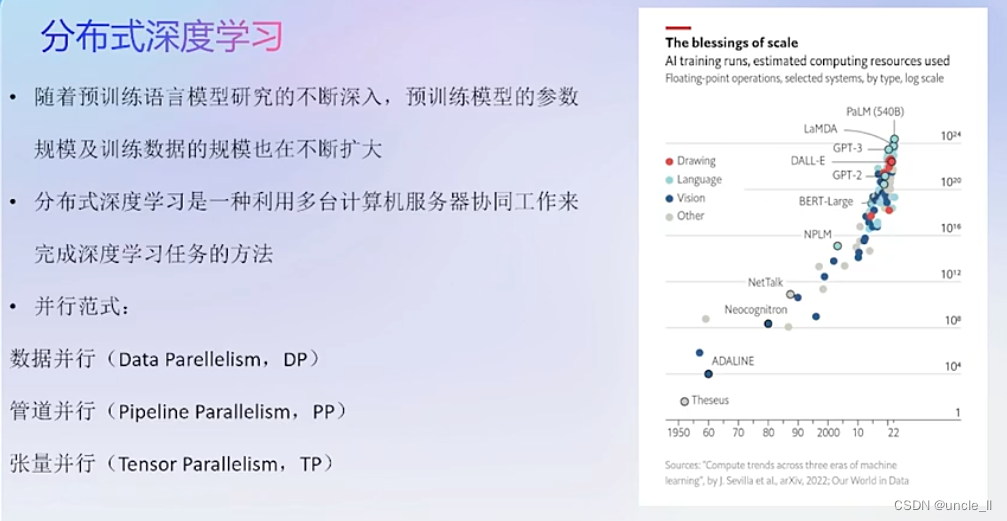

- 分布式深度学习

- 数据并行

- 管道并行

- 向量并行

- 分布式框架——Megatron-LM

- 分布式深度学习框架——Colossal-AI

- 分布式深度学习框架——DeepSpeed

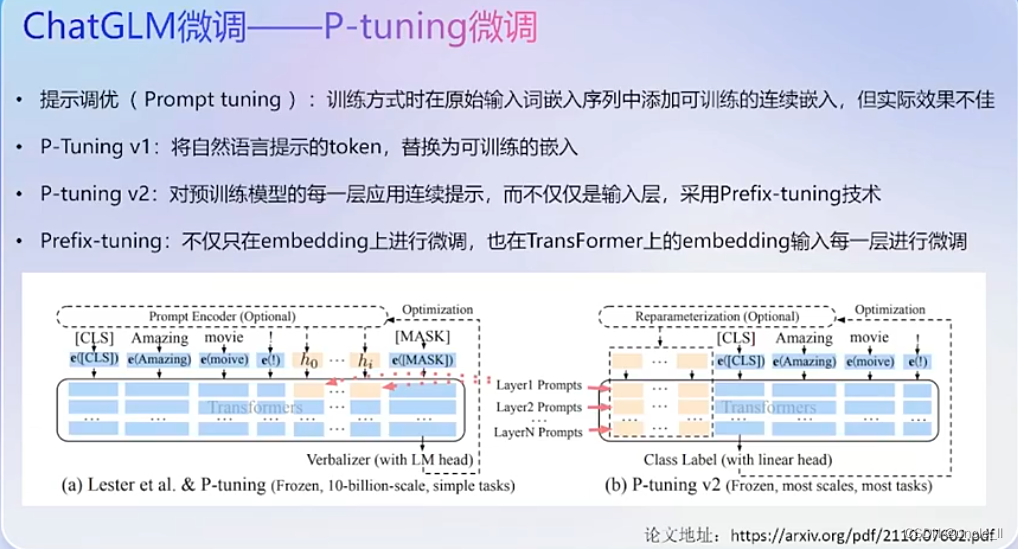

- P-tuning 微调

- 资源消耗

- 模型推理加速

- 模型推理加速方法——FastLLM

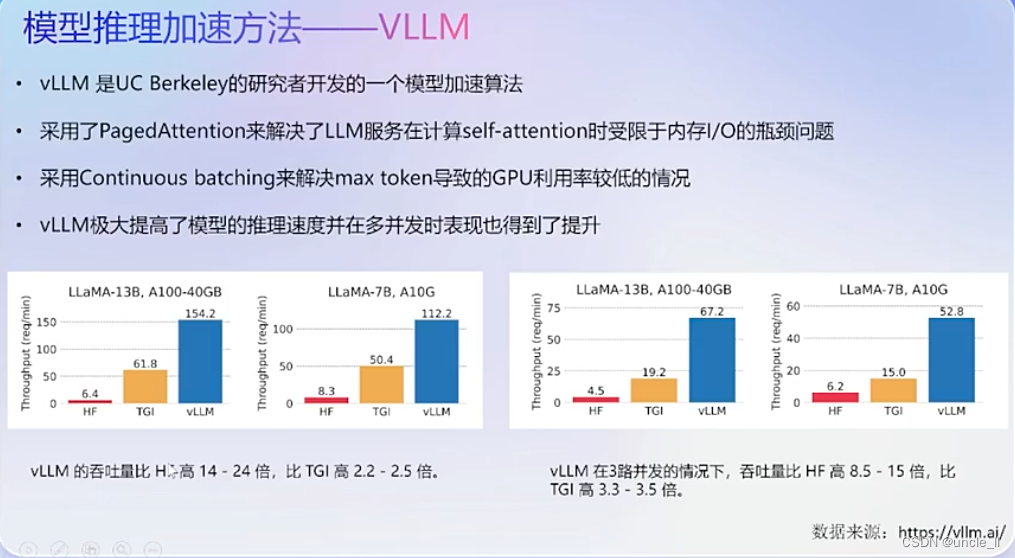

- 模型推理加速方法——VLLm

- 领域大模型产品形态及落地场景

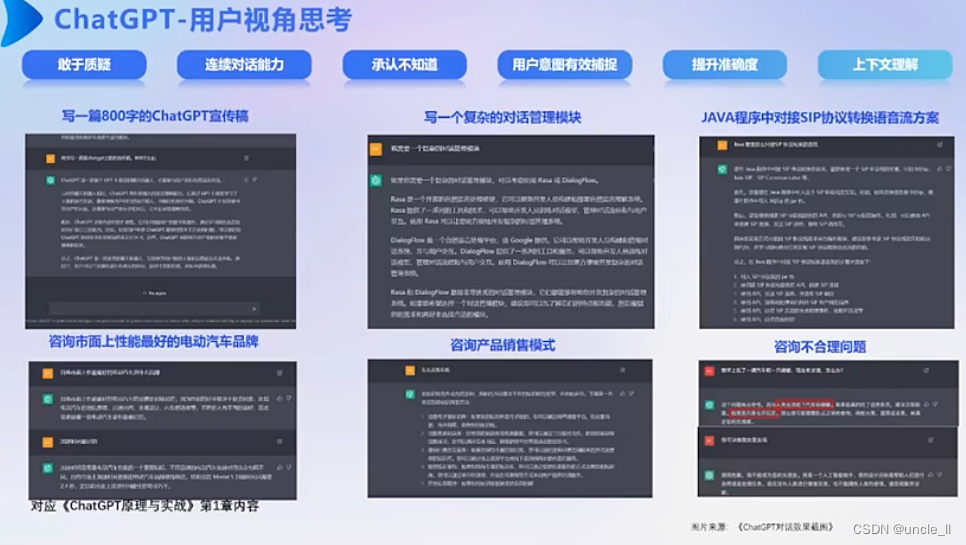

- ChatGPT用户视角思考

- ChatGPT企业视角思考

- 企业级ChatGPT的建设要素

- 选择优质的应用场景

- ChatGPT场景设计-工业制造

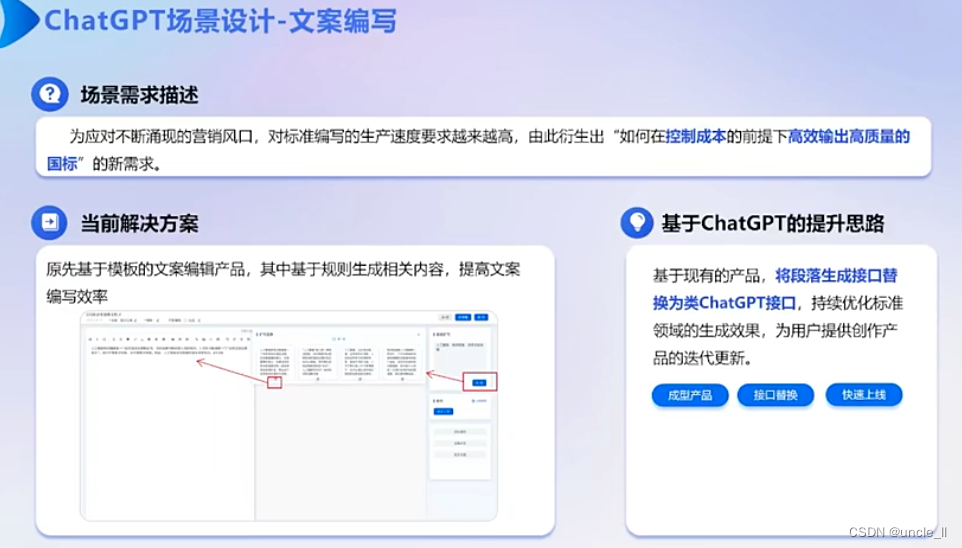

- ChatGPT场景设计-文案编写

大模型现状

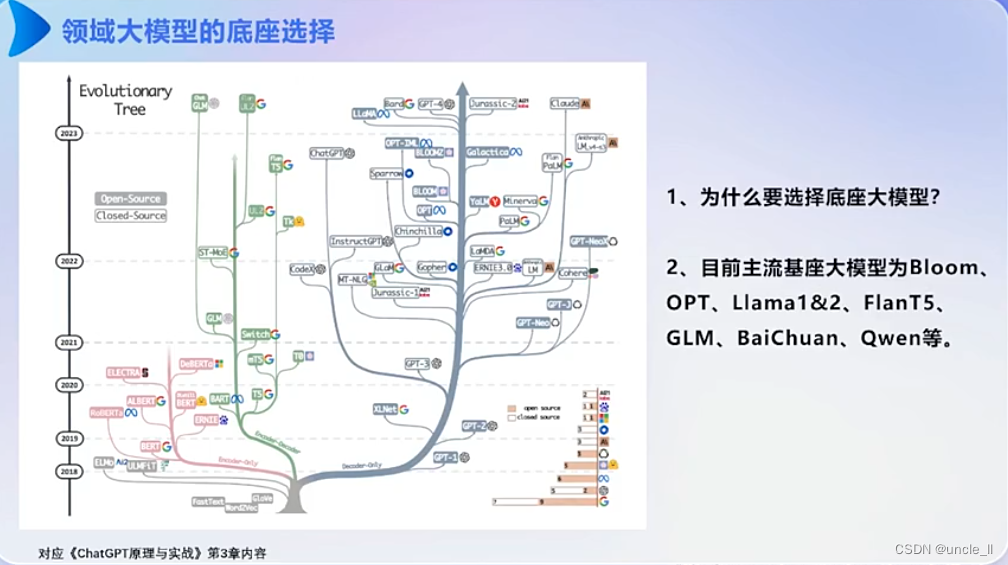

baseline底座选择

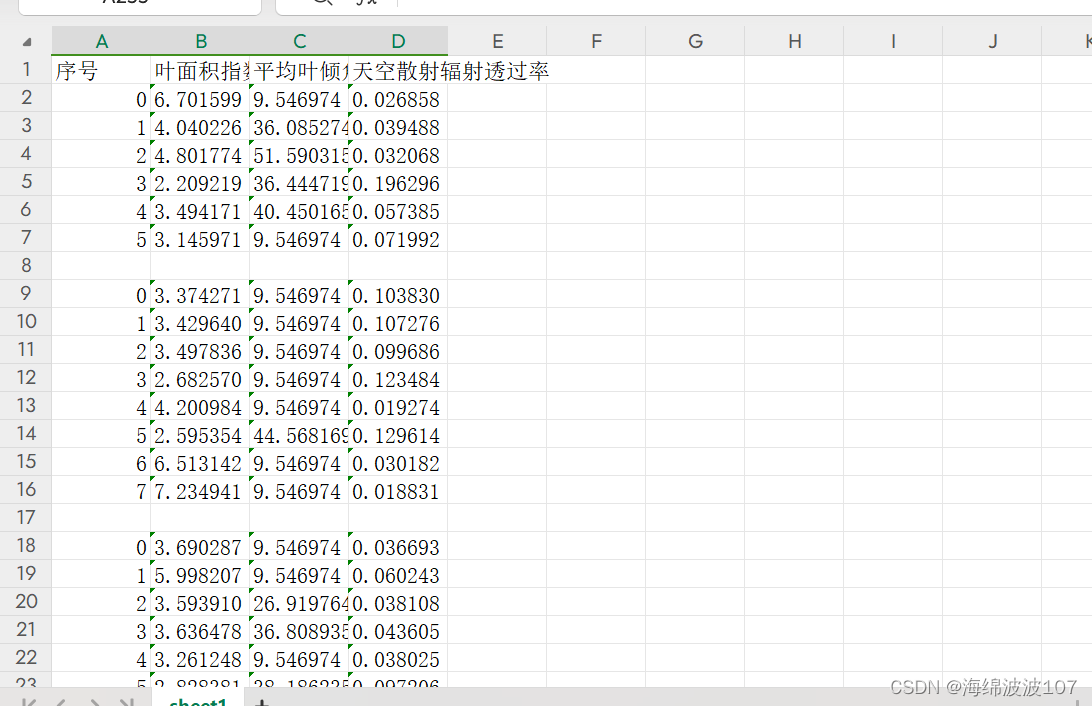

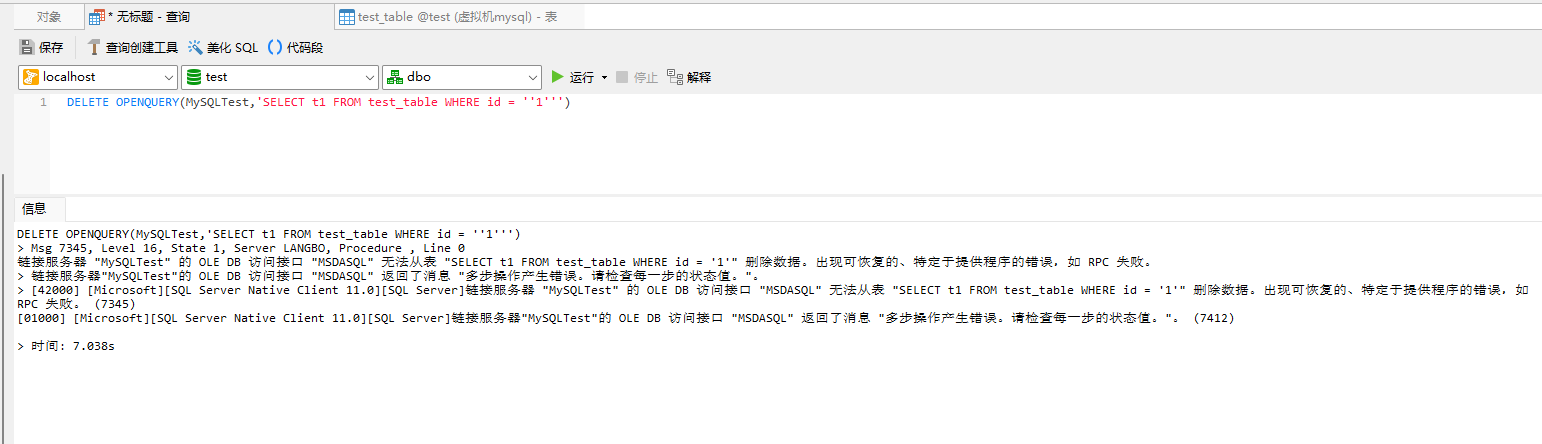

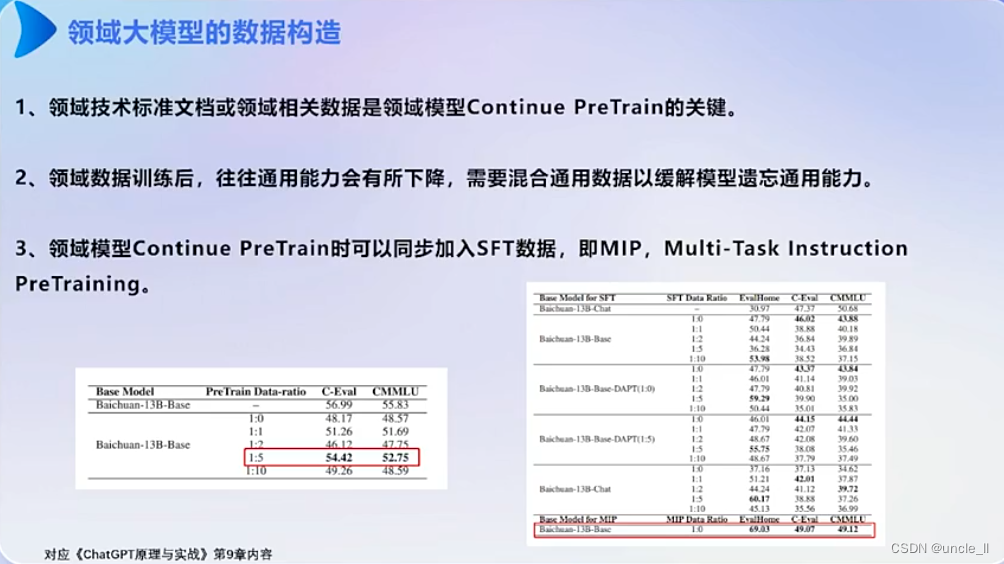

数据构造

- 领域数据

- 书籍数据

- 网站数据

- 新闻内容

- 指令微调数据

混合数据(公用数据+领域数据,比例1:5 )避免知识遗忘,导致通用能力下降。

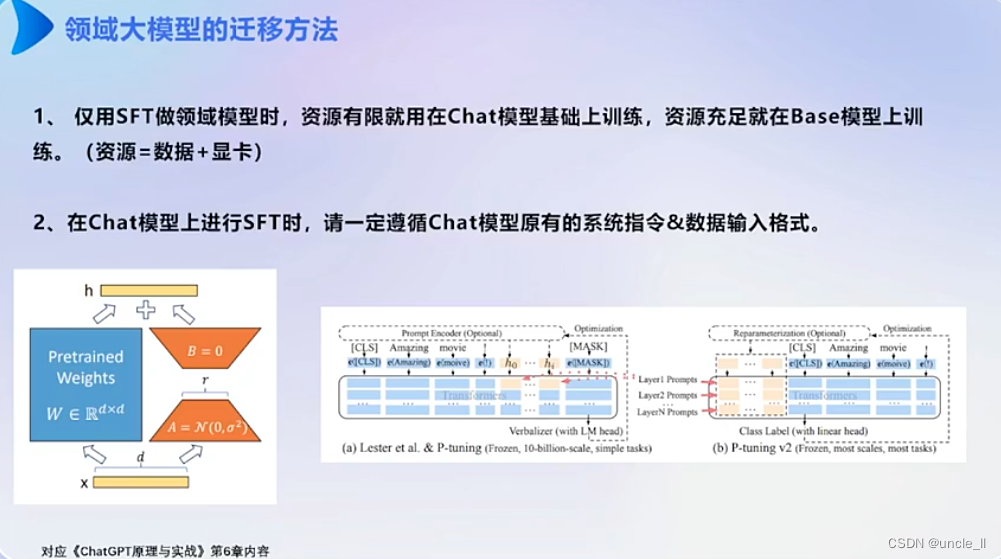

迁移方法

- 资源不充足的时候,在chat模型基础上训练

- 资源充足的时候,在Base模型上训练

千万级别的数据,在chat模型上不要用全量数据进行训练。

评价

思考

领域大模型训练技巧

- ChatGPTBook:github.com/liucongg/ChatGPTBook

Tokenizer

分布式深度学习

数据并行

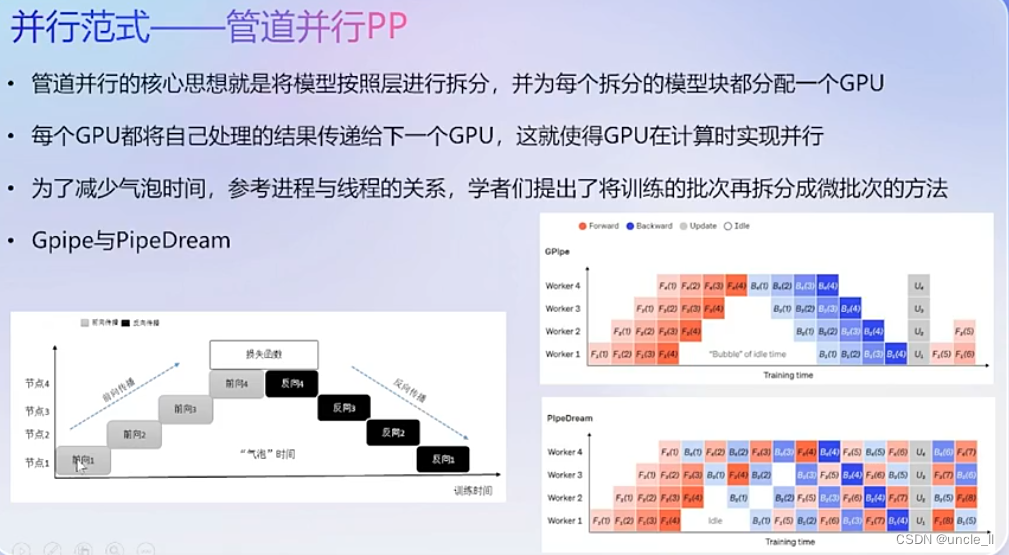

管道并行

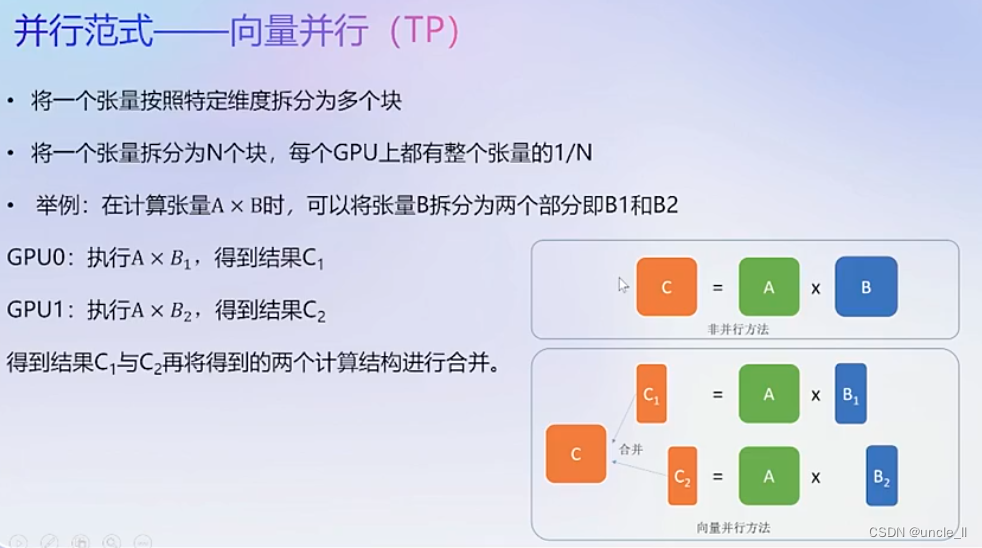

向量并行

分布式框架——Megatron-LM

分布式深度学习框架——Colossal-AI

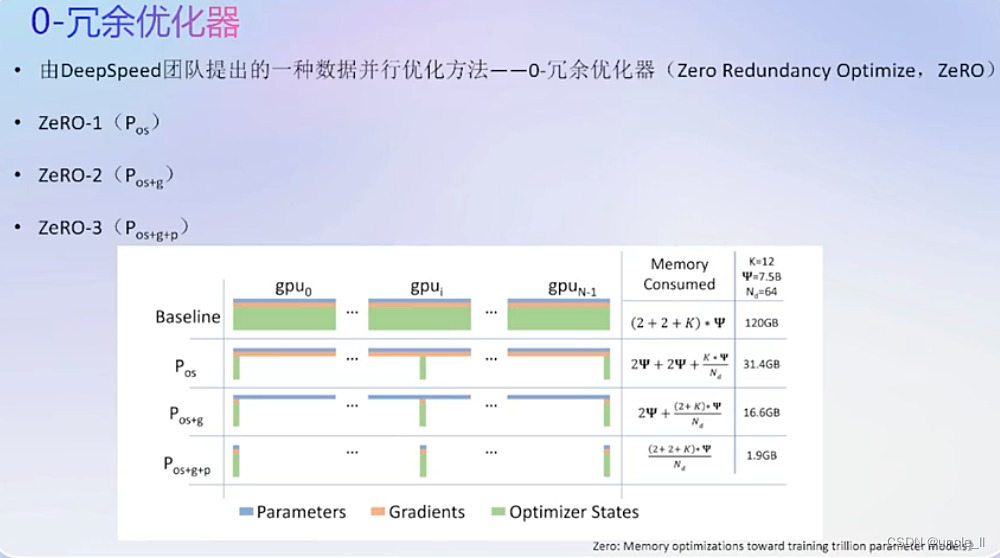

分布式深度学习框架——DeepSpeed

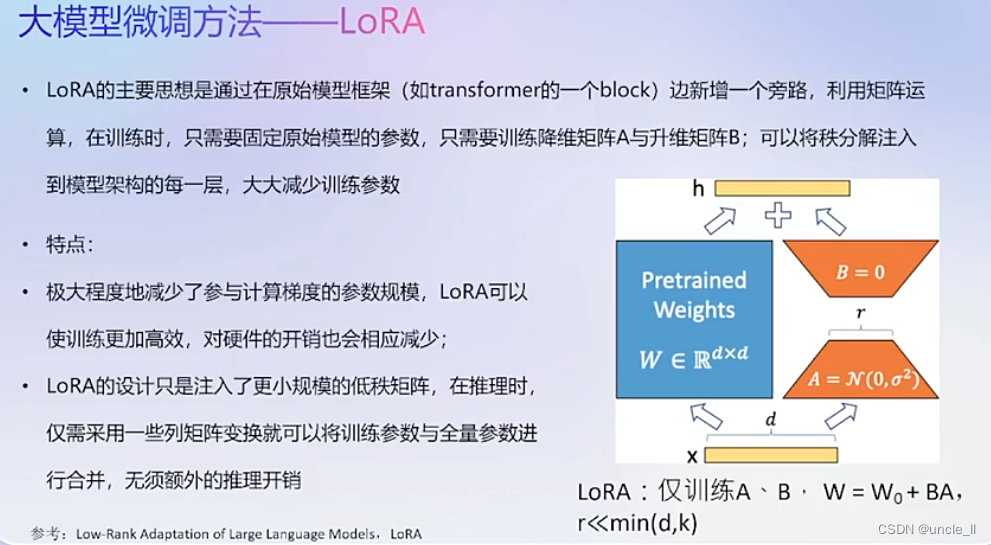

P-tuning 微调

资源消耗

模型推理加速

模型推理加速方法——FastLLM

模型推理加速方法——VLLm

领域大模型产品形态及落地场景

ChatGPT用户视角思考

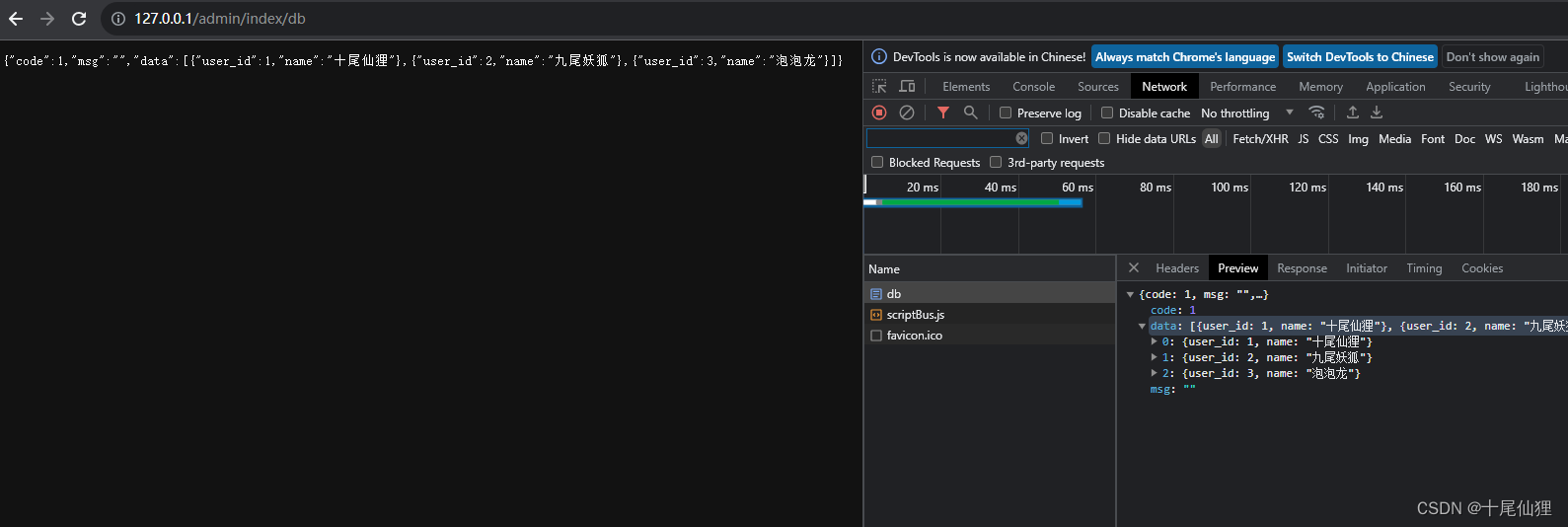

ChatGPT企业视角思考

企业级ChatGPT的建设要素

选择优质的应用场景

ChatGPT场景设计-工业制造

ChatGPT场景设计-文案编写