DeepSeek软件底层原理剖析

一、核心架构基石

(一)混合专家架构(MoE) 架构本质:MoE架构模拟人类专家协作模式,构建一个专家集合。每个专家模块专门负责特定类型或领域知识的处理 。 任务分配机制:当模型面临输入任务时,类似智能调度系统的“路由器”会分析任务特征,将其导向最适配的专家模块。如处理医学文本时,将任务分配给擅长医学知识处理的专家,避免通用模块处理的低效性,极大提升计算效率与任务处理的针对性。

(二)Transformer架构 序列处理基础:Transformer架构以处理序列数据为核心能力,广泛应用于自然语言处理、音频处理等领域。其摒弃传统循环神经网络的顺序处理方式,能并行计算,大大提高处理效率。 注意力机制核心:注意力机制是Transformer的灵魂。在处理序列信息时,模型为序列中每个元素赋予权重,动态聚焦关键信息。例如机器翻译中,可捕捉源语言与目标语言词汇间复杂对应关系,准确翻译。

二、关键技术亮点

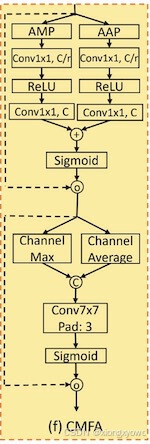

(一)多头潜在注意力(MLA)机制 传统突破:MLA是对传统注意力机制的深度优化。传统注意力在处理长序列时,易出现信息稀释与权重分配不合理问题。MLA通过引入多个“头”,每个头关注序列不同方面,提升对长文本的理解与处理能力。 应用效果