import pygame

import random

# 代码解释及使用说明:

# 首先,导入 pygame 和 random 库。pygame 用于创建游戏窗口和图形绘制,random 用于生成随机数。

# 初始化 pygame,并设置屏幕尺寸为 800x600 像素,设置窗口标题为 "Fireworks"。

# 定义了几种颜色常量,用于粒子的颜色。

# 定义 Particle 类:

# __init__ 方法:初始化粒子的位置、颜色、半径、水平和垂直速度及重力。

# update 方法:更新粒子的位置和速度,同时考虑重力影响,半径会逐渐减小,当半径小于 0 时将其置为 0。

# draw 方法:在屏幕上绘制粒子,使用 pygame.draw.circle 函数,根据粒子的位置和半径绘制圆形。

# main 函数:

# 初始化时钟,用于控制帧率。

# 创建存储粒子的列表 particles。

# 主循环中,填充屏幕为黑色。

# 处理事件,当用户点击鼠标时,在鼠标位置创建 100 个粒子添加到 particles 列表。

# 对 particles 列表中的每个粒子调用 update 和 draw 方法。

# 过滤掉半径小于等于 0 的粒子,防止无效粒子的绘制。

# 调用 pygame.display.flip() 更新屏幕显示,使用 clock.tick(60) 控制帧率为 60 帧每秒。

# 这个程序通过点击鼠标创建烟花效果,每次点击会在鼠标位置生成 100 个粒子,粒子会向上喷射并在重力作用下下落,同时半径逐渐减小,模拟烟花绽放和消散的过程。

# 初始化 pygame

pygame.init()# 屏幕尺寸

screen_width = 800

screen_height = 600

screen = pygame.display.set_mode((screen_width, screen_height))

pygame.display.set_caption("Fireworks")# 颜色

WHITE = (255, 255, 255)

BLACK = (0, 0, 0)

RED = (255, 0, 0)

YELLOW = (255, 255, 0)

ORANGE = (255, 165, 0)

CYAN = (0, 255, 255)

MAGENTA = (255, 0, 255)

GREEN = (0, 255, 0)

colors = [RED, YELLOW, ORANGE, CYAN, MAGENTA, GREEN]class Particle:

def __init__(self, x, y):

self.x = x

self.y = y

self.color = random.choice(colors)

self.radius = random.randint(1, 3)

self.x_vel = random.uniform(-1, 1)

self.y_vel = random.uniform(-5, -1)

self.gravity = 0.1def update(self):

self.x += self.x_vel

self.y += self.y_vel

self.y_vel += self.gravity

self.radius -= 0.05

if self.radius < 0:

self.radius = 0def draw(self):

pygame.draw.circle(screen, self.color, (int(self.x), int(self.y)), int(self.radius))def main():

clock = pygame.time.Clock()

particles = []

running = True

while running:

screen.fill(BLACK)

for event in pygame.event.get():

if event.type == pygame.QUIT:

running = False

if event.type == pygame.MOUSEBUTTONDOWN:

x, y = pygame.mouse.get_pos()

for _ in range(100):

particle = Particle(x, y)

particles.append(particle)for particle in particles:

particle.update()

particle.draw()

particles = [particle for particle in particles if particle.radius > 0]pygame.display.flip()

clock.tick(60)if __name__ == "__main__":

main()

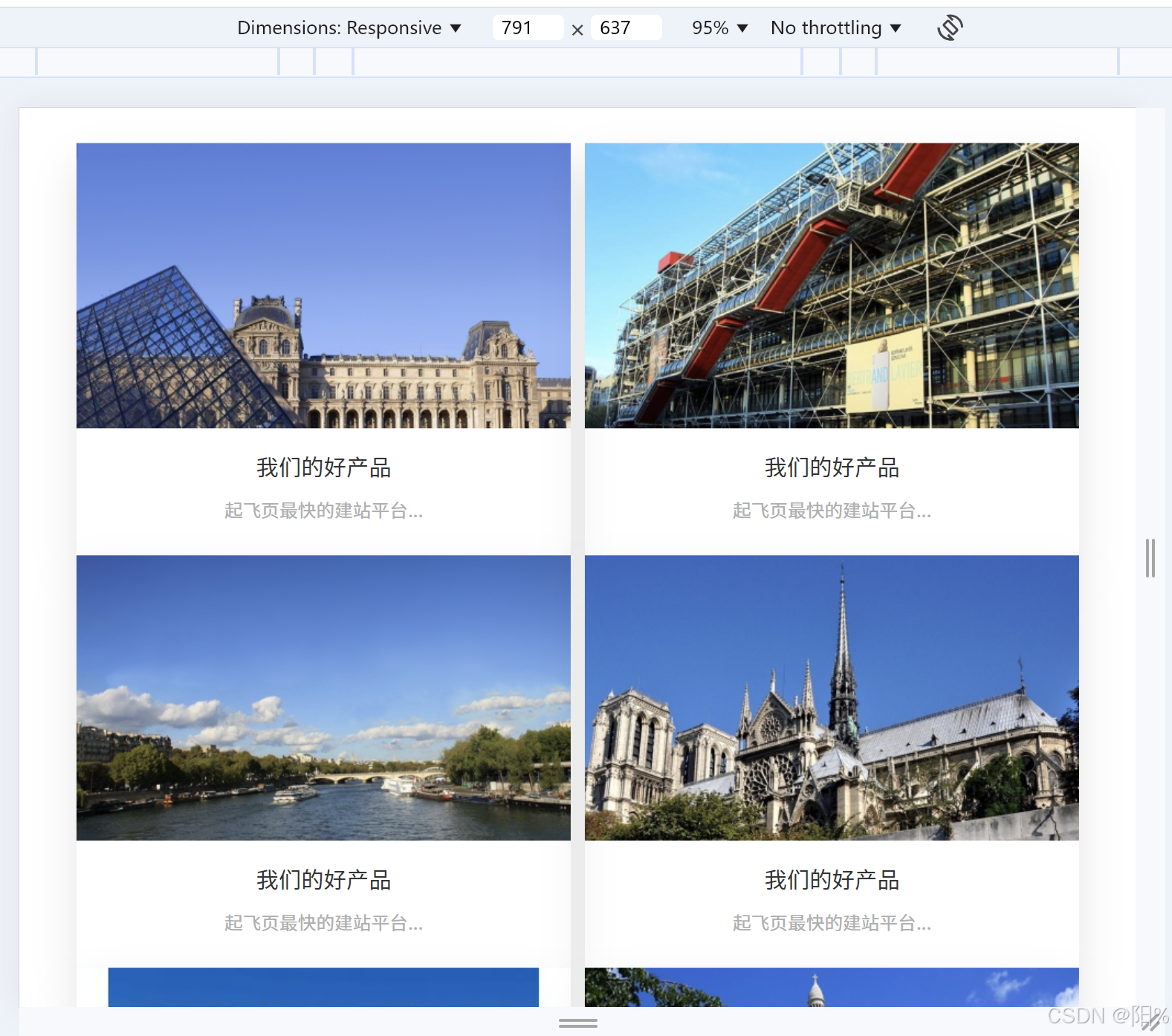

pygame.quit()运行后视图