作为一名开发人员,特别是后端开发人员,随着网络数据量的持续增长,拥有强大的大数据处理能力已经成为每个公司或产品(尤其是2C业务)的必备条件。以下是我在网络上搜集和自身研究的基础上,为您推荐的技术栈和相关书籍。您可以根据自身需求,选择特定的书籍进行学习。

一、Hadoop集群

Hadoop是一个开源的分布式计算框架,用于存储和处理大规模数据集。它提供了可靠性、可扩展性和容错性,使得处理大数据变得更加高效和可行。Hadoop集群由多台计算机节点组成,每个节点都可以运行Hadoop的各个组件。以下是Hadoop集群的主要组件:

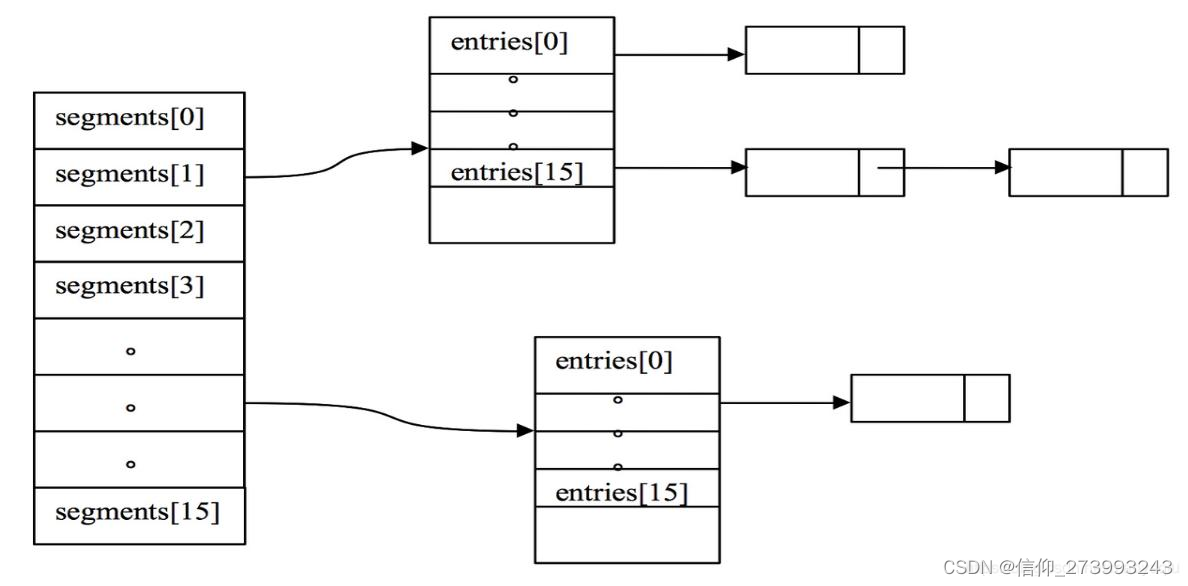

Hadoop分布式文件系统(HDFS):HDFS是Hadoop的存储层,用于可靠地存储大规模数据集。它将数据分割成多个块,并将这些块分布式地存储在集群中的多个节点上。

MapReduce:MapReduce是Hadoop的计算框架,用于并行处理和分析存储在HDFS上的数据。它将计算任务分解成多个Map和Reduce阶段,并在集群中的多个节点上并行执行这些任务。

YARN(Yet Another Resource Negotiator):YARN是Hadoop的资源管理器,用于分配和管理集群中的计算资源。它负责为MapReduce任务分配适当的资源,并监控任务的执行情况。

Hadoop生态系统工具:Hadoop生态系统提供了许多其他工具和组件,用于数据处理、数据仓库、数据流处理、机器学习等各种用途。一些常见的工具包括Hive、Pig、Spark、HBase、Sqoop等。

在Hadoop集群中,数据被分割成多个块,并在集群中的多个节点上进行存储和处理。这种分布式存储和计算的方式使得Hadoop能够处理大规模数据集,并提供高可靠性和容错性,即使某个节点发生故障,数据仍然可以被恢复和处理。Hadoop集群的规模可以根据需求进行扩展,可以添加更多的节点来增加存储容量和计算能力。通过并行处理和分布式存储,Hadoop集群能够提供高性能的数据处理和分析能力,广泛应用于大数据领域。

对于刚开始接触hadoop相关工作者,建议先阅读《Hadoop权威指南》- 作者:Tom White这本书籍。这本书是学习Hadoop和CDH的经典指南之一。它涵盖了Hadoop生态系统的各个方面,包括HDFS、MapReduce、YARN和Hadoop工具的使用。尽管它不是专门针对CDH,但它提供了对Hadoop和大数据处理的全面理解,为CDH的学习打下坚实的基础。

目前,企业很少从头开始构建Hadoop集群,而是借助运维管理工具Ambari或CDH(Cloudera Distribution including Apache Hadoop)进行构建。

1.Ambari书籍推荐:

《Apache Ambari实战指南》- 作者:Ankur Gupta、Gaurav Gupta

这本书提供了关于使用Ambari进行大数据集群管理和监控的实际指南。它涵盖了安装、配置和管理Ambari集群,以及使用Ambari进行性能调优和故障排除的方法。

后续具体在实际构建平台中的使用可以参考:《企业级大数据平台构建:架构与实现》

由于Ambari是一个开源项目,因此除了书籍外,您还可以参考官方文档、在线教程和社区讨论来学习Ambari。这些资源将提供更详细和最新的信息,可以帮助你深入了解和掌握Ambari的使用。

2.CDH推荐书籍:

《大数据平台架构与原型实现:数据中台建设实战》- 作者:刘祥、李瑞、王晓龙、魏巍

这本书介绍了大数据平台的架构设计和实现方法,其中包括CDH作为大数据平台的使用和部署。它涵盖了CDH的关键组件和工具,以及构建数据中台的实战经验和案例分析。

《Cloudera Hadoop大数据平台实战指南》- 作者:周志明

这本书专门介绍了Cloudera Hadoop大数据平台的实战应用。它涵盖了CDH的安装、配置、管理和优化,以及使用CDH进行大数据处理和分析的实际案例和最佳实践。

最后,通过以上基础架构学习后,整个集群的运维可以结合**《大数据平台运维(初级)》**这本数来进行运维相关知识的学习。

二、集群组件

hadoop集群配套相关组件有很多,常用的组件有 Hive , Spark , Kafka ,Flink,ES, Storm等,下面不针对每一个组件进行展开介绍,仅推荐相关学习书籍,可针对自己的需求进行学习。

1.HIve

Hive是一个基于Hadoop的数据仓库工具,它提供了类似于SQL的查询语言(HiveQL)来进行大规模数据的分析和查询。Hive的目标是使非技术用户能够轻松地使用Hadoop进行数据处理和分析,无需编写复杂的MapReduce程序。

推荐书籍:《大数据Hive离线计算开发实战》

2.Spark

Spark是一个快速、通用的大数据处理引擎,它提供了高效的数据处理和分析能力。与传统的MapReduce相比,Spark具有更快的执行速度和更强大的功能,使得处理大规模数据变得更加高效和灵活。

推荐书籍:《大数据处理框架Apache Spark设计与实现》与 《Spark权威指南》

3.Kafka

Kafka是一个分布式流处理平台和消息队列系统,它被设计用于处理高容量的实时数据流。Kafka提供了高吞吐量、可持久化的消息传递,以及可水平扩展的能力,使得它成为构建实时数据管道和大规模数据流处理应用的理想选择。

推荐书籍:《Kafka权威指南》

4.Flink

Flink(Apache Flink)是一个开源的流处理和批处理框架,旨在处理大规模、高吞吐量的实时数据流和批量数据。Flink提供了高效的数据流处理能力,能够处理无界的数据流,并支持事件时间处理和状态管理。同时,Flink也支持批处理作业,可以处理有界的数据集。

推荐书籍:《Flink原理、实战与性能优化》

5.ElasticSearch

Elasticsearch是一个开源的分布式搜索和分析引擎,用于快速、可扩展地搜索、分析和存储大规模的实时数据。它构建在Apache Lucene搜索引擎库之上,并提供了简单的RESTful API,使得开发者可以轻松地构建复杂的搜索和分析应用。

推荐书籍:《Elastic Stack应用宝典》

6.Storm

Storm推荐书籍:《Storm应用实践:实时事务处理之策略》(目前storm使用不是很广泛了),如果有需要或者有兴趣也可以学习一下。

7.ClickHouse

ClickHouse是一个开源的列式数据库管理系统(DBMS),专门用于大规模数据分析和实时查询。它被设计成高性能、可扩展和高可用的,能够处理大量的数据,并在秒级别提供快速的查询响应。

推荐书籍:《ClickHouse原理解析与应用实践》

三、开源数据平台

开源数据平台是一种基于开源技术构建的数据管理和分析平台,用于存储、处理和分析大规模数据。它提供了一系列的工具和组件,帮助用户管理数据、执行复杂的数据处理任务,并从数据中提取有价值的信息和洞察。

推荐书籍:《云原生数据中台:架构、方法论与实践》

最后,感谢你能读到这里,我也是在学习的路上,希望大佬们能多多指点,共同进步。