引言

在人工智能飞速发展的今天,AI技术的应用场景已经渗透到我们生活的方方面面。从智能客服到自动驾驶,从精准医疗到金融科技,AI的应用正在不断推动各行业的变革与创新。作为AI领域的领军企业,腾讯云一直以来都在致力于为开发者提供高效、智能、易用的AI解决方案。近期,腾讯云TI平台正式上线了DeepSeek系列模型,为AI开发者们带来了全新的选择和体验。

DeepSeek系列模型以其出色的性能和广泛的适用性,迅速引起了业界的广泛关注。无论是自然语言处理、计算机视觉,还是多模态融合,DeepSeek系列模型都展现出了强大的能力和潜力。本文将详细介绍利用腾讯云TI平台以及DeepSeek系列模型,帮助开发者们轻松部署DeepSeek,开启全新的AI体验。

一、腾讯云 TI 平台:AI 开发的得力助手

腾讯云TI平台(Tencent Cloud TI Platform)是腾讯云推出的一个综合性AI开发平台,旨在为开发者和企业提供一站式的AI开发、训练和推理服务。TI平台通过集成腾讯云在云计算、AI算法和大数据处理等方面的优势,为开发者提供了一个高效、灵活、易用的AI开发环境。

在人工智能蓬勃发展的时代,腾讯云 TI 平台宛如一位得力助手,为开发者们提供了全方位的支持。它是基于腾讯先进 AI 能力和多年技术经验,面向开发者、政企精心打造的全栈式人工智能开发服务平台,致力于打通从数据获取、数据处理、算法构建、模型训练、模型评估、模型部署,到 AI 应用开发的产业 + AI 落地全流程链路 ,帮助用户快速创建和部署 AI 应用,管理全周期 AI 解决方案,有力地推动了政企单位的数字化转型,促进了 AI 行业生态的共建。

在操作方面,腾讯云 TI 平台充分考虑了用户的使用习惯。Notebook、SDK 操作模式符合高阶客户使用习惯,灵活敏捷,让专业开发者能够充分发挥自己的技术优势;自动学习则通过向导式方式构建模型,界面友好易用,即使是没有深厚技术背景的用户也能轻松上手。

二、腾讯云 TI 平台部署 DeepSeek 优势

(一)便捷高效的部署流程

在腾讯云 TI 平台部署 DeepSeek 模型,操作流程极为简便。以部署 DeepSeek-R1 模型为例,用户首先登录腾讯云 TI 平台,在 “大模型广场” 中找到 DeepSeek 系列模型卡片。点击进入后,选择 “新建在线服务”,即可开始部署。在这一过程中,用户无需手动下载模型,腾讯云 TI 平台已将 DeepSeek 系列模型预装到服务中,用户只需根据自身需求,如模型推理资源要求,选择合适的算力规格,如针对 DeepSeek-R1-Distill-Qwen-7B 模型选择 12C44GB A10 *1 的资源配置,确认费用后点击启动服务,即可完成部署。整个过程如同搭建积木一般,简单易懂,即使是初次接触的用户也能快速上手,大大节省了部署时间和精力。

(二)强大的算力支持与资源调度

腾讯云 TI 平台拥有强大的算力基础设施,能够为 DeepSeek 模型的训练和推理提供充足的算力支持。平台搭载了英伟达最新代次 H800 GPU 的腾讯云星星海自研服务器,服务器之间采用业界最高的 3.2T 超高互联带宽,实测显示新一代集群的算力性能较前代提升高达 3 倍,是国内性能最强的大模型计算集群。在模型训练时,面对大规模的参数计算和海量的数据处理,腾讯云 TI 平台的强大算力能够确保训练过程高效、稳定地进行,大大缩短训练时间。

同时,平台具备灵活的资源调度能力,支持多种 CPU/GPU 资源,符合用户对差异化算力的场景需求。采用灵活的计费方式,帮助用户降本增效。无论是小型企业进行简单的模型测试,还是大型企业进行复杂的模型训练和推理,腾讯云 TI 平台都能根据其业务需求,合理分配计算资源,实现资源的高效利用。在模型推理阶段,当业务量突然增加时,平台能够快速调配更多的算力资源,确保模型推理的响应速度和准确性,满足用户的业务需求。

(三)丰富的模型生态与技术支持

腾讯云 TI 平台拥有丰富的模型生态,除了 DeepSeek 系列模型外,还集成了腾讯自研的混元大模型以及 Llama 3、Baichuan 等市场主流开源大模型。这使得用户可以根据自身业务需求,选择最适合的模型进行应用开发,无需在不同的平台和模型之间进行繁琐的切换和适配。在自然语言处理任务中,用户可以对比混元大模型和 DeepSeek 模型在文本生成、情感分析等方面的表现,选择性能更优的模型进行应用开发。

腾讯云还为用户提供了全面的技术支持和服务。在模型部署和使用过程中,用户遇到任何问题,都可以随时联系腾讯云的专业技术团队,获得及时的解答和帮助。平台还提供了详细的文档和教程,帮助用户快速了解和掌握模型的使用方法。腾讯云 TI 平台还会定期举办技术交流活动和培训课程,邀请行业专家和技术大咖分享最新的技术趋势和应用案例,帮助用户提升技术水平,更好地利用大模型技术推动业务发展。

部署实战:手把手教

三、部署实战:腾讯云 TI 平台部署 DeepSeek

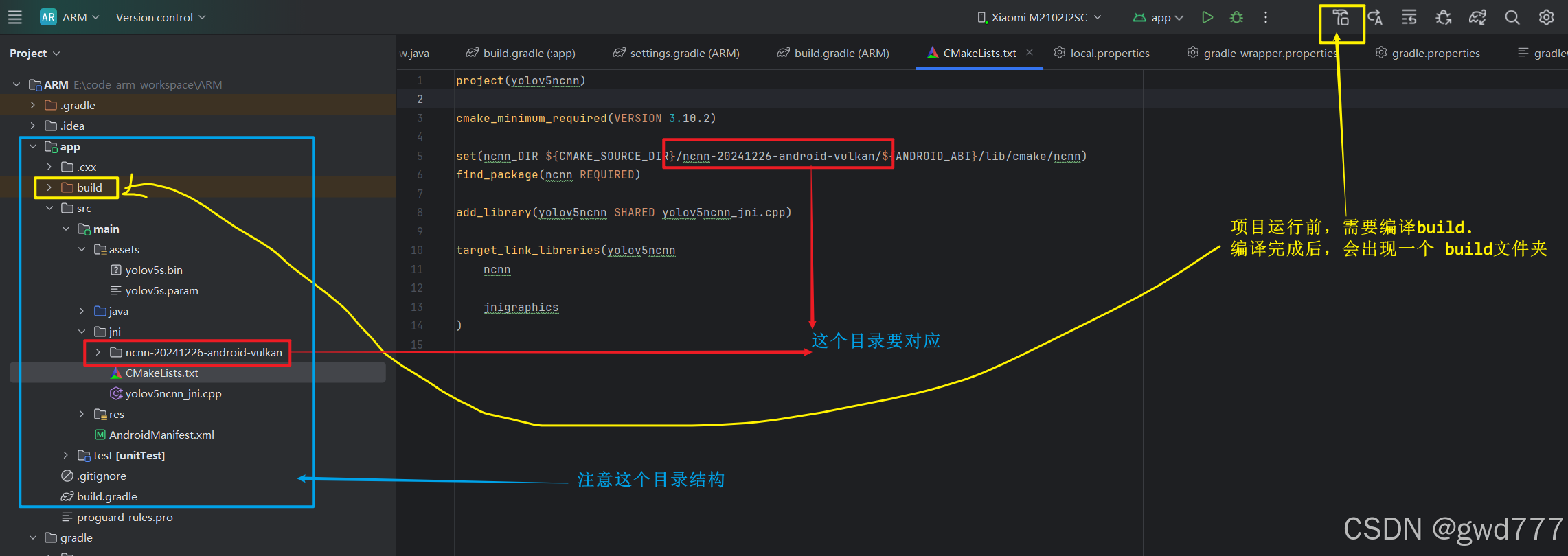

下面以部署 DeepSeek-R1-Distill-Qwen-7B 模型为例,详细说明在腾讯云 TI 平台上的部署过程。

(一)登录腾讯云 TI 平台

在开始部署 DeepSeek 模型之前,首先需要拥有腾讯云账号。打开浏览器,输入腾讯云官网地址,使用已注册并完成实名认证的账号登录腾讯云控制台。

成功注册腾讯云账号后,登录腾讯云官网,在控制台页面的搜索栏中查找 “腾讯云 TI 平台”,在搜索结果中点击对应的产品名称,即可进入腾讯云 TI 平台,开启你的 DeepSeek 模型部署之旅。

(二)选择模型

在腾讯云 TI 平台的 “大模型广场” 中,找到 “DeepSeek 系列模型” 卡片

单击进入模型详情页面。

(三)新建在线服务

在模型详情页面,点击 “新建在线服务” 按钮,跳转至 “模型服务 > 在线服务 > 创建服务” 页面,开始配置部署参数。

(四)配置部署参数

1. 服务名称

输入自定义的服务名称,例如 “my-DeepSeek-R1-Distill-Qwen-7B-service”,方便后续识别和管理。

2. 机器来源

选择 “从 TIONE 平台购买 - 按量计费” 模式。如果已经购买了 CVM 机器,也可以选择 “从 CVM 机器中选择”,并选择对应的资源组。

3. 部署方式

选择 “标准部署”。

(五)服务实例

1. 模型来源

选择 “镜像” 类型。

2. 模型和运行环境

选择 “内置大模型 / DeepSeek 系列模型 / DeepSeek-R1-Distill-Qwen-7B”。

算力规格:根据模型推荐,选择 12C44GB A10 *1 的算力规格。

授权并启动服务:阅读并同意《腾讯云 TI-ONE 训练平台服务协议》,点击底部的 “启动服务” 按钮,正式发起服务部署。

此时,平台会开始分配资源,部署模型服务,需要耐心等待一段时间,直到服务状态显示为 “运行中”。

四、模型效果体验

部署完成后,就可以体验 DeepSeek 模型的强大功能了。在腾讯云 TI 平台的 “模型服务> 在线服务” 页面,找到刚刚部署的 DeepSeek-R1-Distill-Qwen-7B 服务,点击 “在线体验” 按钮,即可进入模型交互界面。

在交互界面中,可以输入各种问题,如自然语言处理任务中的文本生成、情感分析、知识问答,代码生成任务中的代码编写、代码纠错等,观察模型的回答和生成结果。

总结

在今天的分享中,我们一同深入探索了腾讯云 TI 平台部署 DeepSeek 模型的精彩世界。信大家已经对在腾讯云 TI 平台部署 DeepSeek 模型有了全面且深入的了解。如此强大而便捷的技术组合,怎能不亲自尝试一番?我鼓励每一位对人工智能和大语言模型感兴趣的读者,都去腾讯云 TI 平台动手部署 DeepSeek 模型,开启你的智能探索之旅。

在尝试的过程中,你也许会有新的发现、新的感悟,或是遇到一些小问题。无论如何,都欢迎你在留言区分享你的经验和心得。我们可以一起交流探讨,共同进步。说不定你的独特见解,能为其他读者带来新的启发,让我们一起在技术的海洋里共同成长!