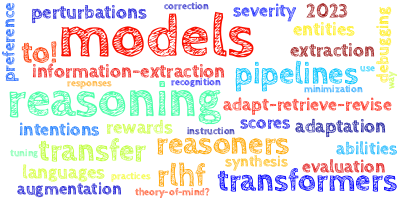

AI视野·今日CS.NLP 自然语言处理论文速览

Fri, 6 Oct 2023

Totally 44 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| MathCoder: Seamless Code Integration in LLMs for Enhanced Mathematical Reasoning Authors Ke Wang, Houxing Ren, Aojun Zhou, Zimu Lu, Sichun Luo, Weikang Shi, Renrui Zhang, Linqi Song, Mingjie Zhan, Hongsheng Li 最近发布的 GPT 4 代码解释器在解决具有挑战性的数学问题方面表现出了卓越的能力,这主要归功于它能够使用自然语言无缝推理、生成代码、执行代码以及根据执行输出继续推理。在本文中,我们提出了一种微调开源语言模型的方法,使它们能够使用代码来建模和推导数学方程,从而增强它们的数学推理能力。我们提出了一种用数学问题及其基于代码的解决方案生成新颖且高质量数据集的方法,称为 MathCodeInstruct。每个解决方案都交织着自然语言、代码和执行结果。我们还引入了定制的监督微调和推理方法。这种方法产生了 MathCoder 模型,这是一系列能够生成基于代码的解决方案来解决具有挑战性的数学问题的模型。令人印象深刻的是,MathCoder 模型在 MATH 45.2 和 GSM8K 83.9 数据集上在开源法学硕士中取得了最先进的分数,大大优于其他开源替代方案。值得注意的是,MathCoder 模型不仅在 GSM8K 和 MATH 上超越了 ChatGPT 3.5 和 PaLM 2,而且在竞赛级别 MATH 数据集上也超越了 GPT 4。 |

| Modular Speech-to-Text Translation for Zero-Shot Cross-Modal Transfer Authors Paul Ambroise Duquenne, Holger Schwenk, Beno t Sagot 最近的研究表明,独立训练的编码器和解码器通过共享的固定大小表示相结合,可以在语音到文本翻译中实现有竞争力的性能。在这项工作中,我们表明这种方法可以通过多语言培训得到进一步改进。 |

| A Long Way to Go: Investigating Length Correlations in RLHF Authors Prasann Singhal, Tanya Goyal, Jiacheng Xu, Greg Durrett 据报道,使用人类反馈 RLHF 的强化学习来调整大型语言模型取得了巨大成功。开源偏好数据集和奖励模型使通用聊天设置之外的更广泛的实验成为可能,特别是使系统对网络问答、摘要和多轮对话等任务更有帮助。在针对有用性进行优化时,人们一直观察到 RLHF 会驱动模型产生更长的输出。本文表明,优化响应长度是 RLHF 报告的这些设置改进背后的一个重要因素。首先,我们研究了在三个开源偏好数据集上训练的奖励模型的奖励和长度之间的关系,以提高帮助性。在这里,长度与奖励密切相关,奖励分数的提高在很大程度上是通过改变输出长度的分布来驱动的。然后,我们探索 RL 和奖励模型学习期间的干预措施,看看我们是否可以在不增加长度的情况下实现与 RLHF 相同的下游改进。虽然我们的干预措施可以缓解长度的增加,但它们在不同环境下的效果并不相同。 |

| DSPy: Compiling Declarative Language Model Calls into Self-Improving Pipelines Authors Omar Khattab, Arnav Singhvi, Paridhi Maheshwari, Zhiyuan Zhang, Keshav Santhanam, Sri Vardhamanan, Saiful Haq, Ashutosh Sharma, Thomas T. Joshi, Hanna Moazam, Heather Miller, Matei Zaharia, Christopher Potts ML 社区正在快速探索促进语言模型 LM 并将其堆叠到解决复杂任务的管道中的技术。不幸的是,现有的 LM 管道通常使用硬编码提示模板来实现,即通过反复试验发现的冗长字符串。为了采用更系统的方法来开发和优化 LM 管道,我们引入了 DSPy,这是一种将 LM 管道抽象为文本转换图的编程模型,即通过声明性模块调用 LM 的命令式计算图。 DSPy 模块是参数化的,这意味着它们可以通过创建和收集演示来学习如何应用提示、微调、增强和推理技术的组合。我们设计了一个编译器,可以优化任何 DSPy 管道以最大化给定的指标。我们进行了两个案例研究,表明简洁的 DSPy 程序可以表达和优化复杂的 LM 管道,这些管道可以推理数学应用问题、解决多跳检索、回答复杂问题和控制代理循环。在编译后的几分钟内,几行 DSPy 允许 GPT 3.5 和 llama2 13b 聊天以自引导管道,其性能通常分别优于标准的少数镜头提示超过 25 和 65 ,以及专家创建的演示管道高达 5 46 和 16 40 ,分别 。最重要的是,为开放且相对较小的语言模型(例如 770M 参数 T5 和 llama2 13b 聊天)编译的 DSPy 程序与依赖专家为专有 GPT 3.5 编写的提示链的方法具有竞争力。 |

| Agent Instructs Large Language Models to be General Zero-Shot Reasoners Authors Nicholas Crispino, Kyle Montgomery, Fankun Zeng, Dawn Song, Chenguang Wang 我们介绍了一种提高大型语言模型在一般语言理解任务上的零样本推理能力的方法。具体来说,我们构建一个自主代理来指导大型语言模型的推理过程。我们展示了这种方法进一步将大型语言模型的零样本推理能力释放到更多任务中。我们研究了我们的方法在涵盖生成、分类和推理的广泛数据集上的性能。我们表明,我们的方法可以推广到大多数任务,并在我们评估的 29 个数据集中的 20 个数据集上获得最先进的零样本性能。例如,我们的方法大幅提升了最先进的大型语言模型的性能,包括 Vicuna 13b 13.3 、 Llama 2 70b chat 23.2 和 GPT 3.5 Turbo 17.0 。与零镜头思维链相比,我们在推理方面的进步是惊人的,平均提高了 10.5 。 |

| Fine-tuning Aligned Language Models Compromises Safety, Even When Users Do Not Intend To! Authors Xiangyu Qi, Yi Zeng, Tinghao Xie, Pin Yu Chen, Ruoxi Jia, Prateek Mittal, Peter Henderson 针对下游用例优化大型语言模型 LLM 通常涉及通过进一步微调来定制预训练的 LLM。 Meta 公开发布的 Llama 模型和 OpenAI 用于在自定义数据集上微调 GPT 3.5 Turbo 的 API 也鼓励这种做法。但是,与这种自定义微调相关的安全成本是多少?我们注意到,虽然现有的安全调整基础设施可以限制 LLM 在推理时的有害行为,但当微调权限扩展到最终用户时,它们并不能涵盖安全风险。我们的红队研究发现,法学硕士的安全一致性可能会因仅使用少数对抗性设计的训练示例进行微调而受到损害。例如,我们通过 OpenAI 的 API 以不到 0.20 的成本对 10 个此类示例进行微调,从而越狱了 GPT 3.5 Turbo 的安全护栏,使模型能够响应几乎任何有害指令。令人不安的是,我们的研究还表明,即使没有恶意,简单地使用良性且常用的数据集进行微调也会无意中降低法学硕士的安全性,尽管程度较小。这些发现表明,微调对齐的法学硕士引入了新的安全风险,当前的安全基础设施无法解决,即使模型的初始安全对齐是无可挑剔的,但在定制微调后也不一定要维持。 |

| DecoderLens: Layerwise Interpretation of Encoder-Decoder Transformers Authors Anna Langedijk, Hosein Mohebbi, Gabriele Sarti, Willem Zuidema, Jaap Jumelet 近年来,人们提出了许多可解释性方法来帮助解释不同精度和复杂程度的 Transformer 模型的内部状态。在这里,为了分析编码器解码器 Transformer,我们提出了一种简单的新方法 DecoderLens。受到仅用于解码器 Transformers 的 LogitLens 的启发,此方法涉及允许解码器交叉参与中间编码器层的表示,而不是像编码器解码器模型中通常所做的那样使用最终编码器输出。因此,该方法将以前无法解释的向量表示映射到人类可解释的单词或符号序列。我们报告了 DecoderLens 应用于问答、逻辑推理、语音识别和机器翻译训练模型的结果。 |

| GoLLIE: Annotation Guidelines improve Zero-Shot Information-Extraction Authors Oscar Sainz, Iker Garc a Ferrero, Rodrigo Agerri, Oier Lopez de Lacalle, German Rigau, Eneko Agirre 大型语言模型法学硕士与指令调优相结合,在推广到看不见的任务时取得了重大进展。然而,它们在信息提取 IE 方面不太成功,落后于特定于任务的模型。通常,IE 任务的特点是复杂的注释指南,这些指南描述任务并向人类提供示例。以前利用此类信息的尝试都失败了,即使是最大的模型也是如此,因为它们无法遵循开箱即用的指南。在本文中,我们提出了遵循 IE 大型语言模型的 GoLLIE 指南,该模型能够通过微调以符合注释指南,从而改善未见过的 IE 任务的零样本结果。综合评估经验表明,GoLLIE 能够泛化并遵循看不见的准则,优于之前零样本信息提取的尝试。 |

| MapperGPT: Large Language Models for Linking and Mapping Entities Authors Nicolas Matentzoglu, J. Harry Caufield, Harshad B. Hegde, Justin T. Reese, Sierra Moxon, Hyeongsik Kim, Nomi L. Harris, Melissa A Haendel, Christopher J. Mungall 协调术语资源(包括本体、受控词汇、分类法和值集)是医疗保健、化学和生物医学研究等许多领域数据集成的关键部分。实体映射是确定这些资源中实体之间对应关系的过程,例如基因标识符、疾病概念或化学实体标识符。已经开发了许多工具来基于常见的结构特征和词汇信息(例如标签和同义词)来计算此类映射。特别是词汇方法通常提供非常高的召回率,但由于词汇歧义而导致精度低。 |

| Evaluating Self-Supervised Speech Representations for Indigenous American Languages Authors Chih Chen Chen, William Chen, Rodolfo Zevallos, John Ortega 近年来,自我监督在语音表示学习中的应用引起了人们的极大兴趣,因为它具有对大量未标记数据的可扩展性。然而,无论是在预训练还是下游评估方面,许多进展仍然集中在仅考虑英语的单语言模型上。很少有模型考虑其他语言,考虑本土语言的模型就更少了。在我们向 ASRU 2023 ML SUPERB Challenge 新语言赛道提交的作品中,我们展示了盖丘亚语(一种南美本土语言)的 ASR 语料库。我们对大型 SSL 模型在盖丘亚语以及瓜拉尼语和 Bribri 等其他 6 种本土语言(例如瓜拉尼语和 Bribri)上的低资源 ASR 上的功效进行了基准测试。 |

| Redefining Digital Health Interfaces with Large Language Models Authors Fergus Imrie, Paulius Rauba, Mihaela van der Schaar 数字医疗工具有可能显着改善医疗保健服务的提供。然而,它们的使用仍然相对有限,部分原因是可用性和信任方面的挑战。最近,大型语言模型法学硕士已经成为通用模型,能够处理复杂信息并生成人类质量的文本,在医疗保健领域呈现出丰富的潜在应用。在临床环境中直接应用法学硕士并不简单,法学硕士很容易提供不一致或无意义的答案。我们展示了法学硕士如何利用外部工具在临床医生和数字技术之间提供新颖的界面。这增强了数字医疗工具和人工智能模型的实用性和实际影响,同时解决了当前在临床环境中使用法学硕士的问题,例如幻觉。 |

| Towards Robust and Generalizable Training: An Empirical Study of Noisy Slot Filling for Input Perturbations Authors Jiachi Liu, Liwen Wang, Guanting Dong, Xiaoshuai Song, Zechen Wang, Zhengyang Wang, Shanglin Lei, Jinzheng Zhao, Keqing He, Bo Xiao, Weiran Xu 在真实的对话场景中,由于话语中存在未知的输入噪声,现有的监督槽填充模型在实际应用中往往表现不佳。尽管有一些关于噪声鲁棒模型的研究,但这些工作仅在基于规则的合成数据集上进行评估,这是有局限性的,使得噪声鲁棒方法的研究难以推广。在本文中,我们引入了一个用于槽填充任务的噪声鲁棒性评估数据集Noise SF。所提出的数据集包含五种类型的人类注释噪声,并且所有这些噪声都完全存在于所提出的框架中的槽填充的真实广泛鲁棒训练方法中。通过对Noise SF进行详尽的实证评估实验,我们发现基线模型在鲁棒性评估方面表现不佳,而所提出的框架可以有效提高模型的鲁棒性。基于实证实验结果,我们提出了一些前瞻性的建议,以推动这一方向的研究。 |

| Tik-to-Tok: Translating Language Models One Token at a Time: An Embedding Initialization Strategy for Efficient Language Adaptation Authors Fran ois Remy, Pieter Delobelle, Bettina Berendt, Kris Demuynck, Thomas Demeester 由于预训练数据有限且通常不充分,为中低资源语言训练单语语言模型变得具有挑战性。在本研究中,我们提出了一种新颖的模型转换策略来解决这个问题,将高资源单语语言模型适应新的目标语言。通过概括包含源语言和目标语言的单词翻译词典,我们将目标标记生成器中的标记映射到源语言标记生成器中语义相似的标记。这种一对多的标记映射极大地改进了目标语言的嵌入表的初始化。我们进行了实验,将高资源模型转换为中低资源语言,即荷兰语和弗里斯兰语。这些转换后的模型在这些语言上跨各种下游任务实现了新的最先进的性能。 |

| Controllable Multi-document Summarization: Coverage & Coherence Intuitive Policy with Large Language Model Based Rewards Authors Litton J Kurisinkel, Nancy F chen 内存高效的大型语言模型擅长优化文本输入以提高可读性。然而,当涉及长输入的文本生成任务(例如多文档摘要)时,可控性是一个值得关注的问题。在这项工作中,我们研究了一种用于多文档摘要的通用可控方法,该方法利用法学硕士的功能来细化文本。特别是,我们训练了一个可控的内容提取方案来提取将由法学硕士精炼的文本。该计划的设计具有新颖的覆盖范围和连贯性直观的政策,并得到了被动培训的法学硕士的适当奖励。 |

| The North System for Formosa Speech Recognition Challenge 2023 Authors Li Wei Chen, Kai Chen Cheng, Hung Shin Lee 本报告对拟议的 North 系统进行了简要概述,该系统旨在实现台湾客家四弦的自动单词音节识别。该报告概述了系统的三个关键组成部分:训练数据的获取、组成和利用、模型的架构以及硬件规格和操作统计数据。 |

| LLM Based Multi-Document Summarization Exploiting Main-Event Biased Monotone Submodular Content Extraction Authors Litton J Kurisinkel, Nancy F. Chen 多文档摘要因其固有的主观偏见而成为一项具有挑战性的任务,DUC 2004 参考摘要中注释器 ROUGE 1 得分较低(0.4)就凸显了这一点。在这项工作中,我们的目标是通过关注一组相关新闻文件的主要事件并在足够的背景下连贯地呈现它来增强新闻摘要的客观性。我们的主要目标是简洁地报告主要事件,确保摘要客观且内容丰富。为了实现这一目标,我们采用了一种提取重写方法,该方法结合了用于内容选择的主事件偏向单调子模函数。这使我们能够从文档集群中提取与主要事件相关的最关键信息。为了确保连贯性,我们利用微调语言模型 LLM 将提取的内容重写为连贯的文本。 |

| Procedural Text Mining with Large Language Models Authors Anisa Rula, Jennifer D Souza 自然语言处理领域的最新进展,特别是基于大量知识进行预训练的大规模语言模型的开发,正在知识工程领域创造新的机会。在本文中,我们研究了大型语言模型法学硕士在零样本和上下文学习设置中的使用,以解决以增量问答方式从非结构化 PDF 文本中提取程序的问题。特别是,我们利用当前最先进的 GPT 4 生成式预训练 Transformer 4 模型,伴随着上下文学习的两种变体,其中涉及具有程序和步骤定义的本体以及少量镜头学习的有限数量的样本。研究结果强调了这种方法的前景和情境学习定制的价值。 |

| Evaluating Hallucinations in Chinese Large Language Models Authors Qinyuan Cheng, Tianxiang Sun, Wenwei Zhang, Siyin Wang, Xiangyang Liu, Mozhi Zhang, Junliang He, Mianqiu Huang, Zhangyue Yin, Kai Chen, Xipeng Qiu 在本文中,我们建立了一个名为 HalluQA 中文幻觉问答的基准来衡量中文大语言模型中的幻觉现象。 HalluQA包含450个精心设计的对抗性问题,跨越多个领域,并考虑到中国历史文化、习俗和社会现象。在 HalluQA 的构建过程中,我们考虑了两种类型的幻觉:模仿谎言和事实错误,并基于 GLM 130B 和 ChatGPT 构建对抗样本。为了评估,我们设计了一种使用 GPT 4 的自动化评估方法来判断模型输出是否是幻觉。我们对 24 个大型语言模型进行了广泛的实验,包括 ERNIE Bot、Baichuan2、ChatGLM、Qwen、SparkDesk 等。在 24 个模型中,18 个模型的非幻觉率低于 50。这表明 HalluQA 具有很高的挑战性。我们分析了不同类型模型中幻觉的主要类型及其原因。 |

| Reformulating Domain Adaptation of Large Language Models as Adapt-Retrieve-Revise Authors Zhen wan, Yating Zhang, Yexiang Wang, Fei Cheng, Sadao Kurohashi 虽然像 GPT 4 这样的大型语言模型 LLM 最近在一般领域任务中展示了惊人的零射击能力,但它们经常会在中国法律等特定领域生成带有幻觉的内容,从而阻碍了它们在这些领域的应用。这通常是由于缺乏包含此类特定领域的训练数据,导致 GPT 4 无法获取领域知识。 |

| Concise and Organized Perception Facilitates Large Language Models for Deductive Reasoning Authors Shaotian Yan, Chen Shen, Junjie Liu, Jieping Ye 利用大型语言模型来解决演绎推理的法学硕士已经引起了越来越多的关注。在复杂的演绎问题中获得令人满意的结果仍然非常具有挑战性,这些问题的特点是存在大量前提,即事实或规则需要实体之间错综复杂的关系并需要多跳推理。一种直观的解决方案是将原始任务分解为更小的子任务,然后将多个临时推理步骤向前(例如选择推理)或向后(例如 LAMBADA 方向)链接在一起。然而,这些技术不可避免地需要大量的总体阶段,导致计算量大的操作并且更有可能做出误导性的步骤。除了逐步分解之外,我们还从人类解决问题的另一个方面汲取灵感。人类倾向于提取最相关的信息并系统地组织他们的思想,例如创建思维导图,这有助于他们准确快速地回答问题或得出结论。鉴于此,我们提出了一种新颖的推理方法,名为 Concise and Organized Perception COP 。 COP 仔细分析给定的陈述,以有效地识别最相关的信息,同时消除冗余。然后,它以一种更有组织的形式提示法学硕士,以适应模型的推理过程。通过感知简洁、有组织的证明,可以更好地激发法学硕士的演绎推理能力,并降低因推理阶段过多而导致错误的风险。此外,我们的方法可以与上述方法相结合,以进一步提高其性能。 |

| Learning Personalized Story Evaluation Authors Danqing Wang, Kevin Yang, Hanlin Zhu, Xiaomeng Yang, Andrew Cohen, Lei Li, Yuandong Tian 虽然大型语言模型法学硕士在 QA 和检索等更客观的任务中显示了令人印象深刻的结果,但评估其在开放式文本生成方面的性能仍然很重要,原因包括 1 数据污染 2 多维评估标准和 3 源于审稿人个人偏好的主观性。为了解决这些问题,我们建议在未受污染的开放式生成评估中建立个性化模型。我们通过适当的匿名化和新的个性化标签重新利用现有数据集,为个性化故事评估创建了两个新数据集 Per MPST 和 Per DOC。我们进一步开发了个性化故事评估模型 PERSE,以推断评论者的偏好并提供个性化评估。具体来说,给定特定审阅者的一些示例性审阅,PERSE 会在多个方面(例如该审阅者对新文本输入的兴趣和惊喜)预测详细审阅或细粒度比较。实验结果表明,PERSE 在故事评分的 Kendall 相关性方面优于 GPT 4 15.8,在成对偏好预测准确性方面优于 GPT 4 13.7。 |

| A New Dialogue Response Generation Agent for Large Language Models by Asking Questions to Detect User's Intentions Authors Siwei Wu, Xiangqing Shen, Rui Xia ChatGPT 等大型语言模型 LLM 由于其开放域生成功能,最近已应用于各种 NLP 任务。然而,将法学硕士应用于对话任务存在两个问题。 1. 在对话过程中,用户可能有隐含的意图,而这些意图可能会被法学硕士所忽视。因此,生成的响应无法符合用户的意图。 2. LLM不太可能全面涵盖所有领域。在某些特定领域,他们的知识可能是不完整的,法学硕士无法实时更新最新的知识。为了解决这些问题,我们提出了一个框架 emph,使用 LLM 来 textbf 通过向 textbf 提出问题来增强对话响应的生成。检测用户的 textbf 隐含在 textbf T entions textbf EDIT 中。首先,EDIT生成与对话上下文相关的开放性问题作为潜在用户的意图然后,EDIT通过与LLM交互并分别在特定领域的知识库中搜索来回答这些问题,并使用LLM选择正确的问题答案作为额外知识最后,编辑通过明确整合这些额外知识来增强响应生成。此外,以前的问题生成工作仅侧重于提出问题并在上下文中给出答案。为了提出开放性问题,我们构建了一个上下文开放性问题 COQ 数据集。 |

| A Formalism and Approach for Improving Robustness of Large Language Models Using Risk-Adjusted Confidence Scores Authors Ke Shen, Mayank Kejriwal 大型语言模型法学硕士(例如 ChatGPT)在自然语言处理 NLP 领域取得了令人印象深刻的里程碑。尽管它们的性能令人印象深刻,但众所周知,这些模型会带来重大风险。由于这些模型被部署在现实世界的应用中,因此非常需要系统地了解这些模型在自然语言推理 NLI 等任务中所带来的不同风险。在本文中,我们定义并形式化了两种不同类型的风险决策风险和复合风险。我们还提出了一个以风险为中心的评估框架和四个新颖的指标,用于评估法学硕士在域内和域外环境中的这些风险。最后,我们提出了一种称为 DwD 的风险调整校准方法,用于帮助法学硕士在整体 NLI 架构中最小化这些风险。使用四个 NLI 基准、三个基线和两个法学硕士(包括 ChatGPT)的详细实验显示了评估框架的实用性以及 DwD 在降低决策和综合风险方面的功效。 |

| Unlock Predictable Scaling from Emergent Abilities Authors Shengding Hu, Xin Liu, Xu Han, Xinrong Zhang, Chaoqun He, Weilin Zhao, Yankai Lin, Ning Ding, Zebin Ou, Guoyang Zeng, Zhiyuan Liu, Maosong Sun 大型语言模型法学硕士的科学扩展需要全面了解其扩展特性。然而,现有关于缩放属性的文献仅给出了不完整的答案,随着模型大小的增加,优化损失可预测地减少,符合既定的缩放定律,但尚未建立任务的缩放定律,并且在缩放期间任务性能远非可预测。任务性能通常在小型模型上显示出较小的增益,直到一旦模型超过尺寸阈值,任务性能就会显着提高,这体现了新兴能力。在这项研究中,我们发现小型模型虽然表现出较小的性能,但表现出关键且一致的任务性能改进,而由于测量分辨率不足,传统评估策略无法捕获这些改进。为了衡量这些改进,我们引入了 PassUntil,这是一种在解码阶段通过大量采样进行评估的策略。我们对任务绩效的缩放规律进行定量研究。首先,确定了严格的任务缩放法则,增强了任务性能的可预测性。值得注意的是,我们能够在训练开始之前预测 2.4B 模型在代码生成方面的性能,偏差仅为 0.05。其次,在 PassUntil 的支持下,我们观察了新兴能力的具体证据,并确定它们与绩效改进的连续性并不冲突。它们的突破在于其标度曲线无法用标准标度律函数拟合。然后我们引入新兴能力的数学定义。 |

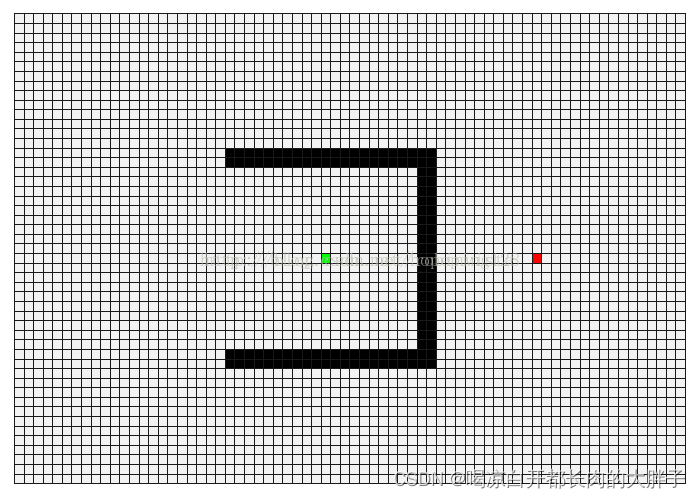

| Can Large Language Models be Good Path Planners? A Benchmark and Investigation on Spatial-temporal Reasoning Authors Mohamed Aghzal, Erion Plaku, Ziyu Yao 大型语言模型法学硕士在广泛的任务中取得了显着的成功,然而,它们在需要长期规划和空间推理的场景中仍然面临局限性。为了促进这一研究方向,在这项工作中,我们提出了一个新的基准,称为 textbf Path textbf P lanning from textbf Natural textbf Language textbf PPNL 。我们的基准通过制定路径规划任务来评估法学硕士的时空推理,这些任务要求法学硕士导航到目标位置,同时避开障碍物并遵守约束。利用这个基准,我们系统地研究了 LLM,包括通过不同的少数镜头提示方法的 GPT 4 以及通过微调的各种大小的 BART 和 T5。我们的实验结果表明,当提示推理和行动交错时,少量 GPT 4 在空间推理中的前景,尽管它仍然无法进行长期时间推理。 |

| Deep Representations of First-person Pronouns for Prediction of Depression Symptom Severity Authors Xinyang Ren, Hannah A Burkhardt, Patricia A Are n, Thomas D Hull, Trevor Cohen 先前的研究表明,分析第一人称单数代词的使用可以深入了解个人的心理状态,尤其是抑郁症状的严重程度。这些发现是通过计算文本数据中第一人称单数代词的频率得出的。然而,计数并不能捕捉这些代词的使用方式。神经语言建模的最新进展利用了生成上下文嵌入的方法。在本研究中,我们试图利用从情境化语言表示模型获得的第一人称代词的嵌入来捕获这些代词的使用方式,从而分析心理状态。德识别在线心理治疗期间发送的短信以及每周评估抑郁严重程度的信息用于评估。结果表明,上下文化的第一人称代词嵌入比标准分类标记嵌入和基于频率的代词分析结果在预测抑郁症状严重程度方面具有优势。 |

| FreshLLMs: Refreshing Large Language Models with Search Engine Augmentation Authors Tu Vu, Mohit Iyyer, Xuezhi Wang, Noah Constant, Jerry Wei, Jason Wei, Chris Tar, Yun Hsuan Sung, Denny Zhou, Quoc Le, Thang Luong 大多数大型语言模型法学硕士只接受过一次培训,并且从未更新过,因此,它们缺乏动态适应不断变化的世界的能力。在这项工作中,我们在回答测试当前世界知识的问题的背景下,对法学硕士生成的文本的真实性进行了详细研究。具体来说,我们介绍 FreshQA,这是一种新颖的动态 QA 基准,涵盖各种问答类型,包括需要快速变化的世界知识的问题以及需要揭穿的错误前提问题。我们在两种模式评估程序下对各种封闭式和开源法学硕士进行了基准测试,这使我们能够衡量正确性和幻觉。通过涉及超过 50K 判断的人类评估,我们揭示了这些模型的局限性,并展示了巨大的改进空间,例如,无论模型大小如何,所有模型都难以解决涉及快速变化的知识和错误前提的问题。受这些结果的启发,我们提出了 FreshPrompt,这是一种简单的几次提示方法,通过将从搜索引擎检索到的相关且最新的信息合并到提示中,显着提高了 FreshQA 上法学硕士的性能。 |

| On the Performance of Multimodal Language Models Authors Utsav Garg, Erhan Bas 指令调整的大型语言模型法学硕士已经在各种下游任务中展示了有前途的零样本泛化能力。最近的研究通过模型移植集成独立预训练的视觉编码器,为法学硕士引入了多模式功能。这些多模态变体经过指令调整,类似于法学硕士,为多模态任务提供有效的零样本泛化。本研究对不同的多模态指令调整方法进行了比较分析,并评估了它们在一系列任务中的性能,包括复杂推理、对话、图像字幕、多项选择题 MCQ 和二元分类。通过严格的基准测试和消融实验,我们揭示了将多模式功能纳入法学硕士时指导架构选择的关键见解。然而,当前的方法存在局限性,它们不能充分满足对多样化多模式指令数据集的需求,而这对于增强任务泛化至关重要。此外,他们在生成回复时忽略了与真实性和事实性相关的问题。 |

| Can Language Models Employ the Socratic Method? Experiments with Code Debugging Authors Erfan Al Hossami, Razvan Bunescu, Justin Smith, Ryan Teehan 当采用苏格拉底式教学法时,教师引导学生自己解决问题,而不是直接提供解决方案。虽然这种策略可以显着提高学习成果,但它通常非常耗时且对认知要求较高。自动化苏格拉底对话代理可以增强人类指令并提供必要的规模,但由于缺乏合适的培训和评估数据,它们的发展受到阻碍。在本文中,我们介绍了一个手动创建的多轮苏格拉底建议数据集,旨在帮助新手程序员修复简单计算问题的错误解决方案。然后,该数据集用于对多种语言模型的苏格拉底式调试能力进行基准测试,范围从微调基于指令的文本到文本转换器 Flan T5,到更大的 GPT 4 的零射击和思想链提示。代码和数据集 |

| Retrieval-augmented Generation to Improve Math Question-Answering: Trade-offs Between Groundedness and Human Preference Authors Zachary Levonian, Chenglu Li, Wangda Zhu, Anoushka Gade, Owen Henkel, Millie Ellen Postle, Wanli Xing 对于中学生来说,与导师互动问答QA是一种有效的学习方式。生成式大语言模型法学硕士的灵活性和新兴能力引发了人们对自动化部分辅导过程的兴趣激增,包括支持数学概念的概念性讨论的交互式问答。然而,法学硕士对数学问题的回答可能不正确或与教育背景不匹配,例如与学校课程不一致。一种潜在的解决方案是检索增强生成 RAG,其中涉及将经过审查的外部知识源纳入 LLM 提示中,以提高响应质量。在本文中,我们设计了提示,用于检索和使用高质量开源数学教科书中的内容来生成对真实学生问题的回答。我们通过进行多条件调查来评估该 RAG 系统在中学代数和几何 QA 中的有效性,发现人们更喜欢使用 RAG 生成的响应,但当响应过于扎根于教科书内容时则不喜欢。 |

| $\mathcal{B}$-Coder: Value-Based Deep Reinforcement Learning for Program Synthesis Authors Zishun Yu, Yunzhe Tao, Liyu Chen, Tao Sun, Hongxia Yang 程序综合的目的是根据自然语言描述创建准确的可执行代码。该领域利用了强化学习 RL 与大型语言模型 LLM 的强大功能,显着增强了代码生成能力。这种集成的重点是直接优化功能正确性,超越传统的监督损失。虽然当前文献主要支持基于策略的算法,但程序综合的属性表明与基于值的方法具有天然的兼容性。这源于人类程序员开发的丰富的非策略程序集合,以及通过自动化单元测试对生成的程序进行直接验证,即用 RL 语言轻松获得奖励。与基于策略的算法的主要使用不同,我们的工作探索了基于价值的方法的适用性,从而导致了我们的 mathcal B Coder(发音为 Bellman 编码器)的开发。然而,由于程序合成固有的巨大搜索空间,基于训练值的方法提出了挑战。为此,我们提出了一种 RL 代理的初始化协议,利用预先训练的 LM 和保守的 Bellman 算子来降低训练复杂性。此外,我们演示了如何利用学习到的价值函数作为双重策略来后处理生成的程序。我们的实证评估表明,与基于策略的方法相比,Mathcal B Coder 能够实现最先进的性能。 |

| Large Language Model Cascades with Mixture of Thoughts Representations for Cost-efficient Reasoning Authors Murong Yue, Jie Zhao, Min Zhang, Liang Du, Ziyu Yao GPT 4 等大型语言模型 LLM 在各种任务中都表现出了卓越的性能,但这种强大的性能往往伴随着使用付费 API 服务的高昂费用。在本文中,我们有动力研究构建 LLM 级联以节省使用 LLM 的成本,特别是在执行推理(例如数学、因果任务)时。我们的级联管道遵循这样的直觉:更简单的问题可以通过较弱但更负担得起的法学硕士来解决,而只有具有挑战性的问题才需要更强和更昂贵的法学硕士。为了实现这一决策,我们将较弱的 LLM 的答案一致性视为问题难度的信号,并提出了几种答案采样和一致性检查的方法,包括利用两种思维表示的混合,即思维链和程序的思想。 |

| Discovering Knowledge-Critical Subnetworks in Pretrained Language Models Authors Deniz Bayazit, Negar Foroutan, Zeming Chen, Gail Weiss, Antoine Bosselut 预训练语言模型 LM 在其参数中编码隐式知识表示。然而,本地化这些表示并将它们彼此分开仍然是一个悬而未决的问题。在这项工作中,我们研究预训练的语言模型是否包含各种知识关键子网,特别是负责编码模型所记忆的特定知识的稀疏计算子图。我们提出了一种多目标可微权重掩蔽方案来发现这些子网络,并表明我们可以使用它们来精确地从模型中删除特定知识,同时最大限度地减少对原始语言模型行为的不利影响。我们在多个 GPT2 变体上展示了我们的方法,发现了高度稀疏的子网络 98,这些子网络仅负责特定的关系知识集合。 |

| How FaR Are Large Language Models From Agents with Theory-of-Mind? Authors Pei Zhou, Aman Madaan, Srividya Pranavi Potharaju, Aditya Gupta, Kevin R. McKee, Ari Holtzman, Jay Pujara, Xiang Ren, Swaroop Mishra, Aida Nematzadeh, Shyam Upadhyay, Manaal Faruqui 思考是为了做事。人类可以通过观察来推断他人的心理状态,这种能力被称为心理理论 ToM,并随后根据这些推断采取务实的行动。现有的问答基准(例如 ToMi)会向模型提出问题来推断故事中角色的信念,但不会测试模型是否可以使用这些推断来指导他们的行动。我们为大型语言模型 LLMs Thinking for Doing T4D 提出了一种新的评估范式,它要求模型将对他人心理状态的推论与社交场景中的行为联系起来。 T4D 上的实验表明,GPT 4 和 PaLM 2 等法学硕士似乎擅长追踪故事中的人物信念,但他们很难将这种能力转化为战略行动。我们的分析表明,法学硕士面临的核心挑战在于识别有关心理状态的隐含推论,而无需像 ToMi 那样明确询问,从而在 T4D 中选择正确的行动。为了弥补这一差距,我们引入了一个零样本提示框架,Foresee 和 Reflect FaR,它提供了一个推理结构,鼓励法学硕士预测未来的挑战并推理潜在的行动。 FaR 将 GPT 4 在 T4D 上的性能从 50 提升到 71,优于其他提示方法,例如 Chain of Thought 和 Self Ask。 |

| How Prevalent is Gender Bias in ChatGPT? -- Exploring German and English ChatGPT Responses Authors Stefanie Urchs, Veronika Thurner, Matthias A enmacher, Christian Heumann, Stephanie Thiemichen 随着 ChatGPT 的推出,OpenAI 使 IT 专业知识有限的用户可以使用大型语言模型 LLM。然而,没有自然语言处理 NLP 背景的用户可能缺乏对 LLM 的正确理解。因此认识到其固有的局限性,并因此将系统输出视为表面价值。在本文中,我们系统地分析提示和生成的响应,以识别可能存在的问题,特别关注性别偏见,用户在处理系统输出时需要注意这一点。我们探讨了当提示从女性、男性或中立角度回答时,ChatGPT 在英语和德语中的反应。在深入调查中,我们检查选定的提示,并分析如果系统以相同的方式多次提示,反应会有多大程度的差异。在此基础上,我们表明 ChatGPT 对于帮助非 IT 用户起草日常工作文本确实很有用。 |

| Improved Baselines with Visual Instruction Tuning Authors Haotian Liu, Chunyuan Li, Yuheng Li, Yong Jae Lee 大型多模态模型 LMM 最近在视觉指令调整方面取得了令人鼓舞的进展。在这篇文章中,我们展示了 LLaVA 中完全连接的视觉语言跨模式连接器的强大功能和数据效率。通过对 LLaVA 进行简单修改,即使用带有 MLP 投影的 CLIP ViT L 336px 并添加具有简单响应格式提示的面向学术任务的 VQA 数据,我们建立了更强大的基线,在 11 个基准中实现了最先进的水平。我们最终的 13B 检查点仅使用 1.2M 公开数据,并在 1 天内在单个 8 A100 节点上完成完整训练。我们希望这能让最先进的 LMM 研究更容易获得。 |

| TRAM: Bridging Trust Regions and Sharpness Aware Minimization Authors Tom Sherborne, Naomi Saphra, Pradeep Dasigi, Hao Peng 通过减小参数空间中损失表面的曲率,锐度感知最小化 SAM 在域转移下产生广泛的鲁棒性改进。然而,这项工作并没有关注参数,而是将表示的可转移性视为微调设置中域外泛化的优化目标。为了鼓励保留可转移的表示,我们考虑基于信任区域的微调方法,该方法利用任务特定的技能,而不会忘记预训练中与任务无关的表示。我们通过使用信任区域边界来统一参数和表示空间平滑方法,以通知这两个优化表面上的 SAM 样式正则化器。我们提出了信任区域感知最小化 TRAM,这是一种微调算法,可以优化平坦最小值和平滑、信息丰富的表示,而不会忘记预先训练的结构。我们发现,TRAM 在跨域语言建模和跨语言迁移方面优于基于锐度感知和信任区域的优化方法,其中域迁移的鲁棒性和表示通用性对于成功至关重要。 |

| CLEVRER-Humans: Describing Physical and Causal Events the Human Way Authors Jiayuan Mao, Xuelin Yang, Xikun Zhang, Noah D. Goodman, Jiajun Wu 构建能够推理物理事件及其因果关系的机器对于与物理世界的灵活交互至关重要。然而,大多数现有的物理和因果推理基准完全基于合成生成的事件和因果关系的合成自然语言描述。这种设计带来了两个问题。首先,事件类型和自然语言描述都缺乏多样性;其次,基于手动定义的启发式的因果关系与人类的判断不同。为了解决这两个缺点,我们提出了 CLEVRER Humans 基准,这是一个视频推理数据集,用于使用人类标签对物理事件进行因果判断。我们采用两种技术来提高数据收集效率,首先是一种新颖的迭代事件完形填空任务,以引出视频中事件的新表示,我们将其称为因果事件图 CEG;其次是一种基于神经语言生成模型的数据增强技术。我们将收集的 CEG 转换为问题和答案,以与之前的工作保持一致。 |

| Neural Language Model Pruning for Automatic Speech Recognition Authors Leonardo Emili, Thiago Fraga Silva, Ernest Pusateri, Markus Nu baum Thom, Youssef Oualil 我们研究应用于基于 Transformer 的自动语音识别神经网络语言模型的模型修剪方法。我们探讨了剪枝框架的三个方面,即标准、方法和调度器,分析了它们在准确性和推理速度方面的贡献。据我们所知,对大规模识别系统进行如此深入的分析尚未在文献中报道。此外,我们提出了一种低秩近似的变体,适用于增量压缩模型,并提供具有不同目标大小的多个模型。除其他结果外,我们表明,在多种情况下,数据驱动的剪枝优于幅度驱动 b 与一次性剪枝相比,增量剪枝实现了更高的准确性,特别是当目标较小的尺寸时,并且 c 低秩近似在尺寸减小和推理速度之间提供了最佳权衡 |

| InstructProtein: Aligning Human and Protein Language via Knowledge Instruction Authors Zeyuan Wang, Qiang Zhang, Keyan Ding, Ming Qin, Xiang Zhuang, Xiaotong Li, Huajun Chen 大型语言模型法学硕士彻底改变了自然语言处理领域,但他们在理解蛋白质等生物序列方面存在不足。为了应对这一挑战,我们提出了InstructProtein,这是一种创新的法学硕士,它具有人类和蛋白质语言的双向生成能力,即以蛋白质序列作为输入来预测其文本功能描述,并使用自然语言来提示蛋白质序列生成。为了实现这一目标,我们首先在蛋白质和自然语言语料库上对法学硕士进行预训练,使其能够理解各种语言。然后采用监督指令调整来促进这两种不同语言的对齐。在这里,我们引入了基于知识图的指令生成框架来构建高质量的指令数据集,解决现有蛋白质文本语料库中的注释不平衡和指令缺陷。特别是,这些指令继承了知识图中蛋白质和功能注释之间的结构关系,这使得我们的模型能够对蛋白质功能进行因果建模,类似于自然语言中的思维过程链。对双向蛋白质文本生成任务的大量实验表明,InstructProtein 的性能大幅优于最先进的法学硕士。 |

| The Rise of Open Science: Tracking the Evolution and Perceived Value of Data and Methods Link-Sharing Practices Authors Hancheng Cao, Jesse Dodge, Kyle Lo, Daniel A. McFarland, Lucy Lu Wang 近年来,资助机构和期刊越来越多地倡导开放科学实践,例如数据和方法共享,以提高科学的透明度、可及性和可重复性。然而,大规模量化这些实践已被证明是困难的。在这项工作中,我们利用 arXiv 中代表物理、数学和计算机科学领域的 110 万篇论文的大规模数据集来分析数据和方法链接共享实践随时间的采用情况及其对文章接收的影响。为了识别数据和方法的链接,我们训练了一个神经文本分类模型,根据论文中的上下文提及自动对 URL 类型进行分类。我们发现证据表明,随着时间的推移,越来越多的论文包含此类 URL,共享方法和数据链接的做法正在蔓延。可重复性的努力也可能正在蔓延,因为相同的链接越来越多地在论文中重复使用,特别是在计算机科学领域,并且这些链接越来越集中在更少的网络域中,例如随着时间的推移,Github 上。最后,共享数据和方法链接的文章在引用计数方面获得更高的认可,当共享链接处于活动状态而不是失效时,效果会更强。 |

| Robust and Interpretable Medical Image Classifiers via Concept Bottleneck Models Authors An Yan, Yu Wang, Yiwu Zhong, Zexue He, Petros Karypis, Zihan Wang, Chengyu Dong, Amilcare Gentili, Chun Nan Hsu, Jingbo Shang, Julian McAuley 医学图像分类是医疗保健的一个关键问题,有可能减轻医生的工作量并促进患者的诊断。然而,将深度学习模型部署到现实世界的医疗保健应用程序时会出现两个挑战。首先,神经模型倾向于学习虚假相关性而不是所需的特征,这在推广到新领域(例如不同年龄的患者)时可能会出现不足。其次,这些黑盒模型缺乏可解释性。在进行诊断预测时,了解模型出于可信和安全考虑而做出决策的原因非常重要。在本文中,为了解决这两个限制,我们提出了一种新的范式,用自然语言概念构建鲁棒且可解释的医学图像分类器。具体来说,我们首先从 GPT 4 中查询临床概念,然后使用视觉语言模型将潜在图像特征转换为显式概念。我们在八个医学图像分类数据集上系统地评估我们的方法,以验证其有效性。在具有强混杂因素的挑战性数据集上,我们的方法可以减轻虚假相关性,从而大大优于标准视觉编码器和其他基线。 |

| MetaTool Benchmark: Deciding Whether to Use Tools and Which to Use Authors Yue Huang, Jiawen Shi, Yuan Li, Chenrui Fan, Siyuan Wu, Qihui Zhang, Yixin Liu, Pan Zhou, Yao Wan, Neil Zhenqiang Gong, Lichao Sun 大型语言模型法学硕士因其令人印象深刻的自然语言处理 NLP 能力而受到广泛关注。最近,许多研究都集中在法学硕士的工具利用能力上。他们主要研究了法学硕士如何与给定的特定工具进行有效协作。然而,在 LLM 充当智能代理的场景中,如 AutoGPT 和 MetaGPT 等应用程序中所示,LLM 预计将参与复杂的决策过程,包括决定是否使用工具并从可用的集合中选择最合适的工具。满足用户请求的工具。因此,在本文中,我们引入了MetaTool,这是一个旨在评估LLM是否具有工具使用意识并能够正确选择工具的基准。具体来说,我们在基准测试中创建一个名为 ToolE 的数据集。该数据集包含各种类型的用户查询,以提示的形式触发法学硕士使用工具,包括单工具和多工具场景。随后,我们设置了工具使用意识和工具选择的任务。我们从工具选择的不同角度定义了四个子任务,包括相似选择的工具选择、特定场景下的工具选择、可能存在可靠性问题的工具选择以及多工具选择。我们对九个流行的法学硕士进行了实验,发现他们中的大多数仍然难以有效地选择工具,这凸显了法学硕士和真正的智能代理之间存在的差距。但通过误差分析,我们发现仍有很大的改进空间。 |

| REFLECT: Summarizing Robot Experiences for Failure Explanation and Correction Authors Zeyi Liu, Arpit Bahety, Shuran Song 自动检测和分析失败执行的能力对于可解释且强大的机器人系统至关重要。最近,大型语言模型法学硕士在文本输入方面表现出了强大的推理能力。为了利用 LLM 的力量来解释机器人故障,我们引入了 REFLECT,这是一个框架,可以根据多感官观察生成的机器人过去经验的分层摘要来查询 LLM 的故障推理。失败解释可以进一步指导基于语言的规划器纠正失败并完成任务。为了系统地评估该框架,我们创建了包含各种任务和故障场景的 RoboFail 数据集。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

![socket.error: [Errno 10049]错误](https://img-blog.csdnimg.cn/eba3ada035f14233b92c5b963b452be3.png)

![【GSEP202303 C++]】1级 每月天数](https://img-blog.csdnimg.cn/22e14bf249134ee79df4741623785cc7.png)