文章目录

- 1. 分布不平衡的数据集

- 2. TP、TN 、FP 、FN

- 3. 混淆矩阵

- 4. 各自的计算公式

- 5. 例题应用

1. 分布不平衡的数据集

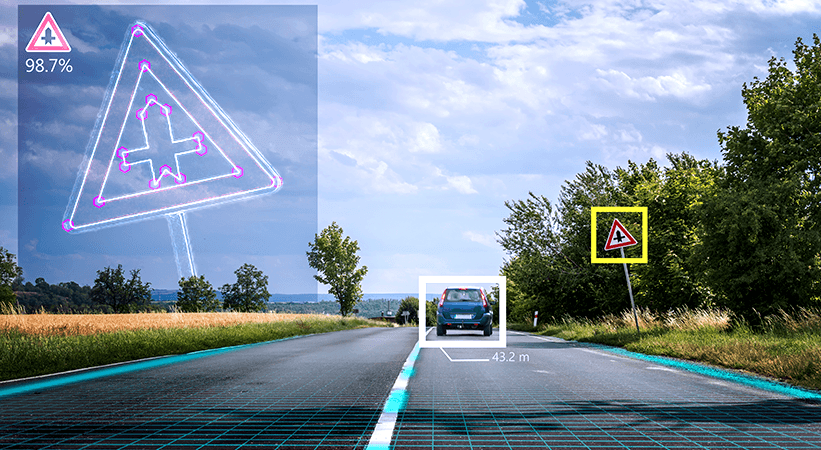

1. 精度(precision)和召回率(recall)是衡量机器学习模型性能的重要指标,特别是数据集分布不平衡的案例中。

2. 不平衡数据集广泛存在于各种分类问题中,包括二分类和多分类问题。以下是一个简单的二分类问题的例子:假设有100个样本,其中80个样本被标记为类别1,其余20个样本被标记为类别2。这个数据集就是不平衡数据集,类别1和类别2的样本数量之比为4:1。另一个不平衡分类问题出现在当疾病在公众中的发病率很低时的疾病监测。

2. TP、TN 、FP 、FN

我们检查身体的时候,经常会听到检测结果呈"真阳性"、"假阴性"等说法。

- “真”、"假"说的是检查结果的对错。”真“意味着检测结果是正确的,"假"意味着检测结果是错误的。

- “阳性”、"阴性"说的是此次的检查结果。阳性,意味检测出了预定的目标。阴性,意味着没查出预定的目标。

| 检测结果 | 英文术语 | 含义 |

|---|---|---|

| 真阳性 | True Positive | 正确地检测到阳性结果:即检测结果正确,并且结果呈现阳性 |

| 假阳性 | False Positive | 错误地检测到阳性结果:即检测结果错误,并且结果呈现阳性 |

| 真阴性 | True Negative | 正确地检测到阴性结果:即检测结果正确,并且结果呈现阴性 |

| 假阴性 | False Negative | 错误地检测到阴性结果:即检测结果错误,并且结果呈现阴性 |

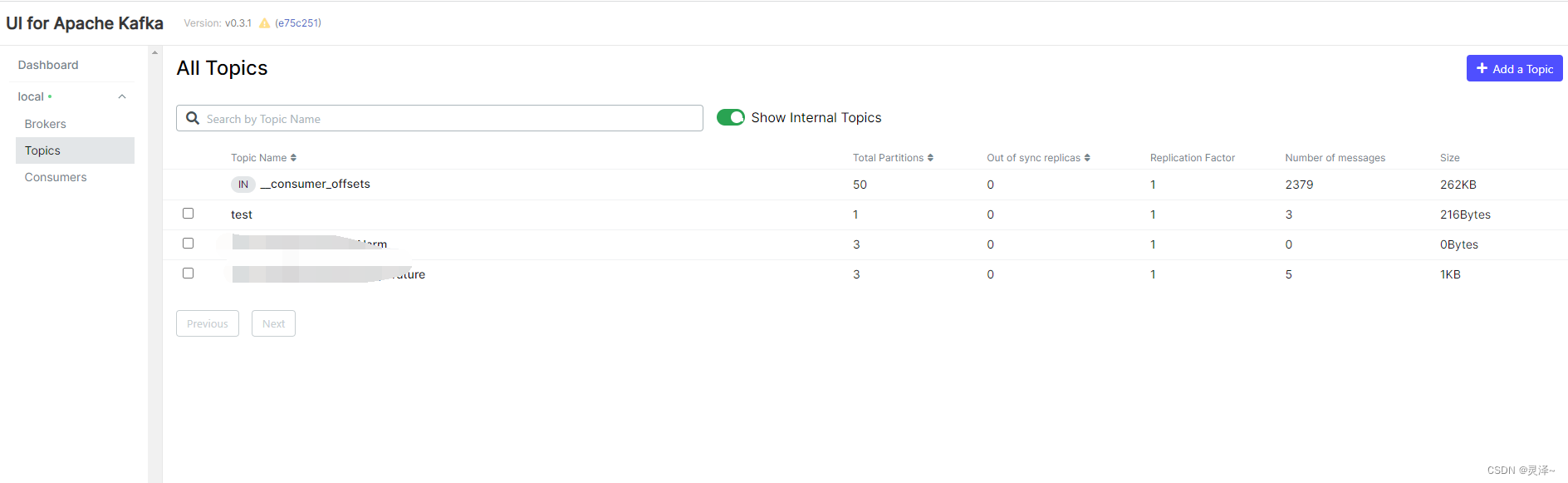

3. 混淆矩阵

1. 混淆矩阵是机器学习领域中用于精度评价的一种标准格式,也被称为误差矩阵。混淆矩阵的每一行代表一个真实的标签,每一列代表一个预测的标签。矩阵的对角线元素表示模型正确分类的实例数,非对角线元素则表示模型错误分类的实例数。

2.(1)TP+FP+TN+FN:样本总数。(2)TP+FN:实际正样本数。(3)TP+FP:预测结果为正样本的总数,包括预测正确的和错误的。(4)FP+TN:实际负样本数。(5)TN+FN:预测结果为负样本的总数,包括预测正确的和错误的。

4. 各自的计算公式

1. 准确率(accuracy)就是在全部预测中,正确预测结果所占的比例。计算公式为:

2. 精度(precision)就是在全部阳性预测中,正确预测结果所占的比例。比如,你预报了10次下雨,结果只下了3次,你的预报的精度就是 0.3,因为 TP = 3 , FP = 7。计算公式为:

3. 召回率(recall)就是在全部阳性事件中,正确预测结果所占的比例。比如,下了10次雨,结果你只正确预报了2次,你的预报的召回率就是 0.2,因为 TP = 2 , FN = 8 , P = 10。计算公式为:

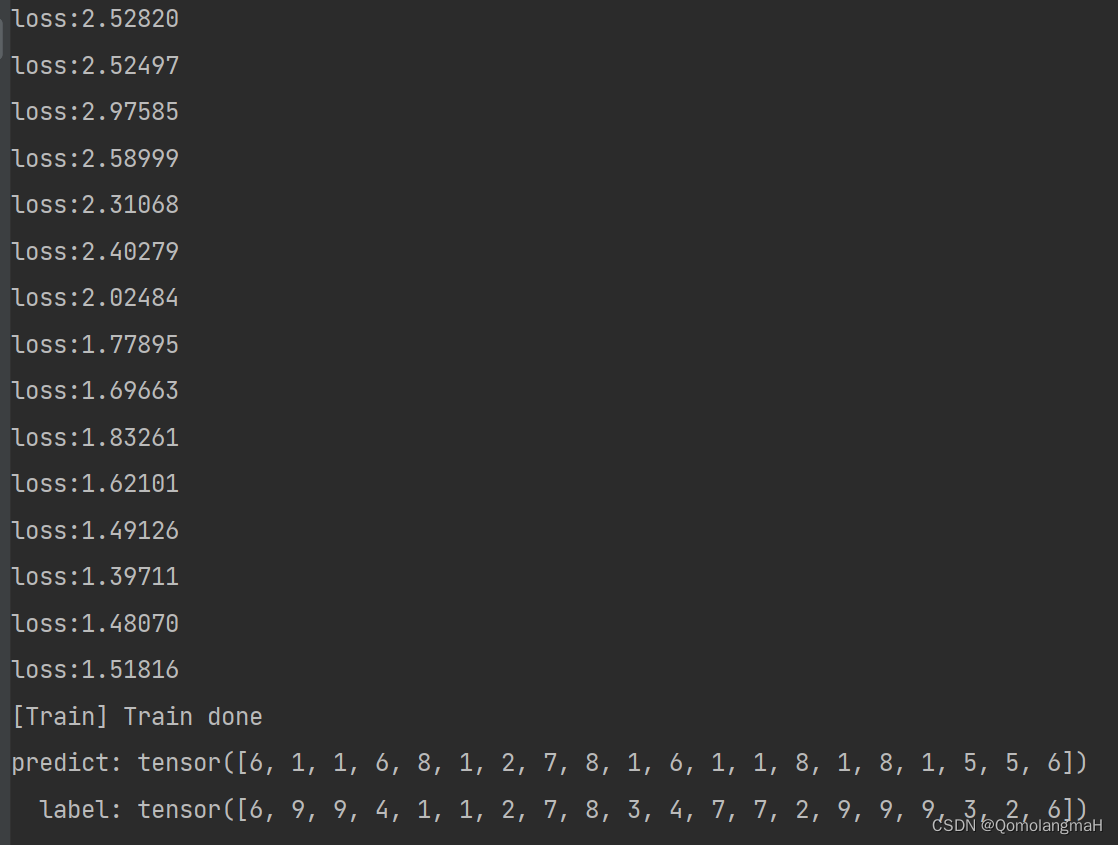

5. 例题应用

下面图片中的红色叉表示真实情况中的正例,蓝色圆圈表示真实情况中的反例。

1、答案:5、3、0、2、0.625、1.00

2、答案:4、2、1、3、0.67、0.80

3、答案:3、0、2、5、1.00、0.60

4、答案:0.60、0.60、0.60