每天给你送来NLP技术干货!

来自:HFL实验室

随着以ChatGPT为代表的生成式AI的火热,近期人工智能领域的顶级会议相继推出相关政策以进一步规范这类工具在科学文献撰写中的使用。ACL 2023程序委员会主席在近期的一篇博客中披露了ACL 2023大会的相关政策。

原文:ACL 2023 Policy on AI Writing Assistance

作者:ACL 2023 Program Chairs

地址:https://2023.aclweb.org/blog/ACL-2023-policy

点击这里进群—>加入NLP交流群

•••

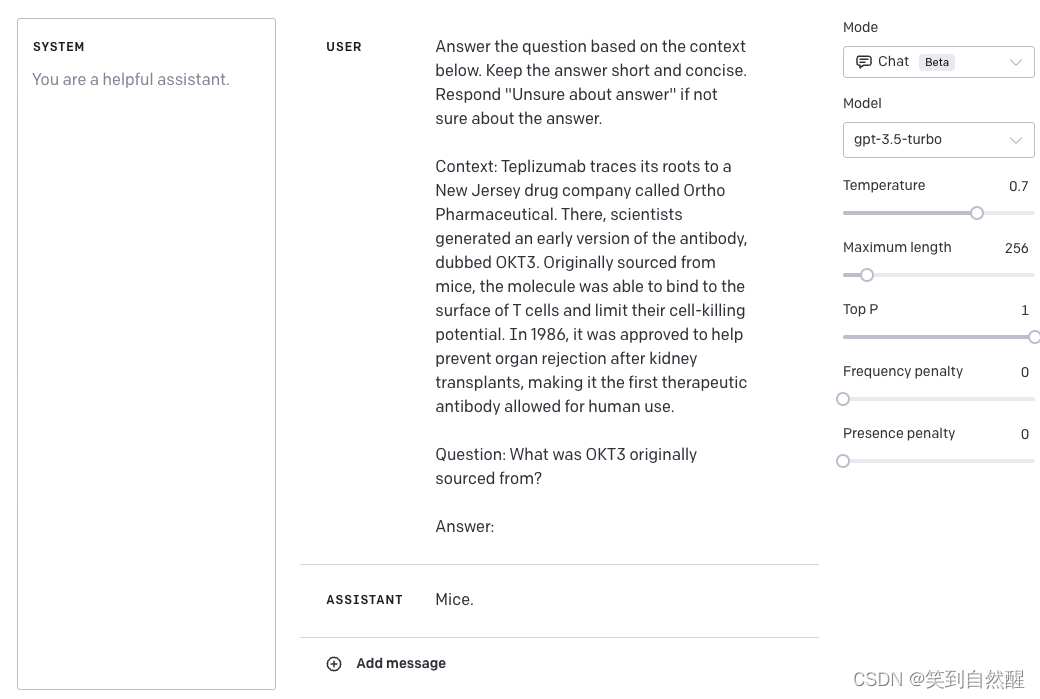

文本生成模型已成为文本输入方法(如联想词、语言检查等)的重要技术支撑。然而,近期的一些生成模型(例如chatGPT和Galactica)能够同时处理语言上和内容上的问题,也就是说它们能够处理和生成足够长的文本内容,使之看起来像是用户自己的创作内容。这项技术进展促使学校、期刊、会议(例如ICML)去进一步更新作者署名政策。

由于这些工具来自我们自己的领域(NLP),所以我们是处理和解决这些潜在问题的最适合的群体,这包括模型输出中的错误和模型训练数据源的抄袭问题。在会议中,审稿人志愿献出他们的时间来审稿,所以他们并不想额外花更多的时间去检查上述问题。此外,还有关于作者署名的问题:ACL通常希望稿件内容是署名作者以及承认贡献者的原创、未发表的工作。根据ACM抄袭定义,它不仅包括对他人作品的直接或近似复制,还包括故意复述他人作品的部分内容。

在与ACL执行委员会协商之后,ACL 2023在NAACL 2022的Resposible NLP Checklist基础上进一步添加了有关使用写作助手的问题。如果作者以任何方式使用了这些工具,作者必须详细说明使用的范围和性质。与其他关于提供代码、数据、补偿参与者以及获得IRB许可类似,这些问题并不是为了进行自动拒稿。与其他问题一样,这些问题的目的是让作者反思和建立研究规范。作者对清单中所有问题的回答都将会披露给审稿人,审稿人随后可根据相关信息进行伦理审查。为了进一步提高NLP研究对于公众的透明度,对于今年被录用的论文,在公开论文时将同时公开Responsible NLP Checklist(作为附录)。这与Nature期刊中的Reporting Summary相似。

•••

以下是关于近期社交媒体热议问题的对策(修改量和修改深度依次递增)。

LV1:纯粹用于论文的语言辅助

当生成模型用于重新表述或润色作者的原始内容,而不是为了提出新内容时,它们类似于Grammarly、拼写检查器、字典和同义词典等工具,多年来一直被完全接受。如果作者的语言水平不够流利,以至于无法注意到生成的内容与他们的预期不符,那么与其使用这些工具而不进行检查,倒不如直接使用简单准确的语言去叙述。使用像Grammarly或者拼写检查器这样只协助语言表述的工具是不需要显式说明的。

LV2:简短的输入协助

即使输入法中的联想词或者像谷歌文档中的智能编写功能同样是由生成式语言模型驱动的,但没有人反对使用它们。因为几乎没有人会尝试用它们来生成非常长、独特且连贯的文本,因为这种方式生成出来的文本根本不具备实用价值。与上面使用语言辅助工具类似,在回答该类工具相关问题时,不需要进行显式说明。

LV3:文献检索

文本生成模型可能被用作搜索助手,例如查找相关文献。然而,我们希望作者阅读和讨论这些参考文献,就像通过常规搜索引擎或语义文献推荐工具识别的参考文献一样。作者要注意引用的准确性和文献综述的全面性,并且要注意推荐引用中可能存在的偏差问题。

LV4:低创新性文本

有些作者可能认为描述广为人知的概念是浪费时间,可以通过自动化的方法完成。在这种情况下,作者应该说明使用了这种文本的位置,并说服审稿人他们检查了生成文本的准确性,并附有相关和适当的引用(例如,使用块引用以表示复制原文)。如果生成的文本是直接从现有工作复制的文本,作者需要合理地进行引用:这既是文本的来源也是思想的来源。

LV5:新思路

如果模型输出了新的研究思想,那么它们应该获得该项工作的共同作者或致谢。如果作者在这基础之上发展了这些理念(例如,讨论的主题、问题的框架),我们建议声明使用了这些模型,并检查这些思路的已知来源以声明和引用它们,这是因为很有可能这些思想来自其他人的工作。

LV6:新思路+新文本

我们认为同时提供思想和执行的贡献者符合共同作者的定义,而模型不能成为共同作者。虽然业界正在建立关于使用生成式AI的相关规范,我们不鼓励在ACL稿件中使用这种方法。如果你坚持认为这是合理的,你可以向审稿人证明这种操作的合理性,并且保证新内容的正确性、连贯性和原创性,并且没有漏引相关文献。需要注意的是,ICML同行指出:目前谁应该享有生成文本的相关权利是尚不清晰的,是模型的开发者,训练数据的原作者,还是生成文本的用户。

Extra:能用生成模型辅助写代码吗?

另外一个独立但相关的问题是借助生成模型写代码。ACL稿件可以附带源代码(被视为补充材料),审稿人不会被强制审阅这些材料,可以根据自己的需要去查看。使用代码助手(例如Copilot)也是一种新兴写代码的方式,并且相关准则还没有完全建立起来。当下,我们要求作者明确指出使用这些助手的范围,例如在README文件中进行备注。我们还要求作者去检查是否存在潜在的抄袭风险。需要注意的是Copilot现在正存在一项关于盗版的诉讼,并且可能向你推荐了不符合许可证的代码片段。代码助手的使用并不能免除作者确保其方法和结果正确性的要求。

HFL编辑部总结参考

关于AI辅助写作:

1、仅用于语法纠错、语言润色为目的时无需声明。

2、用于经典概念的描述、文献检索、提供新思路方面需要声明使用范围,且要确保相关表述是否来源于已有工作,注意相关引用。

3、ACL不鼓励完全使用AI助手生成新思路和新文本。

4、使用AI辅助生成代码,需要在代码描述文件中指出使用范围。

参考链接:

[1] https://icml.cc/Conferences/2023/llm-policy

[2] https://dl.acm.org/doi/abs/10.1145/3571730

[3] https://openreview.net/forum?id=TatRHT_1cK

[4] https://www.acm.org/publications/policies/plagiarism-overview

[5] https://aclrollingreview.org/responsibleNLPresearch

[6] https://www.nature.com/documents/nr-reporting-summary-flat.pdf

[7] https://www.techradar.com/news/microsoft-is-being-sued-over-github-copilot-piracy

最近文章深入理解Pytorch中的分布式训练点击这里进群—>加入NLP交流群

![[算法笔记]NPC问题证明sample](https://img-blog.csdnimg.cn/a2126d22b39d4e84b6a0a8b5f70c6160.png?x-oss-process=image/watermark,type_d3F5LXplbmhlaQ,shadow_50,text_Q1NETiBAQ3BsdXNfcnVsZXI=,size_20,color_FFFFFF,t_70,g_se,x_16)