训练数据

线性回归

基本原理

比如我们要买房,机器学习深度学习来预测房价。房价的影响因素有:卧室数量,卫生间数量,居住面积。此外,还需要加上偏差值来计算。我们要找到一个正确率高的计算方法来计算。

首先,我们需要有一个计算公式: y = w 1 x 1 + w 2 x 2 + w 3 x 3 + b y=w_1x_1+w_2x_2+w_3x_3+b y=w1x1+w2x2+w3x3+b ,w是权重,b是偏差值。w 和 b 的值需要我们自己选取最优解。

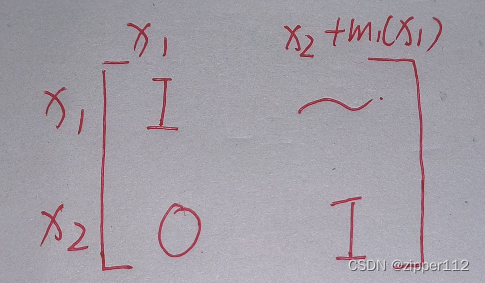

线性模型实现:输入 x 是一个 n*1 的向量,权重 w 是一个 n*1 的向量,b是一个标量。 y = < w , x > + b y=<w,x>+b y=<w,x>+b

这就可以看做一个简单的神经网络了。我们输入多个参数,神经网络处理后最终得到一个标量结果。

神经网络就像级联的神经元一样,每一个神经元是一层,进行一次处理,得到的参数再传递给下一层进行进一步处理。这个例子中层数比较少。

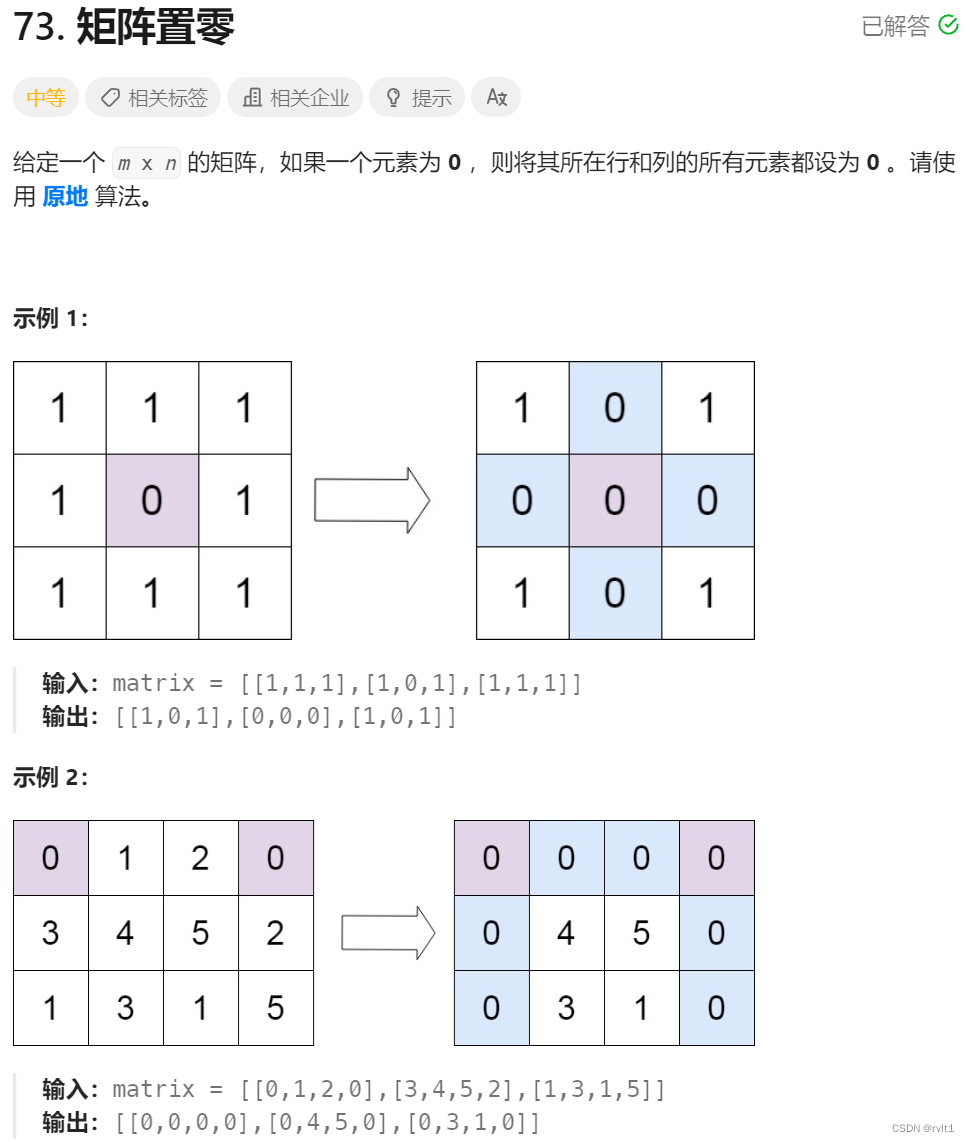

计算得到结果后,如何评价结果的质量?

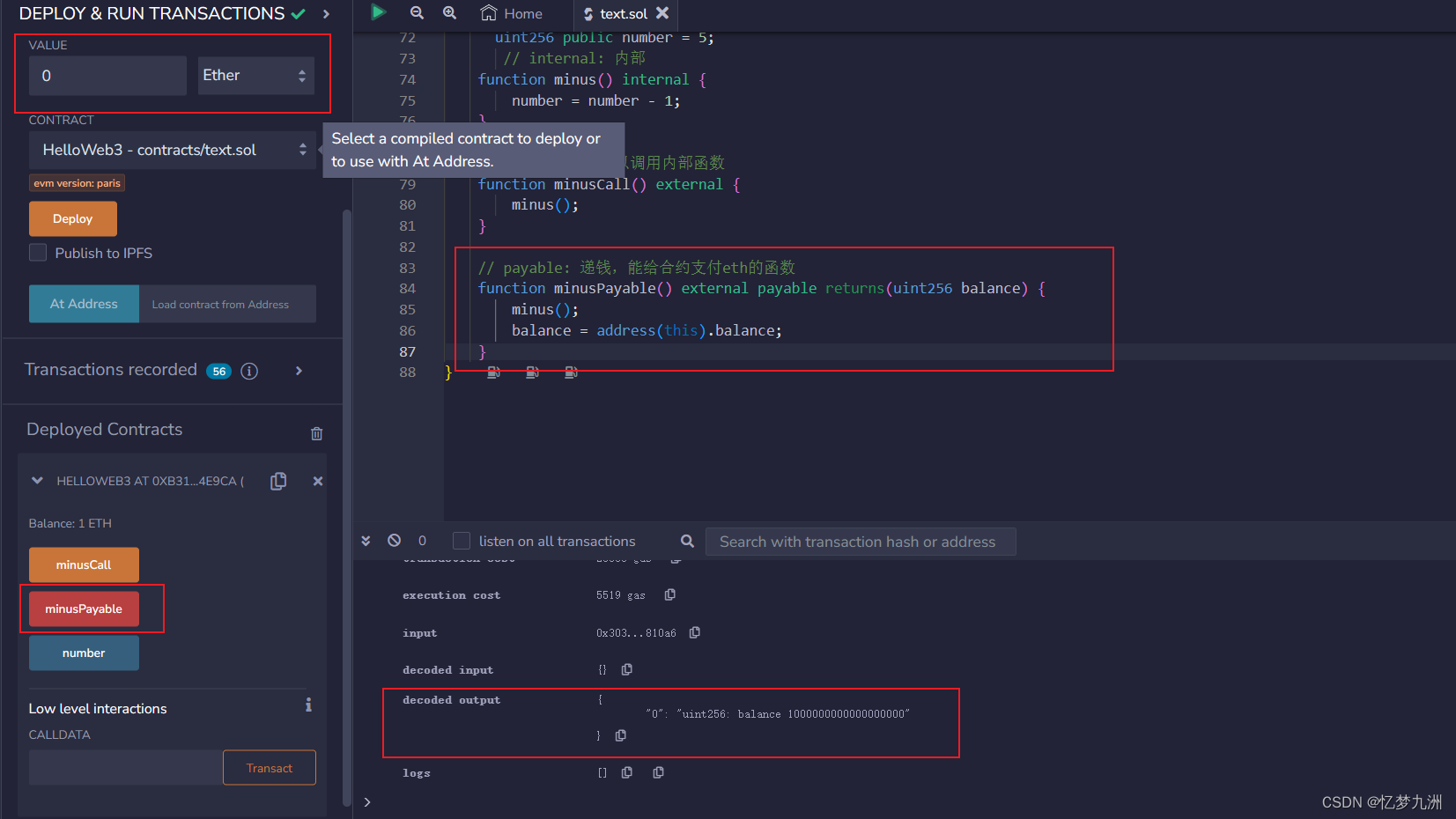

训练数据:结合计算公式和每次的 loss 反馈,得到 w 和 b 的最优解。

线性回归是一种可以得到显示解(就是确定的解,不像 y=x+C 这种包含未知部分的函数解)的单层神经网络,主要运用加权和偏差对 n 维输入进行处理,通过平方损失来衡量预测值和真实值的差异。

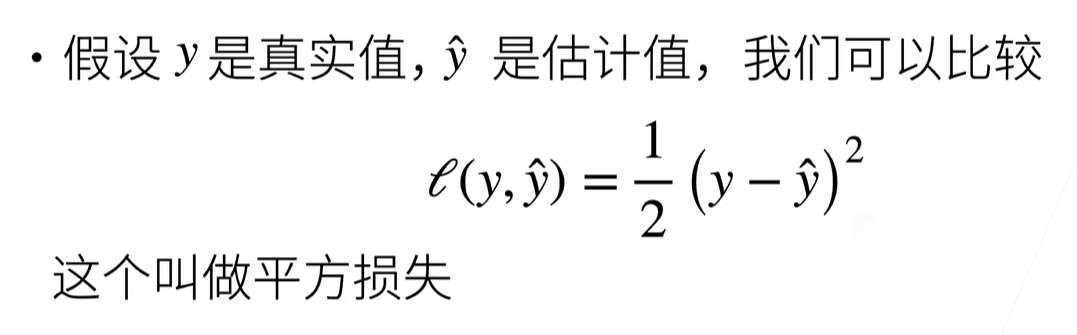

优化方法

具体是用什么样的方法对 w b 进行优化呢?

每次我们沿垂直于切线的方向,也就是求导方向,前进一个步长(学习率),因为沿着这个方向 w 的优化效率最高。

因此很容易联想到学习率步长是有一个合适的范围的,太长了一下子跳太远了。太短了要迭代太多次速度太慢。

另外,重新取点计算梯度值对于复杂模型来说其实是很耗时间的,可能几个小时以上。而且最小值可能不止一个,非要找到损失最小的样本点也很废算力。因此实际操作中一般是随机挑选几个样本点,一部分批量(batch)平均来计算梯度值(小批量随机梯度下降)。batchsize 太小,并行化计算无法完全发挥出来;太大,浪费计算。

实现

%matplotlib inline

import random

import torch

from d2l import torch as d2l# 生成人造数据集

def synthetic_data(w, b, num_examples): #@save"""生成y=Xw+b+噪声"""X = torch.normal(0, 1, (num_examples, len(w)))y = torch.matmul(X, w) + by += torch.normal(0, 0.01, y.shape) # 噪声return X, y.reshape((-1, 1)) # 列向量,-1 表示行数自己计算应该是多少。 # 我们人造数据集的参数。训练期望就是得到的 w 和 b 离我们的 true_w true_b 误差很小

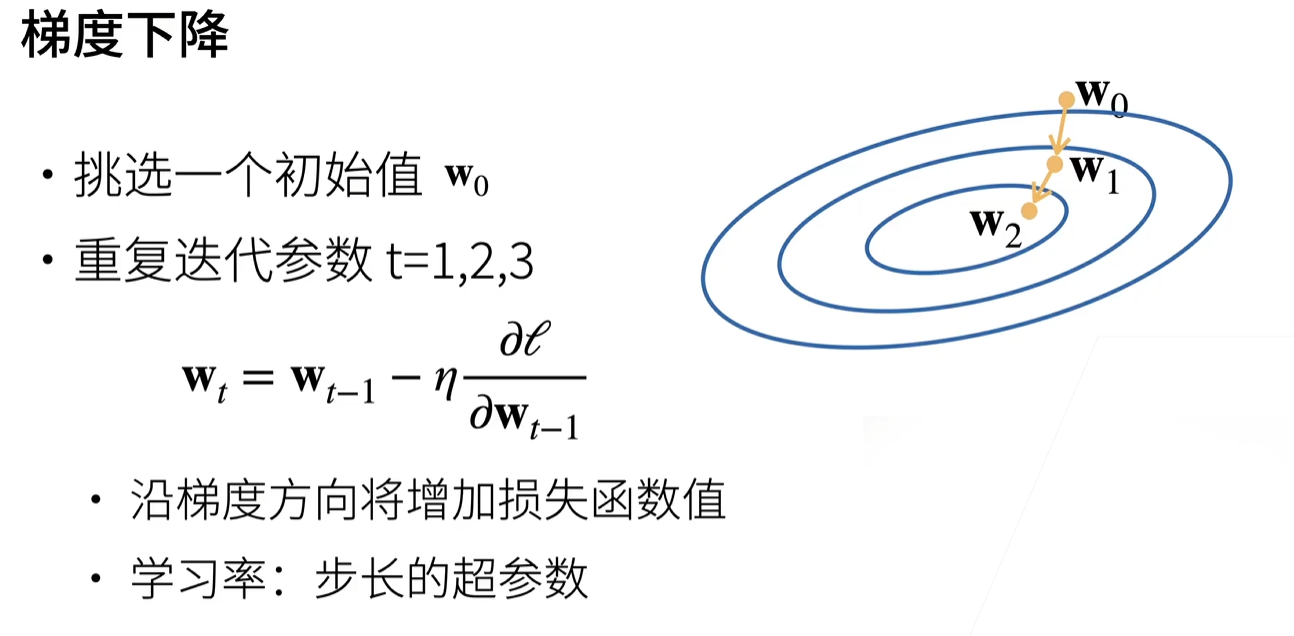

true_w = torch.tensor([2, -3.4])

true_b = 4.2

features, labels = synthetic_data(true_w, true_b, 1000)# 随机读取一批数据

def data_iter(batch_size, features, labels):num_examples = len(features)indices = list(range(num_examples))# 这些样本是随机读取的,没有特定的顺序random.shuffle(indices)for i in range(0, num_examples, batch_size):batch_indices = torch.tensor(indices[i: min(i + batch_size, num_examples)])yield features[batch_indices], labels[batch_indices]# 初始化模型参数,批量大小10,初始 wb 如下

batch_size = 10

w = torch.normal(0, 0.01, size=(2,1), requires_grad=True)

b = torch.zeros(1, requires_grad=True)def linreg(X, w, b): #@save"""线性回归模型"""return torch.matmul(X, w) + bdef squared_loss(y_hat, y): #@save"""均方损失"""return (y_hat - y.reshape(y_hat.shape)) ** 2 / 2def sgd(params, lr, batch_size): #@save"""小批量随机梯度下降优化函数"""with torch.no_grad():for param in params:param -= lr * param.grad / batch_size # 损失函数那里没有归一化,这里归一化param.grad.zero_()lr = 0.03 # 学习率

num_epochs = 3 # 优化计算重复3次

net = linreg # 网络模型

loss = squared_loss # 损失。这样写后面直接改参数很方便for epoch in range(num_epochs):for X, y in data_iter(batch_size, features, labels):l = loss(net(X, w, b), y) # X和y的小批量损失# 因为l形状是(batch_size,1),而不是一个标量。l中的所有元素被加到一起,# 并以此计算关于[w,b]的梯度l.sum().backward()sgd([w, b], lr, batch_size) # 使用参数的梯度更新参数with torch.no_grad():train_l = loss(net(features, w, b), labels)print(f'epoch {epoch + 1}, loss {float(train_l.mean()):f}')# output:loss 代表每一次循环 wb 的均方损失

epoch 1, loss 0.038786

epoch 2, loss 0.000152

epoch 3, loss 0.000048# 和我们自己生成的真正的数据参数比较,来看训练准确性:

print(f'w的估计误差: {true_w - w.reshape(true_w.shape)}')

print(f'b的估计误差: {true_b - b}')

# output:

w的估计误差: tensor([0.0003, 0.0003], grad_fn=<SubBackward0>)

b的估计误差: tensor([-0.0002], grad_fn=<RsubBackward1>)

简洁实现

由于数据迭代器、损失函数、优化器和神经网络层很常用, 现代深度学习库也为我们实现了这些组件。

首先,生成数据集部分是一样的。

import numpy as np

import torch

from torch.utils import data

from d2l import torch as d2ltrue_w = torch.tensor([2, -3.4])

true_b = 4.2

features, labels = d2l.synthetic_data(true_w, true_b, 1000)

读取数据集不用自己定义一个随机读取函数:

def load_array(data_arrays, batch_size, is_train=True): #@save"""构造一个PyTorch数据迭代器"""dataset = data.TensorDataset(*data_arrays)return data.DataLoader(dataset, batch_size, shuffle=is_train)batch_size = 10

data_iter = load_array((features, labels), batch_size)

用法可以和前面的复杂实现一样,for X, y in data_iter 。我们也可以用 iter 构造迭代器,用 next 迭代。next(iter(data_iter)) 获取第一项。

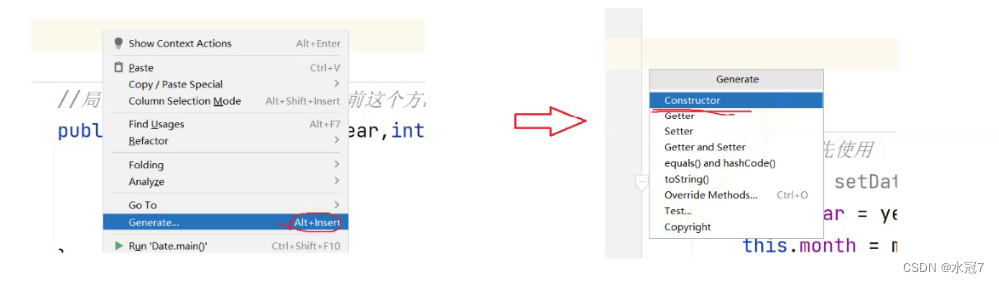

模型也可以直接利用深度学习框架预先定义好的层,没有必要自己写。

Sequential 将多个层串联到一起。其实我们这个简单例子只用到了一个层,但是还是使用 Sequential 定义一下来熟悉一波流程。首先我们定义 Sequential 的输入输出,然后给 Sequential 内部具体的层进行配置。

# nn是神经网络的缩写

from torch import nnnet = nn.Sequential(nn.Linear(2, 1))net[0].weight.data.normal_(0, 0.01) # 输入层权重参数的正态分布

net[0].bias.data.fill_(0) # 偏置参数的初始值

损失函数使用 MSELoss L2 范式返回所有样本损失的平均值。

loss = nn.MSELoss()

优化算法:采用小批量优化算法,给定参数和学习率,参数从 net.parameter 中可以直接获取。

trainer = torch.optim.SGD(net.parameters(), lr=0.03)

训练:

num_epochs = 3

for epoch in range(num_epochs):for X, y in data_iter:l = loss(net(X) ,y)trainer.zero_grad()l.backward()trainer.step()l = loss(net(features), labels)print(f'epoch {epoch + 1}, loss {l:f}')

误差:

w = net[0].weight.data

print('w的估计误差:', true_w - w.reshape(true_w.shape))

b = net[0].bias.data

print('b的估计误差:', true_b - b)

我的输出:

epoch 1, loss 0.000201

epoch 2, loss 0.000103

epoch 3, loss 0.000103

w的估计误差: tensor([-0.0004, 0.0003])

b的估计误差: tensor([0.0003])

![[自学记录08*]LDR、HDR与ToneMapping](https://img-blog.csdnimg.cn/4eb14a68616340a186d801650c81be20.png)

![[MICROSAR Adaptive] --- Hello Adaptive World](https://img-blog.csdnimg.cn/4455584816014653a92c1ee87af203d7.png)