文章目录

- 1. Bert 介绍

- 2. 代码示例

- 2.1 代码流程

1. Bert 介绍

2. 代码示例

from transformers import AutoTokenizertokenizer = AutoTokenizer.from_pretrained("bert-base-chinese")

input_ids = tokenizer.encode('欢迎来到Bert世界', return_tensors='tf')

print(input_ids)

输出内容:

tf.Tensor([[ 101 3614 6816 3341 1168 100 686 4518 102]], shape=(1, 9), dtype=int32)

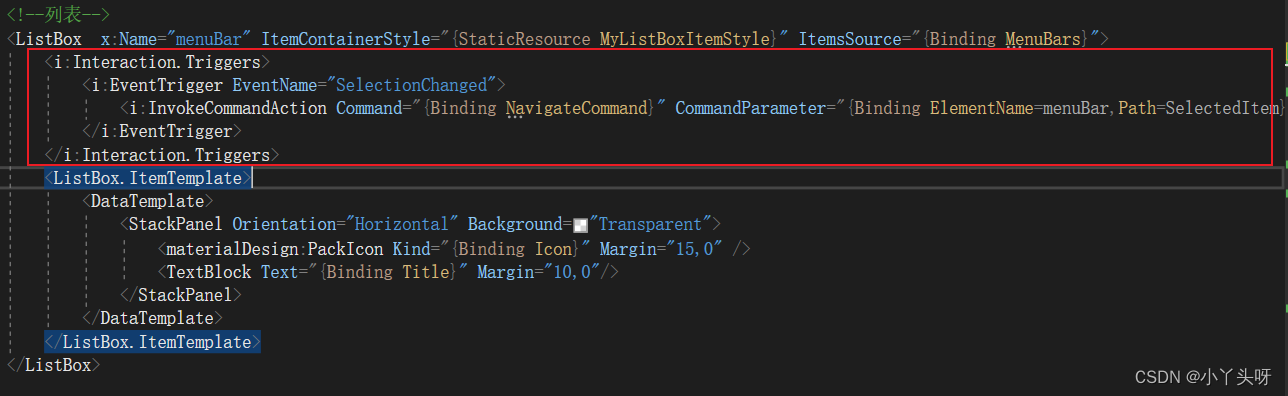

2.1 代码流程

代码片段涉及到了使用transformers库来加载一个预训练的BERT模型的分词器,并用它来对一段文本进行编码。以下是整体流程和目的的分步说明:

-

导入AutoTokenizer类:

from transformers import AutoTokenizer这行代码导入了transformers库中的AutoTokenizer类。这个类可以自动检测并加载与给定模型相对应的分词器(tokenizer)。 -

加载分词器:

tokenizer = AutoTokenizer.from_pretrained("bert-base-chinese")这行代码创建了一个分词器的实例。from_pretrained方法用于加载预先训练好的分词器,这里是"bert-base-chinese",专门为中文文本设计的BERT模型的分词器。 -

文本编码:

input_ids = tokenizer.encode('欢迎来到Bert世界', return_tensors='tf')这行代码用分词器将提供的中文字符串'欢迎来到Bert世界'转换成BERT模型能够理解的输入格式,即一系列的数字ID。每个ID对应原始文本中的一个词或子词单位。return_tensors='tf'指定返回的格式为TensorFlow张量。 -

打印输出:

print(input_ids)这行代码输出编码后的input_ids。这个输出是用于后续的模型预测或者微调过程的输入。tf.Tensor([[ 101 3614 6816 3341 1168 100 686 4518 102]], shape=(1, 9), dtype=int32)

目的:

这段代码的主要目的是为了准备数据,将自然语言文本转换为BERT模型可以接受的格式,这是使用BERT模型进行任务(如分类、问答等)前的标准步骤。