| 时间 | 版本 | 修改人 | 描述 |

|---|---|---|---|

| 2023年11月13日14:02:14 | V0.1 | 宋全恒 | 新建文档 |

| 2023年11月13日19:05:29 | V0.2 | 宋全恒 | 完成 大白话讲解卷积神经网络的学习 |

简介

为了深入理解CNN,进行B站 同济子豪兄深度学习之卷积神经网络的学习.

主要内容

P1卷积与卷积神经网络

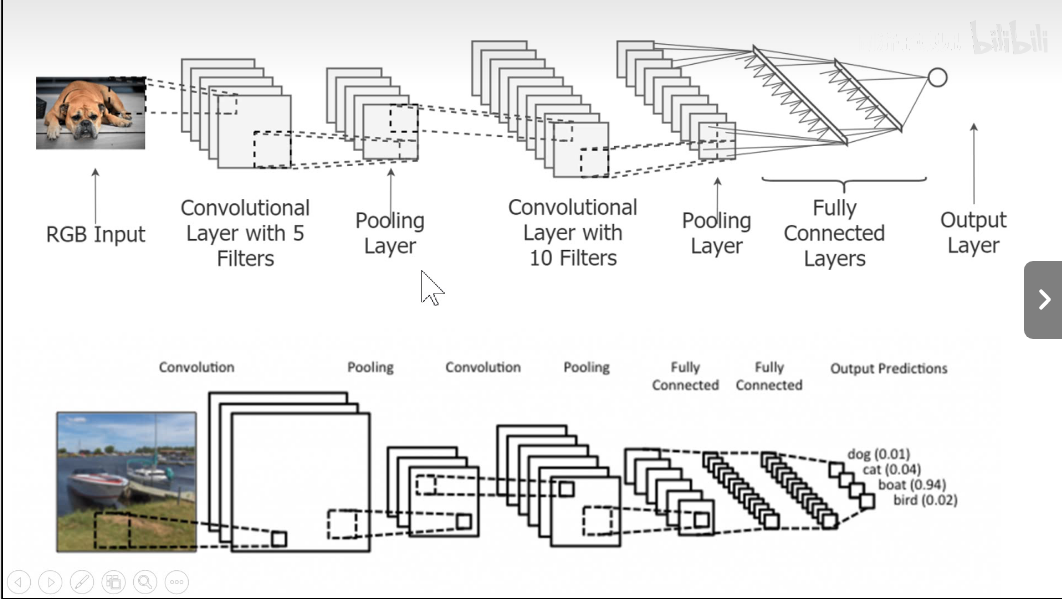

所有的分类神经网络是大同小异的。

- 卷积层

- 池化层

softmax, sigmoid

卷积的基本操作

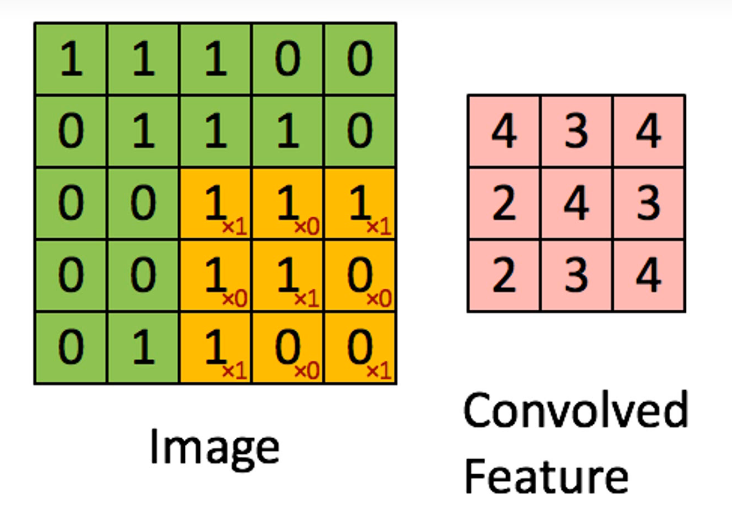

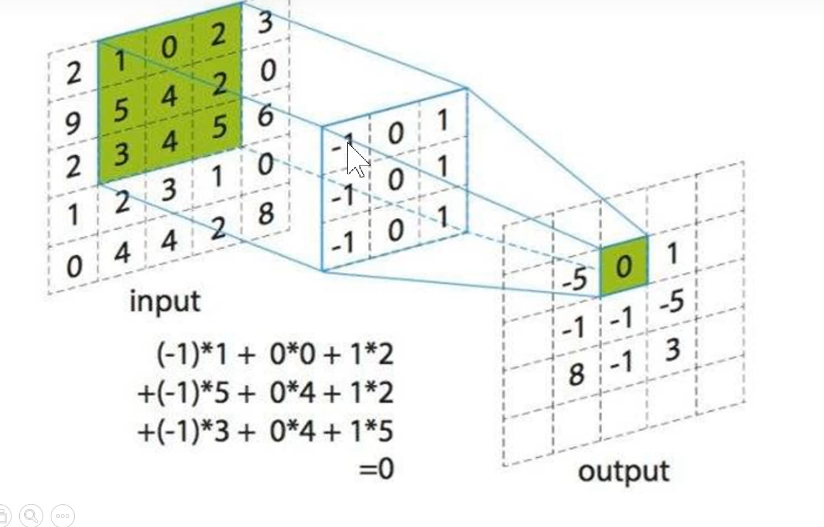

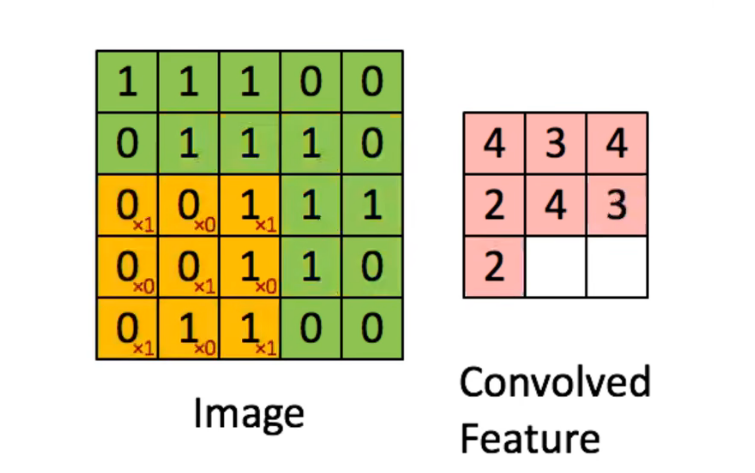

黄色的数字不变,代表kernel, 3 x 3的核,原始图像进行滑动。 进行加权和提取特征。卷积核看到的地方就是感受野。

卷积核工作方式

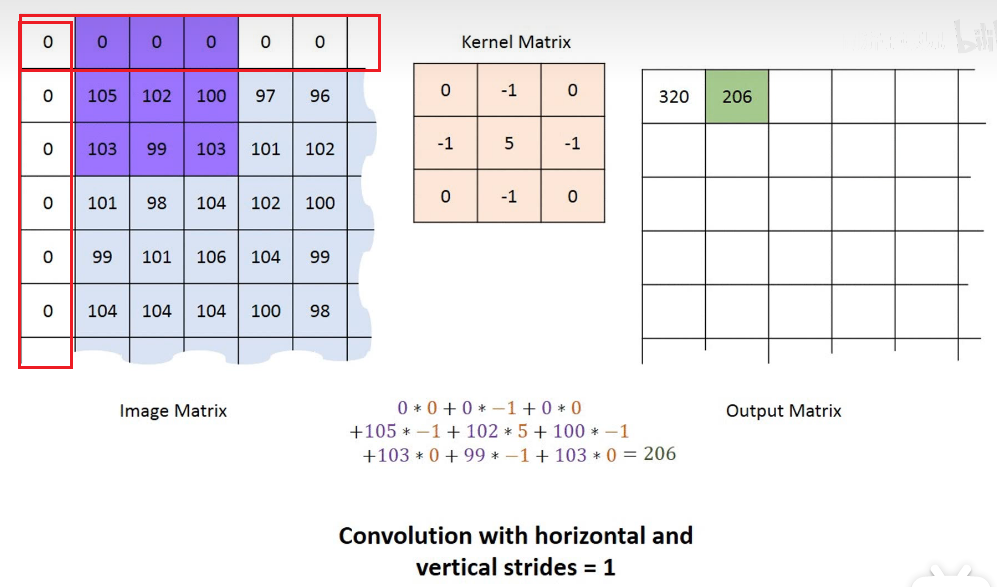

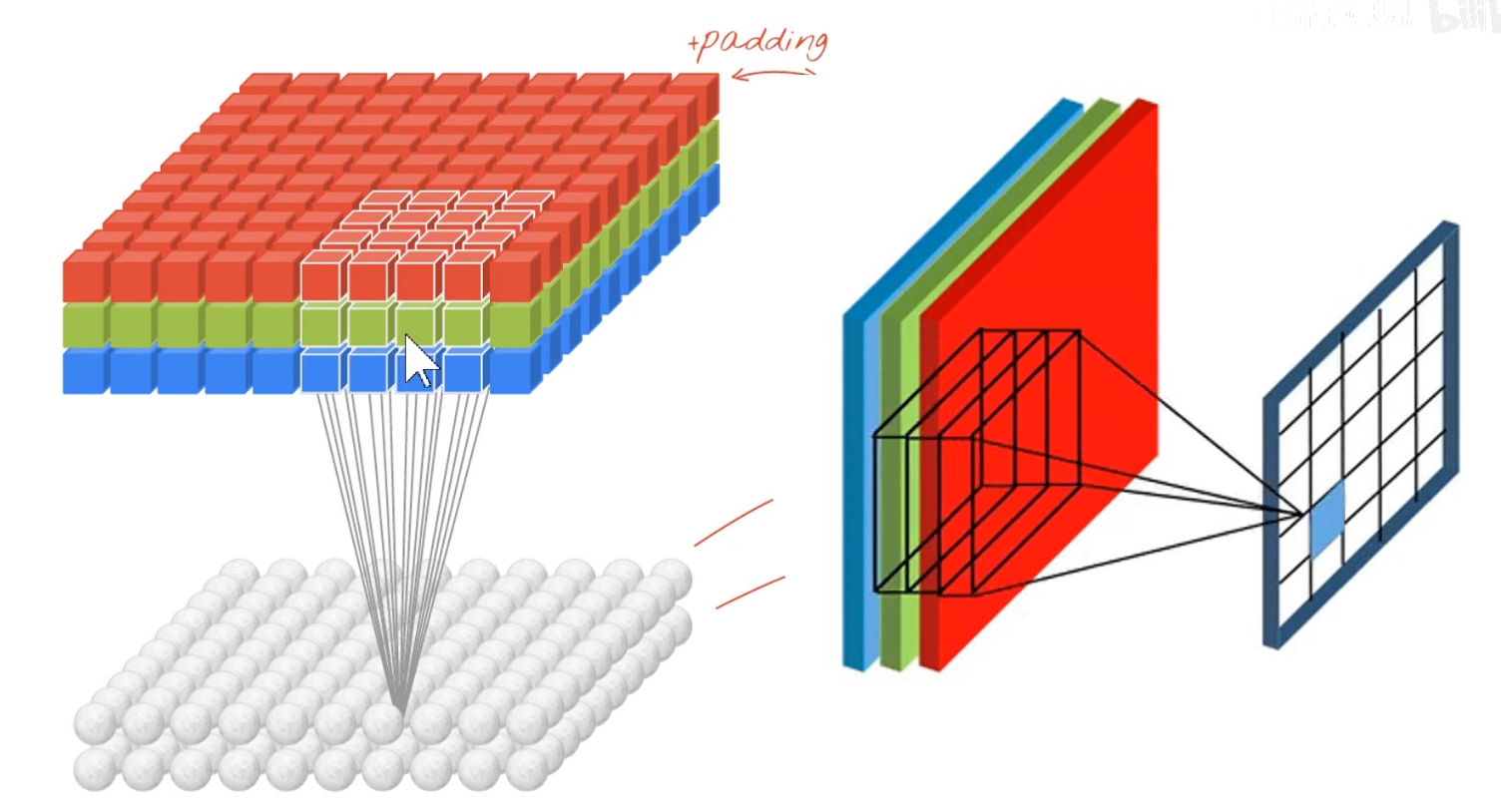

为什么要在边上补充0呢?为了放置边缘像素丢失。在外圈补0,可以让边缘的像素呗关注到。

经过卷积之后得到feature map,特征图。

每个图像经过一个卷积核进行卷积之后得到一个特征图。如果图像是三个通道,那么卷积核也是一个深度为3的图像。

P2卷积中各种参数的交互式演示

卷积的动作示意图参见

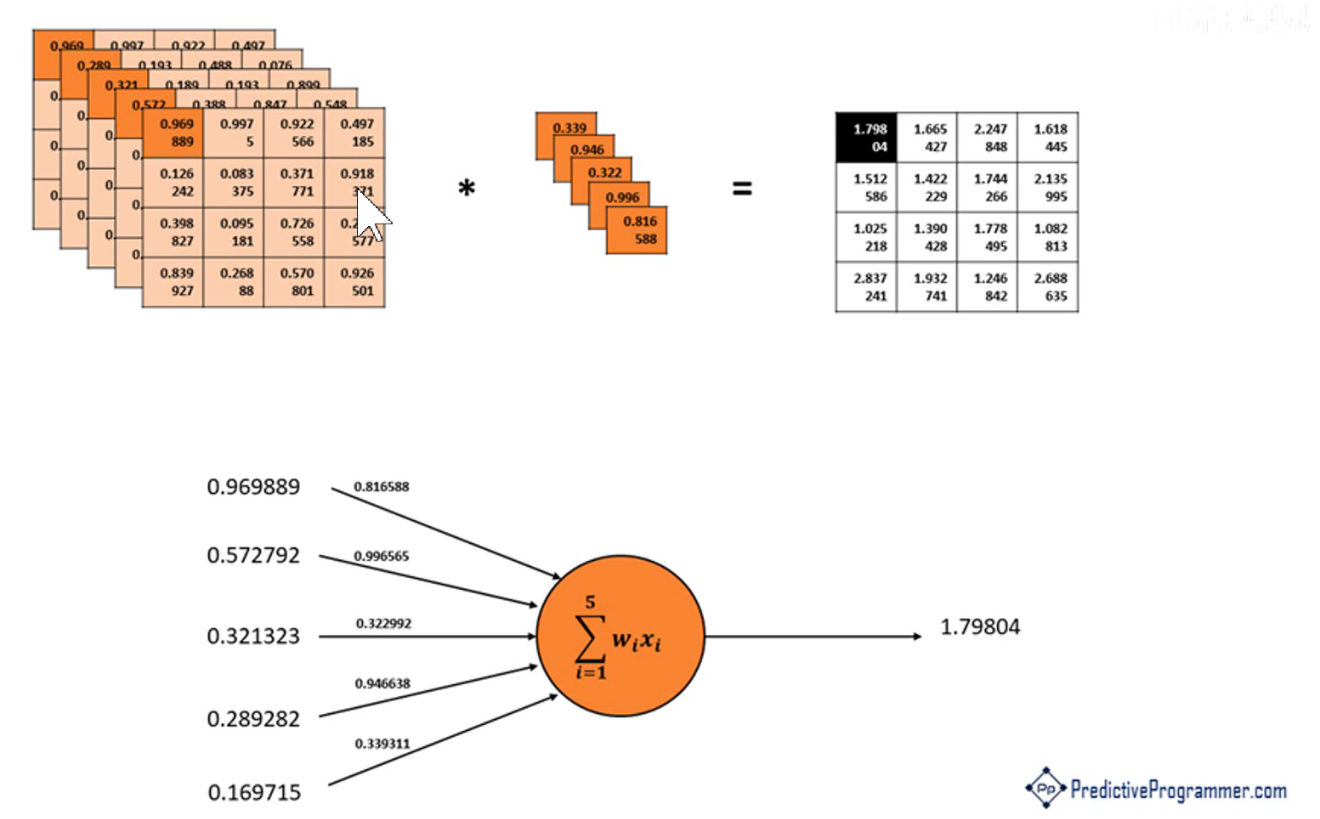

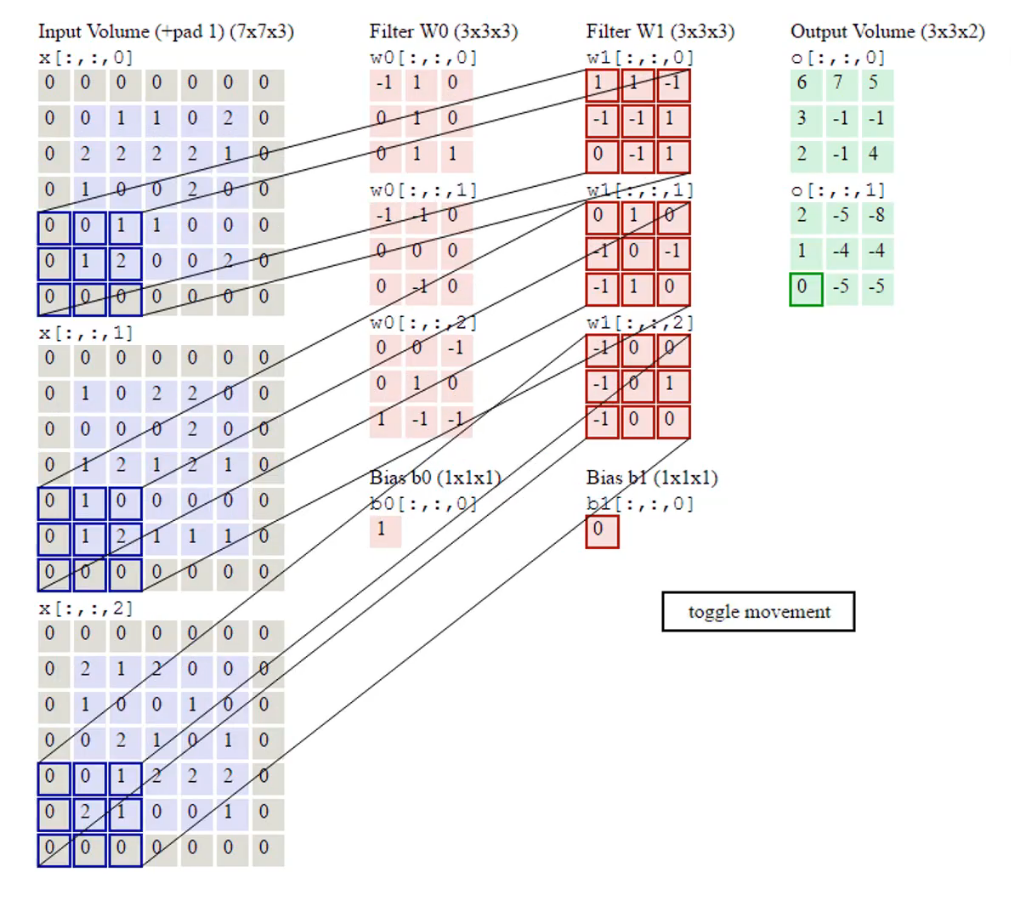

下个图演示了两个卷积核操作:

有多少个卷积核,就有多少个feature map.

每一个卷积核,就得到一个特征图。然后将所有的特征map进行池化。

下图演示了经过1*1卷积核,把4个通道压缩成了一个平面。

可以看到,每个卷积核操作之后得到都是一个单通道的图像。下图中出现了偏置项,是一个变量,维度与卷积核数量相同。

P3多通道图像的卷积

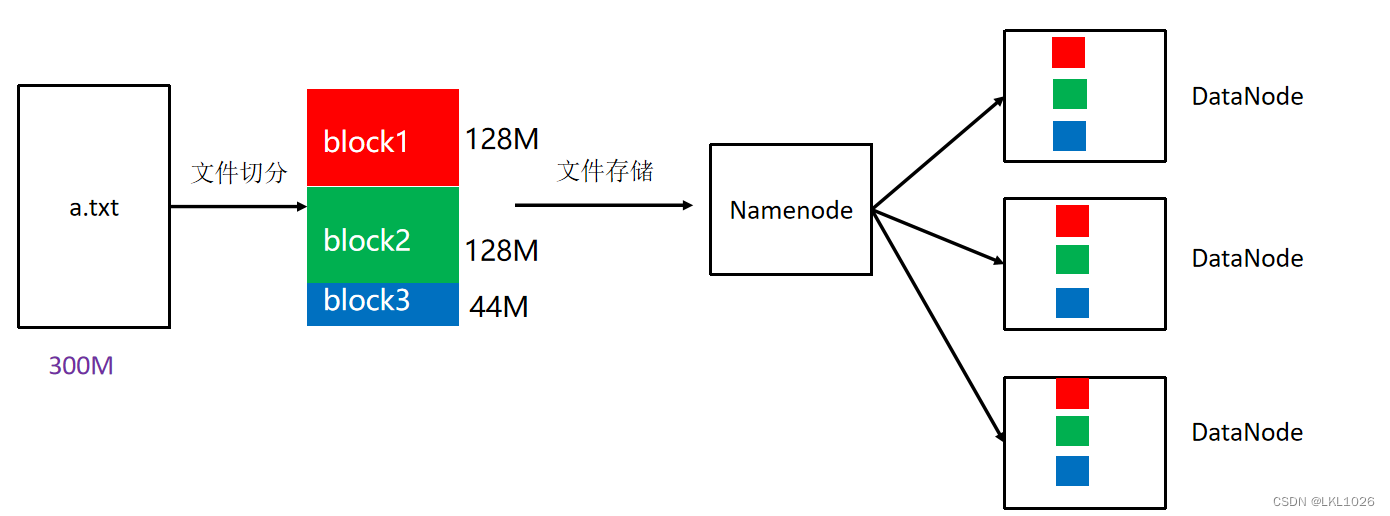

下图演示了,使用3 * 3 * 3得到了一个特征图 4 * 4 * 1

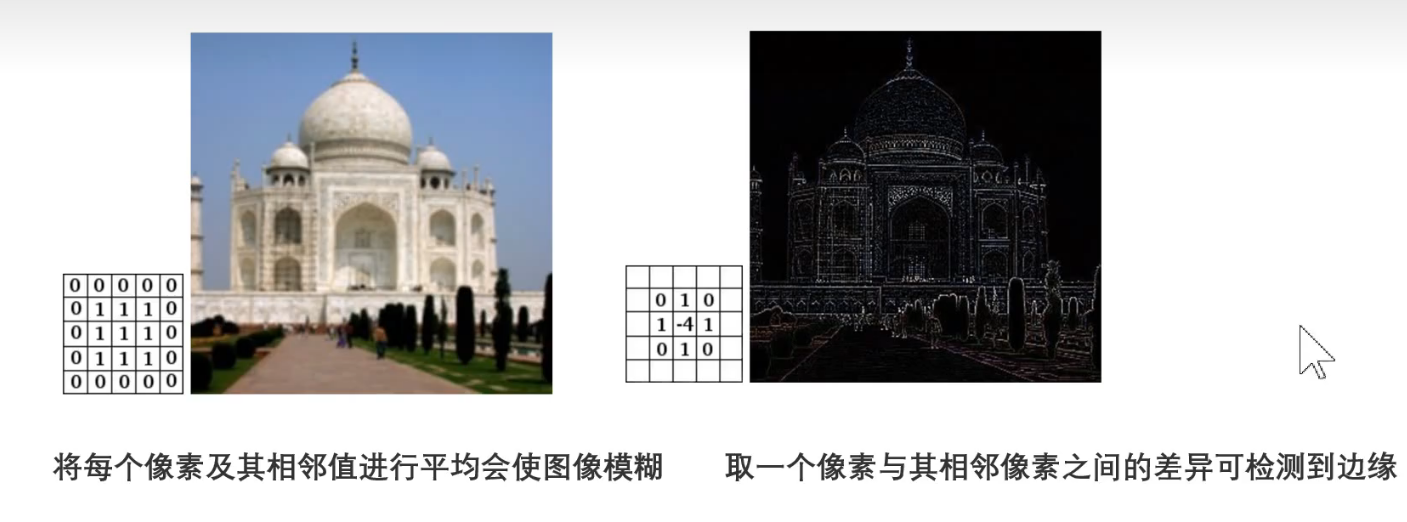

不同的卷积核作用不同:

P4直观理解多通道图像卷积

多通道卷积的示意可以参考 3D图像

三维通向的卷积核也是三维的立方体,而经过卷积之后得到特征图

是一个平面,变成一个平面。可以理解,特征图为从原图抽取的特征。卷积核的大小(

深度)与原图(深度)相同

P5池化层与全连接层

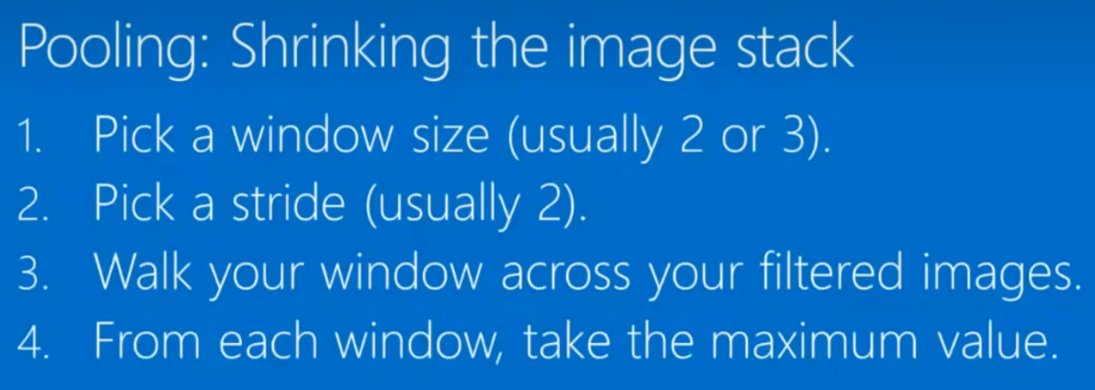

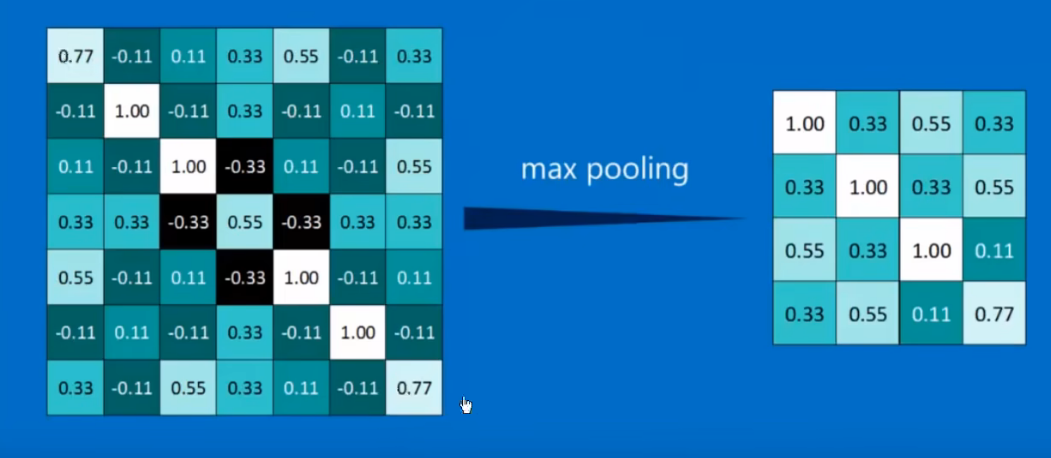

卷积特征(Convolved feature)和池化特征(Pooled feature),可以认为池化特征更加高维,和抽象。

池化又称为降采样。可以大而化之的减少特征。

池化的作用

池化的作用:

- 减少参数量

- 防止过拟合

将池化之后的特征拉平成一个长向量。

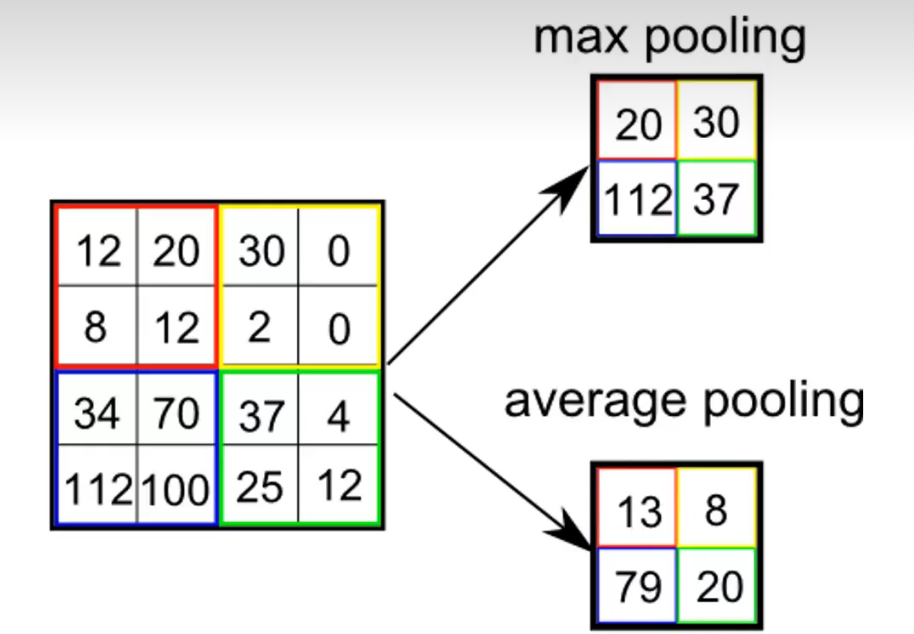

池化的方式

下图给出了池化的两种方式:

P6卷积神经网络各层的作用

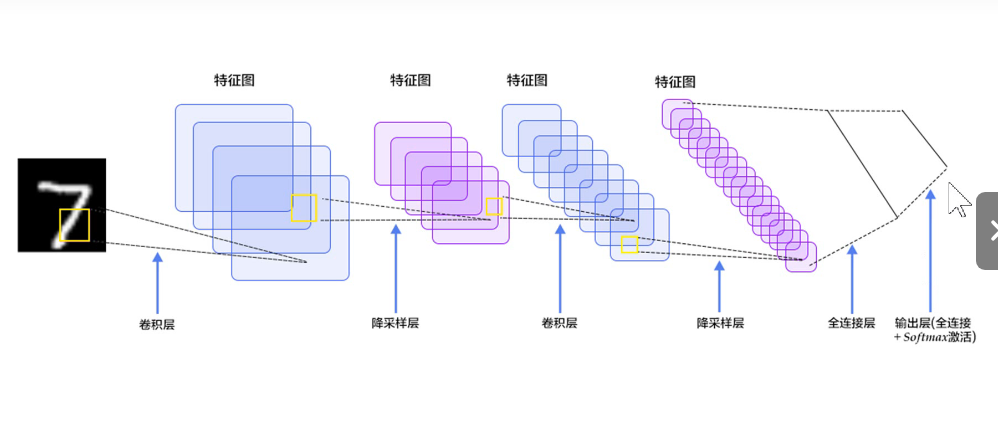

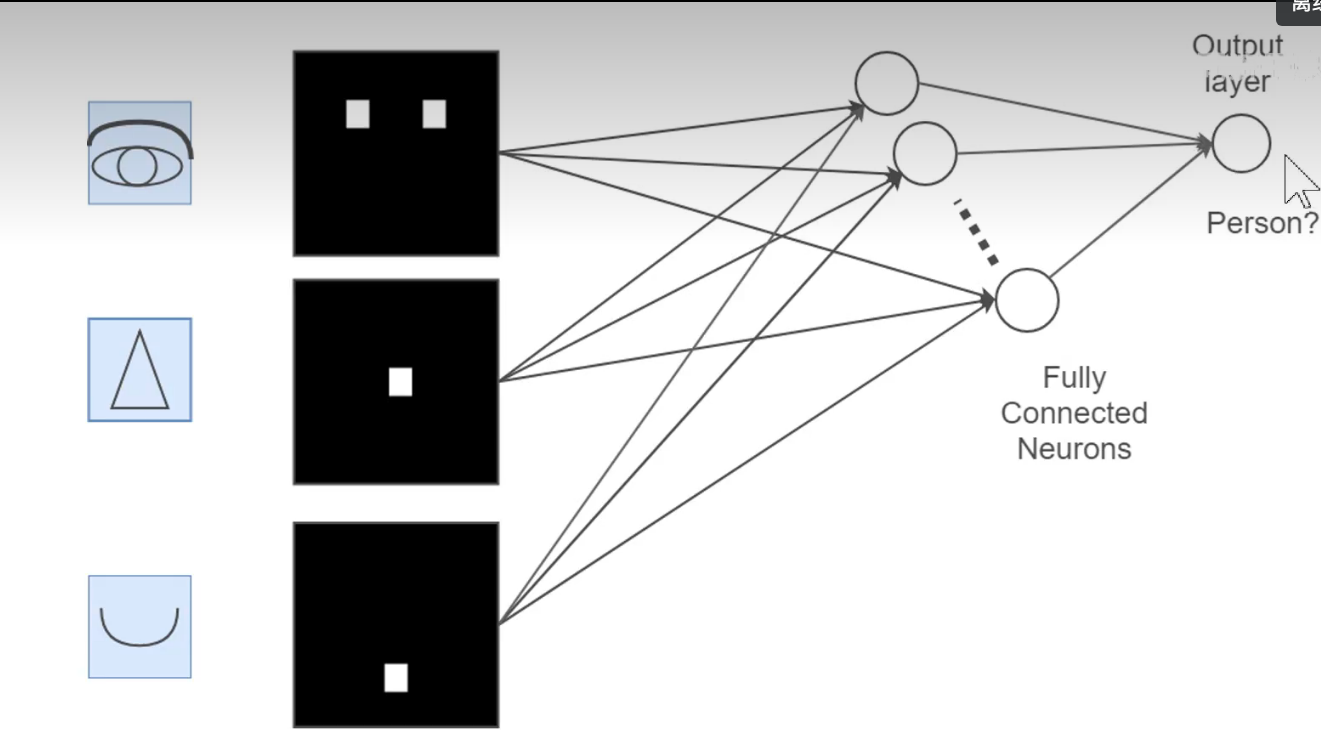

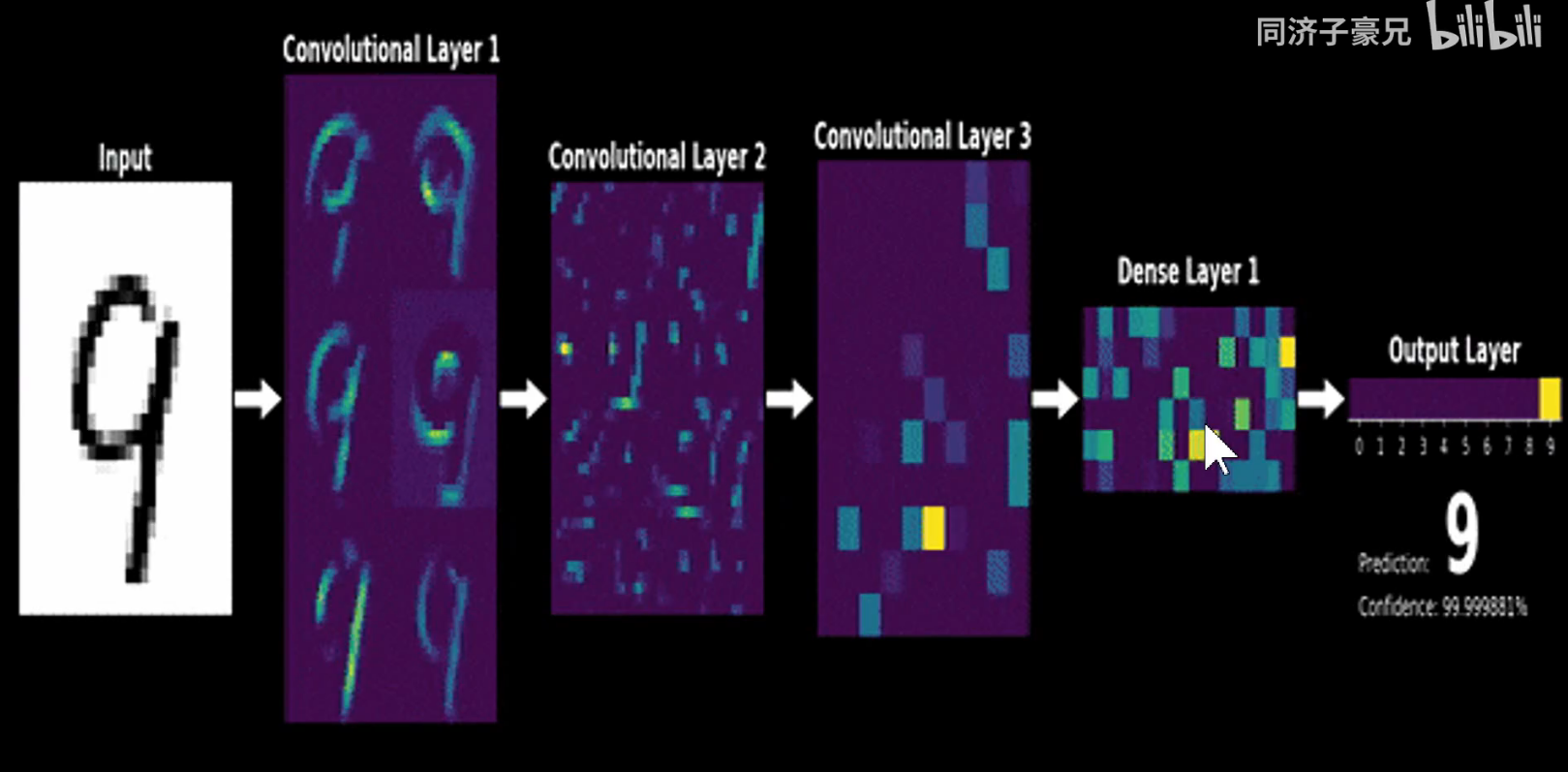

卷积神经网络的整体结构示意如:

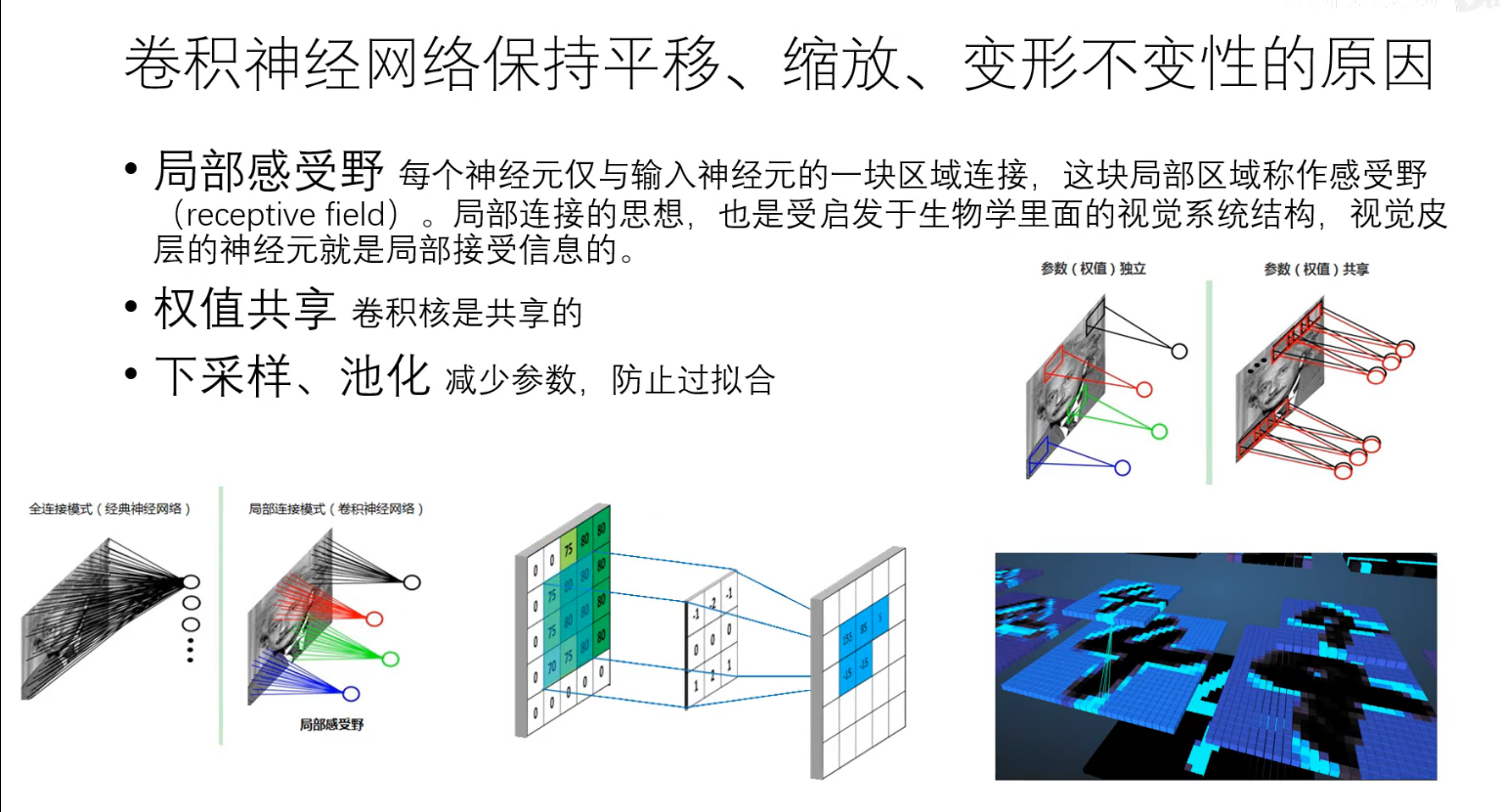

卷积神经网络有平移不变性。而池化是平移不变性的根源。

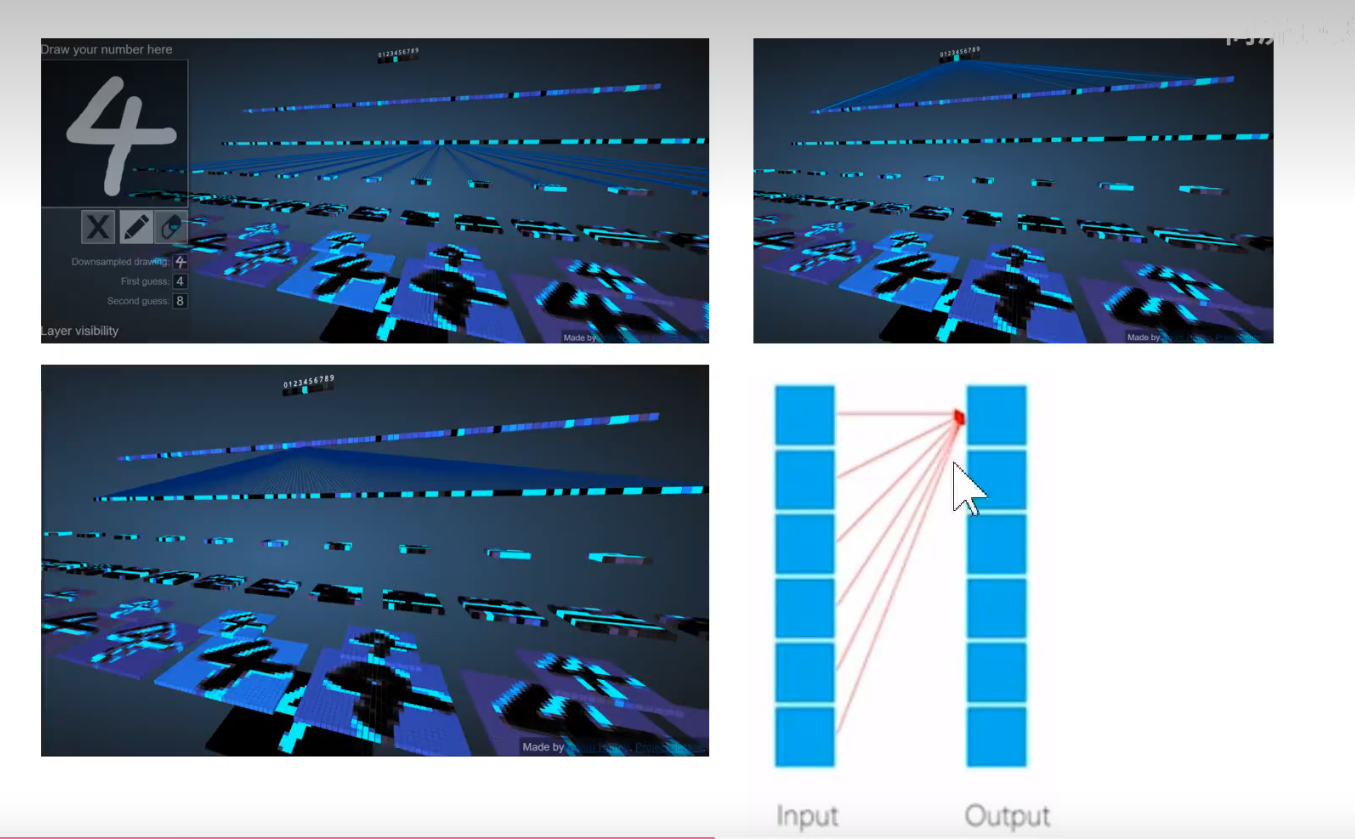

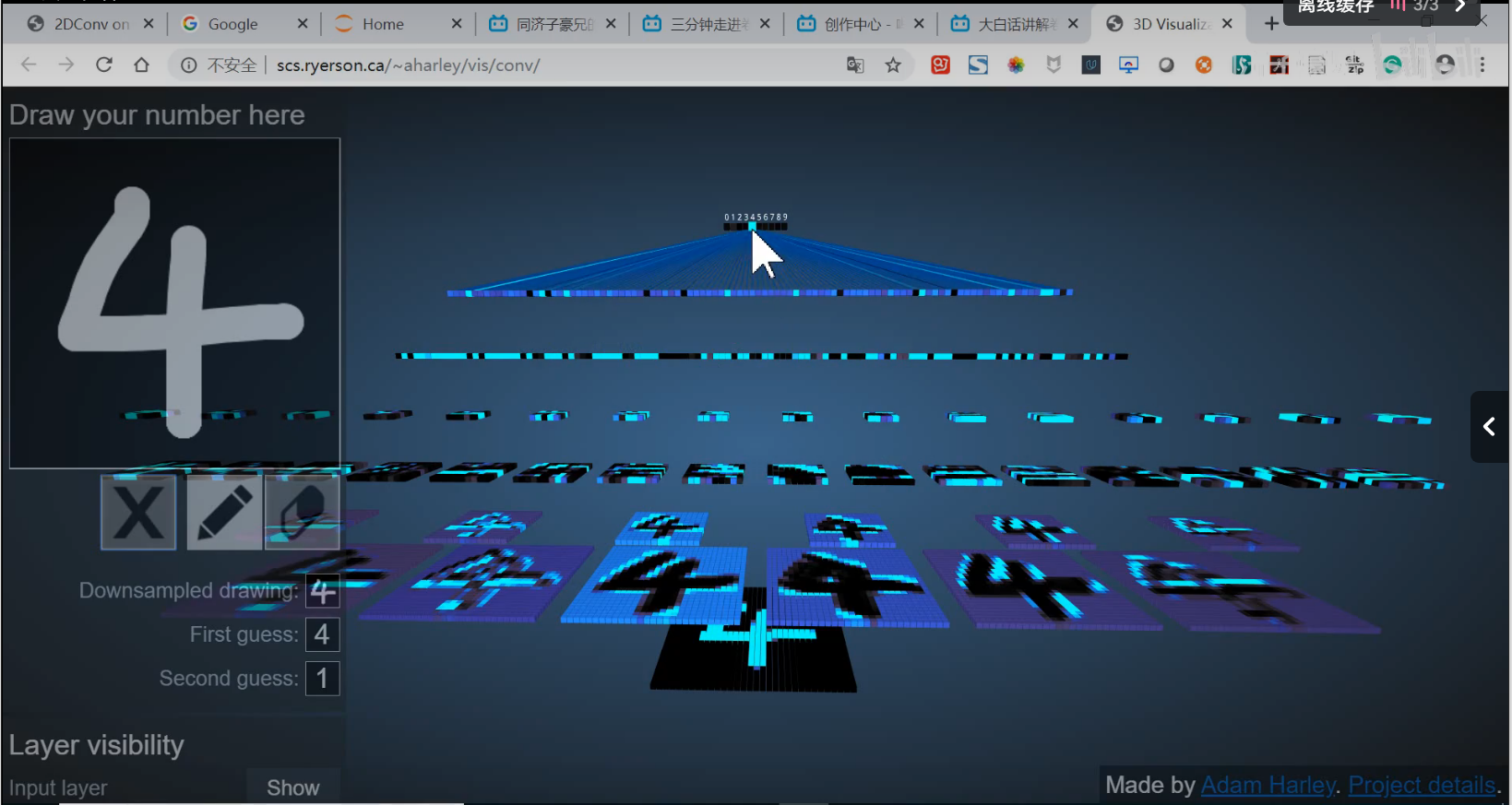

P7在线交互式卷积神经网络演示-手写数字识别

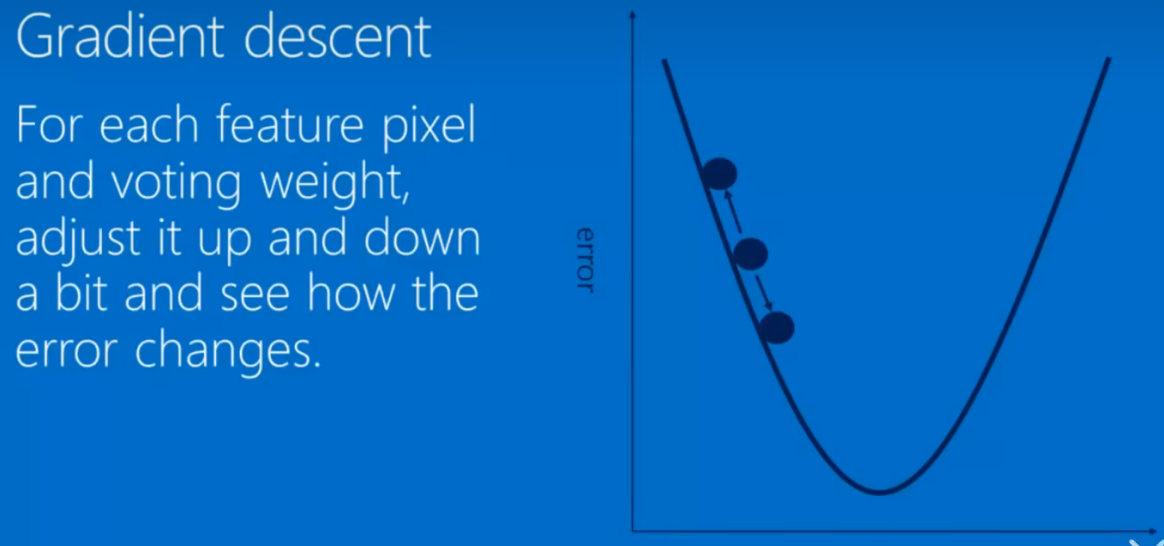

卷积核是由大量的样本经过反向传播,梯度下降学习,迭代产生的。最后使得分类非常准确。

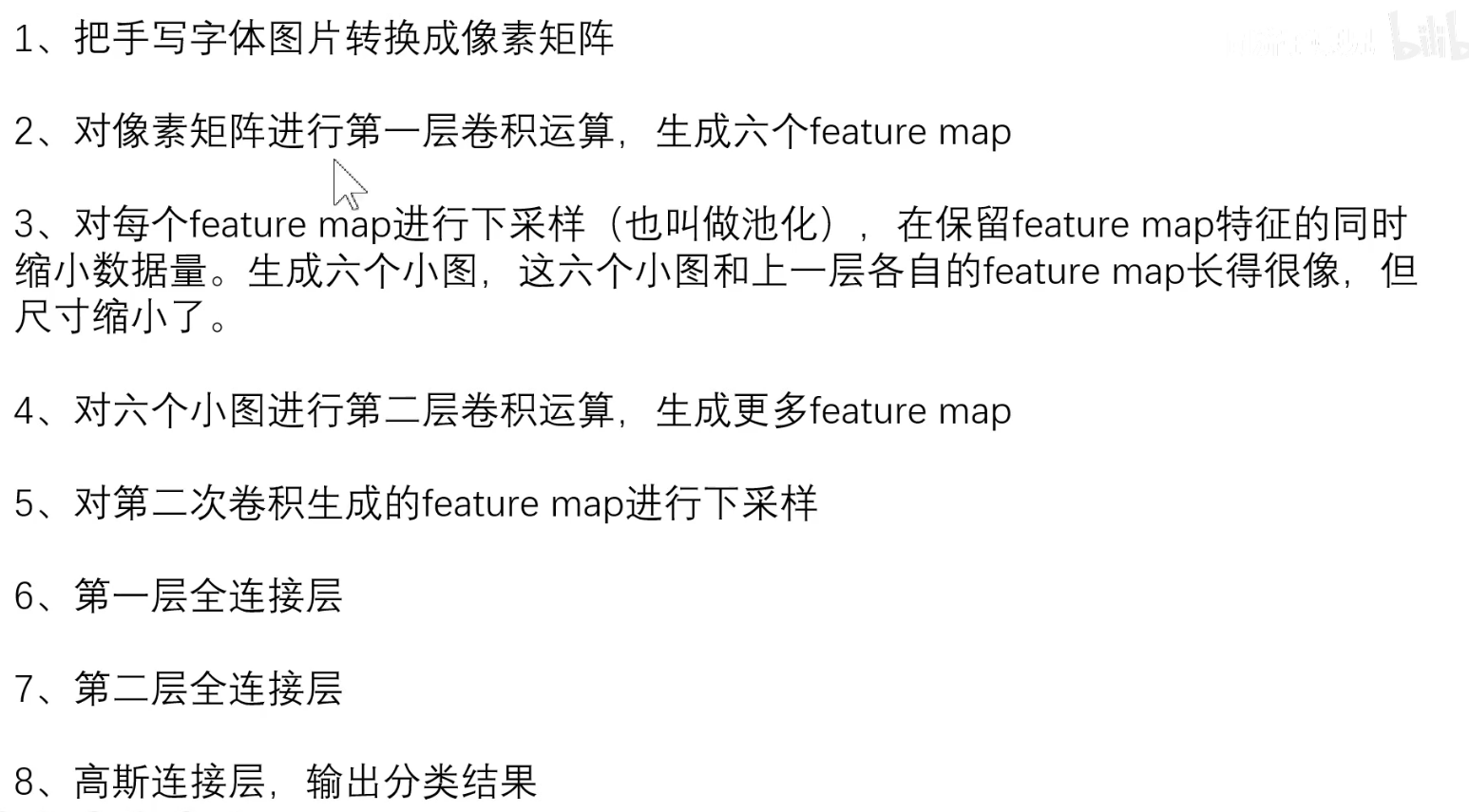

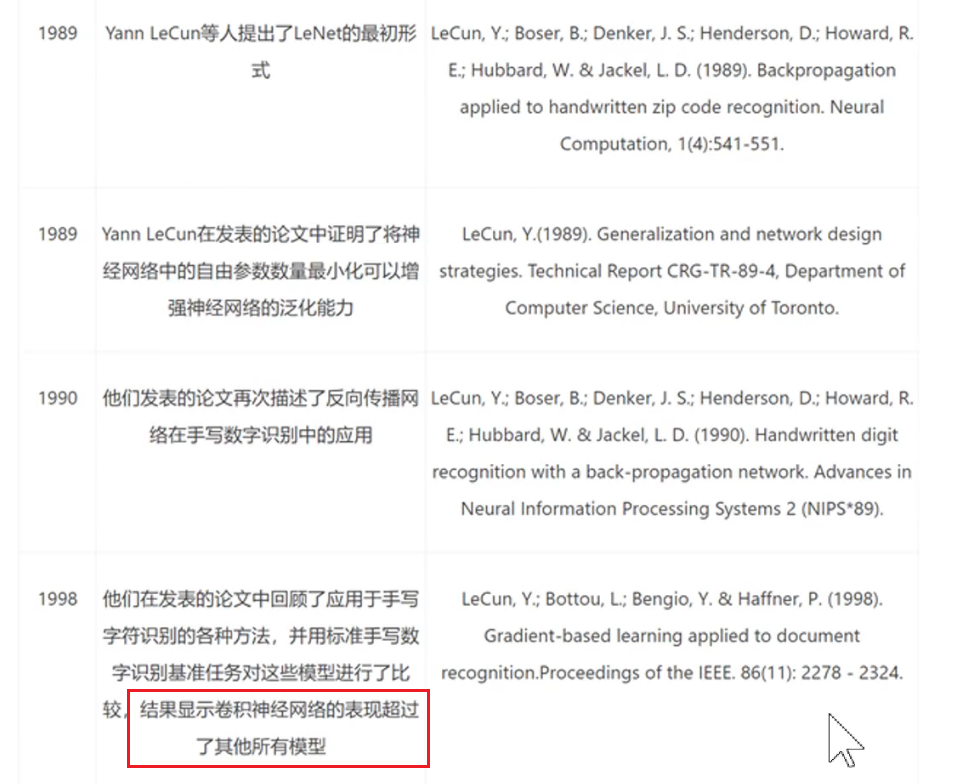

P8卷积神经网络的鼻祖-LeNet-5

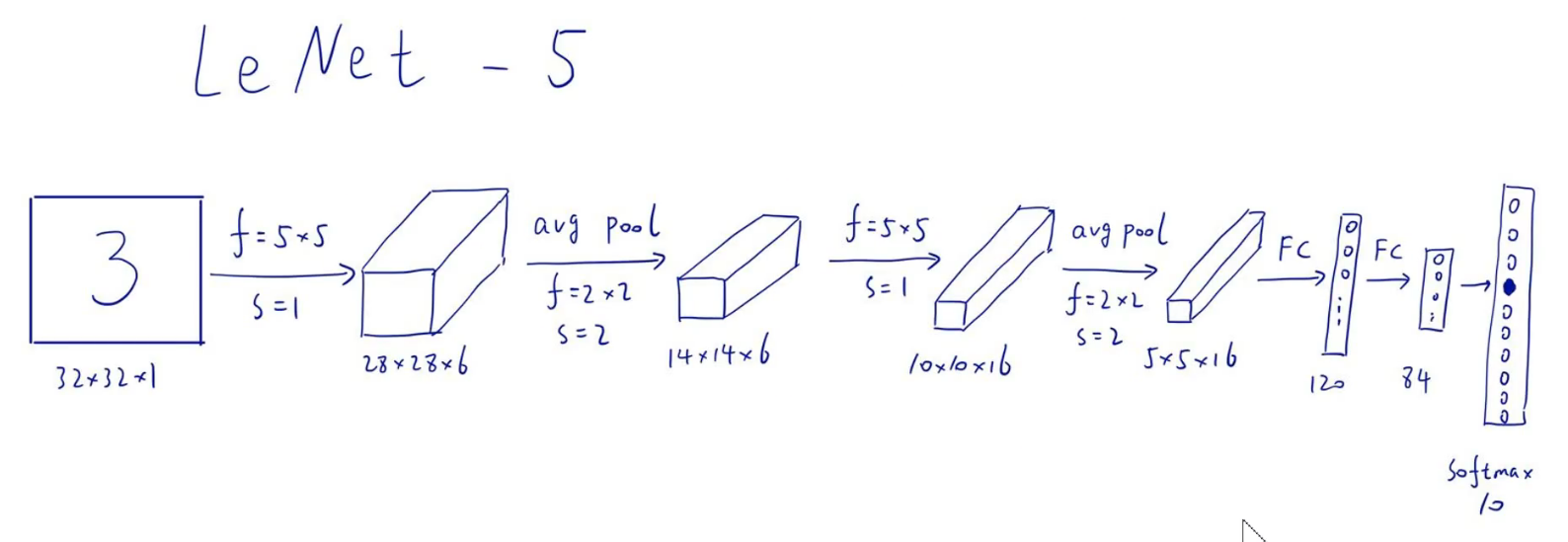

LeNet–5模型是Yann LeCun教授于l998年在论文Gradient-based learnirg applied to document recognition中提出的,它是第一个成功应用于数字识别问题的卷积神经网络。LNet-5模型一共有7层。当年美国大多数银行就是用它来识别支票上面的手写数字的,它是早期卷积神经网络中最有代表性的实验系统之一.Yann LeCun教授不是中国人,是法国人,在上世纪80年代读博期间提出“人工神经网络”,但后来该理论一度被认为过时,他本人甚至被拒绝参加学术会议。

这是Yann LeCun教授的论文历史

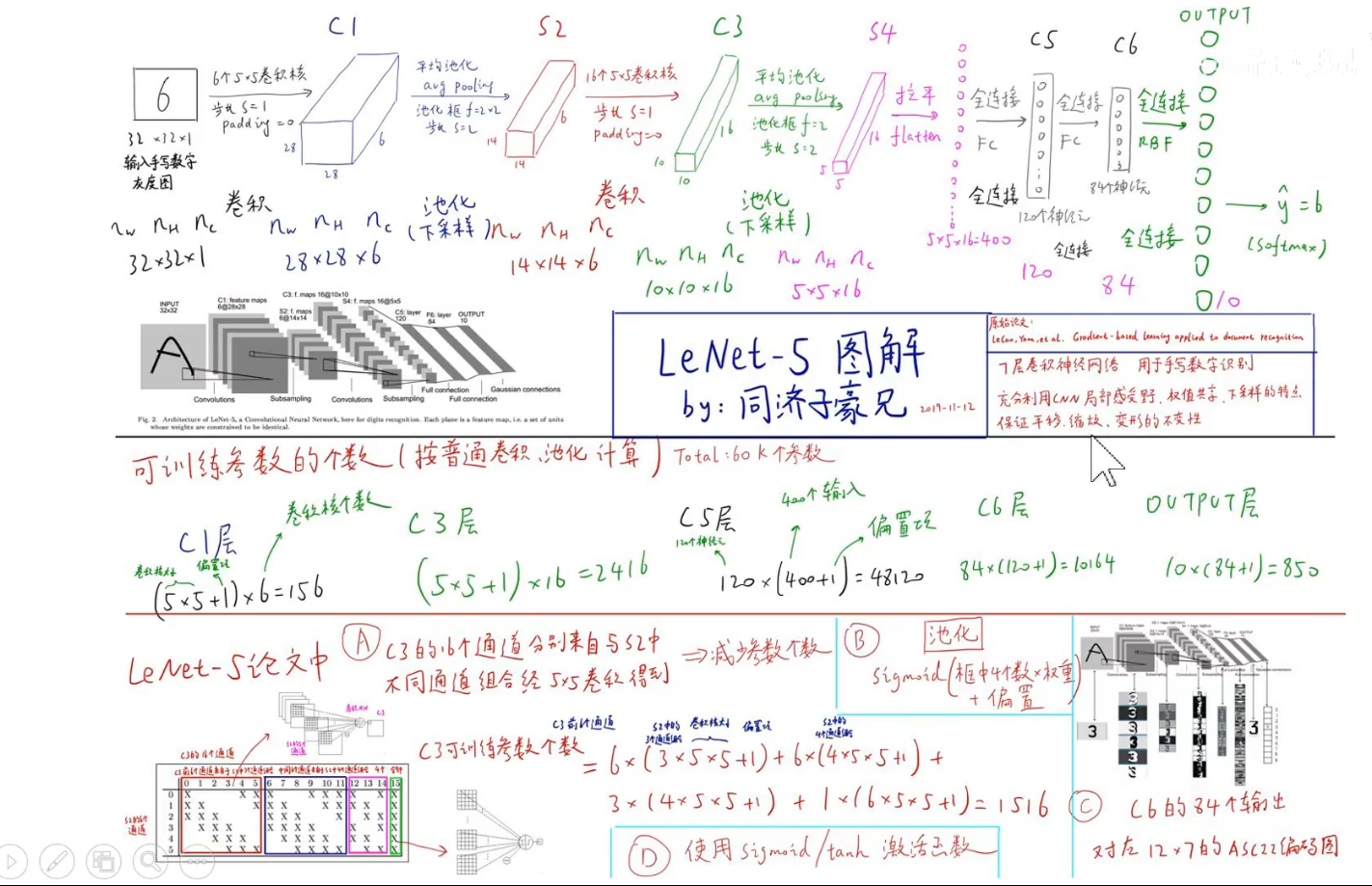

子豪兄的手绘

同济子豪兄在阅读这个论文之后分析:

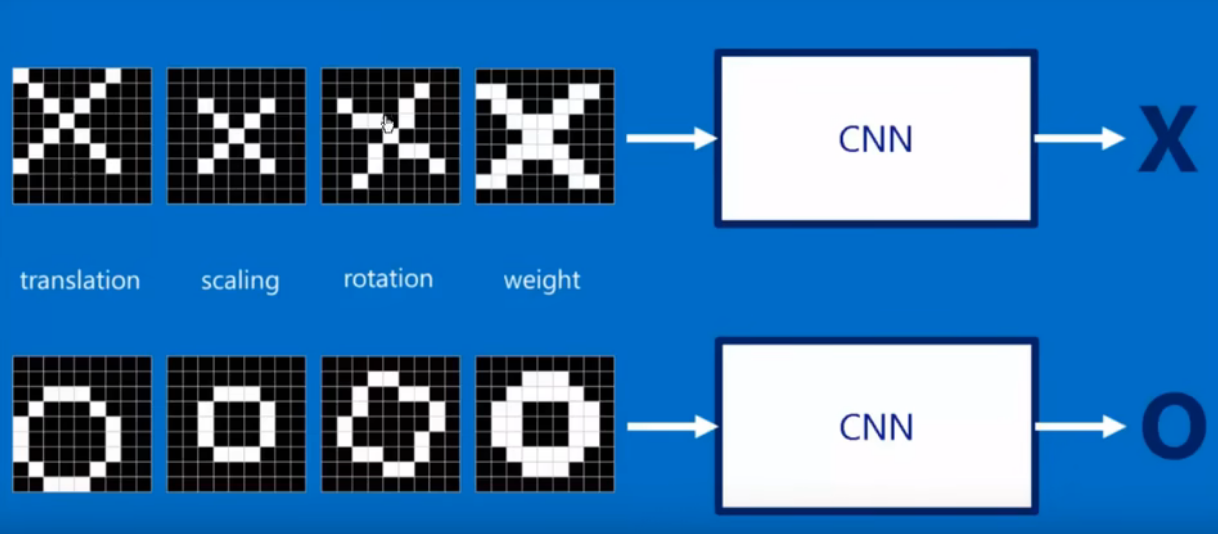

7层卷积神经网络,用于手写数字识别:充分利用CNN局部感受野,权值共享,下采样的特点,保证平移,缩放,变形的不变形。

问题: 为啥C3层的参数为(5 * 5 * 6 +1) * 16 =2416

参数量计算

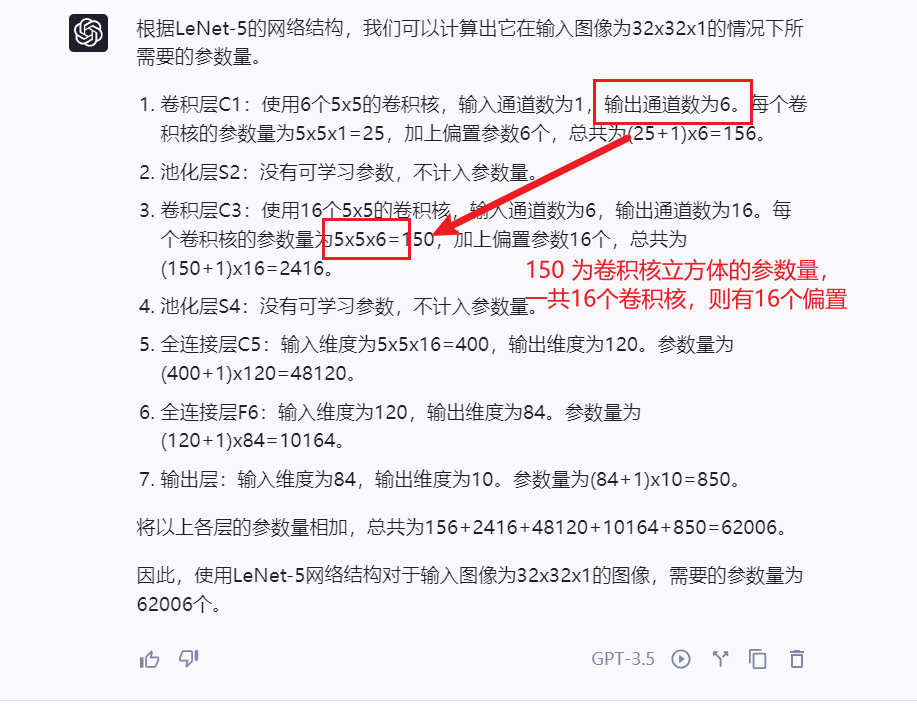

参数量询问了ChatGPT,可以看到具体如下的参数量计算:

局部感受野 权值共享 下采样概念

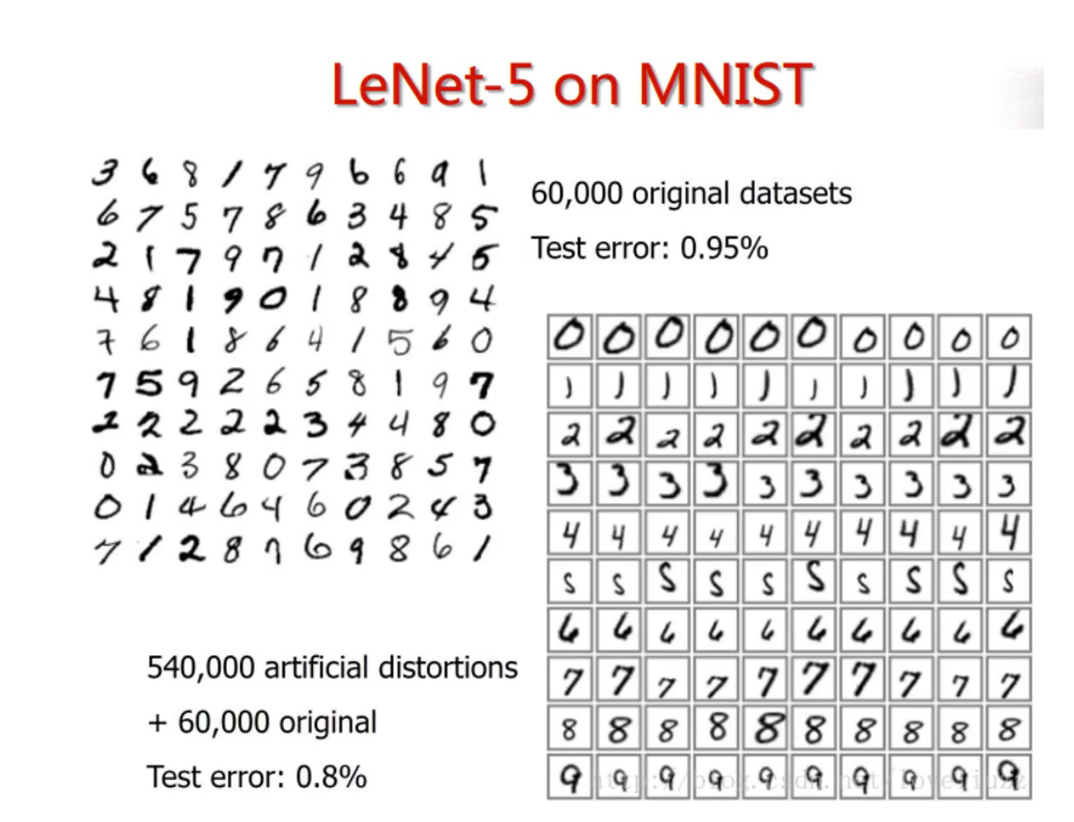

MNIST数据集60000张,测试集 10000张

可解释性不强:

可解释性较强: SVM, 朴素贝叶斯, 决策树

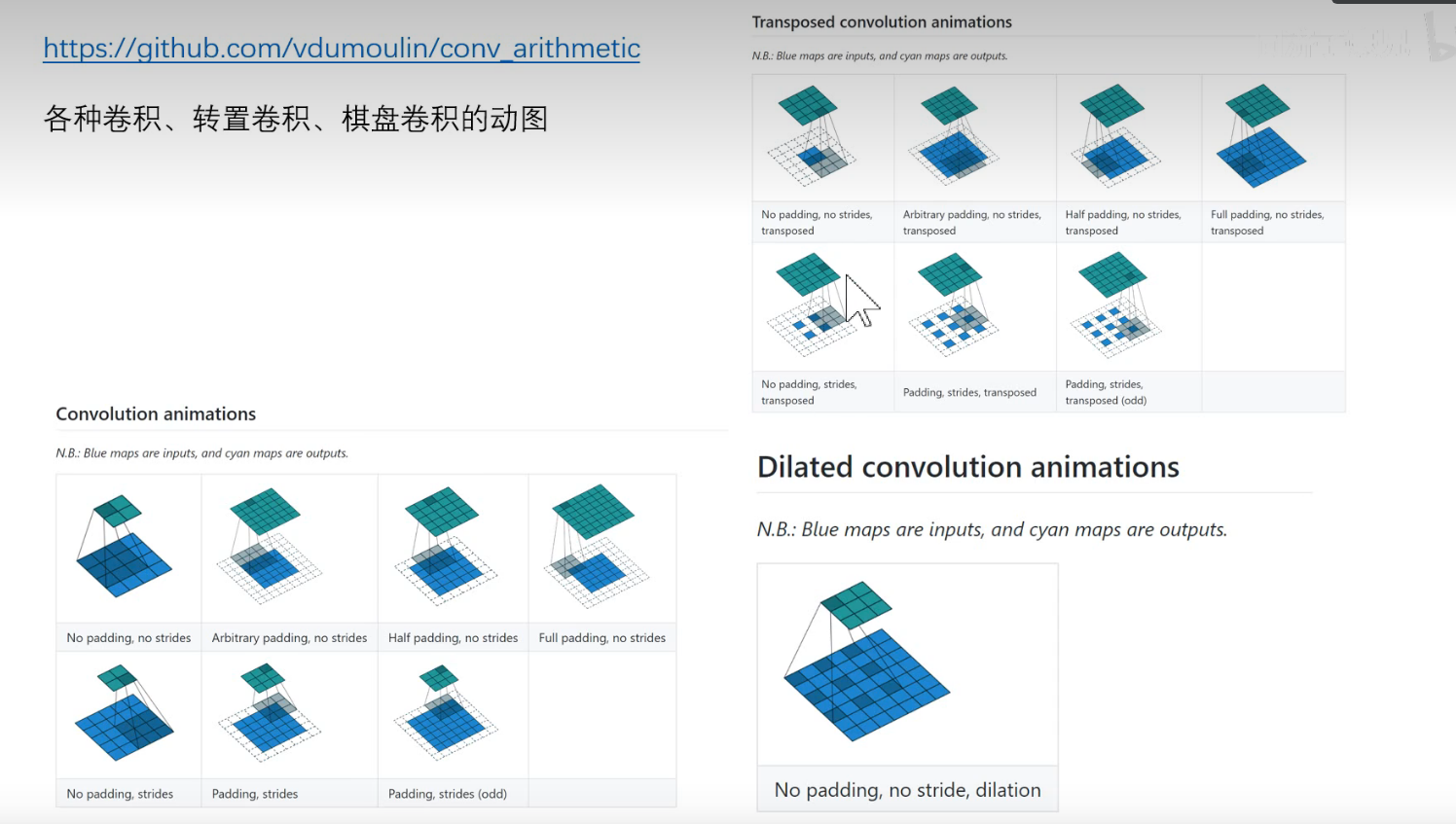

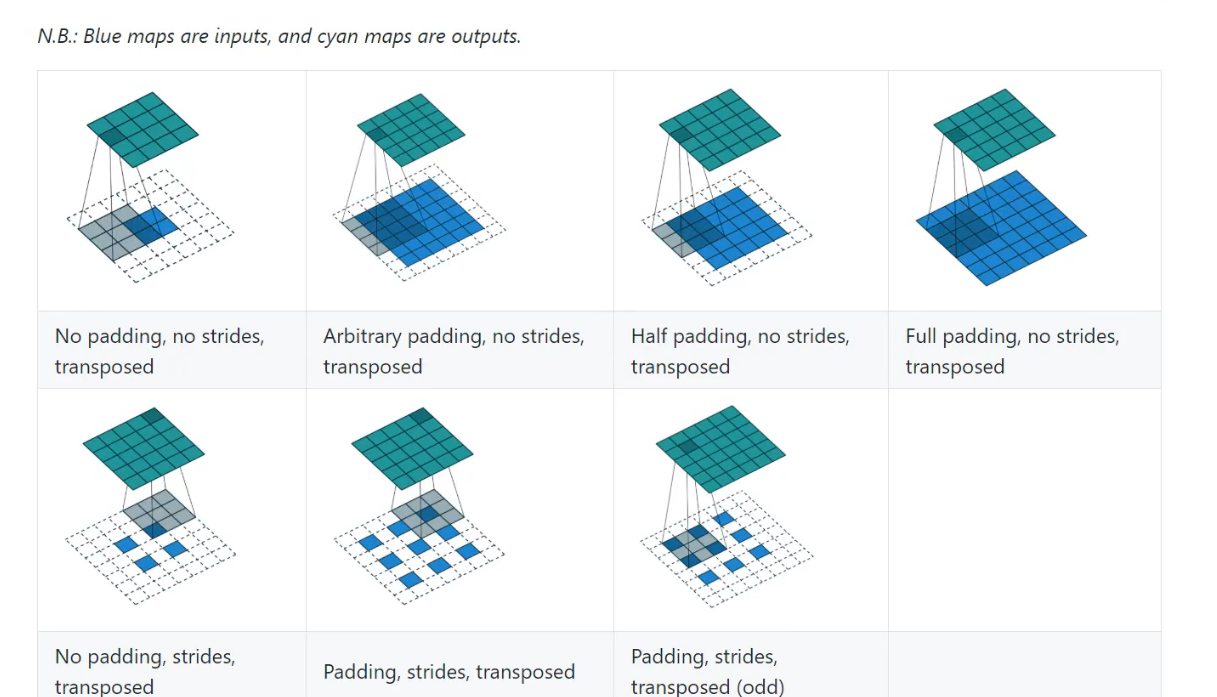

P9各种各样的卷积动图演示

介绍了这个项目conv_arithmetic

转置卷积,反卷积里upsampling, d convolution. 把小的变成大的。可以看成卷积的逆操作。

大白话讲解卷积神经网络。

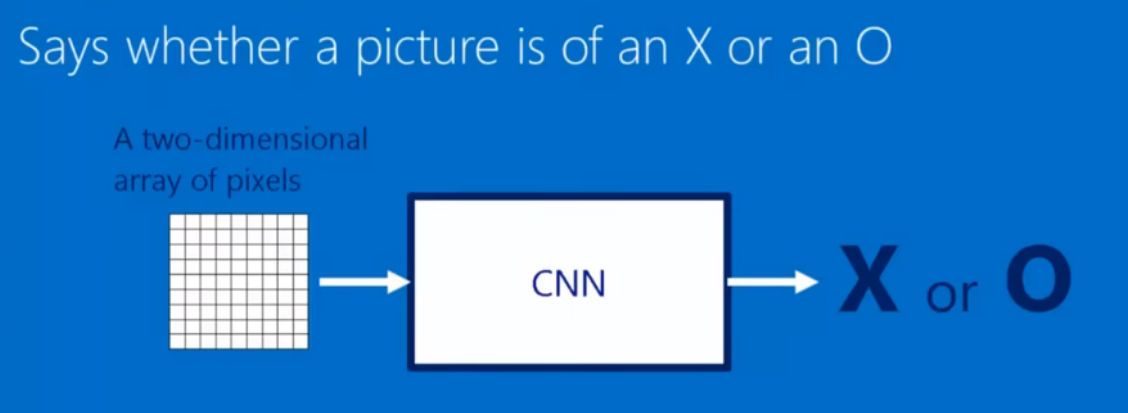

卷积神经网络是一个函数, B站视频链接

经过平移缩放,旋转都能正确的识别:

卷积运算

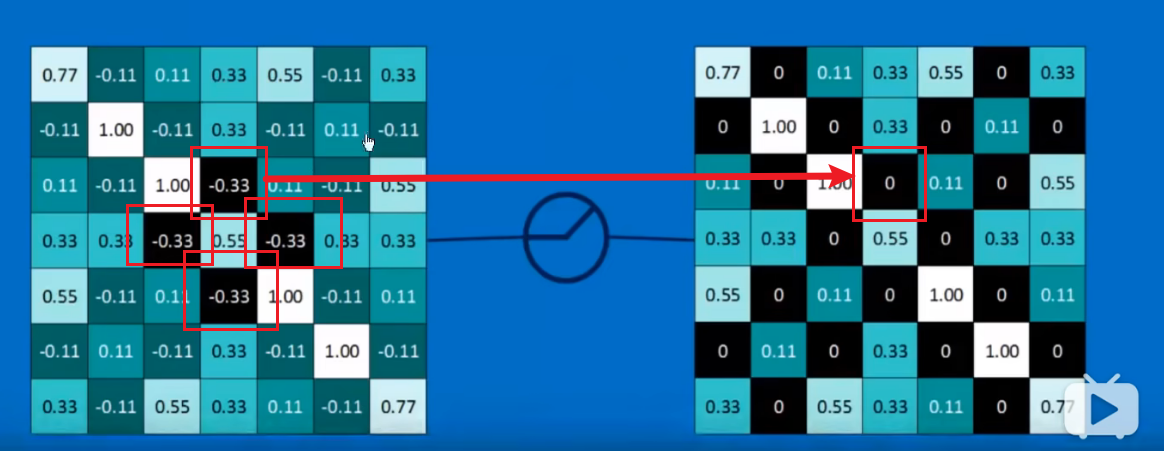

卷积核运算的过程如下:

简单理解示意如下:

不同的卷积核得到不同的特征。

池化

池化一般方式有最大值池化和平均值池化。

池化会保留代表性特征

zero padding 代表使用最外圈补0.

由下图可以看到,池化依旧保留了原图的特征

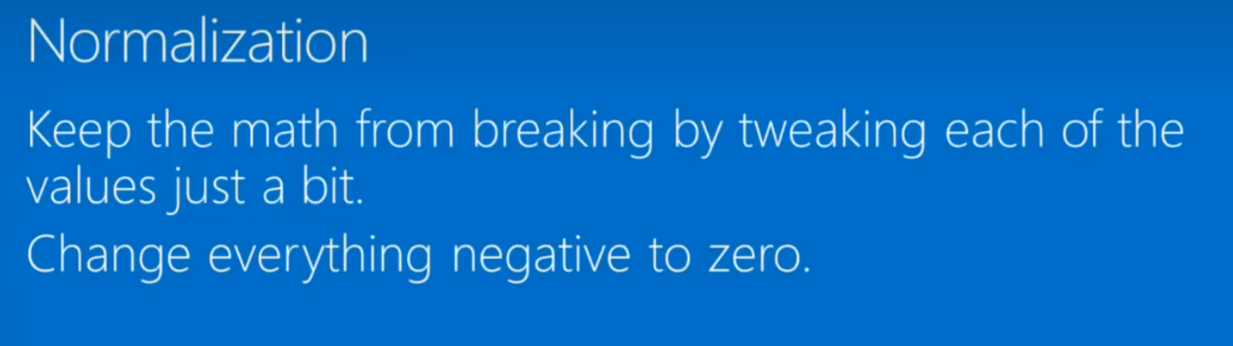

归一化- Normalization

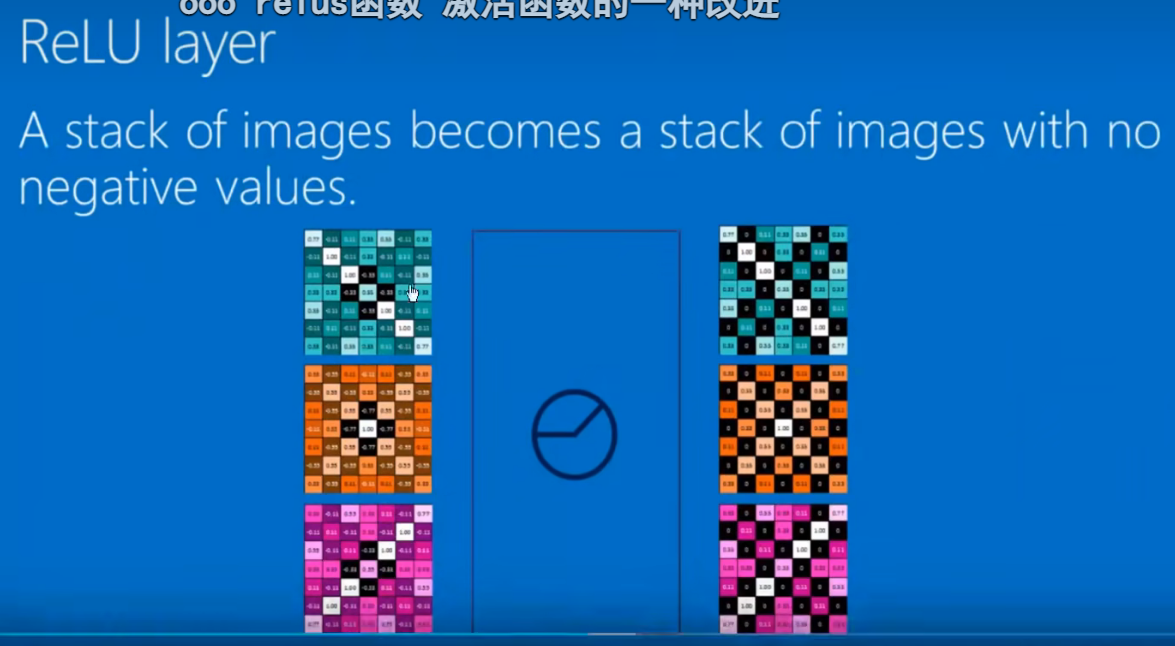

修正线性单元在梯度下降中比其他的激活函数好很多。

经过卷积, 激活和池化之后得到了一组特征图:

三个可以作为一个单元多次重复。

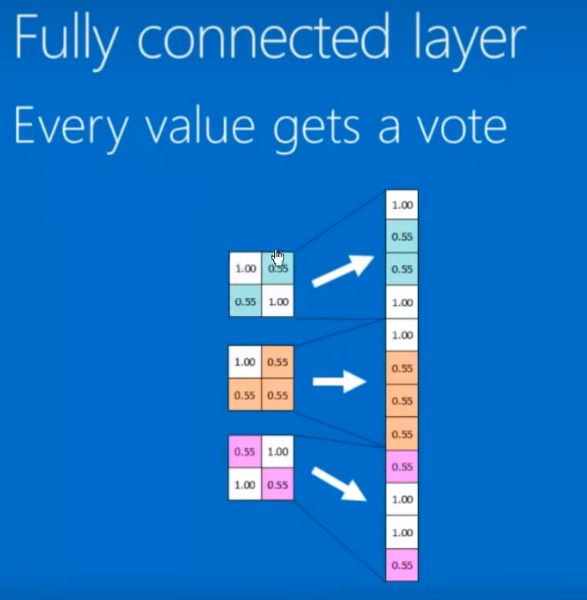

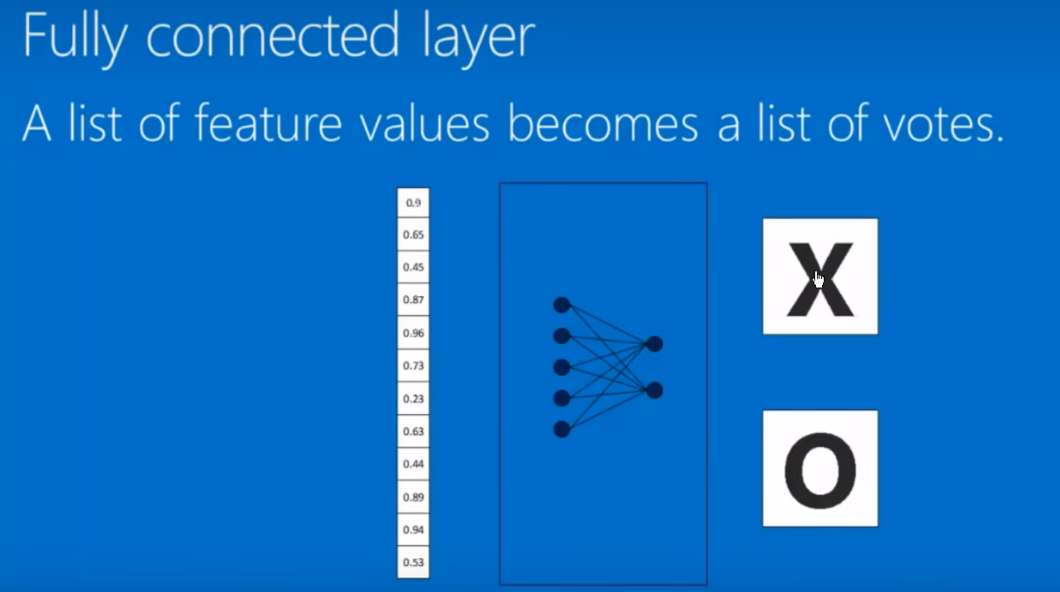

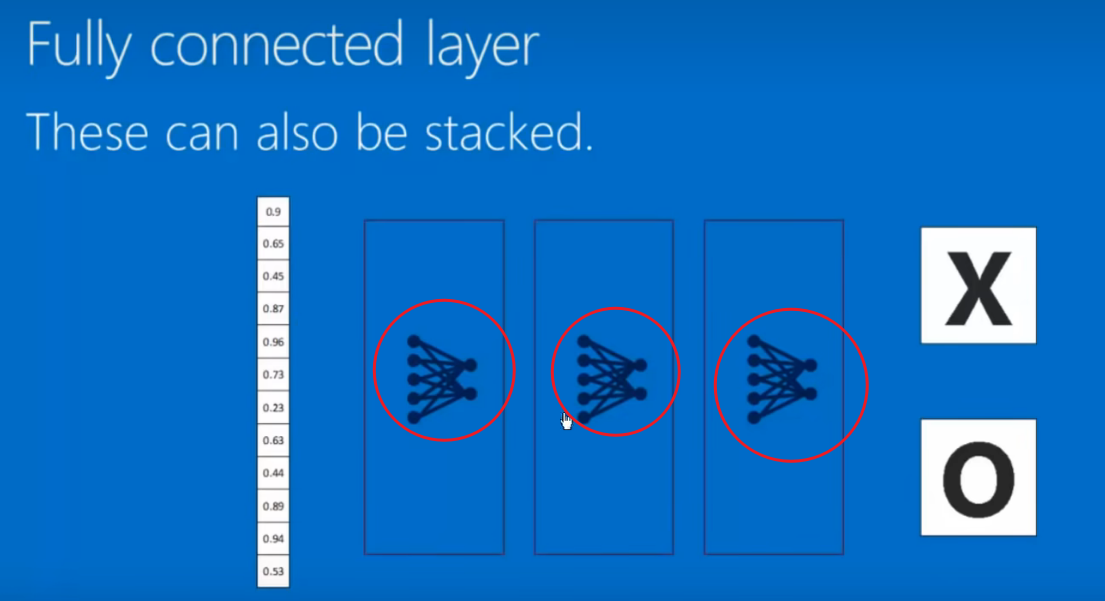

全连接层

即Flatten。

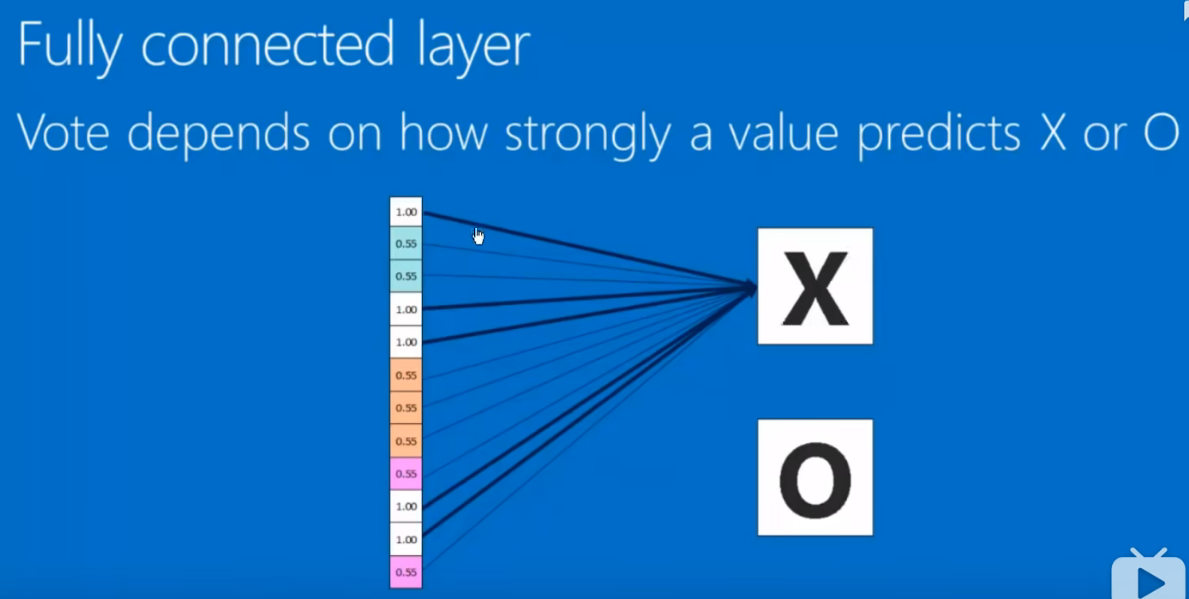

投票 加权求和。

全连接可以放很多层:

问题

这些魔法数字从哪里雪莱的,卷积层中的特征。

- BackPropagation。反向传播的算法。将损失函数最小化。

李飞飞 image-net

。

。

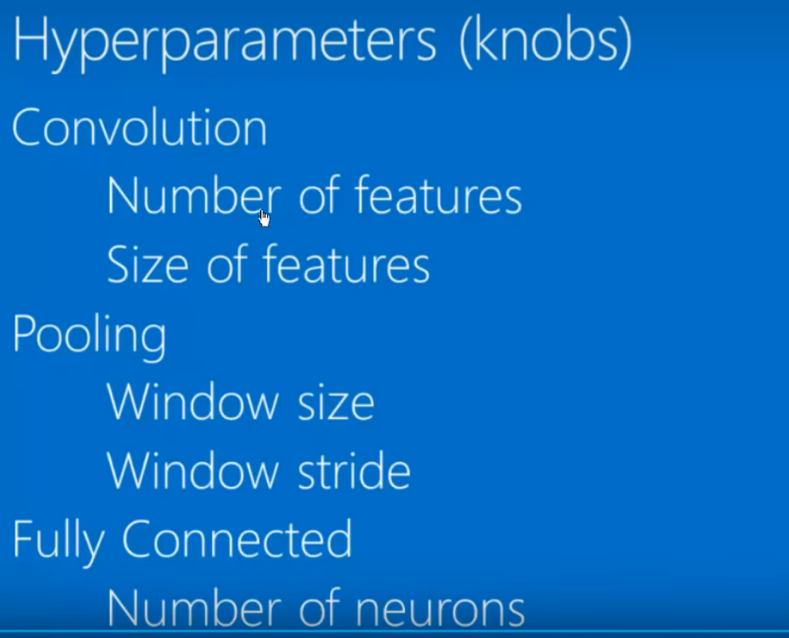

超参数:相当于放好一个框架,然后通过误差最小化优化框架的各个参数。

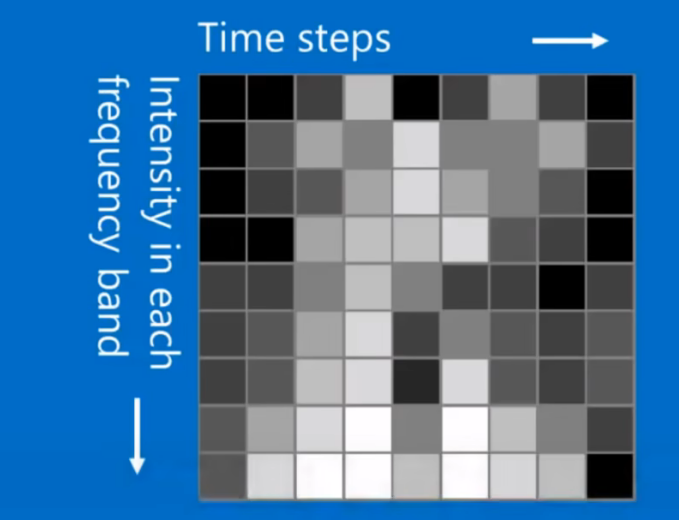

不仅仅处理2D数据,也可以处理3D图像。 声音也可以转化为类似的结构

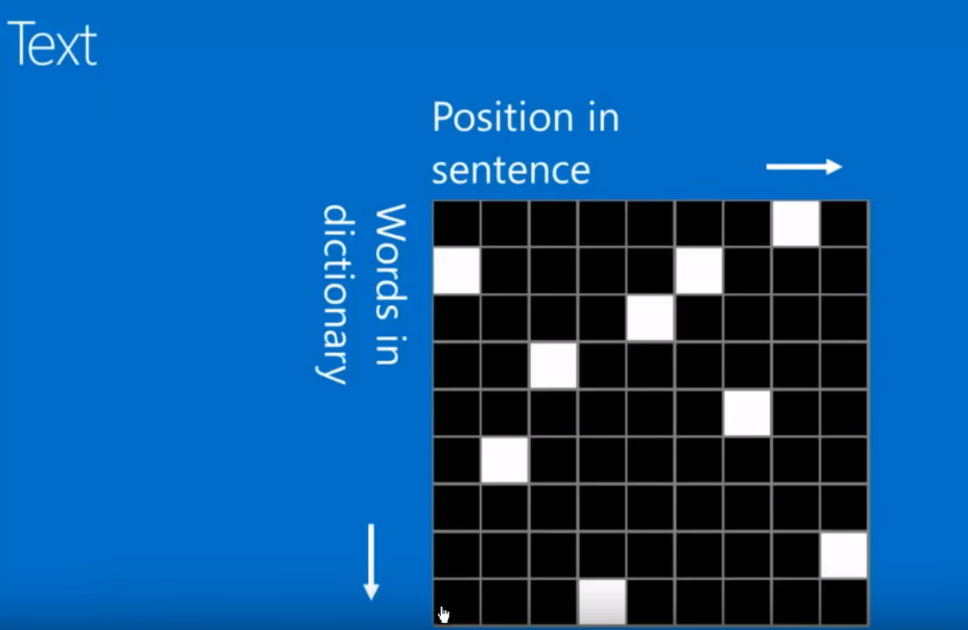

Text

卷积神经网络对于excel的表格不能很好的表示。

总结,在分类图片上非常有用。

2012 Alexnet

2014 GoogleNet VGG(迁移学习中表现良好)

2015年 ResNet, 微软, 152层, 通过残差学习的方法训练模型。

ResNet在2015年被提出,152层,不仅仅靠深度取胜,而是通过采用

残差学习的方法训川练模型。在2015年ImageNet比赛classification任务上获得第一名,因为它"简单与实用"并存,减少了参数数量,衍生出ResNet50和ResNet101这样的旁支,Alpha zero(只训川练8个小时就打败了AlphaGo)也使用了ResNet。作者何凯明是2003年广东省理科高考状元,本科毕业于清华大学,博士毕业于香港中文大学,真正的doctor(图像去雾)。

总结

最近一直想要弄清楚这个CNN的工作,并且要能够使用CNN完成自己的神经网络,至少在计算视觉领域能够分析,以及典型的计算机视觉,NLP,语音处理相关的工作。CNN都是一个相对来说比较有用的工作。

所以深度学习框架,Tensorflow或者Pytorch都是非常重要的。自己在这方面的积累真的太少了。要尽快的学习,加速自己对于机器学习的沉淀,投入时间,换取成长。