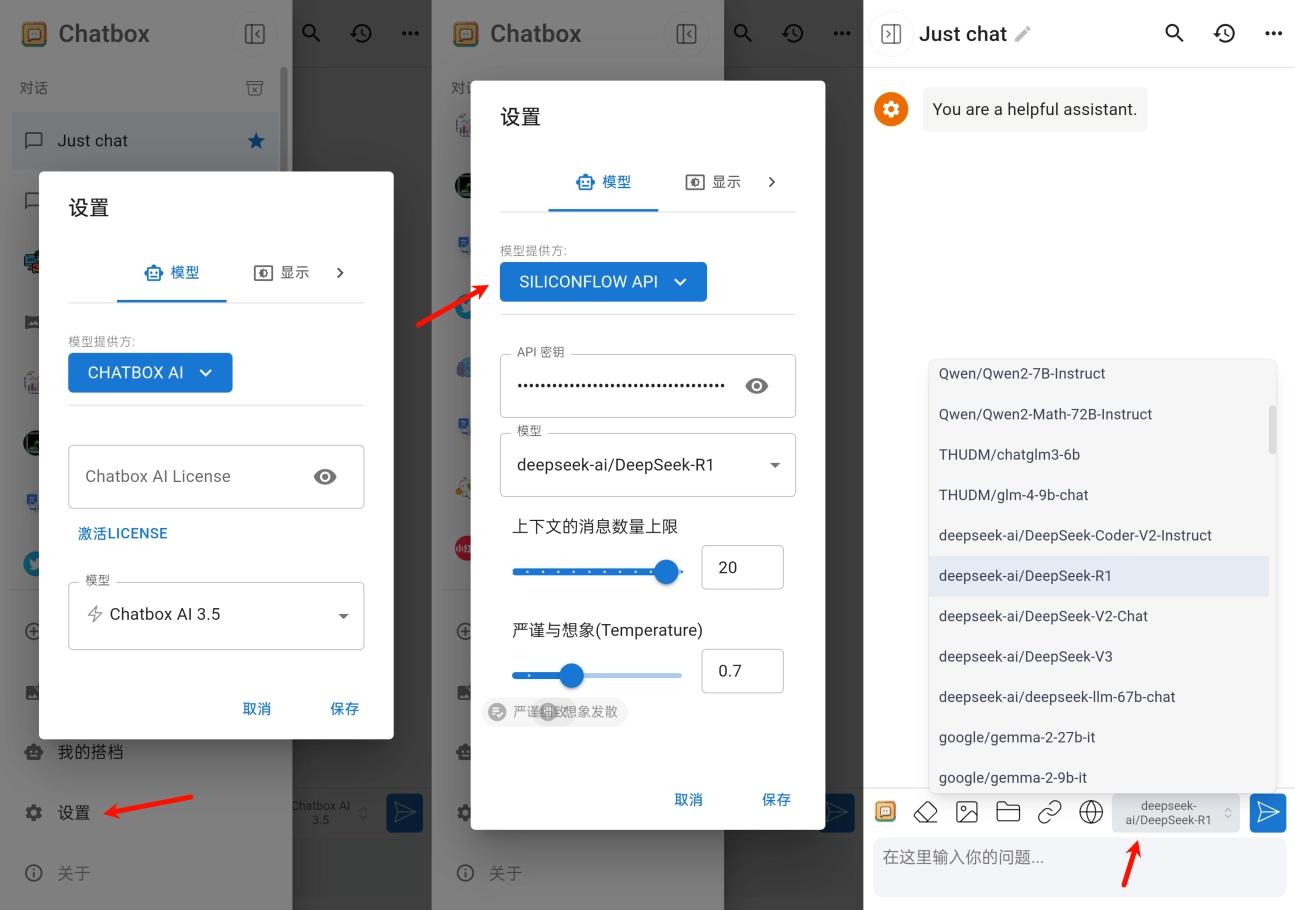

由于生产服务器版本上部署的是MySQL5,而开发手里的脚本代码是MySQL8。所以只能降版本了…

升级版本与降级版本脚本转换逻辑一样

MySQL5与MySQL8版本SQL脚本区别

大多数无需调整、主要是字符集与排序规则

MySQL5与MySQL8版本SQL字符集与排序规则

主要操作: utf8mb4_0900_ai_ci 替换 utf8mb4_general_ci

如下查询字符集(保持所需转换字符集与排序规则一样是成功替换的关键):

-- 内置命令查询

show collation where Charset='utf8mb4';

-- SQL 查询

select * from information_schema.collations where character_set_name = "utf8mb4" order by COLLATION_NAME;

如需了解字符集与排序规则含义自行百度吧、太多了就不说明了…

本人亲测有效。