在线工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 3D数字孪生场景编辑器

Stable Diffusion 已迅速成为最流行的生成式 AI 工具之一,用于通过文本到图像扩散模型创建图像。但是,它需要什么硬件才能以最佳方式运行呢?具体来说,Stable Diffusion 是否利用 GPU 来增强性能?让我们仔细看看。

为什么 Stable Diffusion 使用 GPU?

Stable Diffusion 使用 GPU 的主要原因是 AI 图像合成所需的巨大计算能力。

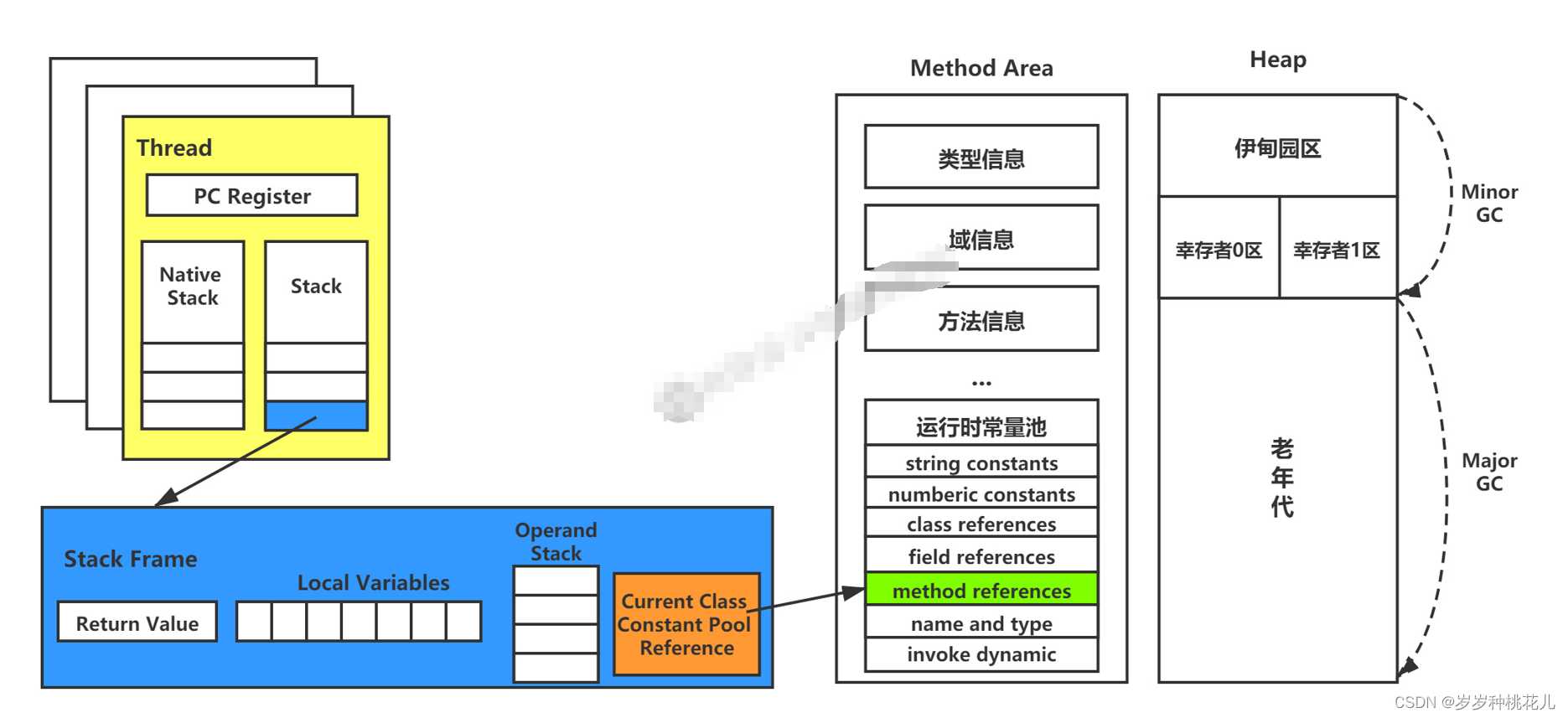

GPU 或图形处理单元旨在处理机器学习任务中涉及的并行计算类型,其效率远高于 CPU。通过神经网络生成图像的要求非常高,需要在庞大的数据集上进行大规模的矩阵计算。

例如,Stable Diffusion 的训练数据集包含超过 2 亿个图像文本对。模型架构本身还包含超过 1 亿个参数。

为了有效地处理如此大量的数据和参数,GPU 加速至关重要。GPU 的大规模并行能力使 Stable Diffusion 能够在合理的时间范围内进行密集的训练和推理。

特别是,在 Stable Diffusion 中生成单个 512×512 图像需要超过 4 万亿次浮点运算。如果没有强大的 GPU,这个过程将花费很长时间。

简而言之,GPU 通过大幅加快训练和生成速度来解锁 Stable Diffusion 等系统的出色功能。先进的硬件与先进的软件相匹配。

使用 GPU 实现稳定扩散的好处

使用 GPU 运行 Stable Diffusion 具有以下几个关键优势:

- 更快的生成 – 借助 GPU 加速,通过 Stable Diffusion 创建图像的速度明显更快。生成图像只需几秒钟,而不是每张图像几分钟或几小时。

- 更高的分辨率 – GPU 可以处理更高分辨率的输出。这使得 Stable Diffusion 能够生成详细的 1024×1024 甚至 2048×2048 图像。

- 更大的批量 – 可以并行生成更多图像。使用 GPU,用户可以一次创建多个提示变体。

- 实时编辑 – 可以实时完成来自 Stable Diffusion 的编辑和操作图像,而无需等待长时间渲染。

- 增强的创造力 – 响应速度和质量使用户能够更自由地微调输出和实验。

- 更大的模型 – 更大、更强大的 AI 模型可以在实际时间范围内运行。Stable Diffusion 可能始于 448M 参数,但 GPU 可以启用具有数十亿个参数的训练模型。

对于创作者和研究人员来说,支持 GPU 的稳定扩散消除了硬件限制,并解锁了更高水平的生成艺术。体验变得无缝互动。

如何选择最佳的GPU实现稳定扩散

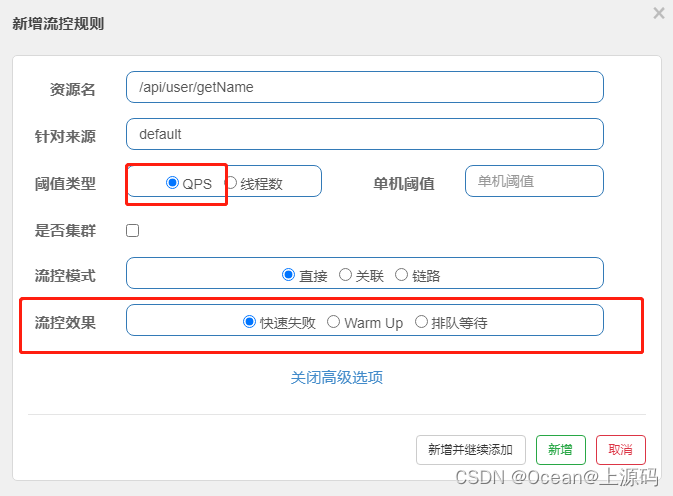

在选择 GPU 以获得最佳稳定扩散性能时,需要考虑几个关键因素:

- VRAM – 视频内存量至关重要。12GB 是实际的最小值,而 24GB 是最大化分辨率、批量大小和模型复杂性的理想选择。

- 内存带宽 – 更快的内存带宽可减少训练大型模型或生成高分辨率图像时的瓶颈。

- 张量核心 – 专门的张量核心单元加速密集矩阵,将 AI 工作负载固有的矩阵乘以。Nvidia RTX GPU 包含专用的张量核心。

- 计算能力 – 更高的 CUDA 内核和更高的时钟速度可实现更快的并行处理。像 A6000 这样的计算优化型 GPU 在这方面表现出色。

- 预算 – GPU 价格随着 VRAM 和电源的急剧上涨而急剧增加。优先考虑预算可能会降低可行的速度和质量。二手/较旧的 GPU 可以提供一个经济实惠的起点。

对于最高质量的输出,Nvidia RTX 3090、RTX A6000 或 RTX 4090 是理想的选择。AMD 还提供功能强大的选项,例如 Radeon Pro W6800。所选的 GPU 将直接影响可用的生成参数和模型大小。

为什么 Stable Diffusion 需要 Nvidia?

Stable Diffusion 使用 Nvidia GPU 的主要原因是 AI 图像合成所需的巨大计算能力。

Nvidia GPU 旨在非常高效地处理机器学习中涉及的并行计算类型。通过神经网络生成图像的要求非常高,需要在庞大的数据集上进行大规模的矩阵计算。

例如,Stable Diffusion 的训练数据集包含超过 2 亿个图像文本对。模型架构本身还包含超过 1 亿个参数。

为了有效地处理如此大量的数据和参数,Nvidia GPU 加速至关重要。Nvidia GPU 的大规模并行能力使 Stable Diffusion 能够在合理的时间范围内进行密集的训练和推理。

特别是,在 Stable Diffusion 中生成单个 512×512 图像需要超过 4 万亿次浮点运算。如果没有强大的 Nvidia GPU,这个过程将花费很长时间。

简而言之,Nvidia GPU 通过大幅加快训练和生成速度来解锁 Stable Diffusion 等系统的出色功能。先进的硬件与先进的软件相匹配。

使用 Nvidia 进行稳定扩散的好处

使用 Nvidia GPU 运行 Stable Diffusion 具有以下几个关键优势:

- 更快的生成 – 借助 Nvidia GPU 加速,通过 Stable Diffusion 创建图像的速度明显更快。生成图像只需几秒钟,而不是每张图像几分钟或几小时。

- 更高的分辨率 – Nvidia GPU 可以处理更高分辨率的输出。这使得 Stable Diffusion 能够生成详细的 1024×1024 甚至 2048×2048 图像。

- 更大的批量 – 可以并行生成更多图像。使用 Nvidia GPU,用户可以一次创建多个提示变体。

- 实时编辑 – 可以实时完成来自 Stable Diffusion 的编辑和操作图像,而无需等待长时间渲染。

- 增强的创造力 – 响应速度和质量使用户能够更自由地微调输出和实验。

- 更大的模型 – 更大、更强大的 AI 模型可以在实际时间范围内运行。Stable Diffusion 可能始于 448M 参数,但 Nvidia GPU 可以启用具有数十亿个参数的训练模型。

对于创作者和研究人员来说,支持 Nvidia GPU 的稳定扩散消除了硬件限制,并解锁了更高水平的生成艺术。体验变得无缝互动。

如何选择最佳的 Nvidia GPU 以实现稳定扩散

在选择 Nvidia GPU 以获得最佳稳定扩散性能时,需要考虑几个关键因素:

- VRAM – 视频内存量至关重要。12GB 是实际的最小值,而 24GB 是最大化分辨率、批量大小和模型复杂性的理想选择。

- 内存带宽 – 更快的内存带宽可减少训练大型模型或生成高分辨率图像时的瓶颈。

- 张量核心 – 专门的张量核心单元加速密集矩阵,将 AI 工作负载固有的矩阵乘以。Nvidia RTX GPU 包含专用的张量核心。

- 计算能力 – 更高的 CUDA 内核和更高的时钟速度可实现更快的并行处理。像 A6000 这样的计算优化的 Nvidia GPU 在这里表现出色。

- 预算 – GPU 价格随着 VRAM 和电源的急剧上涨而急剧增加。优先考虑预算可能会降低可行的速度和质量。二手/较旧的 Nvidia GPU 可以提供一个经济实惠的起点。

对于最高质量的输出,Nvidia RTX 3090、RTX A6000 或 RTX 4090 是理想的选择。选择的 Nvidia GPU 将直接影响可用的生成参数和模型大小。

使用 GPU 实现稳定扩散的替代方案

虽然 GPU 对某些用户来说可能不切实际,但 Stable Diffusion 不需要高级显卡。以下是一些替代选项:

- CPU – 直接在 CPU 上运行是可行的,尽管速度很慢。使用高核心数处理器在一定程度上弥补了 GPU 能力的不足。

- Colab – Google Colab 笔记本电脑提供对云中 GPU 和 TPU 的免费访问。生成速度很快,但受会话时间和图像数量的限制。

- 云 GPU 服务 – Amazon EC2、Paperspace、Lambda 等提供对高端 GPU 的付费云访问,以实现灵活的 AI 开发。费用根据使用情况累积。

- 扩散器 – Automatic1111 的 WebUI 和 DreamStudio 等简化应用程序可通过预配置的远程 GPU 实现稳定的扩散。无需本地 GPU。

- 模型优化 – 较小的蒸馏模型需要更少的计算来获得类似的结果。专门针对 CPU 优化稳定的扩散模型架构和超参数可以产生可用的性能。

- 降低分辨率 – 较低的分辨率输出需要较少的处理能力。对于某些用例,256×256 或 128×128 映像可能就足够了,并允许生成 CPU。

对于专业、尖端的 Stable Diffusion 使用,GPU 加速是必须的。但是,替代方案的范围意味着,通过在速度、批量大小和输出质量上做出妥协,无需昂贵的 GPU 即可生成基本图像。

综上所述,Stable Diffusion 大量利用 GPU 来实现高性能和高保真 AI 图像合成。现代显卡的大规模并行处理和丰富的 VRAM 使生成模型的计算强度得以大规模提高。虽然存在替代方案,但 GPU 可以解锁 Stable Diffusion 等系统的全部功能,并且随着这一激动人心的领域的研究继续快速发展,GPU 可能会成为不可或缺的一部分。

转载:Stable Diffusion 是否使用 GPU? (mvrlink.com)