学习目标:

一、实验

二、论文

学习时间:

2023.11.11-2023.11.17

学习产出:

实验

1、CB模块实验效果出来了,加上去效果不太行,后续实验考虑是否将CB模块换到其他地方

2、CiFAR100实验已完成,效果比ViTGAN好

3、Diffusion + 其他模块的实验还在跑,目前Diffusion+相对位置编码的效果比以前三个模块加一起的效果都好,考虑再多跑几次看是否是偶然结果,下周也会在这个代码上加上傅里叶看是否效果还和模型以前一样。

论文

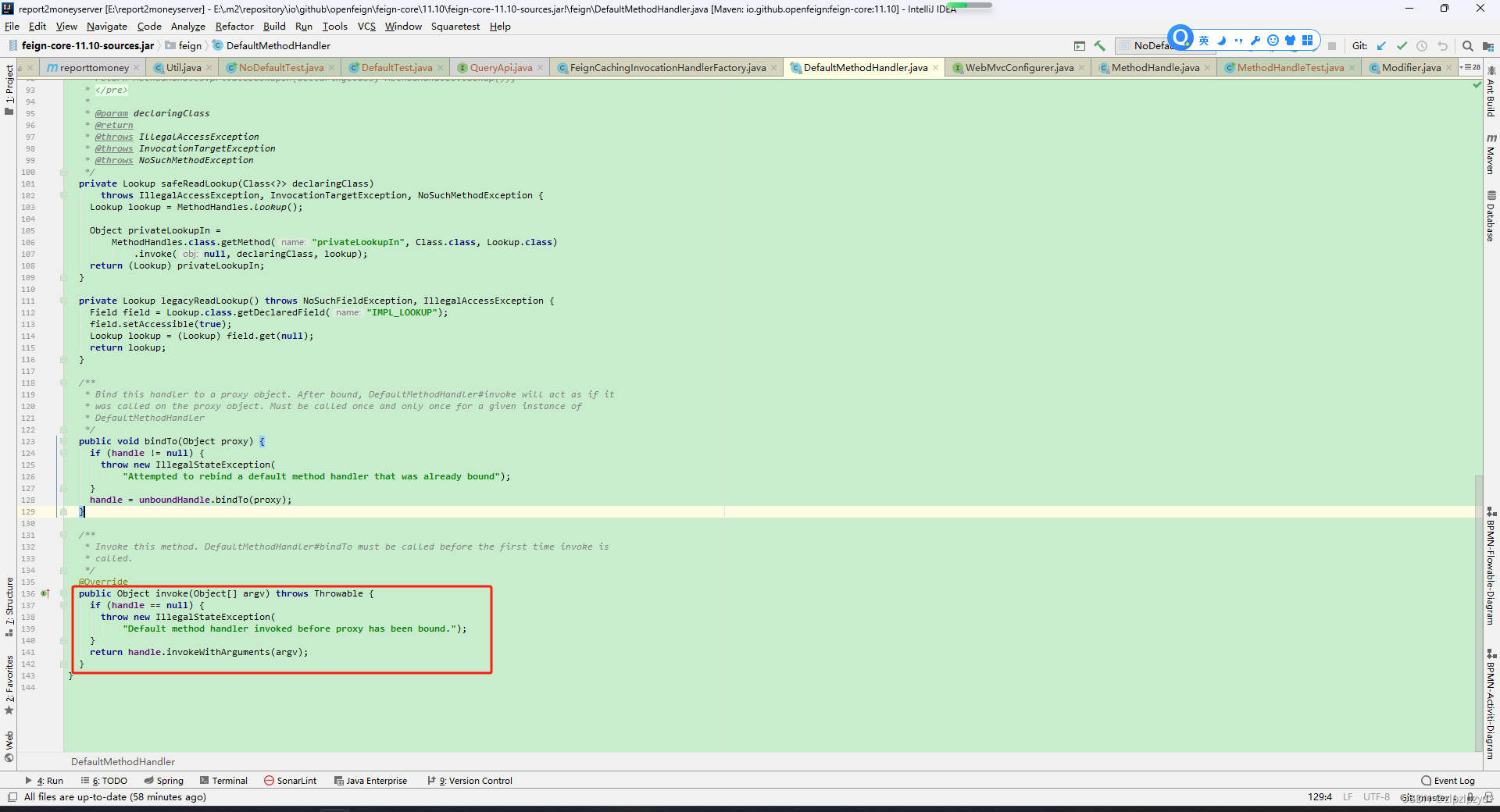

FourierFormer: Transformer Meets Generalized Fourier Integral Theorem

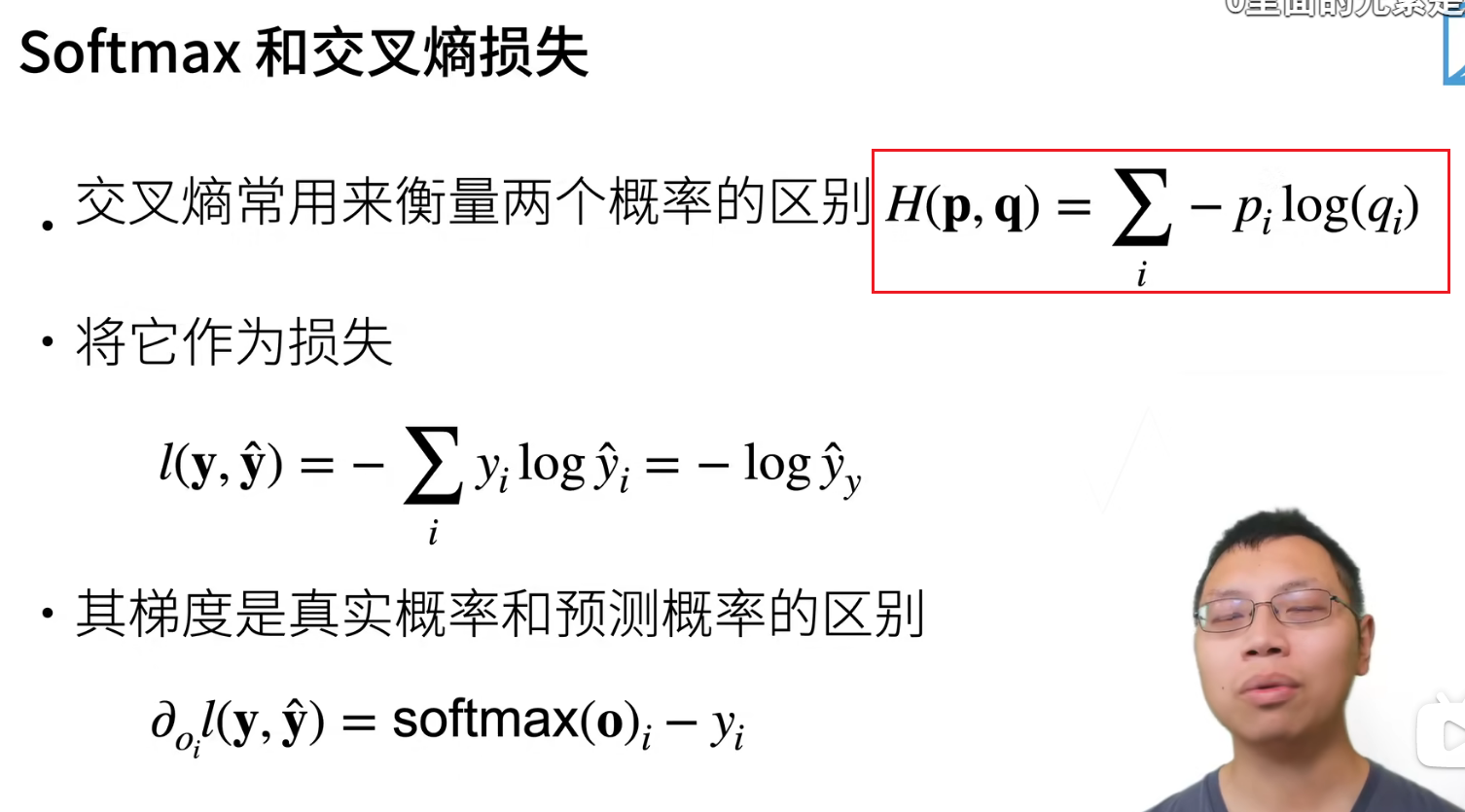

NIPS2022年的论文,提出FourierFormer,将点积核替代为广义傅里叶积分核。

1、介绍

点积自注意力遵循混合高斯分布这一假设所使用的未归一化高斯核,但这一假设在实践中是否有效并无保证。本文将Trasformer注意力解释为一个非参数核回归,提出FourierFormer,将点积核替代为广义傅里叶积分核。理论上证明了提出的傅里叶积分核可以有效逼近任何键和查询分布。与使用点积注意力的传统Transformer相比,FourierFormer能够取得更好的准确性,并减少注意头之间的冗余。

2、方法

点积自注意力可能无法捕获查询向量(Q)中特征与关键向量(V)之间的相关性,传统Transformer的方法是额外使用协方差矩阵建立QV之间的联系。本文提出使用广义傅里叶积分建立自注意力与非参数核回归之间的对应关系,利用广义傅里叶积分定理,自动捕获向量的相关性

3、贡献

(1)通过求解一个非参数核回归问题推导出自注意力的公式,从而为研究和进一步发展自注意力提供了一种非参数回归解释。

(2)提出了非参数回归问题的广义傅里叶积分估计量,并为这些估计量提供了理论保证。

(3)提出FourierFormer,使用广义傅立叶积分估计来更有效地捕获查询中特征和关键向量之间的相关性

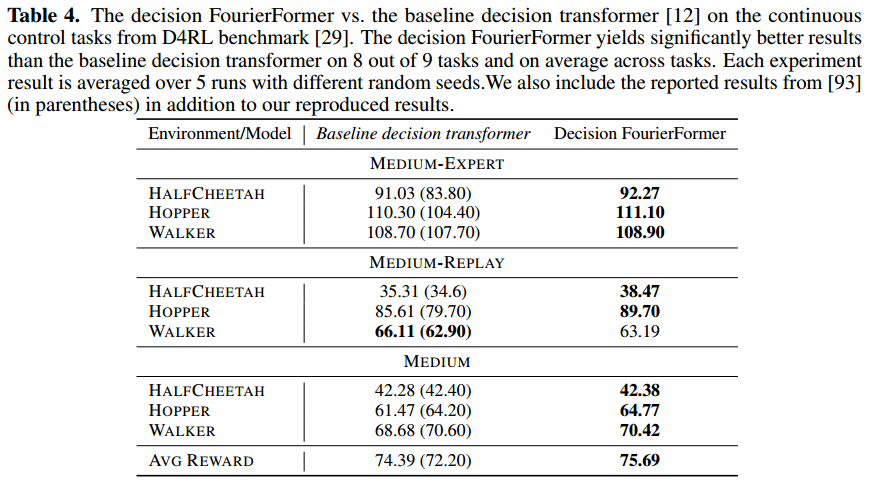

4、结果

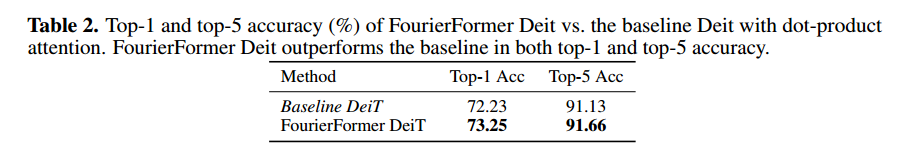

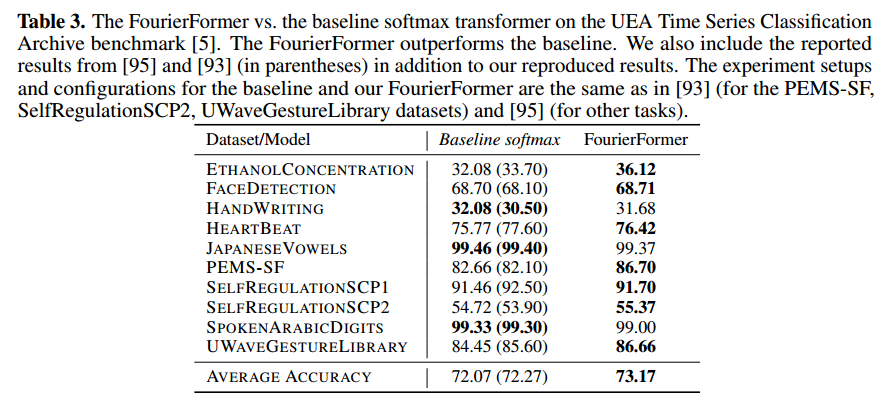

FourierFormer在WikiText语言建模和ImageNet图像分类中比具有点积自注意力的Transformer baseline获得了明显更好的精度。在实验中证明了FourierFormer有助于减少注意头之间的冗余。

![[PHP]关联和操作MySQL数据库然后将数据库部署到ECS](https://img-blog.csdnimg.cn/bd639e7c46574ff18764f3ceb47ef931.png)