聚类模型

引言

“物以类聚,人以群分”,所谓的聚类,就是将样本划分为由类似的对象组成的多个类的过程。聚类后,我们可以更加准确的在每个类中单独使用统计模型进行估计、分析或预测;也可以探究不同类之间的相关性和主要差异。聚类和分类的区别:分类是已知类别的,聚类未知。

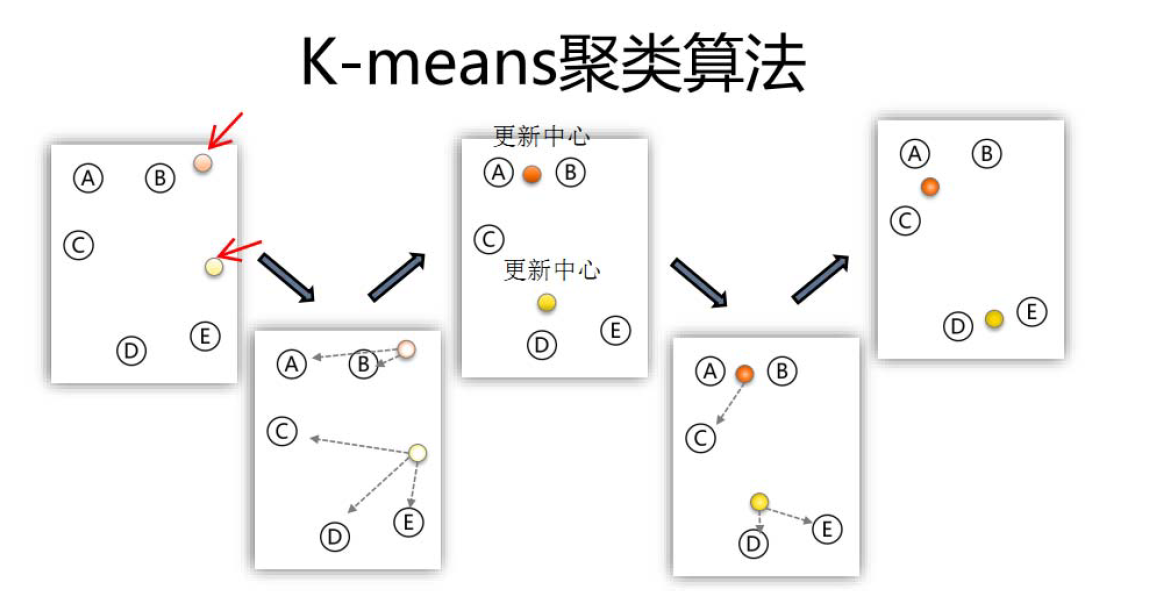

K均值聚类算法

算法流程

一、指定需要划分的簇[cù]的个数K值(类的个数);

二、随机地选择K个数据对象作为初始的聚类中心(不一定要是我们的样本点);

三、计算其余的各个数据对象到这K个初始聚类中心的距离,把数据对象划归到距离它最近的那个中心所处在的簇类中;

四、调整新类并且重新计算出新类的中心;

五、循环步骤三和四,看中心是否收敛(不变),如果收敛或达到迭代次数则停止循环;

六、结束。

K均值可视化网站:https://www.naftaliharris.com/blog/visualizing‐k‐means‐clustering/

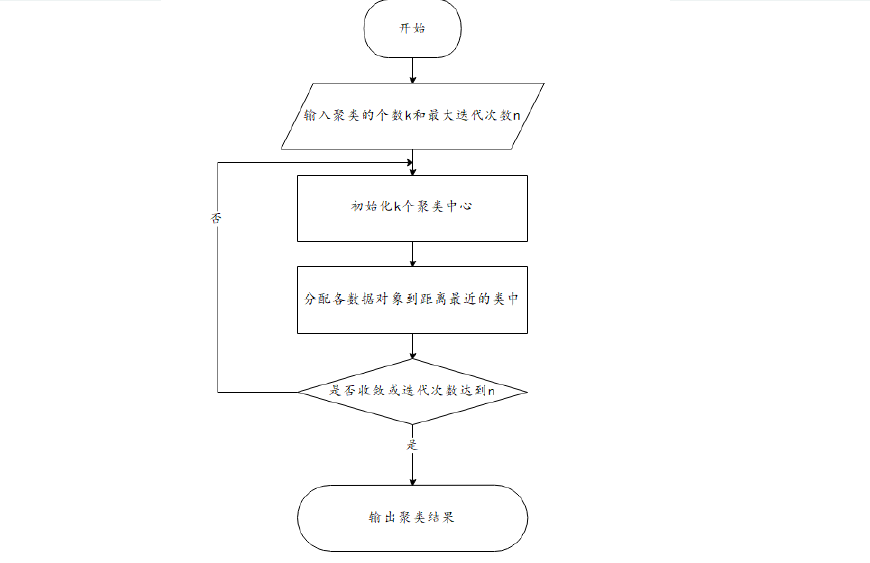

算法流程图

在论文写作中最好使用流程图而不是文字性的描述。

K-means算法评价

优点:

(1)算法简单、快速。

(2)对处理大数据集,该算法是相对高效率的。

缺点:

(1)要求用户必须事先给出要生成的簇的数目K。

(2)对初值敏感。

(3)对于孤立点数据敏感。

K-means++

k-means++算法选择初始聚类中心的基本原则是:初始的聚类中心之间的相互距离要尽可能的远

算法描述

(只对K-means算法“初始化K个聚类中心” 这一步进行了优化)

步骤一:随机选取一个样本作为第一个聚类中心;

步骤二:计算每个样本与当前已有聚类中心的最短距离(即与最近一个聚类中心的距离),这个值越大,表示被选取作为聚类中心的概率较大;最后,用轮盘法(依据概率大小来进行抽选)选出下一个聚类中心;

步骤三:重复步骤二,直到选出K个聚类中心。选出初始点后,就继续使用标准的K-means算法了。

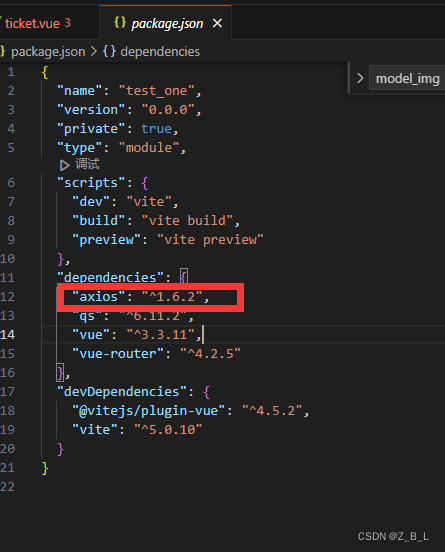

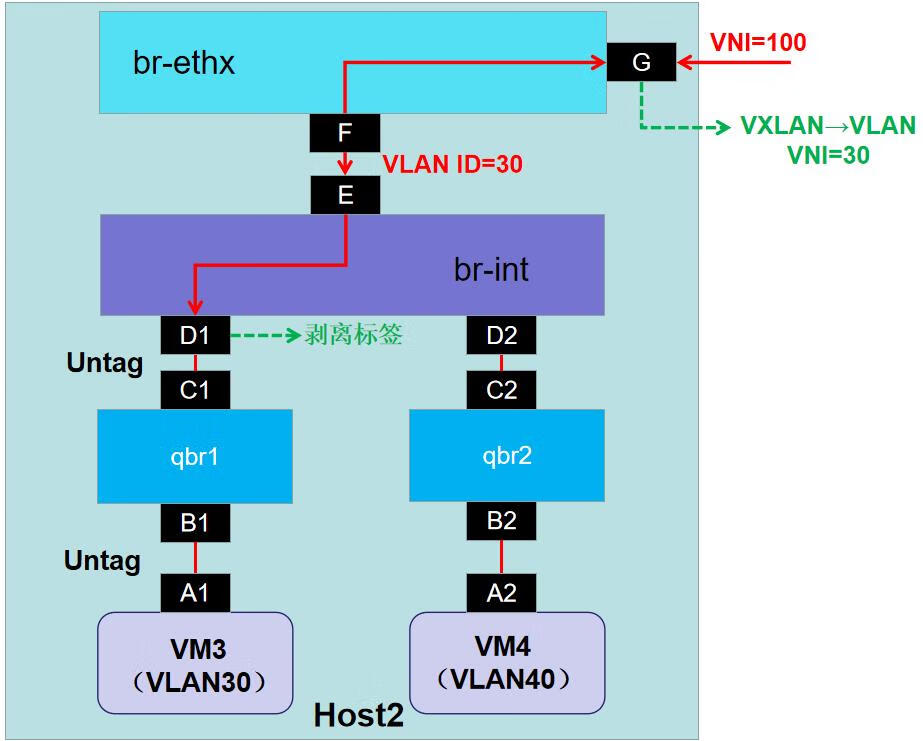

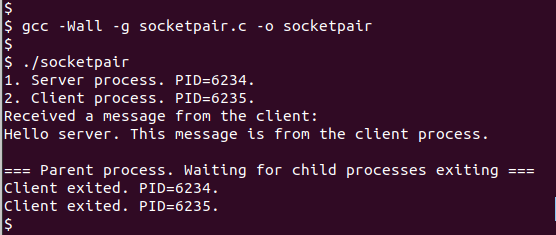

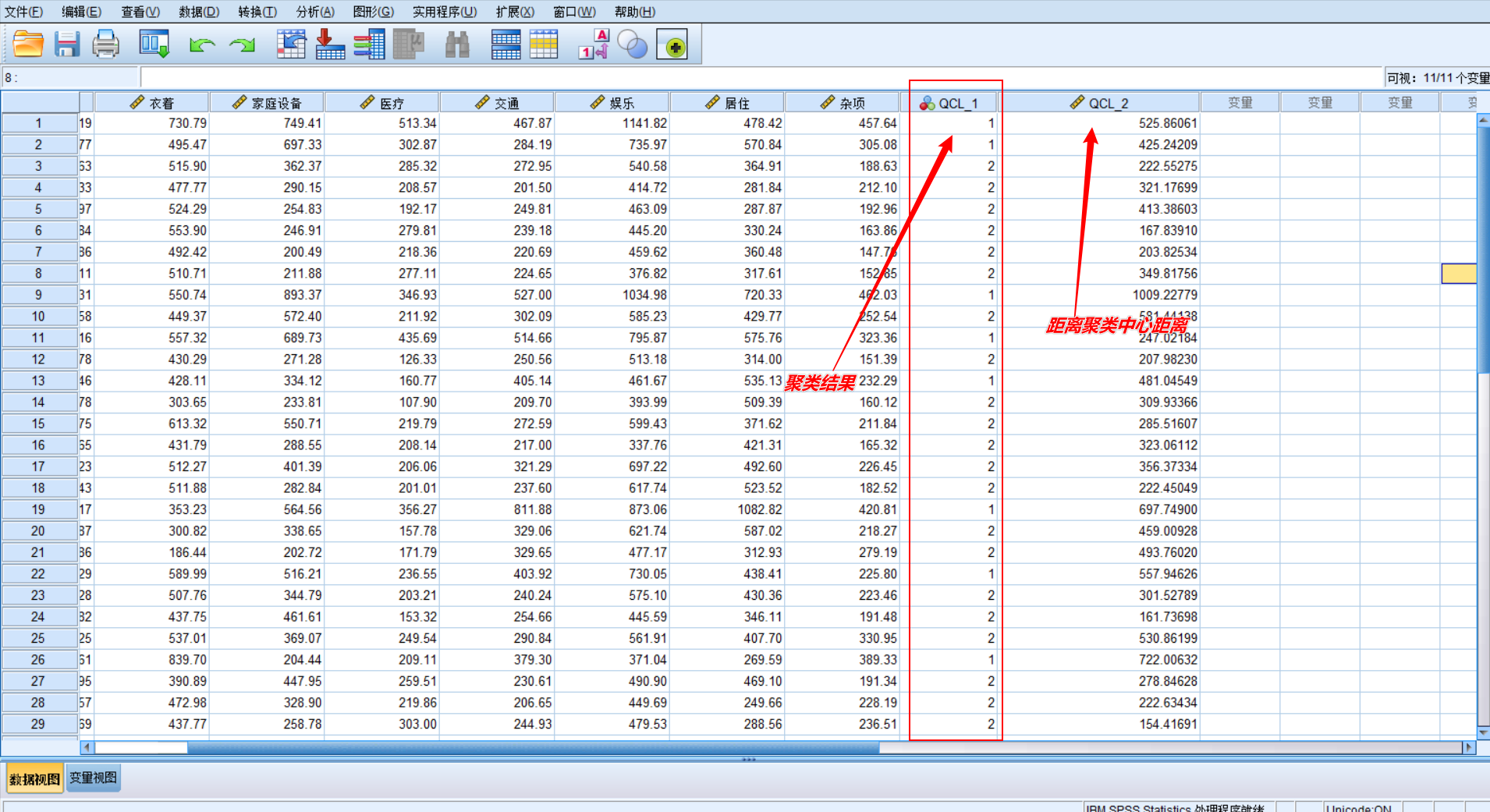

Spss操作之K-means

- 标准化

- 进入聚类

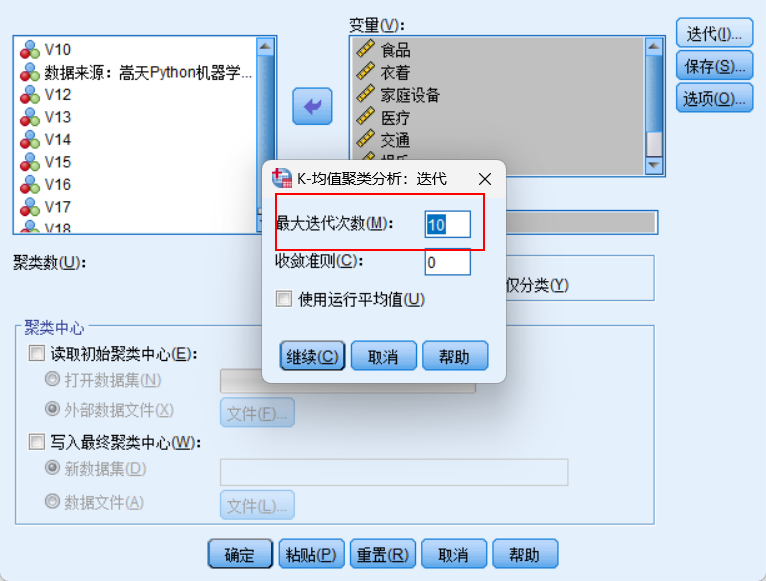

- 迭代次数修改

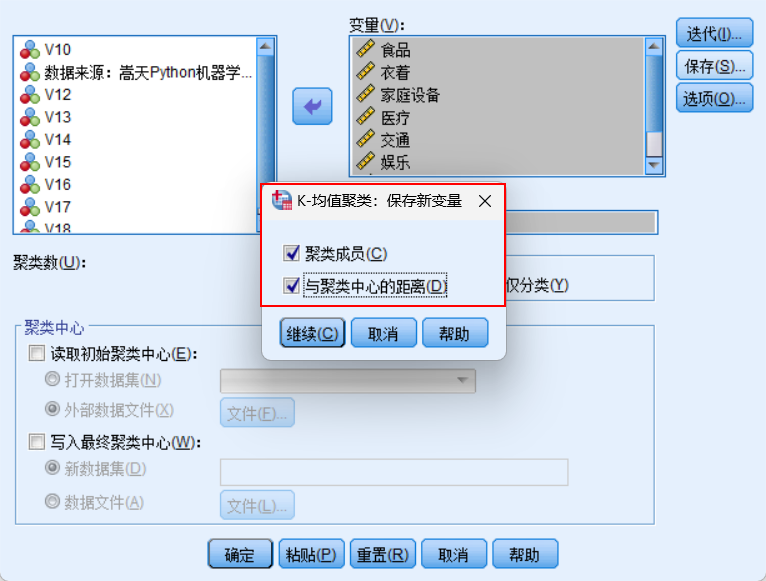

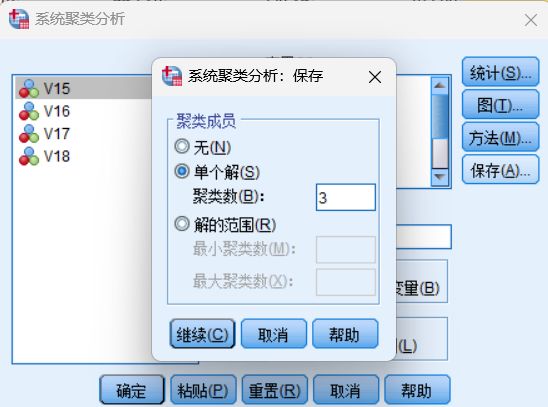

保存结果

结果显示

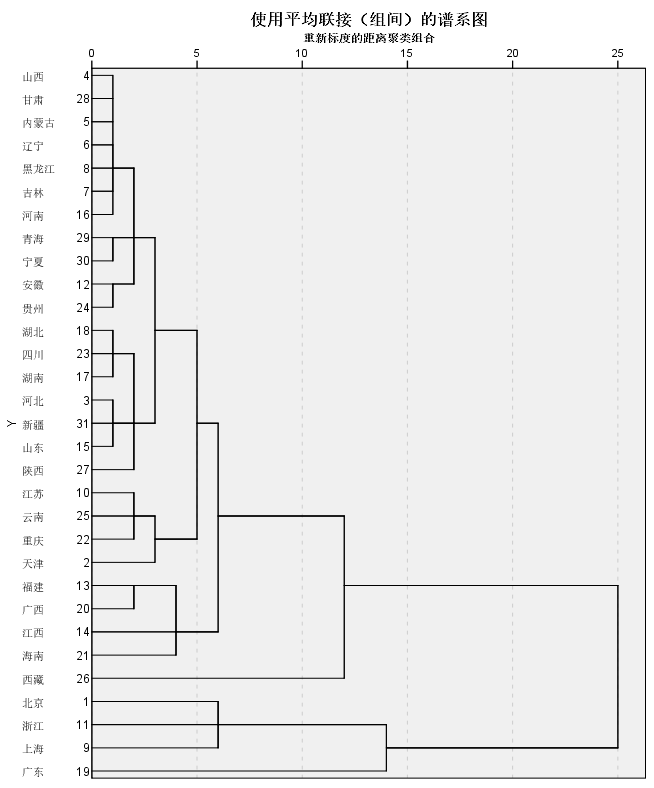

系统(层次)聚类

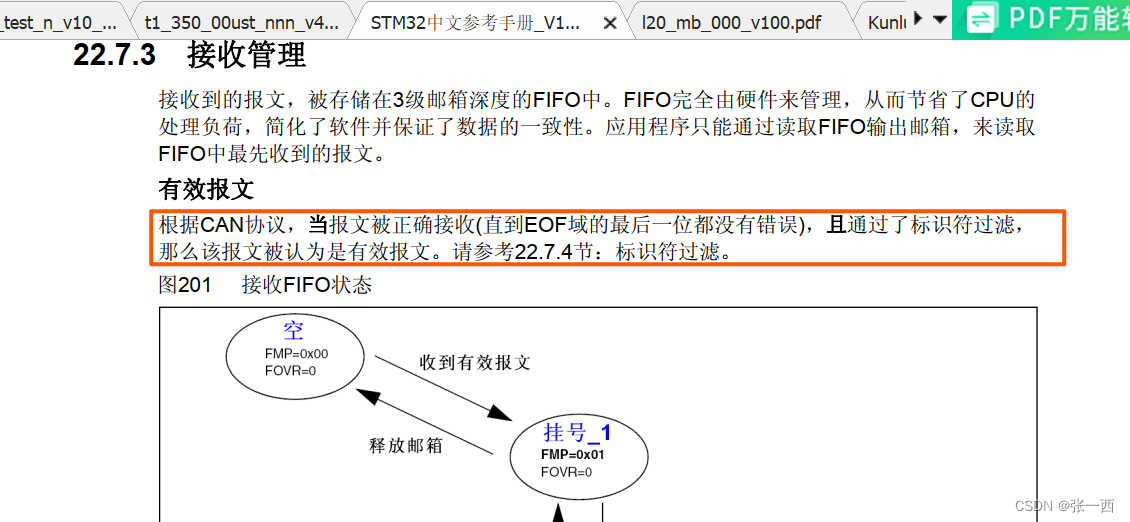

系统聚类的合并算法通过计算两类数据点间的距离,对最为接近的两类数据点进行组合,并反复迭代这一过程,直

到将所有数据点合成一类,并生成聚类谱系图。

这个两点的距离也是有很多种的(如图)

算法流程

系统(层次)聚类的算法流程:

一、将每个对象看作一类,计算两两之间的最小距离;

二、将距离最小的两个类合并成一个新类;

三、重新计算新类与所有类之间的距离;

四、重复二三两步,直到所有类最后合并成一类;

五、结束。

流程图

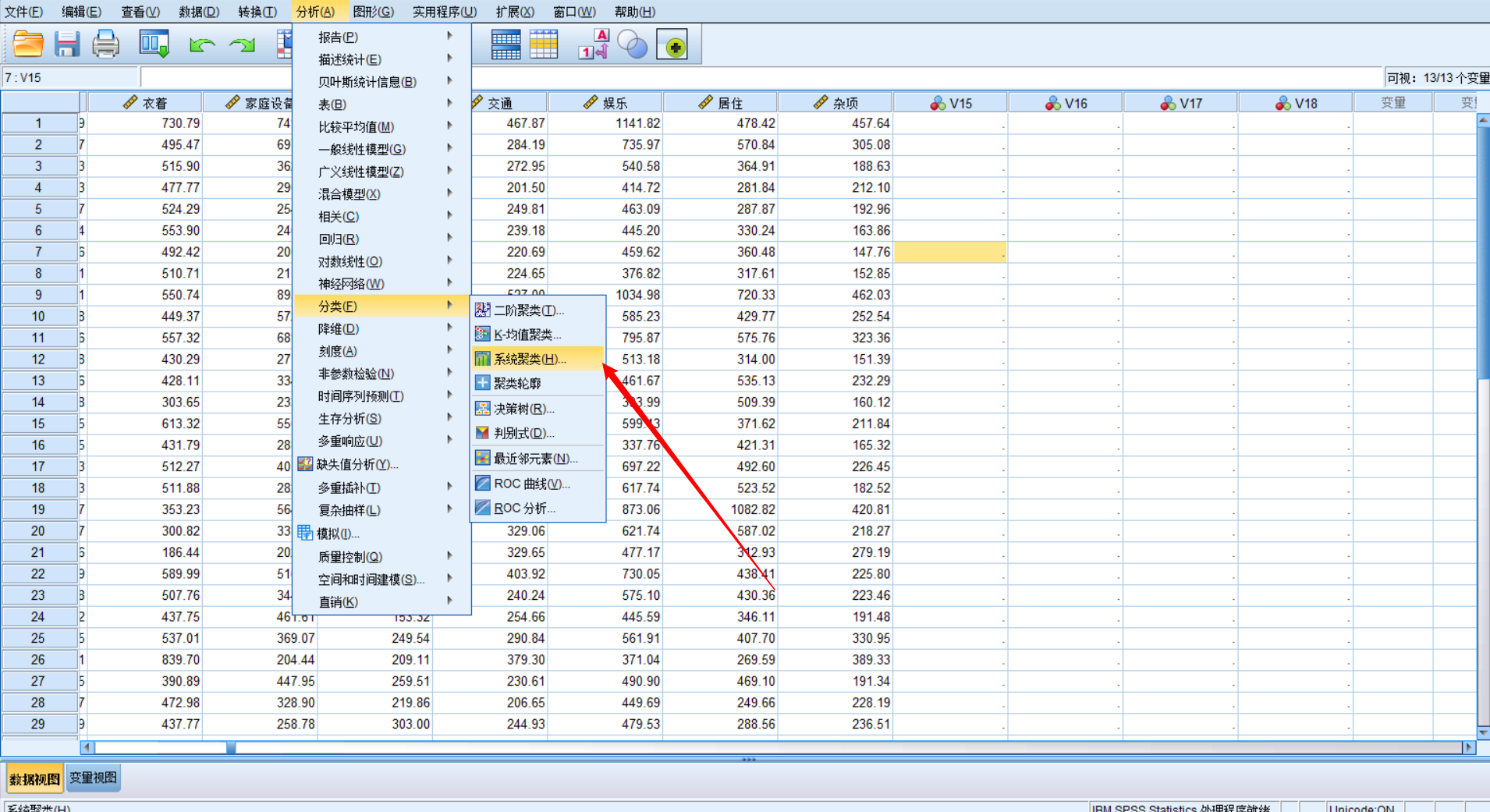

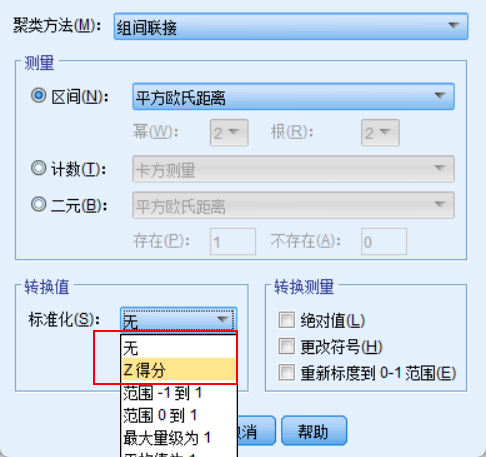

Spss操作

- 谱系图

- 标准化

- 得到结果

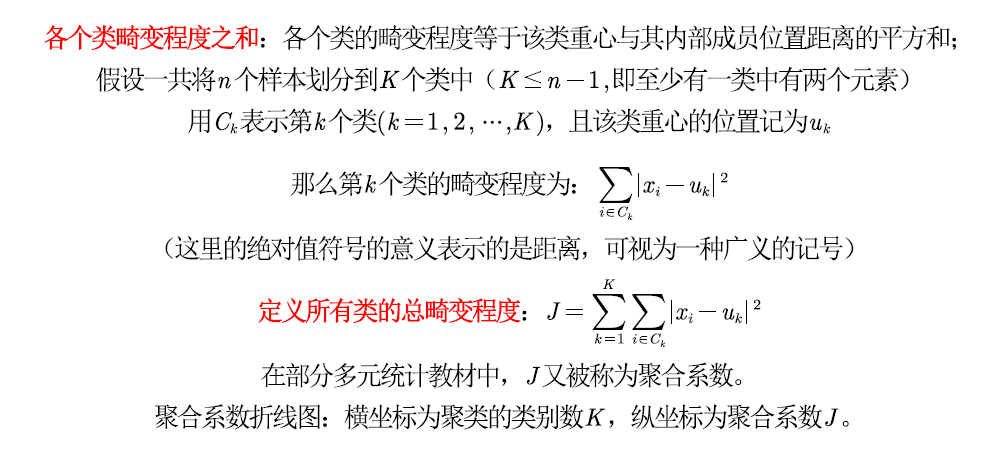

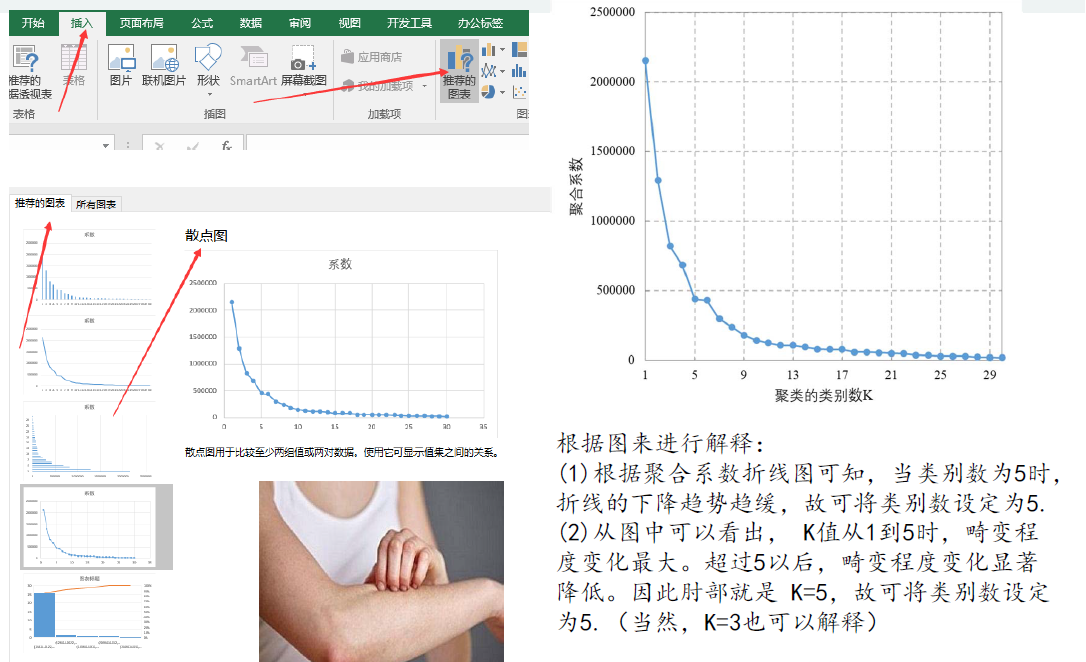

用图形估计聚类的数量

肘部法则(Elbow Method):通过图形大致的估计出最优的聚类数量。

画图前先对数据进行处理

聚合系数折线图的画法

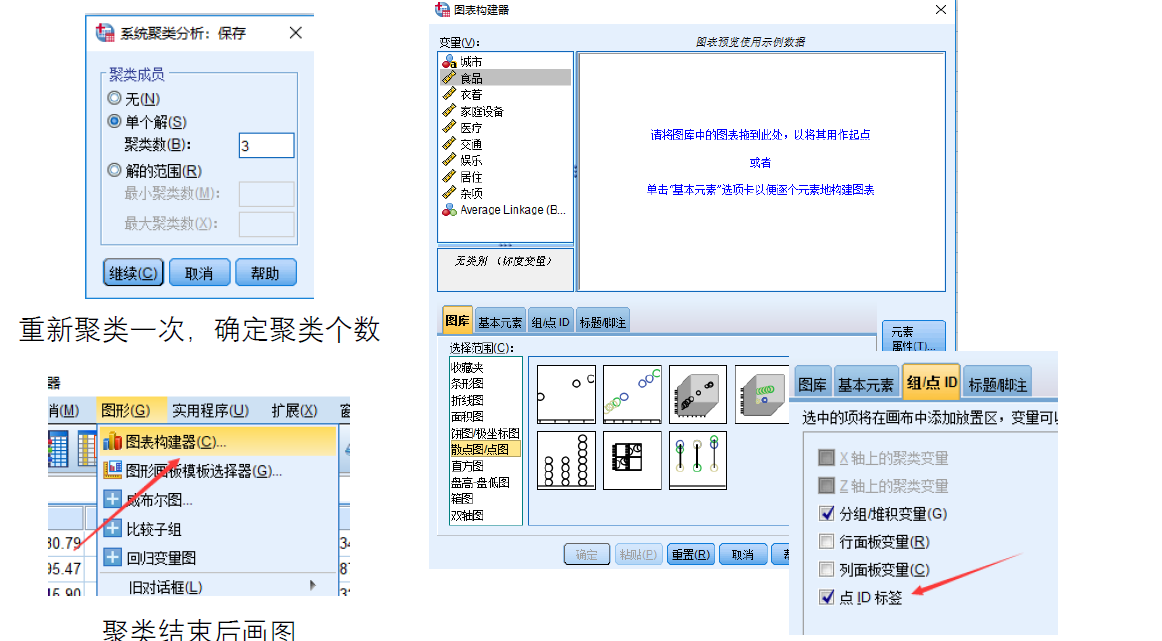

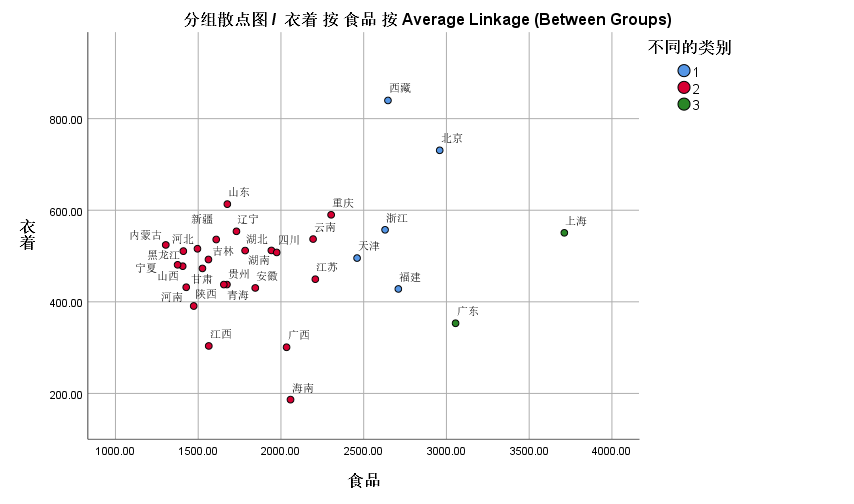

确定聚类数后作图

操作步骤:

结果样式

DBSCAN算法

DBSCAN(Density-based spatial clustering of applicationswith noise)是Martin Ester, Hans-PeterKriegel等人于1996年提出的一种基于密度的聚类方法,聚类前不需要预先指定聚类的个数,生成的簇的个数不定(和数据有关)。该算法利用基于密度的聚类的概念,即要求聚类空间中的一定区域内所包含对象(点或其他空间对象)的数目不小于某一给定阈值。该方法能在具有噪声的空间数据库中发现任意形状的簇,可将密度足够大的相邻区域连接,能有效处理异常数据。

谁和我挨的近,我就是谁兄弟,兄弟的兄弟,也是我的兄弟

基本概念

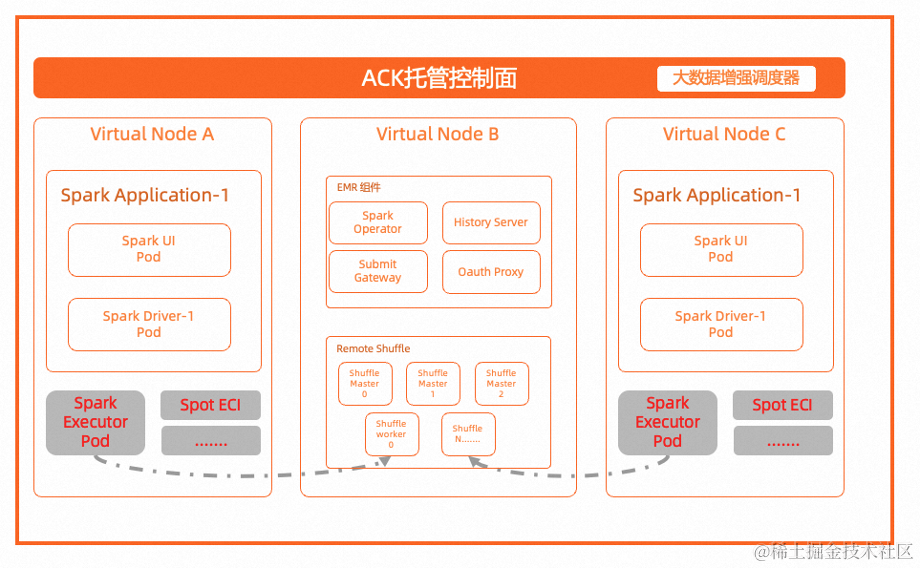

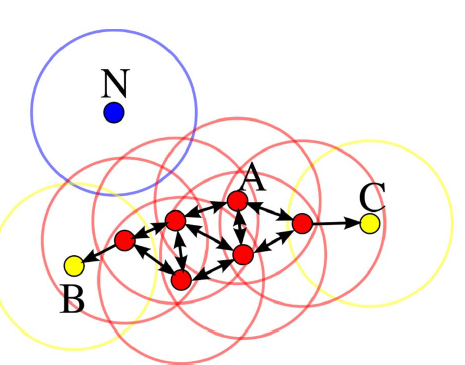

DBSCAN算法将数据点分为三类:

• 核心点:在半径Eps内含有不少于MinPts数目的点

• 边界点:在半径Eps内点的数量小于MinPts,但是落在核心

点的邻域内

• 噪音点:既不是核心点也不是边界点的点

例子:

在这幅图里,MinPts = 4,点A 和其他红色点是核心点,因为它们的ε-邻域(图中红色圆圈)里包含最少4 个点(包括自己),由于它们之间相互相可达,它们形成了一个聚类。点B 和点C 不是核心点,但它们可由A 经其他核心点可达,所以也和A属于同一个聚类。点N 是局外点,它既不是核心点,又不由其他点可达。

DBSCAN算法可视化

https://www.naftaliharris.com/blog/visualizing‐dbscan‐clustering/

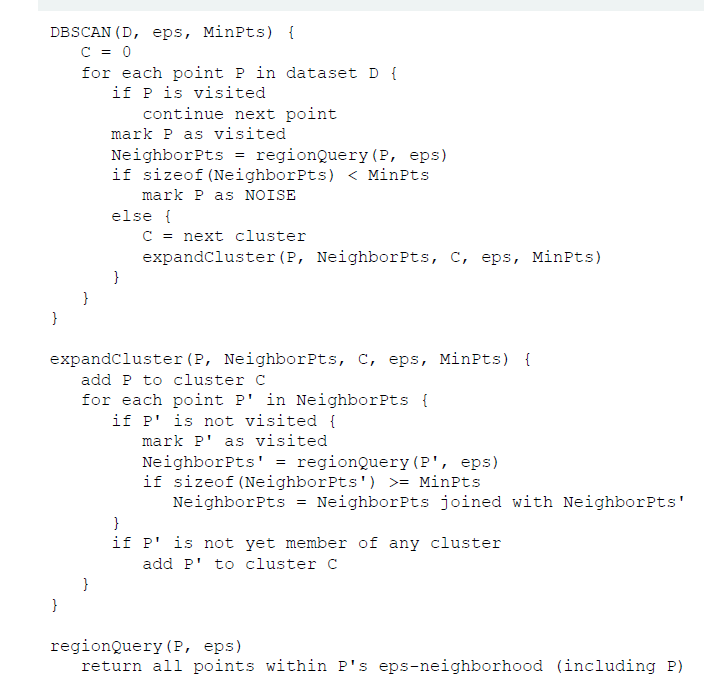

伪代码

欢迎关注微信公众号:

本文由博客一文多发平台 OpenWrite 发布!