简单介绍下梯度消失和梯度爆炸,这个不是重点,但是我觉得有必要再深入了解这个概念,以及很多激活函数为什么是可以防止梯度消失的。

梯度消失和梯度爆炸实际上是在神经网络训练过程中经常会遇到的两类问题,这两类问题都与梯度有关。

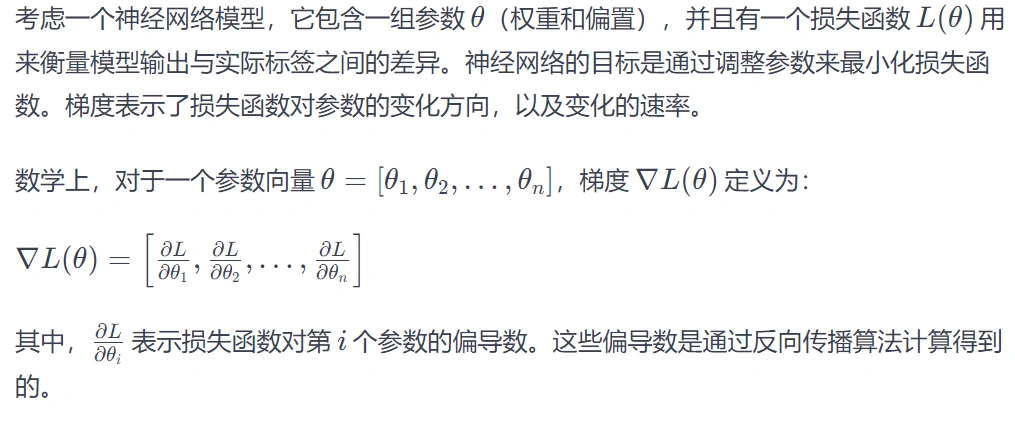

什么是梯度

在神经网络训练中,梯度是指损失函数相对于网络参数的偏导数。

损失函数是用来判断预测值与真实值的差距的函数,损失函数的值越小,说明预测值与真实值越接近。

梯度则表示了损失函数相较于网络中参数的变化率。它告诉我们在当前训练的参数值下,沿着哪个方向能够最大程度地减小损失函数的值,这也是我们希望可以看到的。

梯度的负方向是损失函数下降最快的方向,因此可以用梯度下降法来优化更新梯度,沿着负梯度的方向更新参数,以减小损失函数。这一过程会在训练过程中不断迭代,直到达到损失函数的最小值或收敛到一个稳定状态。

上面大概介绍了梯度的概念,大概理解梯度是用来更新权重的即可。

梯度消失

梯度消失指的是,梯度在反向传播的过程中,传着传着就没了。

怎么没的呢?

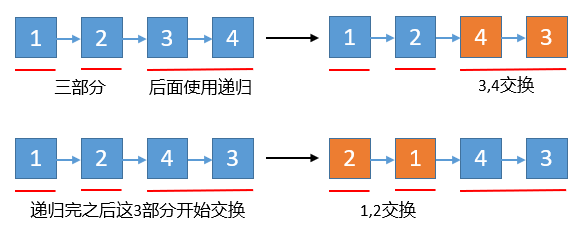

反向传播是基于一层接着一层的链式求导法则来从后往前传播的。

假设最后一层算出来的梯度为0.1,前一层算出来的梯度为0.1,那么两者相乘变成了