在当今的大数据时代,实时数据处理和分析已经变得至关重要。为了实现实时数据集成和分析,组合使用Apache Kafka和Apache Spark Streaming是一种常见的做法。本文将深入探讨如何使用Kafka与Spark Streaming进行流数据集成,以及如何构建强大的实时数据处理应用程序。

什么是Kafka?

Apache Kafka是一个高吞吐量、分布式、持久性的消息系统,用于发布和订阅流数据。它具有以下关键特性:

-

分布式:Kafka可以在多个服务器上运行,以实现高可用性和扩展性。

-

持久性:Kafka可以持久化数据,确保数据不会丢失。

-

发布-订阅模型:Kafka使用发布-订阅模型,允许生产者发布消息,而消费者订阅感兴趣的消息主题。

-

高吞吐量:Kafka能够处理大量消息,适用于实时数据流。

什么是Spark Streaming?

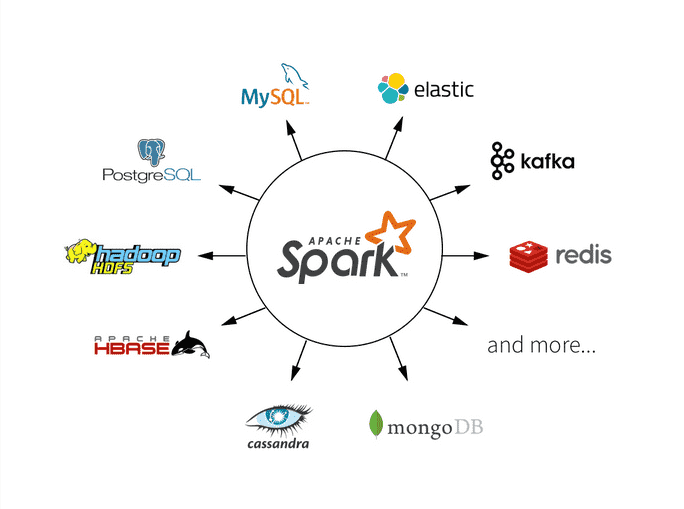

Spark Streaming是Apache Spark的一个模块,用于实时数据处理和分析。它可以从各种数据源接收实时数据流,如Kafka、Flume、Socket等,并在小的时间窗口内对数据进行批处理处理。Spark Streaming使用DStream(离散流)来表示数据流,允许开发人员使用Spark的API来进行实时数据处理。

使用Kafka与Spark Streaming集成

为了将Kafka与Spark Streaming集成,需要执行以下步骤:

1 配置Kafka

首先,确保已经安装和配置了Kafka。需要创建一个Kafka主题(topic)来存储实时数据流。Kafka主题是消息的逻辑容器,用于将消息组织在一起。

2 创建Spark Streaming应用程序

接下来,创建一个Spark Streaming应用程序,并配置它以连接到Kafka主题。以下是一个示例:

from pyspark.streaming.kafka import KafkaUtils

from pyspark.streaming import StreamingContext# 创建StreamingContext,每隔一秒处理一次数据

ssc = StreamingContext(spark, 1)# 定义Kafka连接参数

kafka_params = {"bootstrap.servers": "localhost:9092", # Kafka集群的地址"group.id": "my-group", # 消费者组ID"auto.offset.reset": "largest" # 从最新的消息开始消费

}# 创建一个DStream,连接到Kafka主题

kafka_stream = KafkaUtils.createStream(ssc,"localhost:2181", # ZooKeeper地址"my-group", # 消费者组ID{"my-topic": 1} # 指定主题和线程数

)# 对数据流进行处理

kafka_stream.map(lambda x: x[1]).pprint() # 打印消息内容# 启动StreamingContext

ssc.start()# 等待终止

ssc.awaitTermination()

在上面的示例中,创建了一个StreamingContext,并配置它以连接到Kafka主题。使用KafkaUtils.createStream创建一个DStream,连接到Kafka主题,并使用pprint打印消息内容。

3 处理数据流

一旦配置了Spark Streaming应用程序来连接到Kafka主题,可以使用Spark的API来处理数据流。例如,可以使用map、filter等操作来对数据进行转换和过滤。

以下是一个示例,演示如何使用Spark Streaming从Kafka接收数据并计算每个单词的出现次数:

# 从Kafka接收数据

kafka_stream = KafkaUtils.createStream(ssc,"localhost:2181","my-group",{"my-topic": 1}

)# 对数据进行转换和处理

words = kafka_stream.flatMap(lambda line: line[1].split(" ")) # 按空格拆分单词

word_counts = words.countByValue() # 计算每个单词的出现次数# 打印每个单词的出现次数

word_counts.pprint()# 启动StreamingContext

ssc.start()# 等待终止

ssc.awaitTermination()

在上面的示例中,使用flatMap将每个消息拆分为单词,然后使用countByValue计算每个单词的出现次数,并使用pprint打印结果。

性能优化和注意事项

在使用Kafka与Spark Streaming进行流数据集成时,有一些性能优化和注意事项:

-

并行度设置:根据数据流的速度和应用程序的需求来设置适当的并行度,以确保数据可以及时处理。

-

检查点:如果您的应用程序需要容错性,考虑定期将DStream状态保存到检查点,以便在应用程序重新启动时恢复状态。

-

Kafka配置:在配置Kafka时,了解Kafka的参数和配置选项,以确保连接和消费数据的稳定性和性能。

总结

使用Kafka与Spark Streaming进行流数据集成是构建实时数据处理应用程序的强大方法。本文介绍了Kafka和Spark Streaming的基本概念,并提供了一个示例应用程序,演示了如何从Kafka接收实时数据流并进行处理。希望本文能够帮助大家入门Kafka与Spark Streaming的集成,以构建强大的实时数据处理解决方案。