本地部署 Ollama

- 0. Ollama 能帮我们做什么

- 1. 下载 Ollama

- 2. 安装 Ollama

- 3. 使用 Ollama

- 4. Ollama 和 Langchain 的集成

0. Ollama 能帮我们做什么

在本地启动并运行大型语言模型。

运行 Llama 2、Code Llama 和其他模型。自定义并创建自己的。

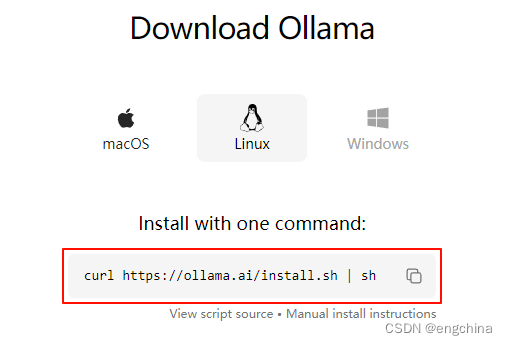

1. 下载 Ollama

访问 https://ollama.ai/download,根据你使用的系统,下载相应版本。

这里以 Linux 为例。(20240107时点,还未支持 Windows)

2. 安装 Ollama

curl https://ollama.ai/install.sh | sh

3. 使用 Ollama

访问 https://ollama.ai/library,检索你想使用的模型,然后执行下面命令运行,以 llama2 为例

ollama run llama2

4. Ollama 和 Langchain 的集成

后续有需要时,在补充详细说明。

参考地址:

-

https://python.langchain.com/docs/integrations/chat/ollama

-

https://python.langchain.com/docs/integrations/chat/ollama_functions

完结!