资料

- 课程主页:https://speech.ee.ntu.edu.tw/~hylee/ml/2023-spring.php

- Github:https://github.com/Fafa-DL/Lhy_Machine_Learning

- B站课程:https://space.bilibili.com/253734135/channel/collectiondetail?sid=2014800

一、大语言模型的两种期待和使用

BERT:专才

- 简介:BERT是一个语言模型,对其进行改造(加外挂+微调参数),成为不同领域的专才(BERT只会进行文字填空,无法像GTP一样写出句子说话)

- 本质:文字填空

- 发展:专才 (单一任务完成度优秀,eg:专用于翻译的模型)

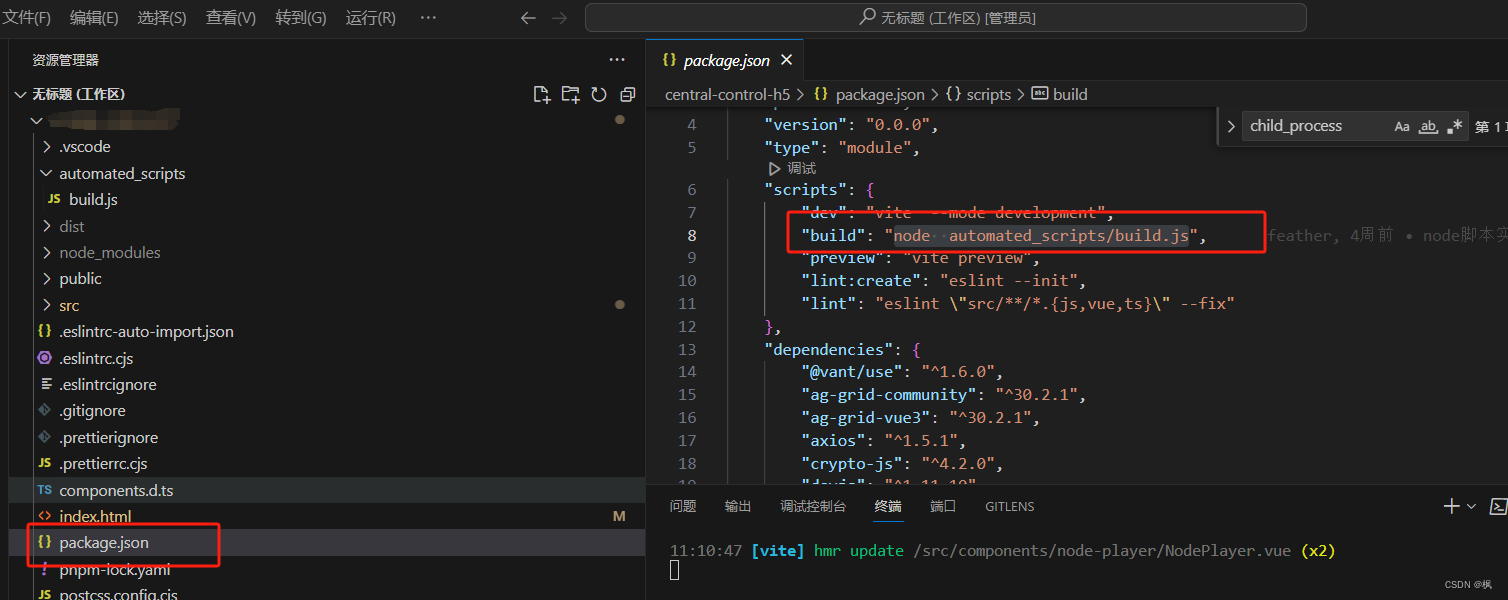

- 使用方式:

-

(1)加外挂Head:

-

(2)Fintune(微调参数):

-

(3)Adapter(局部微调):

-

GPT:通才

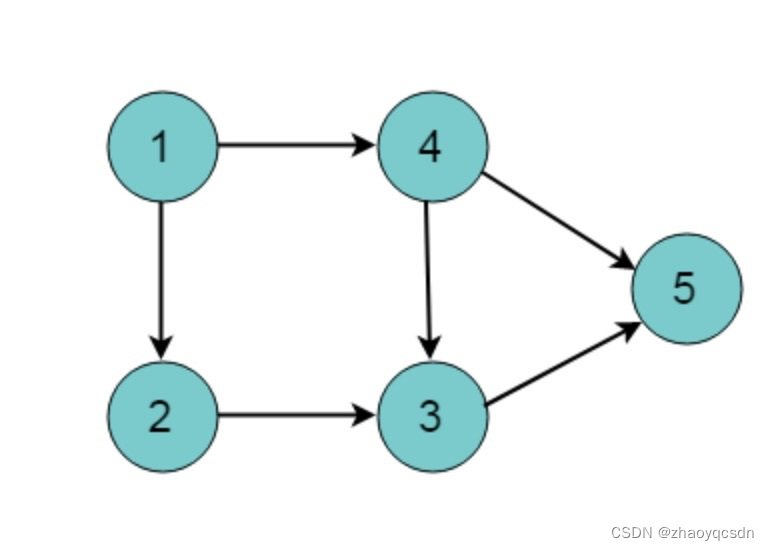

- 简介: 机器要学会读题目叙述Instruction Learning或题目范例In-context Learning

- 本质:文字接龙

- 发展:通才(只要重新设计Prompt,即可快速开发新功能不用写程式,eg:)

- 使用方式:见二

- Instruction Learning

- In-context Learning

- Chain of Thought (CoT) Prompting