No.70

智源社区

预训练组

预

训

练

研究

观点

资源

活动

周刊订阅

《预训练周刊》已经开启“订阅功能”,扫描下面二维码,进入《预训练周刊》主页,选择“关注TA”,即可收到推送消息。

关于周刊

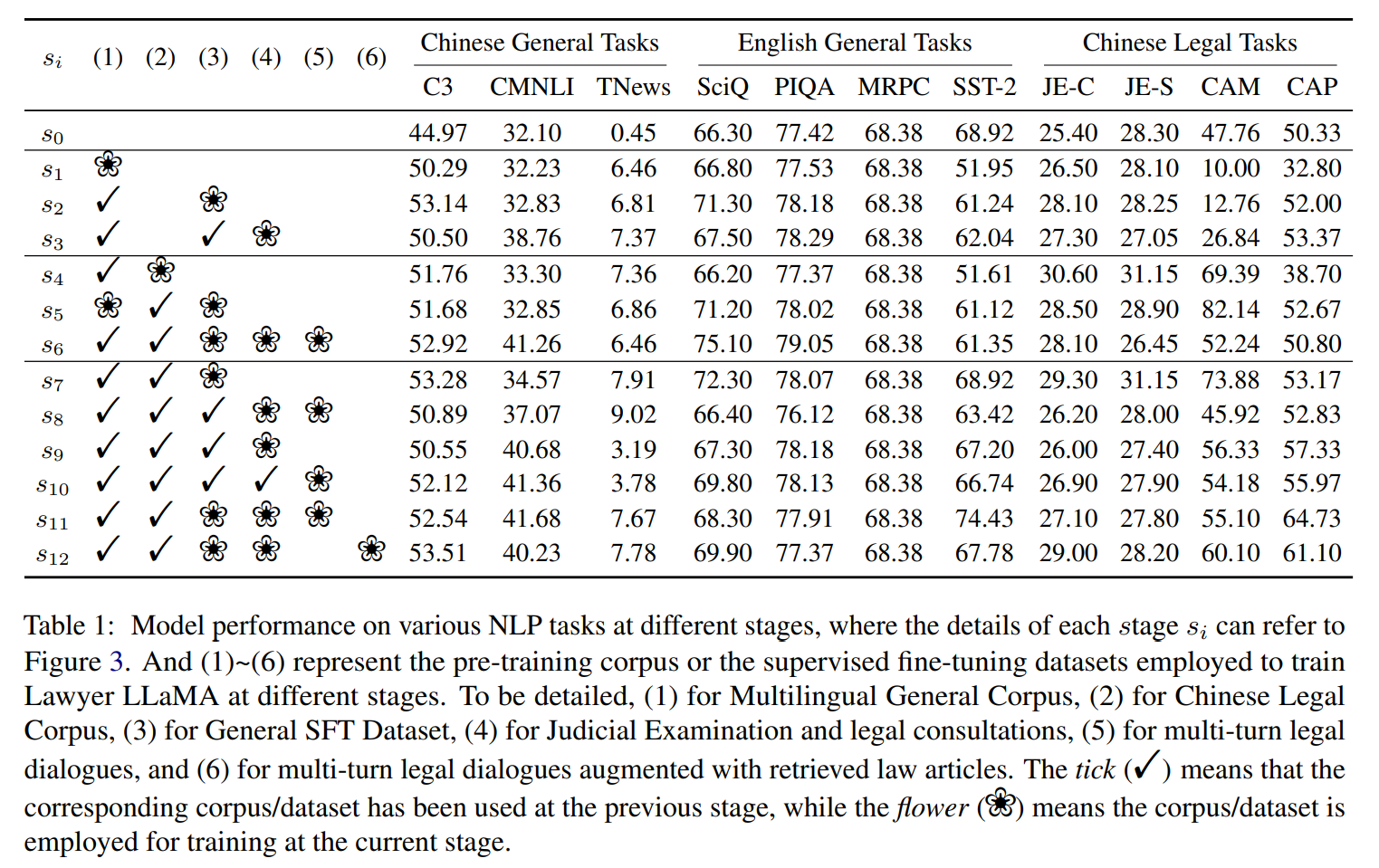

本期周刊,我们选择了12篇来自国内外知名研究机构的预训练相关的论文:多模态话题包括one-shot视频生成、视频摘要;自然语言话题包括情绪分析,无注意力预训练,大模型剪枝、语境学习、反向链推理;生命科学话题包括临床知识理解和抗体预训练。综述方面包括知识增强、稠密检索、语境学习的3篇综述;另外我们选择了3篇热点应用资讯,包括3个有趣的大模型使用案例,司法考试应试者、鼓手和企业说客。

(本期贡献者:翟珂 吴新刚)

论文推荐

多模态研究

标题:新加坡国立大学、腾讯 | Tune-A-Video: One-Shot Tuning of Image Diffusion Models for Text-to-Video Generation(文本生成视频的图像扩散模型的单样本调优)

作者:Jay Zhangjie Wu , Yixiao Ge , Xintao Wang , 等

简介:本文研究在Text2Video生成领域引入扩散模型。为了再现文本到图像(T2I)的成功生成,最近的文本到视频生成(T2V)工作使用大规模文本-视频数据集进行微调。然而,这种范式在计算上很昂贵。人类有惊人的能力从一个范例中学习新的视觉概念。作者针对性研究并提出了一个新的T2V生成问题,即单样本视频生成,其中仅呈现单个文本视频对来训练开放域T2V生成器。作者建议将基于海量图像数据预处理的T2I扩散模型用于T2V生成。作者做了两个关键观察:1)T2I模型能够生成与动词术语很好地对齐的图像;2) 扩展T2I模型以同时生成多个图像显示出令人惊讶的良好内容一致性。本文提议的方案能够在各种应用程序(如主题或背景的改变、属性编辑、风格转换)上生成时间连贯的视频,证明了作者方法的通用性和有效性。

论文:https://arxiv.org/pdf/2212.11565.pdf

解析: https://hub.baai.ac.cn/view/23106

标题:人大、巴黎文理研究大学、哔哩哔哩 | Translating Text Synopses to Video Storyboards(将文本概要转换为视频情节提要)

作者:Xu Gu, Yuchong Sun, Feiyue Ni, 等

简介:本文研究Text2Video生成领域的文本生成故事板任务。故事板是视频创作的路线图,它由逐个镜头的图像组成,以可视化文本概要中的关键情节。然而,创建视频故事板仍然具有挑战性,这不仅需要高级文本和图像之间的关联,还需要长期推理以使镜头之间的过渡平滑。在本文中,作者提出了一项称为文本概要到视频故事板 (TeViS) 的新任务,旨在检索有序的图像序列以可视化文本概要。作者基于公共 MovieNet 数据集构建了 MovieNet-TeViS 基准。它包含 10K 文本概要,每个文本概要都与关键帧配对,这些关键帧是通过考虑相关性和电影连贯性从相应电影中手动选择的。实验结果表明:作者提出的模型在创建与文本相关且连贯的故事板方面明显优于其他模型。

论文:https://arxiv.org/pdf/2301.00135.pdf

解析:https://hub.baai.ac.cn/view/23105

NLP研究

标题:伊朗Birjand大学 | Russia-Ukraine war: Modeling and Clustering the Sentiments Trends of Various Countries(俄乌战争:对各国的情绪趋势进行建模和聚类)

作者:Hamed Vahdat-Nejad, Mohammad Ghasem Akbari, Fatemeh Salmani,等

简介:本文是BERT情绪识别任务在当前世界时事的具体应用。随着 Twitter 的发展和流行,用户就各种主题分享了大量的观点,使该平台成为各种政治、社会和经济问题的宝贵信息来源。本文调查了有关俄乌战争的英文推文,以分析反映用户对冲突的看法和情绪的趋势。使用基于 BERT 的模型分析推文的正面和负面情绪,并计算与各个国家的正面和负面推文频率相关的时间序列。然后,作者提出了一种基于邻域平均值的方法,用于对国家时间序列进行建模和聚类。聚类结果为了解有关这场冲突的公众舆论提供了宝贵的见解。

论文:

https://arxiv.org/ftp/arxiv/papers/2301/2301.00604.pdf

解析:https://hub.baai.ac.cn/view/23137

标题:康奈尔大学、DeepMind、Hugging Face联合 | Pretraining Without Attention(无注意力的预训练)

作者:Junxiong Wang , Jing Nathan Yan , Albert Gu等

简介:本文研究无注意的预训练、并实现了更长序列的处理。Transformer对于 NLP 预训练的成功至关重要。已经使用了其他架构,但需要注意层来匹配基准精度。这项工作探索了无需注意的预训练。作者测试了最近开发的基于状态空间模型 (SSM) 的路由层和基于乘法门控的模型架构。这些建模选择一起使用会对预训练准确性产生很大影响。根据经验,拟议的双向门控 SSM (BiGS) 无需注意即可复制 BERT 预训练结果,并且在无需近似的情况下:可以扩展到 4096 个令牌的长格式预训练 。

论文:https://arxiv.org/pdf/2212.10544.pdf

解析:https://hub.baai.ac.cn/view/23110

标题:奥地利科技学院 | Massive Language Models Can Be Accurately Pruned in One-Shot(大规模语言模型的一次性精确剪枝)

作者:Elias Frantar, Dan Alistarh

简介:本文研究专门针对GPT家族中大语言模型的新剪枝方法。作者首次展示了大规模生成预训练Transformer(GPT) 系列模型可以一次性修剪到至少 50% 的稀疏性,而无需任何重新训练,并且精度损失最小。这是通过一种称为 SparseGPT 的新剪枝方法实现的,该方法专门设计用于在大规模 GPT 系列模型上高效准确地工作。在最大的可用开源模型 OPT-175B 和 BLOOM-176B 上执行 SparseGPT 时,作者可以达到 60% 的稀疏度,而困惑度的增加可以忽略不计。值得注意的是,在推理时可以忽略来自这些模型的超过 1000 亿个权重。SparseGPT 泛化为半结构化(2:4 和 4:8)模式,并且与权重量化方法兼容。作者推测此类大型模型未来可能可以实现至少80-90%的稀疏性。

论文:https://arxiv.org/pdf/2301.00774.pdf

解析:https://hub.baai.ac.cn/view/23109

标题:北大、清华、微软 | Why Can GPT Learn In-Context? Language Models Secretly Perform Gradient Descent as Meta-Optimizers(为什么 GPT 可以在上下文中学习?语言模型作为元优化器秘密执行梯度下降)

作者:Damai Dai, Yutao Sun, Li Dong, Yaru Hao,等

简介:本文聚焦研究大型预训练语言模型的上下文学习 (ICL) 能力。尽管大模型在性能上取得了巨大成功,但 ICL 的工作机制仍然是一个悬而未决的问题。为了更好地理解 ICL 的工作原理,本文将语言模型解释为元优化器,并将 ICL 理解为一种隐式微调。从理论上讲,作者发现 Transformer 注意力具有基于梯度下降的双重优化形式。在此之上,作者对ICL的理解是这样的:GPT首先根据示例产生meta-gradients,然后将这些meta-gradients应用到原来的GPT中来构建ICL模型。实验结果证明:ICL 在预测级别、表示级别和注意行为级别的行为类似于显式微调。此外,受元优化的理解的启发,作者通过类比基于动量的梯度下降算法设计了一种基于动量的注意力,结果始终优于 vanilla attention 的性能。

论文:https://arxiv.org/pdf/2212.10559.pdf

解析:https://hub.baai.ac.cn/view/22972

标题:谷歌 | LAMBADA: Backward Chaining for Automated Reasoning in Natural Language(LAMBADA:自然语言自动推理的反向链)

作者:Seyed Mehran Kazemi, Najoung Kim等

简介:本文介绍了反向链算法LAMBADA,将经典推理文献中得出的反向推理效率明显高于前向推理这一结论应用于语言模型中。以前用语言模型进行推理的方法大多采用前向链式推理的思路,要求从整个集合中选择一个事实和规则的子集;这对语言模型过来说可能是困难的,因为它需要在一个大的空间里进行组合搜索。而后向链式推理,即从目标出发,将其递归分解为子目标,直到子目标可以根据事实被证明或推翻。该算法将推理过程分解为四个子模块,每个模块都由小样本提示语言模型推理实现。相比当下SOTA的前向推理方法,最终LAMBADA在两个逻辑推理数据集上实现了显著的性能提升;特别是在问题要求深度和准确的证明链情况下,LAMBADA的性能提升更加明显。

论文: https://arxiv.org/pdf/2212.13894.pdf

解析:https://hub.baai.ac.cn/view/23156

生命科学研究

标题:谷歌、Deepmind | Large Language Models Encode Clinical Knowledge(大型语言模型编码医疗临床知识)

作者:Karan Singhal, Shekoofeh Azizi等

简介:本文介绍了大模型理解临床知识的能力。本文提出了MultiMedQA,一个结合了六个现有的公开问答数据集的基准,涵盖了专业考试、研究和消费者医学问题。本文提出了一个框架,用于沿着多个维度对模型答案进行人工评估,包括事实性、精确度、可能的伤害和偏见。此外,本文还在MultiMedQA上评估了PaLM及其指令微调的变体Flan-PaLM。通过结合小样本、CoT、提示策略,Flan-PaLM在MultiMedQA的每一个多选题数据集上都达到了最优的准确率。另外本文引入了指令提示调整,训练了Med-PaLM模型,它的表现更好但仍然比临床医生差。本文表明:理解力、知识和医学推理随着模型规模和指令提示的调整而改善,这展示LLMs在医学中的潜在应用空间。

论文:https://arxiv.org/pdf/2211.13672v1.pdf

解析:https://hub.baai.ac.cn/view/23073

标题:ICLR2023 | On Pre-training Language Model for Antibody(用于抗体的预训练语言模型)

简介:本文介绍了抗体预训练。抗体是一种重要的蛋白质,被广泛的应用于疾病诊断和治疗。本文全面地探讨不同的预训练语言模型在不同的抗体问题上的表现能力,提出了抗体的ATUE基准,并设计了两个抗体进化相关的预训练任务。本文回答了以下关键问题:预训练的语言模型在不同的抗体任务中表现如何?如果我们在预训练过程中引入特定的生物学机制,模型将获得多少好处?学得的抗体预训练表征在现实世界的抗体问题中是否有意义,如药物发现和免疫过程理解,最终证实与进化相关的目标有利于预测。作者还将抗体预训练用于药物发现,预测了每种抗体与 SARS-CoV-2 结合的概率,同时在没有准确的序列标签的情况下成功地识别了 11 种潜在的抗体。

论文 :

https://openreview.net/forum?id=zaq4LV55xHl

解析:https://hub.baai.ac.cn/view/23115

综述分享

标题:北京邮电大学、英国汤森路透 | A Survey on Knowledge-Enhanced Pre-trained Language Models(知识增强型预训练语言模型综述)

作者:Chaoqi Zhen , Yanlei Shang , Xiangyu Liu ,等

简介:本综述提供了当前快速发展的“知识增强型预训练语言模型”领域的全面视图。通过使用 BERT 等预训练语言模型 (PLM),自然语言处理 (NLP) 发生了革命性变化。尽管在几乎每一个 NLP 任务中都创造了新记录,但 PLM 仍然面临着许多挑战,包括可解释性差、推理能力弱,以及在应用于下游任务时需要大量昂贵的注释数据。通过集成外部知识增强型预训练语言模型(KEPLM),将具有潜力以克服上述限制。在本文中,作者通过一系列研究系统地回顾了 KEPLM。具体来说,作者概述了要集成到 KEPLM 中的常见类型和不同格式的知识,详细介绍了构建和评估 KEPLMS 的现有方法,介绍下游任务中的应用,并讨论未来的研究方向。

论文 :https://arxiv.org/pdf/2212.13428.pdf

解析:https://hub.baai.ac.cn/view/23107

标题:人大、百度 | 综述:全新视角回顾基于预训练语言模型的稠密检索

简介:本文是基于预训练语言模型稠密检索的综述。本篇综述从架构(architecture)、训练(training)、索引(indexing)和整合(integration)四个主要方面组织了相关研究,系统地回顾了基于预训练语言模型(PLM)的稠密检索的最新进展,文章还讨论了其在下游任务的应用,以及部分进阶主题。本篇综述尽量完整地涵盖了这一题目下的近期工作,引用了300余篇经典及最新的文献,为相关方向的研究者了解此领域提供全面、实用的参考。

论文 :https://arxiv.org/abs/2211.14876

解析:https://hub.baai.ac.cn/view/22953

标题:北大 | 综述论文:In-context Learning进展、挑战和方向

简介:本文是语境学习( in-context learning,ICL)的综述。本文对ICL的研究进展、面临的挑战以及未来的研究方向进行了综述和总结。作者首先给出了ICL的形式化定义,并阐明了其与相关研究的相关性。然后,作者组织讨论了ICL的先进技术,包括训练策略、激励策略等;最后,指出了ICL面临的挑战,并指出了进一步研究的方向。作者希望该综述工作能够促进更多关于揭示ICL工作原理和改进ICL的研究。

论文:https://arxiv.org/abs/2301.00234

解析:https://hub.baai.ac.cn/view/23037

热点应用

标题:斯坦福 | Large Language Models as Corporate Lobbyists(大型语言模型可以充当企业说客)

作者:John J. Nay

简介:本文展示了一个大型语言模型进行企业游说的概念验证。本文使用自回归大型语言模型(OpenAI text-davinci-003)来确定拟议的美国国会法案是否与特定的上市公司有关,并提供解释和置信水平。对于模型认为相关的法案,模型会起草一封给法案发起人的信,试图说服国会议员对拟议的立法进行修改。该实验使用数百个关于法案与公司相关性的真实标签来衡量模型的性能。另外本文也尝试用之前的OpenAI GPT-3模型(text-davinci-002)测试了确定法案相关性的能力,但其表现并不是很好。这些结果表明,随着大型语言模型不断提高核心自然语言理解能力,企业游说相关任务的性能将继续提高。最后本文讨论了为什么这可能会对社会-人工智能的关系产生影响。如果人工智能开始影响法律本身,这将威胁到法律对人类社会秩序的关键作用。

论文 :https://arxiv.org/pdf/2301.01181v1.pdf

解析:https://hub.baai.ac.cn/view/23111

标题:宾大 | Language Models are Drummers: Drum Composition with Natural Language Pre-Training(语言模型是鼓手:使用自然语言预训练的鼓乐创作)

作者:Li Zhang, Chris Callison-Burch

简介:本文展示了一个大型语言模型进行音乐创作的案例。用人工智能自动生成音乐通常需要大量的数据,而对于许多不太常见的流派和乐器来说,这是很难获得的。为了解决这个问题,本文探讨了深度学习模型将知识从语言转移到音乐的可能性,在仅有的几百个鼓乐的MIDI文件上对语言模型进行微调。本文表明,通过这样做语言模型GPT3能够生成合理的鼓乐,而没有经过预训练的模型除了简单的重复之外,无法显示出音乐的能力。本文提出了一个专门的评估方法,并分析了由GPT3生成的鼓乐与人类专业人员演奏的鼓乐的比较,展示了这种通过语言到音乐转换的生成的优势和劣势。本文的研究结果表明,用大型语言模型进行语言到音乐的迁移学习是可行的。

论文 :https://arxiv.org/pdf/2301.01162v1.pdf

解析:https://hub.baai.ac.cn/view/23144

标题:CodeX等 | GPT Takes the Bar Exam(语言模型参加司法考试)

作者:Michael Bommarito II, Daniel Martin Katz

简介:本文展示了大型语言模型在司法考试上的表现。本文记录了OpenAI的 "text-davinci-003 "模型(通常被称为GPT-3.5)在考试的多选(MBE)部分的表现的实验评估。作者对GPT-3.5进行了提示工程、超参数优化以及微调的尝试。结果发现,超参数优化和提示工程对成绩表现有积极影响,而微调没有任何效果。对于最佳提示和参数,最终在完整的MBE练习考试中达到了50.3%的平均正确率,大大超过了25%的基线猜测率。GPT-3.5对答案排序与正确性有很强的相关性,Top2和Top3的选择分别有71%和88%的正确率。其中“Top2”的准确率全都超过了极限,有五个类别均超过了人类平均水平。而“Top3”的准确度更高,在证据这一表现中甚至达到了98%。这也证实了模型对法律领域的一般理解,而非随机猜测。未来作者将进一步对法考的其他两部分:作文和情景表现进行上述的研究。

论文 :https://arxiv.org/abs/2212.14402

解析:https://hub.baai.ac.cn/view/23059

关于周刊

周刊采用社区协作的模式产生,欢迎感兴趣的朋友们参与我们的工作,一起来推动预训练学习社群的分享、学习和交流活动。您可添加yuzhong125微信号和智源社区取得联系。

更多阅读

2022年「预训练」优秀论文盘点

《预训练周刊》第68期:不同通用基础模型:机器人、文本处理/嵌入、视频,Huggingface谈chatGPT原理

《预训练周刊》第67期:ChatGPT引起热议、量化技术、Meta图像掩码加速CLIP

《预训练周刊》第66期:智源2022大模型创新论坛、 ChatGPT手把手debug代码、AI与物理的交融

《预训练周刊》第65期:智源AltDiffusion升级支持9种语言、Meta科学大模型争议