自ChatGPT问世以来,强大的理解力与信息总结能力便使得其快速成为了各行业从业者的得力助手,无论是程序员、作家、学生还是记者都能够依靠ChatGPT的帮助来提升实际的工作效率。

然而在硬币的另一面,幻觉问题却也始终困扰着这款诞生并不太久的聊天机器人,并且随着所涉猎场景的不断增加,ChatGPT的幻觉也开始在越来越多的情况下给用户甚至是其母公司OpenAI带来麻烦。

就在不久前,一位记者为了撰写报告,要求ChatGPT提供一起有关美国枪支权利基金会(SAF)的案件摘要。然而在幻觉的作祟之下,ChatGPT编造了一起并不存在的贪腐案件,还将莫须有罪名强加到了一位与基金会并无太多关联的电台主持人头上。

而得知自己遭到ChatGPT恶意诬陷的电台主持人,也在一气之下将OpenAI告上了法庭,使这家如日中天的企业背上了有史以来第一个关于人工智能的诽谤诉讼。

1、电台主持人化身枪支基金会高官

这起事件的主角Mark Walters是Armed America电台的一位主持人。作为合法持枪权的拥护者,Walters时常会通过各类渠道呼吁民众支持合法持枪权。由于他为枪支自由所做出的贡献,美国枪支权利基金会曾于2017年授予了Walters杰出服务奖。

Mark Walters

但也正因这个奖项,使得ChatGPT错误地将Walters与SAF联系了起来。在被记者要求提供有关SAF的案件介绍及摘要时,ChatGPT鬼使神差的将Mark Walters的名字附在了一份刑事诉讼之上。

在ChatGPT提供给记者的摘要中,原本只获得过SAF奖项的电台主持人摇身一变成为了SAF的首席财务官和司库,更为离谱的是,在幻觉的驱使下,ChatGPT还为Walters捏造了一项利用职务之便诈骗、贪污基金会资金的罪名。

而当记者要求ChatGPT继续提供相关诉状的具体案件卷宗时,ChatGPT依然假模假式地制造了一封完全不存在的案件文档,甚至为了让文件看起来更加真实,ChatGPT还主动向记者提供了捏造出来的案件编号。

从记者口中得知这一事件的Walters非常气愤,并在第一时间聘请律师将OpenAI告上了法庭。Walters表示:ChatGPT对自己的指控是虚假、恶意的,通过印刷、写作图片等内容,伤害了自己的名誉,并使自己受到了公众的仇恨、蔑视或嘲笑。

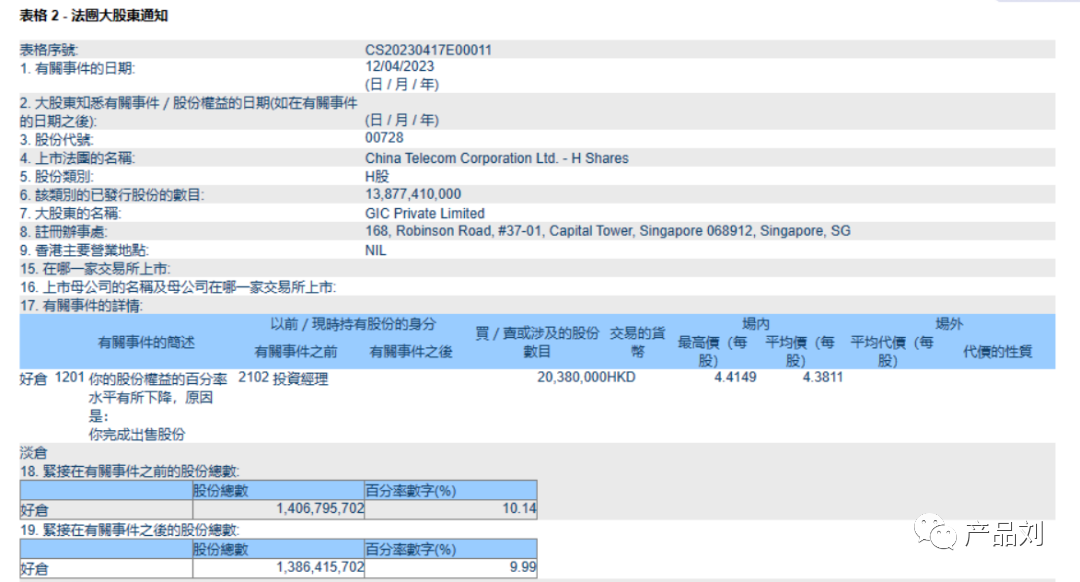

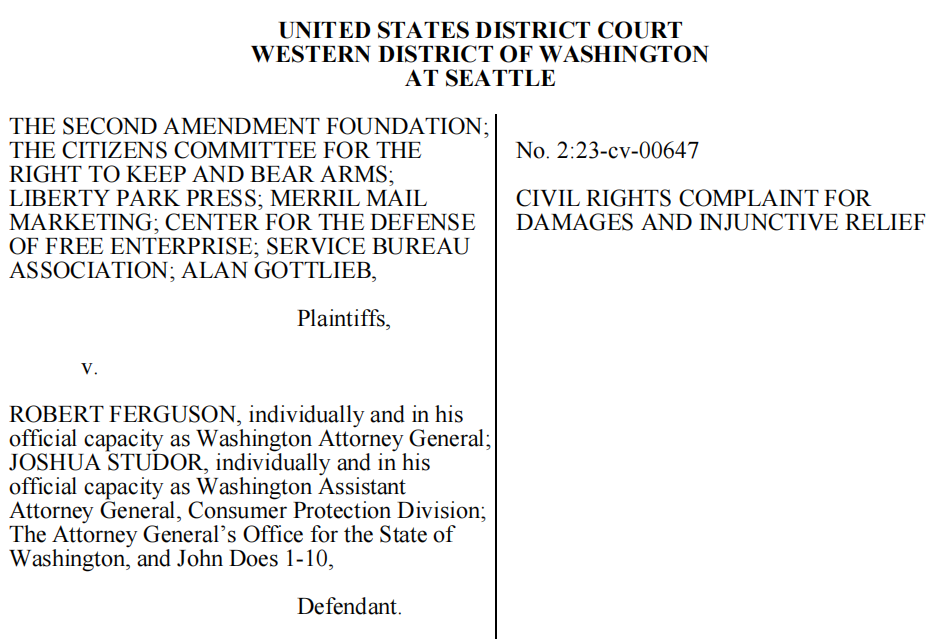

诉讼文件

根据法院所出示的公开信息,Walters起诉OpenAI要求赔偿其个人损失及律师费。但由于司法界意见并为达成统一,截至目前该案件尚未正式开庭。至于Walters所要求的赔偿,法院方则表示,如案件确认开庭,赔偿金将会在审判时予以确定。

2、ChatGPT为什么总会说谎

众所周知,ChatGPT的幻觉问题由来已久,捏造诉讼也并不是第一次了。就在几周前,一名律师让ChatGPT帮忙整理案件材料,而ChatGPT所提供的6起案件全是假的,这也让这位粗心的律师差点丢掉了饭碗。

对于Walters的案件,熟悉AI系统的法学教授Eugene分析称,ChatGPT产生幻觉的原因可能是由于受到了与记者的对话历史的影响。ChatGPT的回答会基于对话的上下文,如果对话历史存在错误或不明确信息,那么ChatGPT就会比较容易受到影响。

在与ChatGPT进行交互的过程中,记者首先要求ChatGPT提供SAF相关的案件及摘要而不是确切的链接或文档,若此时ChatGPT的训练数据中存在错误信息或缺少该方面内容,那么这就很可能会导致幻觉的产生。

随后记者又要求ChatGPT提供其所生成案件的相关卷宗,为了能够满足用户需求,此时的ChatGPT便在无法查询到不存在案件的情况下,模仿类似文件的样式,自动生成了一份能够以假乱真的文档。

Eugene强调称,虽然ChatGPT的幻觉产生可能是由于记者所给出的提示不够准确。但在这起案件中,记者并没有主动引导ChatGPT进行造假,只是对ChatGPT提出了正常需求,因此所造成的影响与使用者并无关系。

3、OpenAI该承担责任吗

Walters的律师Monroe在接受采访时表示:虽然OpenAI在ChatGPT的使用条款中标注了“用户应当根据用例评估输出的准确性,包括人工审查输出结果”。但OpenAI不能仅仅通过这样简单的标注来逃避诽谤责任。

ChatGPT声明

Walters所提交给法院的诉状指出,OpenAI早就意识到ChatGPT有时会捏造事实,并将这种现象称为幻觉。这一案件是检验公司对人工智能系统法律责任的一个重要案例,OpenAI知道它的人工智能系统正在发布诽谤信息,但它们试图依靠一些小手段回避这一点,这显然是在混淆视听。

对此,Eugene教授也从法律角度提出了自己的看法,他表示,在诽谤罪名相关法律责任中,如果原告“可以证明被告陈述是虚假的”,并且“可以证明被告在作出虚假陈述的行为导致损害了原告的实际利益”,那么诽谤索赔原则上就是合法的。

然而Eugene也提到,以自己的了解,目前没有法律先例要求公司是对人工智能输出内容负责。虽然此类诽谤索赔原则上是可行的,但这起特殊诉讼应该很难维持,因为事发过后,Walters没有通知OpenAI这些虚假信息,给他们一个机会来删除它们,并且他也很难有效证明ChatGPT的输出对他造成了实际的损害。

4、网友热评 :都是幻觉

这起史无前例的、将OpenAI送上法庭的案件,也在网上一石激起千层浪,引发了大量网友广泛的讨论。

Beryllium Sphere在Slashdot的留言中写到:如果一家公司的机器因为其疏忽造成了损失,该公司应当承担责任。OpenAI当然知道ChatGPT的输出不可靠,他们也在主页上进行了标注,但我认可Walters的观点,这样的警告不足以让他们避免责任。

Koga Onutalepo提到:尽管如此,我仍然很难将OpenAI视为这里的责任方,它只是创建了这个复杂的自动系统。他对这位主持人一无所知,ChatGPT也只是根据提示生成了听起来合理的描述,如果让OpenAI承担责任,似乎很多人可以要求ChatGPT捏造他们想要的任何故事,然后以此来起诉OpenAI。

JJMORRIS2000则在Reddit上留言表示:这就是我讨厌“幻觉”一词的原因,ChatGPT获得答案的过程只是遵循了不同的随机路径来生成文本字符串,并最终提出它自己认为正确的东西。所以如果说生成错误答案被认为是一种幻觉,那生成正确答案其实也可以被认为是一种幻觉。

归根结底,我们目前依然无法从根本上解决大模型的幻觉问题,但随着以ChatGPT为首的人工智能工具不断深入各行业,未来的我们在享受生成式人工智能所带来便利的同时,也注定将会在技术、法律、监管等领域面临更多未知的挑战。

现阶段我们所能做的,就是保持对一切问题的理性看待,依靠在一次次不同经历中所积累的经验,逐步完善对生成式人工智能的监管与控制。在降低技术所带来的负面影响的同时,尽可能地发挥出它的最大价值,这是我们需要在未来不断思考并着力解决的最主要课题。

最后,对于这起史无前例的诽谤诉讼,你有什么不一样的看法呢?