一、AI小模型脱胎于AI大模型,而AI小模型群又可以反哺AI大模型

AI大模型(如GPT、BERT等)通常拥有大量的参数和训练数据,能够生成或理解复杂的文本内容。这些大模型在训练完成后,可以通过剪枝、微调等方式转化为小模型,以适应不同的应用场景,比如嵌入式设备、移动应用或者对计算资源有限制的环境。

另一方面,AI小模型群在各自的领域中通过持续学习和优化,可以积累丰富的经验和知识。这些小模型在实际应用过程中产生的新数据、反馈信息以及改进策略,又可以被用于进一步迭代和升级AI大模型。这种“反哺”机制体现在:

1. 数据收集:AI小模型在与用户交互过程中生成的新数据,可以作为大模型训练的补充,帮助大模型更好地理解和适应现实世界的复杂性和多样性。

2. 知识迁移:AI小模型针对特定场景的专业化知识和技能,经过整合和提炼后,可以为大模型提供更具体和深入的知识输入。

3. 模型优化:从小模型获取到的有效算法改进、架构调整等经验,有助于提升大模型的学习效率和性能表现。

因此,AI大模型和小模型之间形成了一个相互促进、共同发展的生态循环系统。

此图片来源于网络

二、“脱胎”与“反哺”

元学习(Meta Learning)和迁移学习(Transfer Learning)是机器学习中两种不同的学习策略,它们都旨在利用已有的知识来帮助新任务的学习,但其核心思想与应用场景有所不同:

**元学习**:

1. 目标:元学习的目标在于“学习如何学习”,即训练模型掌握快速适应新任务的能力。它强调的是在多个相关的小规模任务上进行训练,从而学习到一种能够快速收敛、泛化到未见过的任务上的学习算法或初始化权重。

2. 方法:元学习通常采用“任务采样”的方式,在每次迭代过程中从一系列任务分布中抽样出小批量任务来进行训练,通过这种过程学习一个通用的初始化参数或者优化器,使得在面对新的目标任务时只需要少量样本就能快速调整和适应。

**迁移学习**:

1. 目标:迁移学习主要是将从一个或多个源任务中学到的知识应用到目标任务中,以改善目标模型的性能。它的重点在于重用预训练模型中的特征表示或其他相关信息,而不是从零开始训练一个新的模型。

2. 方法:迁移学习经常表现为使用在大型数据集(如ImageNet)上预先训练好的深度神经网络模型,将其顶层(通常是分类层)替换成针对新任务的结构,并根据目标数据集对部分或全部模型参数进行微调。迁移学习可以显著减少对新任务所需的大规模标注数据依赖。

总结起来,两者的主要区别在于:

- 元学习关注于学习到适用于任何任务的高效学习策略,解决的是如何更快地学习新任务的问题。

- 迁移学习关注于将从一个任务中学到的知识直接应用于另一个任务,尤其在有相关性的情况下,更侧重于复用已经学到的有用特征表示。

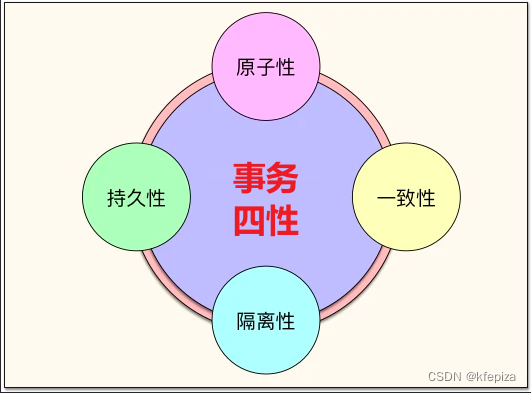

此图片来源于网络

三、小模型反哺大模型(108个想法)

利用众多行业AI小模型提升通用AI大模型能力的具体手段可以包括但不限于以下几种方法:

1. **知识蒸馏(Knowledge Distillation)**:

小型行业模型通常在各自领域有较高的准确性和专业性。通过知识蒸馏技术,将小型模型的预测结果或中间层特征“软标签”传递给大型模型学习,使得大模型能够模仿并吸收小模型的专业知识。

2. **多任务学习(Multi-Task Learning, MTL)**:

设计一个多任务学习框架,让大模型同时处理来自各个行业的小模型所对应的任务。大模型会共享底层特征提取部分,并为每个任务配备特定的输出层,从而学习到跨领域的通用和专用特征表示。

3. **元学习(Meta-Learning / Learning to Learn)**:

利用多个行业的小模型训练数据作为元训练集,训练一个能够快速适应新任务的大模型。大模型在不同任务之间进行迭代训练,学习如何快速调整自身的参数以应对新的、有限样本的任务。

4. **迁移学习与微调(Transfer Learning and Fine-tuning)**:

结合预训练的小型行业模型,将其底层权重或部分网络结构整合到大模型中,然后使用特定行业的数据对大模型进行微调,这样可以充分利用小模型在特定领域的学习成果。

5. **模型融合(Model Fusion or Ensemble)**:

将多个小型行业模型集成在一起形成混合系统,大模型可以通过分析和学习这些小模型在决策过程中的互补性和一致性,优化自身的表现。

6. **深度神经网络模块复用(Module Reuse in Deep Networks):

对于各行业中有相似功能或者问题结构的部分,从小模型中挑选出有效的神经网络模块加入到大模型中,实现跨行业的知识转移。

7. **联邦学习(Federated Learning)**:

在保护隐私的前提下,联合多个行业的小模型进行分布式训练,各自贡献模型更新信息,在云端构建统一的大模型,使大模型能够汇总多个行业特有的模式和规律。

8. **动态架构学习(Dynamic Architecture Learning)**:

根据不同行业任务的需求,动态地组合或调整预先训练好的小型模型组件,形成具有自适应能力的大模型。

9. **强化学习与元学习结合(Reinforcement Learning with Meta-Learning)**:

通过将强化学习应用于元学习框架中,让AI大模型在不同行业的小任务环境中学习如何调整其参数和行为策略,以适应新的、未知的任务环境。

10. **领域自适应(Domain Adaptation)**:

将多个行业小模型视为不同的源域,训练大模型学会从这些源域迁移到目标域的能力。大模型通过对不同行业数据的特征迁移和分布匹配,提高对新行业场景的理解和适应性。

11. **生成式对抗网络(Generative Adversarial Networks, GANs)**:

利用GANs或者变种技术生成各种行业的模拟数据,扩充大模型的训练集,使得大模型能够接触到更丰富的场景和案例,从而提升泛化能力。

12. **可解释性和因果推理(Interpretability and Causal Inference)**:

分析各个行业AI小模型的决策逻辑和因果关系,提炼出具有普适性的因果规律,并将其融入到AI大模型的设计和优化过程中,使其具备更强的跨行业推理和泛化能力。

13. **持续学习或终身学习(Continual Learning / Lifelong Learning)**:

让大模型以一种连续的方式不断学习并整合来自各行业的小模型的知识,同时设计相应的机制防止遗忘旧知识,确保大模型能随着时间和新任务的增加而持续进化和改进。

14. **联邦学习与联合建模(Federated Learning and Collaborative Modeling)**:

联邦学习允许AI大模型在不直接访问各行业小模型数据的情况下,通过分布式训练和信息交互来整合各个领域的知识。每个行业的本地模型在保护数据隐私的前提下,在本地进行训练,并将模型更新传输至中心服务器,大模型根据这些更新进行全局优化。

15. **多任务学习(Multi-Task Learning, MTL)**:

在一个统一的大模型架构中设计多个并行的任务头,每个任务头对应不同行业的特定需求。共享底层的表示层可以捕获跨行业的共同特征,同时利用各自的任务特定层来应对不同场景下的个性化要求。

16. **深度强化迁移学习(Deep Reinforcement Transfer Learning)**:

结合深度强化学习与迁移学习技术,让AI大模型从不同行业的RL任务中学习到通用策略,然后通过少量样本或环境交互就能快速适应新行业或新任务的需求。

17. **自监督学习(Self-Supervised Learning)**:

通过构建跨行业的自监督学习任务,如预测隐藏部分、重建输入数据或挖掘潜在结构等,使得大模型在无标注或少标注的数据环境下也能提取出有意义的行业共性特征。

18. **元决策森林(Meta Decision Forests)**:

利用元学习思想结合决策树或者随机森林等传统机器学习方法,形成一种能够快速适应新行业问题的元决策森林模型,它能够在面临新领域时迅速调整其内部结构以适应新的决策边界。

19. **神经架构搜索与元学习结合(Neural Architecture Search with Meta-Learning)**:

利用元学习来指导神经架构搜索过程,动态地发现和优化适合处理多行业任务的网络结构。通过这种方式训练出的大模型能够更好地捕获各行业间的共性特征,并在新领域快速适应。

20. **层级迁移学习(Hierarchical Transfer Learning)**:

根据不同行业的相似性和层次关系,设计多层次的迁移学习框架。底层共享通用特征表示,而上层针对特定行业进行细粒度的知识迁移,使得大模型在保留泛化能力的同时具备深入理解各行业特性的能力。