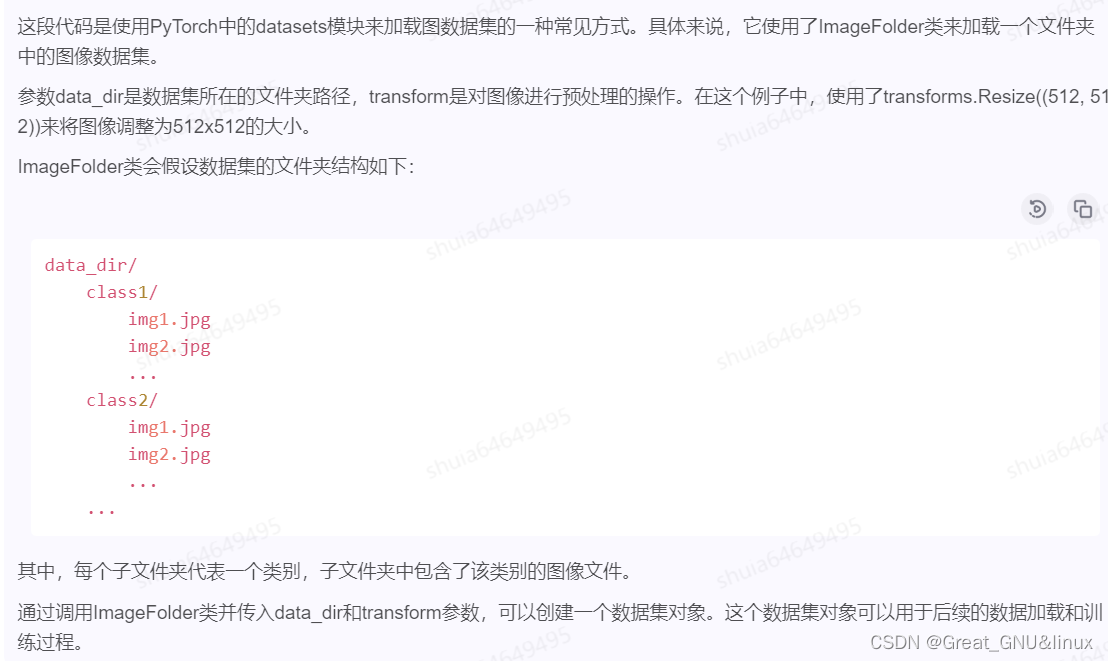

图像读取

Image read ⇒ \Rightarrow ⇒ torchvision.datasets

from torchvision import datasets

dataset = datasets.ImageFolder(data_dir, transform=transforms.Resize((512, 512)))

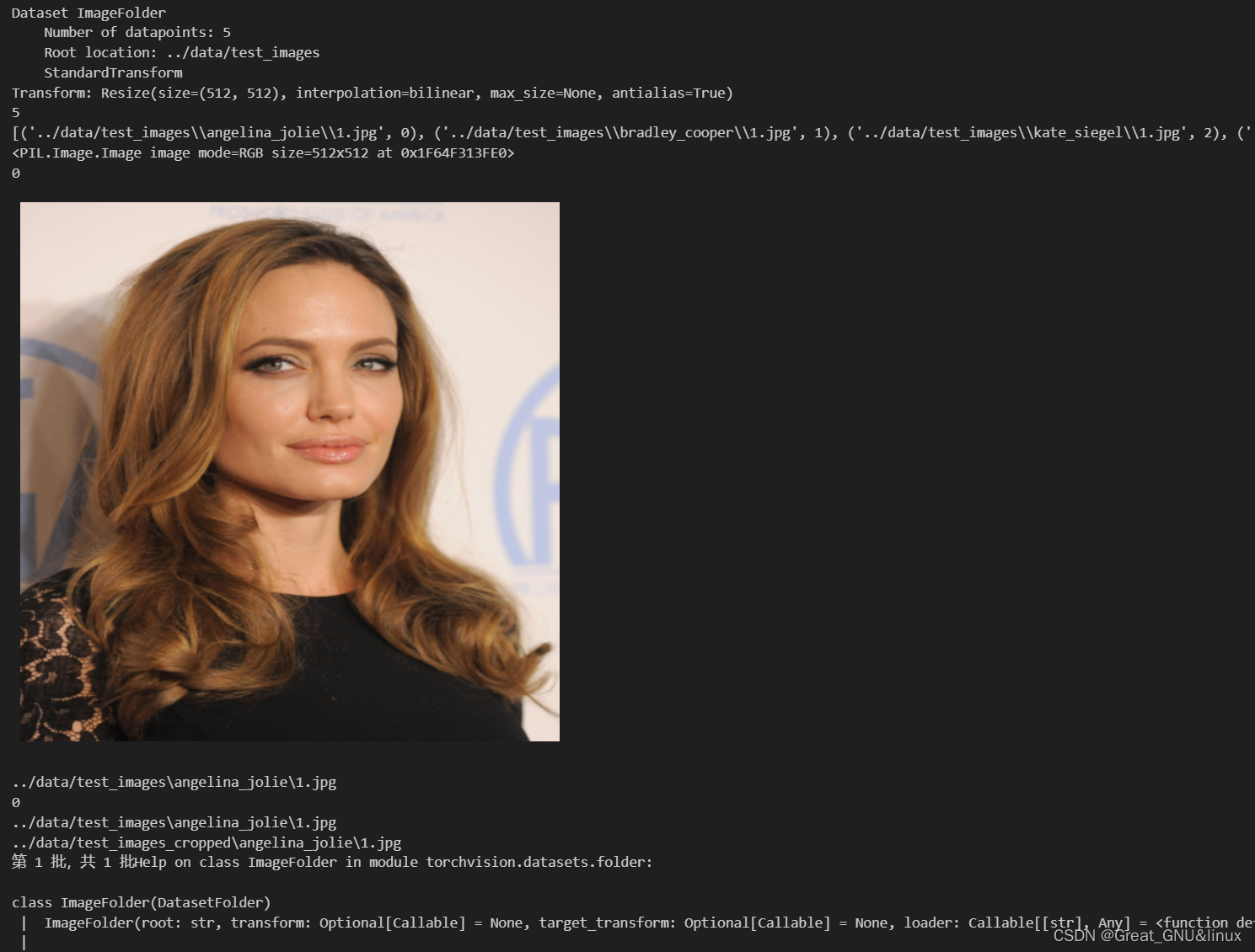

Return value illustration

- dataset[0][0]是PIL.Image objects,这利用IPython.display输出image,

from IPython import display

dataset = datasets.ImageFolder(data_dir, transform=transforms.Resize((512, 512)))

print(dataset)

print(len(dataset))

print(dataset.samples)

print(dataset[0][0])

print(dataset[0][1])

display.display(dataset[0][0])

print(dataset.samples[0][0])

print(dataset.samples[0][1])

dataset.samples = [(p, p.replace(data_dir, data_dir + '_cropped'))for p, _ in dataset.samples

]

print(dataset.samples[0][0])

print(dataset.samples[0][1])loader = DataLoader(dataset,num_workers=workers,batch_size=batch_size,collate_fn=training.collate_pil

)for i, (x, y) in enumerate(loader):mtcnn(x, save_path=y)print('\r第 {} 批,共 {} 批'.format(i + 1, len(loader)), end='')# Remove mtcnn to reduce GPU memory usage

del mtcnnhelp(datasets.ImageFolder)

返回的dataset类有如下函数:

- dataset[0][0]=PIL.Image,[1]=tag

- dataset.sample[0][0]

- len(dataset)

之后DataLoader加载数据集

loader = DataLoader(…)返回的DataLoader是什么,如何使用

`DataLoader`返回的是一个迭代器,用于从给定的`dataset`中按照指定的`batch_size`以及其他参数,生成批次的数据。

每个批次数据是一个元组,其中包含了输入样本和对应的标签。在给定的代码中,`DataLoader`会使用`dataset`作为数据源,设置`num_workers`参数表示同时使用多少个子进程来加载数据,设置`batch_size`参数

表示每个批次的样本数量。`collate_fn`参数是一个用来自定义如何将样本列表组合成一个批次的函数。通过使用`DataLoader`,可以方便地对大规模数据集进行批次加载,以进行训练或推理操作。

使用`DataLoader`的好处是可以自动进行数据并行处理,提高数据加载的效率。

for i, (x, y) in enumerate(loader):

是常用的 图像/样本 使用方式,x是图像batch列表,

x是图像,y是路径,好繁琐

图像裁剪

MTCNN 说明

facenet_pytorch.MTCNN是一个用于人脸检测和对齐的Python库。它使用了三个级联的神经网络来完成这个任务,分别是P-Net、R-Net和O-Net。在MTCNN中,有三个阈值需要设置,分别是人脸检测的阈值、人脸对齐的阈值和人脸裁剪的阈值。人脸检测的阈值(detection_threshold):用于确定是否存在人脸的阈值,默认值为0.6。当检测到的人脸置信度大于该阈值时,认为存在人脸。人脸对齐的阈值(landmarks_threshold):用于确定是否成功对齐人脸的阈值,默认值为0.7。当对齐后的人脸关键点置信度大于该阈值时,认为对齐成功。人脸裁剪的阈值(min_face_size):用于确定最小人脸尺寸的阈值,默认值为20。当检测到的人脸尺寸小于该阈值时,将被忽略。这些阈值可以根据具体应用场景进行调整,以达到更好的检测和对齐效果。

from facenet_pytorch import MTCNN

mtcnn = MTCNN(image_size=160, margin=0, min_face_size=20,thresholds=[0.6, 0.7, 0.7], factor=0.709, post_process=True,device=device

)

facenet_pytorch.MTCNN是一个用于人脸检测和对齐的模型,它有以下几个参数:min_face_size:最小人脸尺寸。默认值为20,表示检测到的人脸的最小边长为20个像素。thresholds:阈值列表。默认值为[0.6, 0.7, 0.7],表示在三个不同的阈值下进行人脸检测和对齐。factor:图像金字塔的缩放因子。默认值为0.709,用于生成不同尺度的图像。post_process:是否进行后处理。默认值为True,表示进行后处理以去除重叠的人脸框。device:设备类型。默认值为"cuda:0",表示使用GPU进行计算。如果没有可用的GPU,则可以设置为"cpu"。keep_all:是否保留所有检测到的人脸框。默认值为False,表示只保留最大的人脸框。select_largest:是否选择最大的人脸框。默认值为False,表示选择所有检测到的人脸框。prewhiten:是否对图像进行预白化处理。默认值为True,表示对图像进行预处理以提高模型性能。

Cropping out 人脸框

用mtcnn对x裁剪,放入地址=y,

for i, (x, y) in enumerate(loader):mtcnn(x, save_path=y)display.display(display.Image(y[0]))print('\r第 {} 批,共 {} 批'.format(i + 1, len(loader)), end='')

IPython中输出如下:

Resnet 人脸识别

形成(嵌入式表示,索引)对

from facenet_pytorch import MTCNN,InceptionResnetV1

import torch

from torchvision import datasets

from torch.utils.data import DataLoadermtcnn=MTCNN(image_size=240,margin=0,min_face_size=20)

resnet=InceptionResnetV1(pretrained='vggface2').eval()dataset=datasets.ImageFolder('./data/test_images')

idx_to_class={i:c for c,i in dataset.class_to_idx.items()}def collate_fn(x):return x[0]loader=DataLoader(dataset,collate_fn=collate_fn)face_list=[]

name_list=[]

embedding_list=[]

for img,idx in loader:face,prob =mtcnn(img,return_prob=True)if face is not None and prob>0.90:emb=resnet(face.unsqueeze(0))embedding_list.append(emb.detach())name_list.append(idx_to_class[idx])

- 存入’data.pt’

data=[embedding_list,name_list]

torch.save(data,'data.pt')

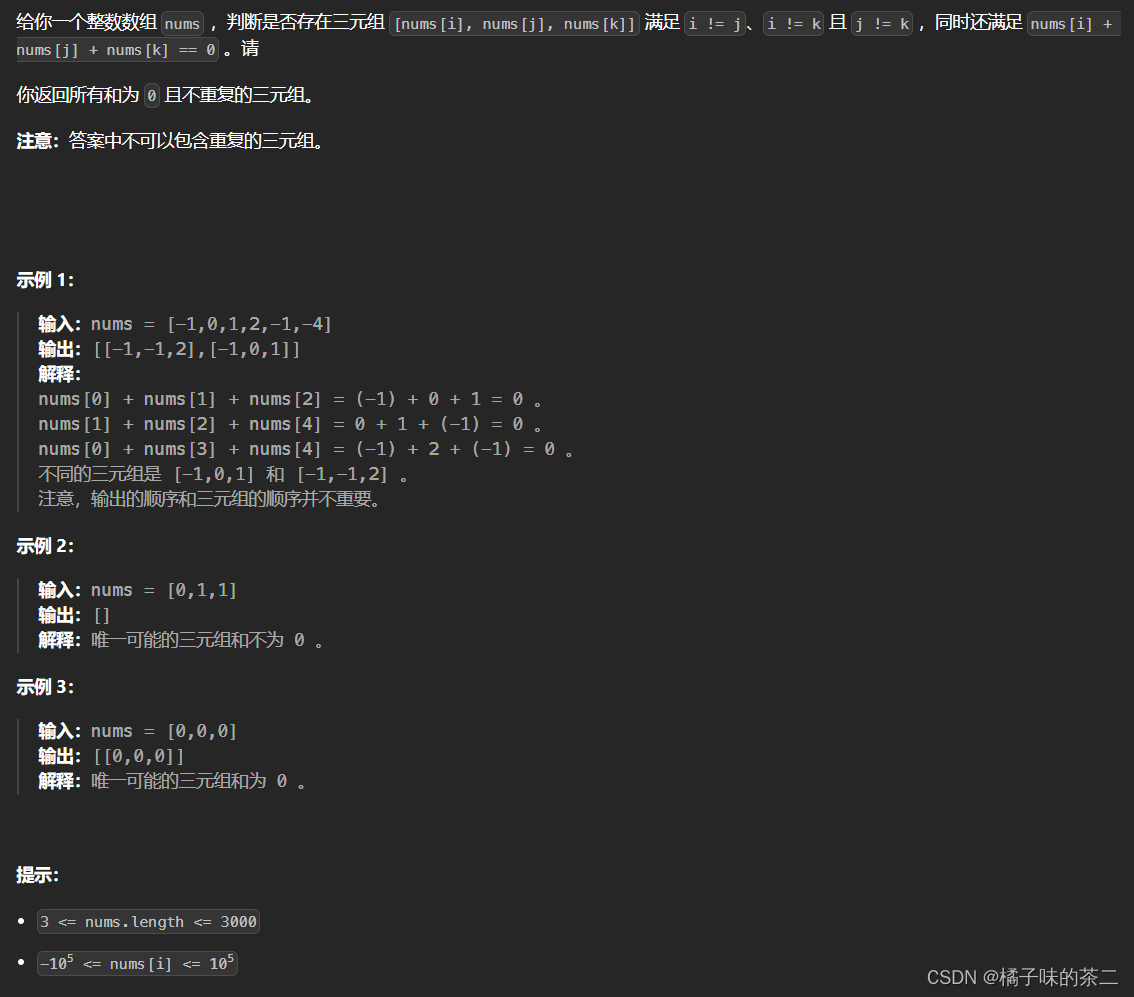

找出龙队

- 将’ml3.jpg’与已有数据库的嵌入式比较,选择欧式距离最小的索引

from PIL import Imagedef face_match(img_path,data_path):img=Image.open(img_path)face,prob = mtcnn(img,return_prob=True)emb=resnet(face.unsqueeze(0)).detach()saved_data = torch.load('data.pt')embedding_list = saved_data[0]name_list = saved_data[1]dist_list = []for idx,emb_db in enumerate(embedding_list):dist = torch.dist(emb,emb_db).item()dist_list.append(dist)idx_min = dist_list.index(min(dist_list))return name_list[idx_min]person=face_match('ml3.jpg','data.pt')

print(person)

./data/test_images为开头的资源

用于测试的龙队的图片’ml3.jpg’如下:

用来生成(embed,index)对的图片如下:

可见,用resnet形成的同一个人的图片的嵌入式表示的欧式距离很接近,算法有效

但这个嵌入式表示是如何形成的呢,有其他方式形成吗?

facenet_pytorch.InceptionResnetV1

facenet_pytorch是一个用于人脸识别的PyTorch库,而InceptionResnetV1是其中的一个模型。

InceptionResnetV1是由Google团队提出的一种深度卷积神经网络架构,它结合了Inception模块和残差连接的思想。Inception模块是一种多分支的卷积结构,通过不同大小的卷积核并行处理输入特征图,然后将它们在通道维度上进行拼接,

从而捕捉不同尺度的特征。这种结构可以有效地提取丰富的特征信息。残差连接是为了解决深度神经网络训练过程中的梯度消失和梯度爆炸问题。通过在网络中引入跳跃连接,将输入直接与输出相加,

可以使得网络更容易学习到残差部分,从而提高网络的性能。InceptionResnetV1结合了Inception模块和残差连接的优点,可以在保持较低计算复杂度的同时提高网络的准确性。

它在人脸识别任务中表现出色,被广泛应用于人脸验证、人脸检测等领域。

from facenet_pytorch import MTCNN,InceptionResnetV1

import torch

from torchvision import datasets

from torch.utils.data import DataLoadermtcnn=MTCNN(image_size=240,margin=0,min_face_size=20)

resnet=InceptionResnetV1(pretrained='vggface2').eval()dataset=datasets.ImageFolder('./data/test_images')

idx_to_class={i:c for c,i in dataset.class_to_idx.items()}def collate_fn(x):return x[0]loader=DataLoader(dataset,collate_fn=collate_fn)face_list=[]

name_list=[]

embedding_list=[]

for img,idx in loader:face,prob =mtcnn(img,return_prob=True)print(face.shape)if face is not None and prob>0.90:emb=resnet(face.unsqueeze(0))print(emb.shape)embedding_list.append(emb.detach())name_list.append(idx_to_class[idx])

resnet的输入维度为(1,3,240,240),Output.shape=[1,512]

衡量嵌入表示相似性的其他方式

- 上面,我们采用torch.dist(emb,emb_db)比较test_sample和dict的相似性,还有其他聚类,idea=减小类内损失,扩大类间损失

torch.dist函数的语法如下:

torch.dist(input, other, p=2)其中,input和other是两个张量,表示要计算距离的两个向量或矩阵。p是一个可选参数,表示要计算的距离类型,默认为2,即欧氏距离。具体来说,torch.dist函数根据p的取值,计算不同类型的距离:当p=0时,计算非零元素的数量(L0范数)。

当p=1时,计算曼哈顿距离(L1范数)。

当p=2时,计算欧氏距离(L2范数)。

当p=float(‘inf’)时,计算切比雪夫距离(L∞范数

- Next,we mainly talk about ArcFace