目录

一、概述

二、相关工作

三、SimVS

1、利用视频模型模拟世界的不一致性

2、效果

一、概述

该论文提出了一种名为SimVS的视频模型方法,旨在解决稀疏多视角图像捕捉中因动态变化(光照变化、物体运动)导致的视图合成鲁棒性问题。

动机:现有方法在动态场景下需要依赖静态假设信息(比如NeRF),而实际的应用中输入的图像存在动态干扰,导致重建质量下降,或者使用了很少的数据,最后重建结果出现残影或者几何错乱(如下图CAT3D)。

近期的NVS模型都是从一组一致性的图像作为输入,场景几何形状和照明都是静态的,但是现实场景的图像捕捉一般很难遵循这一约束,人、物体可能存在移动或者变形,灯光也可能存在移动或改变亮度。

目的:该论文实现了从动态不一致的稀疏输入中恢复高质量的静态3D模型。原理是将动态干扰的稀疏图像隐式对齐到同一静态状态,输出一个与参考视角几何一致的图像,以供后续3D重建。

关键贡献:

一种生成式数据增强策略,利用视频扩散模型(Lumiere)去采样世界的不一致性(场景运动和光线改变)

一种多视图协调模型,根据生成的数据进行训练,将不一致的稀疏输入图像转换为一组一致的图像。

二、相关工作

三、SimVS

首先对于所假设的模型缺乏成对的动态-静态的训练数据,所以打算创建一个数据集。

基于现有的多视图数据集,当前大多数的静态多视图数据集只包含对一致场景的capture,而通过简单的缩放数据,不足以形成robust的NVS,而如果对图像移动视点或者单独进行场景变形或者照明改变是很繁杂的。如果利用启发式数据增强策略(如下图),比如随机变换,色彩变换,难以捕捉真实情况的照明变换和几何性质,甚至这种方式不能影响场景内的运动。如果使用objaverse数据集,他只能在物体级实现,而没有场景级。

下图第一列为原始图片,第二列真实场景下的加以dynamics/lighting的效果,第三列是通过VDM生成的效果,第四列是启发式数据增强策略生成的,效果很拉胯,不真实。

基于实际拍摄的动态场景,难以获取多视角的同步数据。

1、利用视频模型模拟世界的不一致性

所以基于上面的原理,考虑利用生成模型创造一个数据集--包含不同dynamic/lighting的并对应原来静态效果的数据集,这也就是下图所作的工作。

(a)Multiview inputs

视频模型采用Lumiere模型,一个二阶段高分辨率生成的视频扩散模型。

模拟了两个最突出的不一致现象:动态运动和照明变化。动态运动,采用Mannequin Challenge dataset(包含相机运动,同一场景下人物的连续型动作)照明变化,采用RealEstate10k dataset(包含多样化的室内室外照明条件的图像)

上面这些图像都是多视图输入。

(b)Inconsistency prompts

接下来是inconsistency prompt的生成,我们基于多模态大语言模型Gemini生成多样化的标题,对于给定的每一个clip,也就是每一张都随机生成一个简单且具体的prompts。

另外也添加一个negative的prompt,类似于文生图中的反向提示词,来强制模型忽略与固定视角冲突的生成方向,比如文本是“a person is waving hands”,可以写作“moving camera”,保证视角固定,但是场景中人物存在动作变化。

(c)Video model

预训练模型Lumiere(文本+图像生成视频模型)权重冻结,输入和prompts并生成一个富有光照变化或者动态场景的视频。

(d)Synthesized inconsistent

如何将视频转换为一帧Synthesized inconsistent的图像?论文中给的是随机采样一帧

,这一帧相比于

来说存在光照不一致但是空间一致。

(e)Multiview generative model

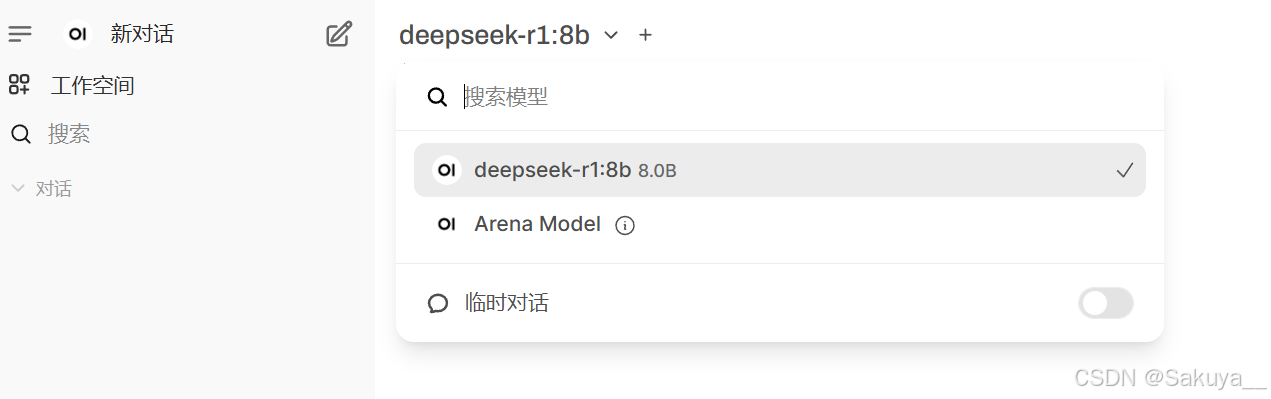

这个后半段用的模型就是CAT3D的预训练模型,基于参考视图来实现多视图扩散,然后利用NeRF进行多视角生成。

这个模型的意义是,基于给定的多张(图中是3张)以及一张参考视图

,得到与参考视图光照条件一致,(或者如果动态场景变化,那么就是时间一致的)多视角输出

。

模型如何做到的呢?过去的想法参考视图应该利用交叉注意力层类似以往文本编码的方式,编码他的光照信息,输入到模型中。(异想天开罢了)他就是一个CAT3D,

损失函数方面:可以去看CAT3D,他的损失就是重建阶段的损失函数,空间一致性:先生成Raymap保留几何性质,通过多视图输入LDM实现跨视角一致性,LDM通过自注意力机制来实现空间一致性。不再使用极线约束,这样可以依赖大规模的训练数据,数据驱动。

2、效果

下图diffusion samples就是扩散出来的多视图,NeRF是根据NeRF生成模型后的效果,如果用以往的CAT3D生成,在扩散模型后就会出现空间不一致,所以NeRF重建效果也会出现鬼影。

后两个是在objaverse上做的和启发式增强,说白了就是饱和度+亮度调整。

参考论文:SimVS: Simulating World Inconsistencies for Robust View Synthesis

相关博文:

CAT3D: Create Anything in 3D with Multi-View Diffusion Models 论文解读-CSDN博客

ReconFusion: 3D Reconstruction with Diffusion Priors 论文解读-CSDN博客