深度学习是一种机器学习方法,其核心是通过构建深层神经网络来学习数据的表示和特征,以解决各种复杂的任务。以下是深度学习算法的基本原理,希望对大家有所帮助。北京木奇移动技术有限公司,专业的软件外包开发公司,欢迎交流合作。

1. 神经网络结构:

- 神经元(Neuron):神经网络的基本单元,接收输入,经过加权求和和激活函数处理后产生输出。

- 层(Layer):由多个神经元组成的一层结构,通常分为输入层、隐藏层和输出层。

- 深度(Depth):指神经网络的隐藏层数量,深度越大,网络的非线性表示能力越强。

2. 前向传播(Forward Propagation):

- 输入数据传递:输入数据经过输入层传递给第一个隐藏层。

- 隐藏层传递:每个隐藏层根据上一层的输出计算权重加权和,并通过激活函数产生输出。

- 输出层计算:最后一个隐藏层的输出传递到输出层,进行最终的输出计算。

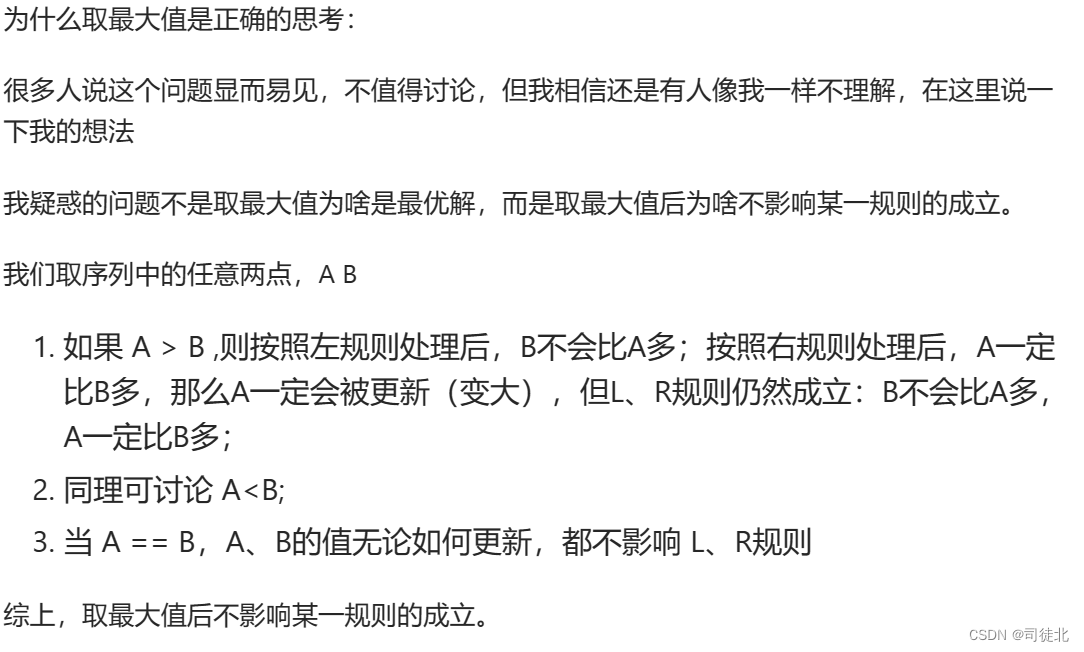

3. 反向传播(Backpropagation):

- 误差计算:计算模型输出与实际标签之间的误差。

- 误差反向传播:将误差通过网络反向传播,根据链式法则计算每一层的梯度。

- 参数更新:根据梯度下降法则,调整网络参数以减小误差,例如使用梯度下降算法或其变种进行参数更新。

4. 激活函数(Activation Function):

- 作用:引入非线性,使神经网络能够学习更复杂的数据表示。

- 常见的激活函数:ReLU(Rectified Linear Unit)、Sigmoid、Tanh等。

5. 损失函数(Loss Function):

- 作用:衡量模型预测结果与实际标签之间的差异。

- 常见的损失函数:均方误差(Mean Squared Error)、交叉熵(Cross-Entropy)等。

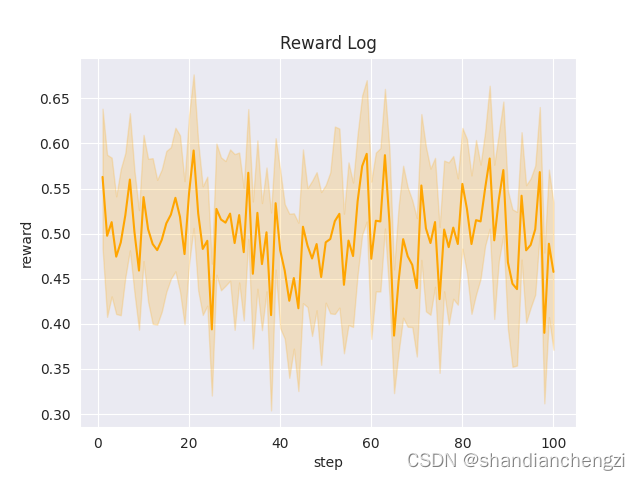

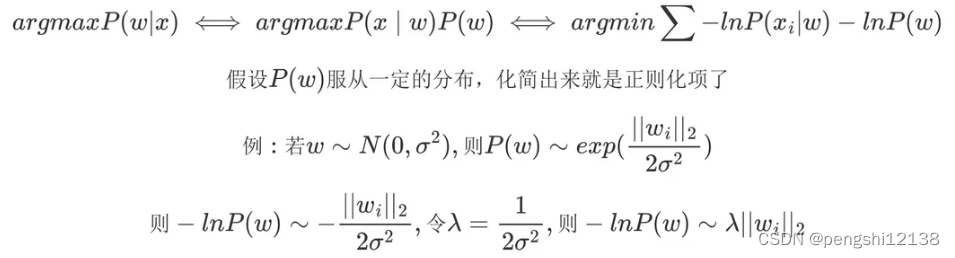

6. 优化算法(Optimization Algorithm):

- 作用:用于更新模型参数,以使损失函数最小化。

- 常见的优化算法:梯度下降(Gradient Descent)、Adam、Adagrad、RMSProp等。

7. 深度学习模型:

- 卷积神经网络(CNN):主要用于图像处理和计算机视觉任务。

- 循环神经网络(RNN):主要用于序列数据处理,如自然语言处理和时间序列分析。

- 深度自编码器(Deep Autoencoder):用于特征提取和数据压缩。

深度学习算法通过反向传播来不断地调整网络参数,以最小化损失函数,从而使模型能够更准确地学习数据的表示和特征,适用于各种领域的数据建模和预测任务。