【相关问题解答1】bert中文文本摘要代码

- 写在最前面

- 问题1

- 问题描述

- 一些建议

- import时无法找到包时,几个潜在的原因和解决方法

- 1. 模块或包的命名冲突

- 解决方法:

- 2. 错误的导入路径

- 解决方法:

- 3. 第三方库的使用错误

- 解决方法:

- 4. 包未正确安装

- 解决方法:

前些天发现了一个人工智能学习网站,内容深入浅出、易于理解。如果对人工智能感兴趣,不妨点击查看。

写在最前面

感谢大家的支持和关注。

最近好多人咨询之前博客【bert中文文本摘要代码】的相关代码报错问题,由于报错有一定的相似性,因此这里统一进行答复

之前的相关博客链接,感兴趣的uu可以点击跳转:

bert中文文本摘要代码(1)

bert中文文本摘要代码(2)

bert中文文本摘要代码(3)

【相关问题解答1】bert中文文本摘要代码:import时无法找到包时,几个潜在的原因和解决方法

【相关问题解答2】bert中文文本摘要代码:结果输出为一些重复的标点符号和数字

问题1

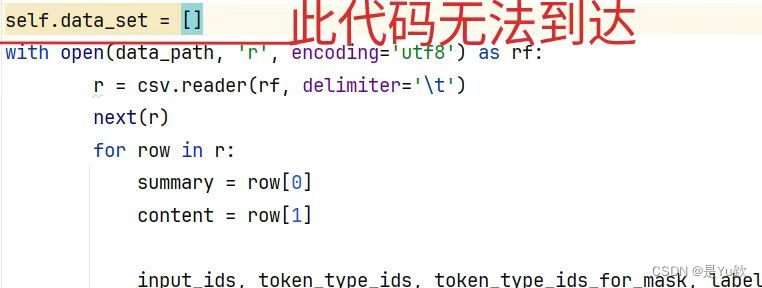

问题描述

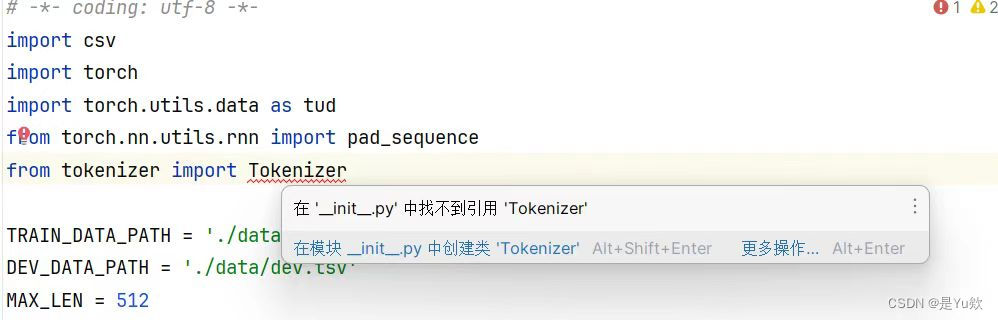

from tokenizer import Tokenizer

在’init_py’中找不到引用 Tokenizer

运行时报错:

Traceback (most recent call last):

File “D:\pythonpro\pythonProject\text.train.py”, line 6, in

from tokenizer import Tokenizer

ImportError: cannot import name ‘Tokenizer’ from ‘tokenizer’ (D:\pythonpro\pythonProject.venv\Lib\site-packages\tokenizer_init_.py). Did you mean: ‘tokenizer’?

一些建议

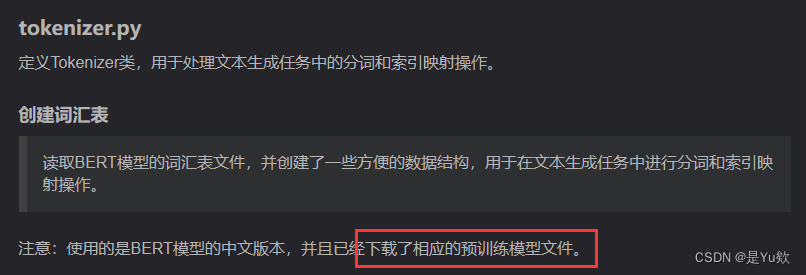

在这个项目中,目标是使用一个名为Tokenizer的类或功能。

然后本地有一个模块或包名为tokenizer,并且希望从中导入一个名为Tokenizer的类或函数。

如果是这种情况,需要确保文件结构和导入路径正确。

在前面的博客文档中有介绍,可以顺着流程看一下:

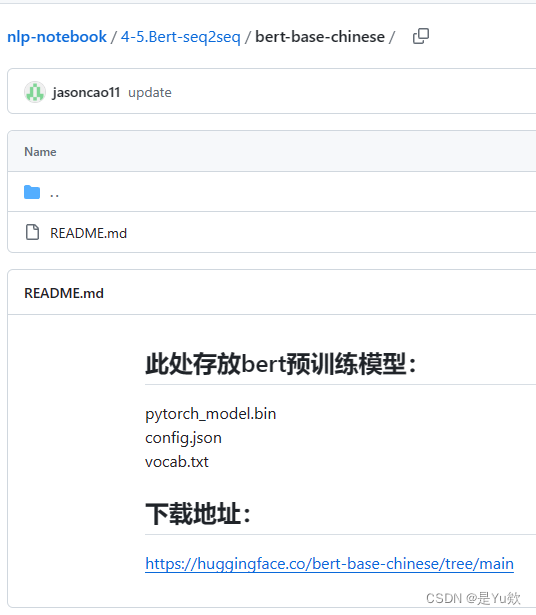

在代码4-5.Bert-seq2seq/bert-base-chinese文件夹下的readme中,也有关于Hugging Face的transformers库中的Tokenizer的安装地址,顺着安装就可以了

https://huggingface.co/bert-base-chinese/tree/main

如果还有问题,欢迎继续交流探讨 ~

import时无法找到包时,几个潜在的原因和解决方法

这里附赠一般项目遇到该问题的解决方案。

遇到这种情况时,通常有几个潜在的原因和解决方法。根据提供的错误信息,问题出现在尝试从tokenizer模块导入Tokenizer类时。错误提示表明Python无法在tokenizer包的__init__.py文件中找到Tokenizer这个名称。这可能是由于以下几个原因导致的:

1. 模块或包的命名冲突

如果您安装了一个名为tokenizer的第三方库,而您的项目中也尝试定义了一个同名的模块或包,可能会发生冲突。Python导入系统可能优先导入了安装的第三方库,而不是您项目中的模块。

解决方法:

- 重命名本地模块:确保您的项目中没有名为

tokenizer的模块或包与第三方库冲突。您可以尝试将本地的tokenizer模块重命名为其他名称,如my_tokenizer。 - 检查并调整PYTHONPATH:确保Python的搜索路径(PYTHONPATH)配置正确,以便首先导入您项目中的模块。

2. 错误的导入路径

可能您的目录结构与预期不符,或者Tokenizer类不在tokenizer包的__init__.py中定义。

解决方法:

- 确认目录结构:确保

Tokenizer类定义在正确的位置。如果Tokenizer是您自定义的类,请确认其位于正确的文件中,并且该文件是项目结构的一部分。 - 初始化文件:如果

Tokenizer类定义在tokenizer包的某个子模块中,您可能需要在__init__.py文件中显式地导入该类,以便可以从包直接导入。

3. 第三方库的使用错误

如果您确实是想要使用第三方的tokenizer库,可能是该库的使用方法有误。

解决方法:

- 查阅文档:确认您想要使用的

tokenizer库的文档,确保导入方式和类名正确。 - 安装正确的库:如果存在多个具有相似名称的库,请确保安装了正确的库。可能需要安装或引入不同的包以获取

Tokenizer类。

4. 包未正确安装

如果tokenizer是一个第三方库,可能该库未正确安装在您的环境中。

解决方法:

- 重新安装:尝试在您的环境中重新安装

tokenizer包,确保使用了正确的包名和版本。

在解决此问题时,可以仔细检查您的项目文件结构、导入语句,以及任何相关的第三方库文档。这些步骤应该能帮助您确定问题的根源并找到解决方法。