目录

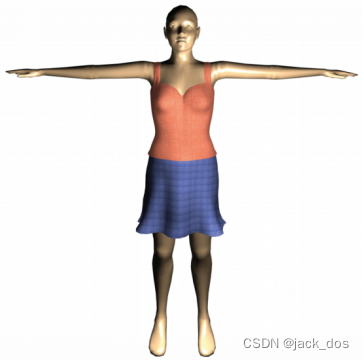

人体姿态检测

效果展示

举手检测

行业应用

代码实现

代码分析

效果展示

代码修改,一只手举起即可

总结

啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦^_^啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦♪(^∇^*)啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦啦

人体姿态检测

import cv2

import mediapipe as mp# 初始化MediaPipe Pose模型

mp_pose = mp.solutions.pose

pose = mp_pose.Pose()# 读取视频流或摄像头

cap = cv2.VideoCapture(0) # 0表示默认摄像头while cap.isOpened():ret, frame = cap.read()if not ret:break# 转换BGR图像为RGB图像rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)# 运行姿势估计模型results = pose.process(rgb_frame)# 绘制姿势关键点及连接线if results.pose_landmarks:mp.solutions.drawing_utils.draw_landmarks(frame, results.pose_landmarks, mp_pose.POSE_CONNECTIONS)# 显示结果cv2.imshow('Pose Estimation', frame)# 退出程序if cv2.waitKey(1) & 0xFF == 27: # 按ESC键退出break# 释放资源

cap.release()

cv2.destroyAllWindows()我这段代码使用了MediaPipe库中的姿势估计模型,它能够从摄像头捕获图像并检测人体的关键关节。以下是对代码的详细分析:

-

导入库:

cv2: OpenCV库,用于图像和视频处理。mediapipe: 包含MediaPipe库,其中包含了各种预训练的机器学习模型,包括姿势估计。

-

初始化姿势估计模型:

mp_pose = mp.solutions.pose: 导入姿势估计模型。pose = mp_pose.Pose(): 创建一个姿势估计对象。

-

打开摄像头:

cap = cv2.VideoCapture(0): 打开默认摄像头,创建一个VideoCapture对象。

-

循环处理每一帧:

while cap.isOpened():: 通过循环处理摄像头捕获的每一帧。ret, frame = cap.read(): 读取一帧图像,ret表示读取是否成功,frame是帧的图像。

-

图像处理:

rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB): 将BGR格式的图像转换为RGB格式,因为MediaPipe库使用RGB格式的图像。

-

姿势估计模型运行:

results = pose.process(rgb_frame): 运行姿势估计模型,获取关键关节的位置。

-

绘制关键点及连接线:

if results.pose_landmarks:: 检查是否检测到了姿势关键点。mp.solutions.drawing_utils.draw_landmarks(frame, results.pose_landmarks, mp_pose.POSE_CONNECTIONS): 绘制关键点及连接线在原始图像上。

-

显示结果:

cv2.imshow('Pose Estimation', frame): 显示带有姿势估计结果的图像。

-

退出程序:

if cv2.waitKey(1) & 0xFF == 27:: 检测是否按下ESC键(ASCII码27),如果是则退出循环。

-

释放资源:

cap.release(): 释放摄像头资源。cv2.destroyAllWindows(): 关闭所有图像窗口。

就是这样的,这只是软件包的基础应用。

效果展示

比较社恐,我就先打码了

当然,如果我站起来就真没法截图了,没法翘脚,腿部也是可以识别的

那么既然已经实现了这个简单的基础小功能,那么为什么不做点什么实际的好东西出来呢??

嘿嘿(手动坏笑)

举手检测

行业应用

举手检测在许多应用中都可以发挥作用,特别是在交互式和人机界面领域。以下是一些例子:

-

手势控制界面: 通过举手或特定手势来控制电子设备、计算机或应用程序,例如切换页面、调整音量、播放/暂停媒体等。

-

虚拟现实(VR)和增强现实(AR): 在VR和AR应用中,举手检测可以用于手势交互,改变虚拟环境中的元素,例如拾取物体、绘画等。

-

教育应用: 举手检测可以用于教育应用,帮助学生更直观地与教学内容进行互动,例如参与互动式课堂、学习手语等。

-

游戏控制: 游戏开发者可以使用举手检测来实现新颖的游戏控制方式,提供更具体的玩家交互体验。

-

体感运动训练: 在健身应用或体感游戏中,举手检测可以用于监测用户的运动姿势,提供实时反馈和指导。

-

会议和演示: 在远程会议或演示中,举手检测可以作为一种简便的手势来表达意见、提问或切换幻灯片。

-

无接触式交互设备: 举手检测可以在公共场所用于创建无触摸的交互设备,例如自动门、自动售货机等。

-

身体语言分析: 通过分析举手动作,可以进行身体语言分析,识别用户的情感状态、兴奋程度等,用于用户体验研究或情感计算。

-

辅助技术: 举手检测可以在辅助技术领域中用于帮助残障人士进行电脑交互,例如通过手势控制轮椅或进行文字输入。

代码实现

import cv2

import mediapipe as mp

import time# 初始化MediaPipe Pose模型

mp_pose = mp.solutions.pose

pose = mp_pose.Pose()# 读取视频流或摄像头

cap = cv2.VideoCapture(0) # 0表示默认摄像头# 初始化FPS计算

prev_time = 0while cap.isOpened():ret, frame = cap.read()if not ret:break# 转换BGR图像为RGB图像rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)# 记录处理开始时间start_time = time.time()# 运行姿势估计模型results = pose.process(rgb_frame)# 记录处理结束时间end_time = time.time()# 计算FPSfps = 1 / (end_time - start_time)# 绘制姿势关键点及连接线if results.pose_landmarks:mp.solutions.drawing_utils.draw_landmarks(frame, results.pose_landmarks, mp_pose.POSE_CONNECTIONS)# 获取左右手关键点的坐标left_hand = results.pose_landmarks.landmark[mp_pose.PoseLandmark.LEFT_WRIST].yright_hand = results.pose_landmarks.landmark[mp_pose.PoseLandmark.RIGHT_WRIST].y# 判断是否举手(示例:手腕高于肩部)if left_hand < results.pose_landmarks.landmark[mp_pose.PoseLandmark.LEFT_SHOULDER].y and \right_hand < results.pose_landmarks.landmark[mp_pose.PoseLandmark.RIGHT_SHOULDER].y:cv2.putText(frame, 'Hands raised', (10, 60), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)# 在图像上显示FPScv2.putText(frame, f'FPS: {int(fps)}', (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)# 显示结果cv2.imshow('Pose Estimation', frame)# 退出程序if cv2.waitKey(1) & 0xFF == 27: # 按ESC键退出break# 释放资源

cap.release()

cv2.destroyAllWindows()

代码分析

我这段代码使用了 MediaPipe 库来实现实时的姿势估计,并通过检测手的位置来判断是否举手。以下是对代码的详细分析:

-

导入库:

cv2: OpenCV库,用于图像和视频处理。mediapipe: 包含 MediaPipe 库,其中包含了各种预训练的机器学习模型,包括姿势估计。

-

初始化姿势估计模型:

mp_pose = mp.solutions.pose: 导入姿势估计模型。pose = mp_pose.Pose(): 创建一个姿势估计对象。

-

打开摄像头:

cap = cv2.VideoCapture(0): 打开默认摄像头,创建一个 VideoCapture 对象。

-

初始化FPS计算:

prev_time = 0: 用于计算每秒处理的帧数(FPS)。

-

循环处理每一帧:

while cap.isOpened():: 通过循环处理摄像头捕获的每一帧。ret, frame = cap.read(): 读取一帧图像,ret表示读取是否成功,frame是帧的图像。

-

图像处理:

rgb_frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB): 将 BGR 格式的图像转换为 RGB 格式,因为 MediaPipe 库使用 RGB 格式的图像。

-

姿势估计模型运行:

results = pose.process(rgb_frame): 运行姿势估计模型,获取关键关节的位置。

-

记录处理时间和计算FPS:

- 记录处理开始时间和结束时间,然后计算帧率(FPS)。

-

绘制关键点及连接线:

if results.pose_landmarks:: 检查是否检测到了姿势关键点。mp.solutions.drawing_utils.draw_landmarks(frame, results.pose_landmarks, mp_pose.POSE_CONNECTIONS): 绘制关键点及连接线在原始图像上。

-

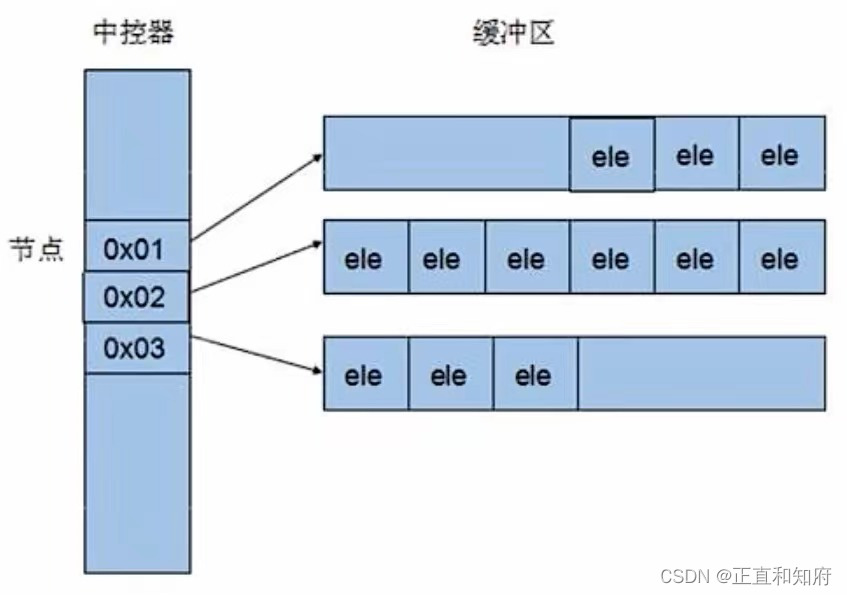

判断是否举手:

- 获取左右手关键点的 y 坐标,并与肩部的 y 坐标进行比较,以判断是否举手。

- 如果判断为举手,使用

cv2.putText在图像上方显示 "Hands raised"。

-

在图像上显示FPS:

cv2.putText(frame, f'FPS: {int(fps)}', (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2): 在图像左上角显示当前帧率。

-

显示结果:

cv2.imshow('Pose Estimation', frame): 显示带有姿势估计结果的图像。

-

退出程序:

if cv2.waitKey(1) & 0xFF == 27:: 检测是否按下 ESC 键(ASCII码27),如果是则退出循环。

-

释放资源:

cap.release(): 释放摄像头资源。cv2.destroyAllWindows(): 关闭所有图像窗口。

小总结,这段代码通过姿势估计检测手的位置,判断是否举手,并在图像上方显示相应的提示。帧率(FPS)也会在图像左上角显示。

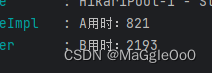

效果展示

举手之后就会显示hands raised

那么细心的小伙伴就发现了,为什么是hands而不是hand,哈哈哈,因为我是两只手都举起来才有效果。

那么也是可以修改为任意一只手举起来就显示举手的

代码修改,一只手举起即可

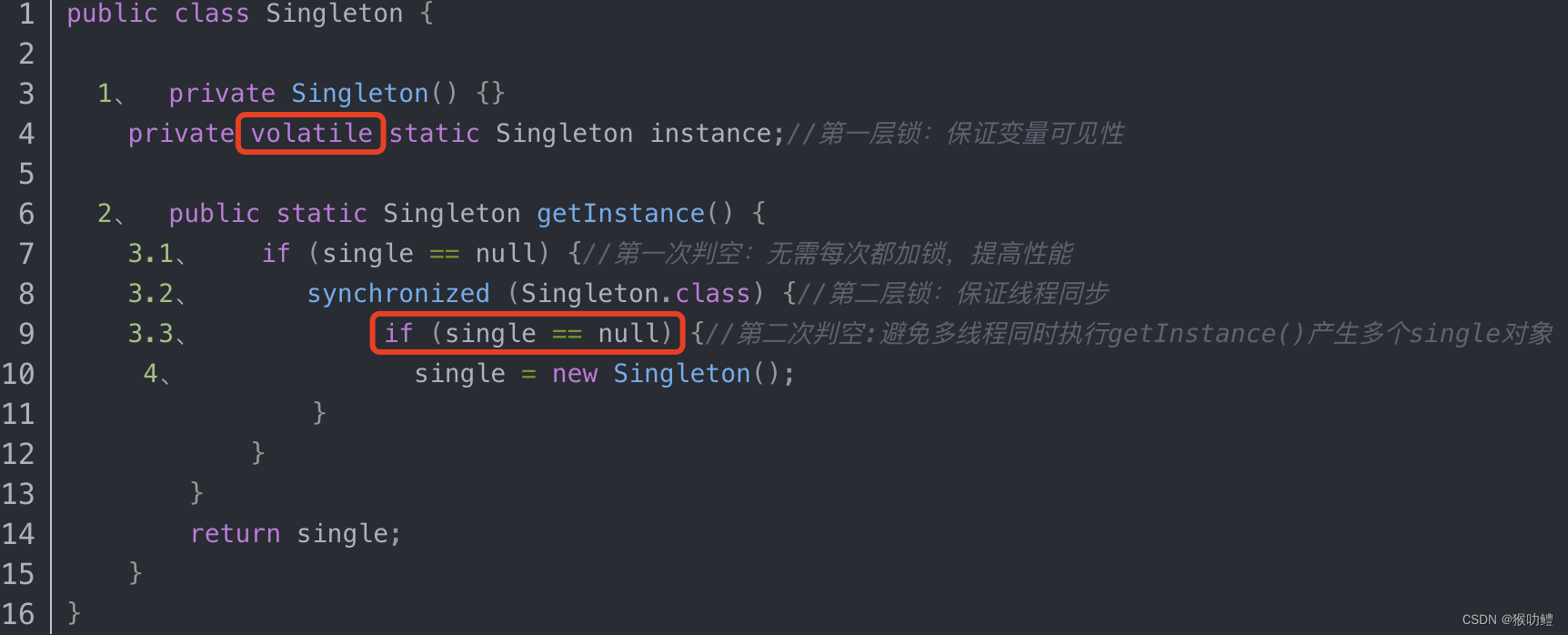

也很简单,将第44行的判断从and同时满足修改为or,一个满足即可

总结

在这篇文章中,我们首先介绍了使用 MediaPipe 库进行人体姿态检测的基础应用。通过简单的代码实现,我们能够从摄像头捕获图像,利用 MediaPipe 提供的姿势估计模型检测人体关键关节的位置,并在图像上绘制出关键点和连接线,从而实现实时的姿势估计。这为后续的应用奠定了基础。

接着,我们引入了一个更具实际应用意义的场景——举手检测。通过对姿势估计模型输出的手部关键点进行垂直位置的比较,我们实现了一个简单的举手检测系统。当两只手同时举起时,程序会在图像上方显示 "Hands raised" 的提示,为用户提供了一种直观的交互方式。

最后,我们展示了如何通过简单的修改,将举手检测条件从要求两只手同时举起变为只需任意一只手举起即可。这样的灵活性使得代码能够适应不同的应用场景,例如在教育、会议、游戏等领域中,通过手势交互实现更加智能化的应用。

而且什么,就是说,我还有一个邪恶的想法,把这个程序安装到教室中,老师有一个终端可以实时看见那些学生举手,不用举的太高略微超过肩部即可,这样老师就可以尽情的让学生起立回答问题啦,又克服了社恐的问题,完美!@!~~

ヾ( ̄▽ ̄)Bye~Bye~