MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training

相关链接:arxiv

关键字:多模态学习、大型语言模型、预训练、视觉语言连接、混合专家模型

摘要

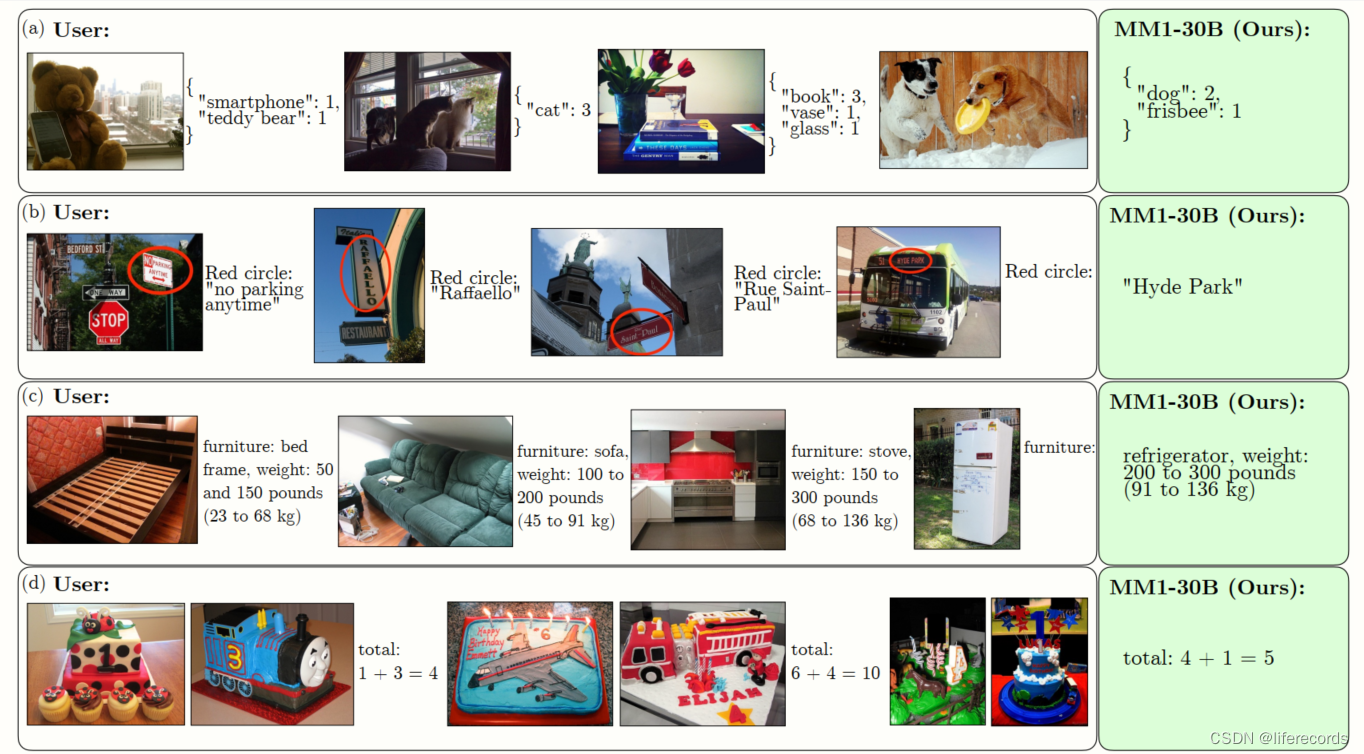

本文讨论了构建高性能的多模态大型语言模型(MLLMs)。特别地,我们研究了各种架构组件和数据选择的重要性。通过对图像编码器、视觉语言连接器以及各种预训练数据选择进行仔细全面的消融实验,我们确定了几个关键的设计经验。例如,我们展示了对于使用精心混合的图像标题、交错的图像文本和纯文本数据进行的大规模多模态预训练,在多个基准测试中实现最先进的(SOTA)少样本结果至关重要,与其他已发布的预训练结果相比。此外,我们展示了图像编码器与图像分辨率和图像标记计数有重大影响,而视觉语言连接器设计的重要性相对较小。通过扩展这些方法,我们构建了MM1,一个多模态模型家族,参数量高达30B,包括密集模型和混合专家(MoE)变体,这些模型在预训练指标上是最先进的,并在一系列已建立的多模态基准测试中经过监督微调后取得了有竞争力的性能。得益于大规模预训练,MM1具有吸引人的特性,如增强的上下文学习能力、多图像推理,使得少样本链式思维提示成为可能。

核心方法

- 图像编码器和视觉语言连接器的设计:我们发现图像分辨率对性能影响最大,其次是模型大小和训练数据组成。而视觉语言连接器的架构设计对最终性能的影响相对较小。

- 预训练数据的选择:我们发现交错的图像文本数据和纯文本数据对于少样本和纯文本性能至关重要,而对于零样本性能,标题数据最为重要。

- 模型架构和训练过程:我们探索了不同的预训练图像编码器,并研究了如何将视觉特征桥接到LLM空间。我们还详细阐述了如何训练MLLM,包括超参数和训练模型的哪些部分。

实验说明

| 实验名称 | 数据集 | 指标 | 结果 | 备注 |

|---|---|---|---|---|

| MM1-3B | 多种数据源 | 准确率 | 73.5 | 包括图像标题、交错图像文本和纯文本数据 |

| MM1-7B | 多种数据源 | F1分数 | 61.0 | 同上 |

| MM1-30B | 多种数据源 | 准确率 | 54.6 | 同上 |

实验结果表明,MM1模型在多个基准测试中取得了先进的性能,特别是在少样本学习方面。数据来源包括图像标题、交错的图像文本文档和纯文本数据。

结论

通过仔细的建模和数据选择消融实验,我们确定了重要的经验教训,这些经验教训产生了一个在一系列少样本评估中取得SOTA结果的预训练模型。在SFT之后,这个模型家族在广泛的基准测试中产生了有竞争力的性能,同时启用了多图像推理和少样本提示。我们希望这些确定的经验教训能够帮助社区构建强大的模型,超越任何单一的具体模型架构或数据策略。