源自:专知

“人工智能技术与咨询” 发布

大模型在人工智能领域取得了革命性的突破,但它们也可能带来潜在的担忧。为了解决这些担忧,引入了对齐技术,以使这些模型遵循人类的偏好和价值观。尽管过去一年取得了相当大的进展,但在建立最佳对齐策略时仍然存在各种挑战,例如数据成本和可扩展的监督,如何对齐仍然是一个悬而未决的问题。在这篇综述文章中,我们全面调查了价值对齐方法。我们首先解析对齐的历史背景,追溯到20世纪20年代(它来自哪里),然后深入探讨对齐的数学本质(它是什么),揭示了固有的挑战。在此基础上,我们详细检查了现有的对齐方法,这些方法分为三类:强化学习、监督式微调和上下文内学习,并展示了它们之间的内在联系、优势和限制,帮助读者更好地理解这一研究领域。此外,还讨论了两个新兴主题:个人对齐和多模态对齐,作为该领域的新前沿。展望未来,我们讨论了潜在的对齐范式以及它们如何处理剩余的挑战,展望未来对齐的方向。

https://www.zhuanzhi.ai/paper/7868e1b5d373ca9ba85ae00d67522a8c

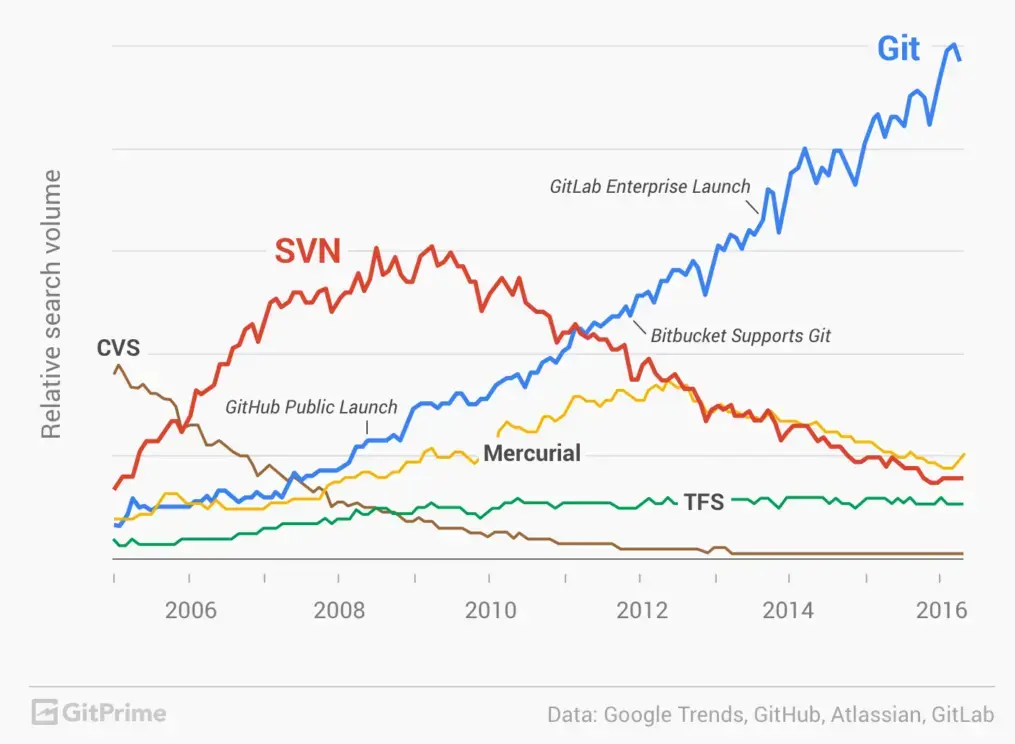

大模型,是指在大量数据上训练并包含超过数十亿参数的神经模型(Bommasani et al., 2021),通常包括大型语言模型(LLMs)和大型多模态模型(LMMs)。LLMs 通常是基于Transformer(Vaswani et al., 2017)的大规模语言模型,以自回归方式训练(Zhao et al., 2023a),如GPT-3(Brown et al., 2020)、PaLM(Narang and Chowdhery, 2022)、ChatGPT(Ouyang et al., 2022)、Bard(Aydin, 2023)和LLaMA(Touvron et al., 2023a)。LLMs 的卓越能力也促进了LMMs 的发展,LMMs 能够处理图像(视觉)和自然语言文本(语言)(Dirik and Paul, 2023),如PaLM-E(Driess et al., 2023)、LLaVA(Liu et al., 2023c)、DALL-E 3(Betker et al., 2023)和Gemini(Team et al., 2023)。与小模型(Cho et al., 2014;Devlin et al., 2018)不同,大模型展示了两个独特特征:规模化法则(Kaplan et al., 2020),阐明了模型规模增长与性能改进之间的一致关系,以及新兴能力(Wei et al., 2022a)显示,当模型规模超过某一阈值时,意外地出现了在小模型中未观察到的新能力,如上下文内学习(Wang et al., 2023a)、指令跟随和跨多种任务和领域的逐步推理(Wei et al., 2022b),革新了AI的角色。因此,语言模型(LMs)经历了逐步的演化,从统计语言模型(SLMs)(Pauls and Klein, 2011)和神经语言模型(NLMs)(Cho et al., 2014)开始,进步到预训练语言模型(PLMs)(Devlin et al., 2018;Radford et al., 2019),最终导致LLMs的复杂出现。沿着这样的轨迹,LLMs 也通过整合大规模图文对和精心设计的目标进行预训练,建立这两种模态之间的内在联系(Dosovitskiy et al., 2020;Liu et al., 2021)。这些大模型已经演变成各种变体,如图1所示,深刻影响了多个行业和领域,根本性地改变了我们解决实际问题的方式。

然而,每枚硬币都有两面。由于大模型通常是在从互联网爬取的数据集上预训练的,它们也可能内化风险信息并引发一些潜在的担忧(Tamkin et al., 2021; Bender et al., 2021; Kaddour et al., 2023),包括产生社会偏见(Sheng et al., 2019)、有害语言和排斥(Gehman et al., 2020)、错误信息(Bommasani et al., 2021)和社会经济伤害(Weidinger et al., 2022),对社会造成深远的影响。此外,观察到两个风险特征,(1)逆规模化:某些风险可能不仅仅是保持不变,而且随着模型规模的增加而恶化(McKenzie et al., 2023),(2)新兴风险:未见的风险可能出现或显著放大的现有风险随着更大的模型而出现(Wei et al., 2022a),使得之前建立的特定风险方法难以处理迅速出现的潜在问题。对这些伦理和社会风险给予极高的重视是至关重要的。低估这些风险可能会导致严重的后果。例如,可能煽动仇恨或暴力的有害语言,可能导致财产损失的私人数据泄露,以及在敏感领域可能造成伤害的错误信息,例如不准确的法律或医疗建议(Weidinger et al., 2021)。

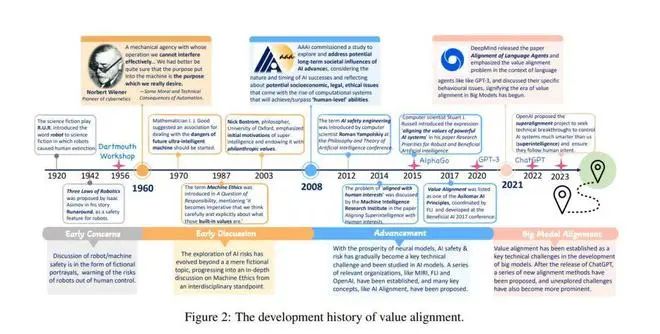

为了解决上述风险,研究人员开发了各种对齐方法,以使LLMs与人类指令、偏好和价值观对齐(Ouyang et al., 2022; Liu et al., 2022; Rafailov et al., 2023)。在LMMs的背景下,"对齐"这一术语传统上指的是不同模态之间的对齐,如视觉和语言(Jia et al., 2021; Radford et al., 2021)。然而,随着LLMs中对齐技术的进步,现在它倾向于代表使LMMs对齐,以使它们遵循人类指令并完成多样化的任务(Liu et al., 2023c; Zhu et al., 2023; Dai et al., 2023)。对齐的概念可以追溯到诺伯特·维纳的表述,“我们最好确信放入机器中的目的是我们真正想要的目的”(Wiener, 1960),这被定义为“A试图做H想要它做的事情”,其中A和H是现代AI研究中的两个智能代理(Yudkowsky, 2016; Christiano, 2018)。随后,对齐的研究在强化学习(RL)领域逐渐获得重要性(Hadfield-Menell et al., 2016; Everitt and Hutter, 2018; Leike et al., 2018),并在大模型时代蓬勃发展(Kenton et al., 2021),培育了多样化的生成模型和多模态模型,如图1所示。良好对齐的AI代理,例如LLMs,不仅具有遵循用户指令从而协助完成任务或回答问题的能力,还有避免生成攻击性或歧视性内容的能力(Askell et al., 2021)。相反,未对齐的AI将会导致潜在风险,如真实性问题、错误信息、上瘾和群体两极分化(Zhuang and Hadfield-Menell, 2020; Pan et al., 2022),如前所述。

尽管近年来取得了显著进展,但对大模型对齐的研究仍处于初级阶段,理解这一主题仍存在许多模糊和困难。认识到对齐的重要性,本文致力于对现有对齐方法进行全面的综述和分析,以促进人工智能与人类的共生未来。我们的范围包括:i) 介绍对齐的历史并详述对齐的本质(第2节),ii) 回顾现有方法论并分析其优势、劣势和联系(第3节),以及iii) 讨论未来的挑战和研究方向(第4节)。

对齐目标

在深入探讨如何对齐之前,我们首先简要介绍需要对齐的目标。对齐目标的讨论源自于规范问题,即我们如何定义我们期望从人工智能中得到的目的?(Leike et al., 2018),这可以从两个方面考虑(Gabriel, 2020):(1)规范方面:我们应该将什么目标编码进人工智能中,以及(2)技术方面:我们如何形式化和建模这些目标。未能实现目标可能会导致人工智能寻找漏洞并以意料之外的方式实现目标,这被称为规范游戏(Skalse et al., 2022)。从前者方面来看,对齐目标范围从指令、意图和偏好到利益、价值等(Gabriel, 2020)。另一个流行的目标是有益、诚实和无害(HHH)原则(Askell et al., 2021)。然而,大部分工作(Ouyang et al., 2022; Rafailov et al., 2023)强调对齐方法,而忽略了关于哪个目标最合适的分析。

良好对齐的模型能够生成与这些确定的目标一致的内容。然而,由于评估者追求错误的目标、问题奖励模型或策略(Casper et al., 2023),可能会出现错位问题。错位的模型可能会无意中导致意料之外或不希望的伤害和后果。例如,存在恶意使用的潜力,这些模型可能生成错误信息或歧视性和有害的内容(Brundage et al., 2018)。此外,即便是相当良好对齐的模型,也仍然可能展现出某些缺陷。它们可能产生幻觉(Ji et al., 2023),传播偏见(Santurkar et al., 2023),并且容易受到如越狱(Li et al., 2023b)等对抗性攻击的影响。

总体而言,实现对齐需要仔细考虑它们应该对齐的各种目标,解决潜在的错位问题,并减轻这些模型可能具有的限制和脆弱性。

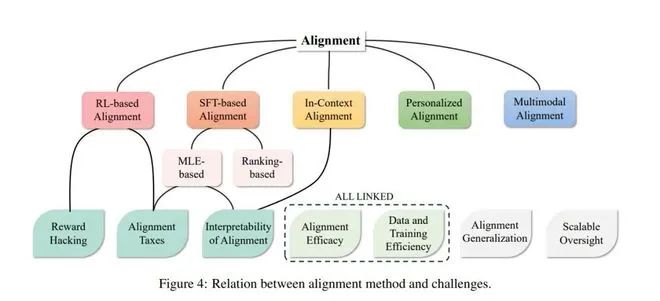

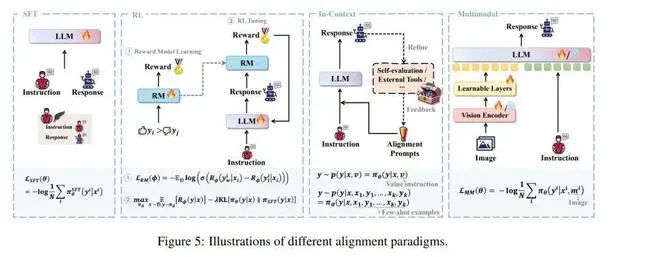

对齐方法

LLMs的对齐方法主要分为三种范式:基于强化学习的对齐(第3.1节)、基于监督式微调的对齐(第3.2节)和上下文内对齐(第3.3节)。在这一节中,我们将介绍和讨论它们,以及个性化对齐(第3.5节)和LMM对齐(第3.4节),并建立它们与第2节中介绍的定义的联系。所有类别的对齐方法都在附录中的图7中总结。

强化学习对齐

RLHF的理念最初在(Christiano et al., 2017)中被揭示,其中人类偏好是针对代理轨迹的片段表达的,用于深度强化学习,使得学习更复杂的行为成为可能。之后,Stiennon等人(2020)将RLHF技术应用于摘要任务中,并学习人类对不同摘要的偏好,从而显著提高了质量。此外,Nakano等人(2021)提出了WebGPT,它在GPT-3上进行微调,并利用RLHF来提炼网页导航和信息检索的能力。这些早期使用RLHF的研究主要旨在提高模型性能,特别是在“有用性”或“诚实性”方面,可能忽略了“无害性”(HHH)(Askell et al., 2021)。这种失败可能会导致LLMs与人类价值观的错位,导致模型输出对用户有害或不真实,如第1节所述。

为了减少这种伤害,InstructGPT(Ouyang et al., 2022)利用RLHF与用户的意图对齐,后者通过标记的模型响应来表示,以满足HHH原则。RLHF技术直接催生了最成功的互动对话LLMs之一,ChatGPT,激发了对人工通用智能(AGI)的追求。

尽管RLHF的效果令人满意,但它需要同时加载至少三个LLMs,即πθ、πSFT和Rϕ,以及大量高质量的手动标记数据,D(x, yw, yl)。这带来了无法承受的数据/训练成本(RC3)。为了应对这一挑战,提出了Constitutional AI(Bai et al., 2022b)以实现与人类标签的对齐。这种方法类似于RLHF,但通过要求LLM生成并修正其响应来自动创建对(yw, yl)。这个框架促进了对齐的新方向,即基于AI反馈的强化学习(RLAIF)。随后,开发了RLAIF的不同变体。Kim等人(2023)首先利用来自不同规模和提示的LLMs衍生的合成偏好数据来训练奖励模型。然后,他们自动生成高质量的示范用于SFT步骤,接着进行奖励模型的RL调整。另一方面,为了提高RLHF的计算效率,Gulcehre等人(2023)提出了一种离线强化自训练(ReST)方法。ReST从最新LLM策略中采样多个响应以扩充训练数据集(增长步骤),然后使用过滤后的数据通过离线RL目标对LLM策略进行微调(改进步骤)。

RLHF在实现相对良好的泛化方面已被证明是有效的,具有更好利用人类反馈信号的潜力。然而,它因训练不稳定和高训练/数据成本(RC3)而臭名昭著,这阻碍了RLHF进一步的适应性(RC2)和可扩展性(RC6)。此外,方程(7)中不同项之间的权衡是难以处理的(RC5),而RC4&7也仍未解决(Casper et al., 2023)。

考虑到SFT和RL的成本,以及大多数主流LLMs是黑盒的事实,基于微调的对齐方法变得越来越难以承担或不可行。因此,另一种受欢迎的范式——基于上下文学习(ICL)的对齐——吸引了更多的注意。这种方法利用了LLMs在预训练和指令调整阶段获得的庞大知识和遵循指令的能力。

多模态对齐

除了LLMs之外,大型多模态模型(LMMs)近年来也开启了发展的新篇章,能够同时处理多种模态,如图像、视频和文本,并学习从一种模态到另一种模态的映射(Liu et al., 2023c)。对LLMs的初步对齐成就表明了在多模态场景中进行对齐的潜力。具体来说,一系列工作整合了预训练的视觉编码器和LLM,并进行指令调整,以赋予LLM视觉问答(QA)能力,例如LLaVA(Liu et al., 2023c)、MiniGPT-4(Zhu et al., 2023)等(Li et al., 2023a;Gong et al., 2023;Dai et al., 2023)。LLaVA(Liu et al., 2023c)是将指令调整扩展到LLMs的第一步,它结合了CLIP的视觉编码器和基于LLaMA的语言解码器,并在GPT-4生成的多模态数据集上进行视觉指令调整。MiniGPT-4(Zhu et al., 2023)仅训练单个投影层以将编码的视觉特征与Vicuna语言模型对齐。经过在精选小数据集上的指令调整后,MiniGPT-4能生成更自然、更可靠的语言输出。对于文本到图像的任务,受LLMs中RLHF有效性的启发,Lee等人(2023)提出了一种直接从人类反馈中学习的微调方法。该过程首先收集人类关于生成图像是否与其输入文本提示相对应的偏好数据,学习基于这些数据的奖励模型,最后,使用奖励加权似然最大化优化文本到图像模型以实现对齐。为了与人类审美价值对齐,Wu等人(2023b)首先利用人类选择的图像微调CLIP模型作为偏好分类器。这个分类器用于为训练数据集产生伪奖励,进一步用于微调Stable Diffusion模型。训练后的模型可以生成人类更偏好的更好审美质量的图像。

多模态对齐目前处于其发展的非常初期阶段,主要强调与人类指令的对齐,但忽略了如美德和社会规范等高层次和多样化的人类价值。确保无害性提出了一个重大且不可忽视的挑战。

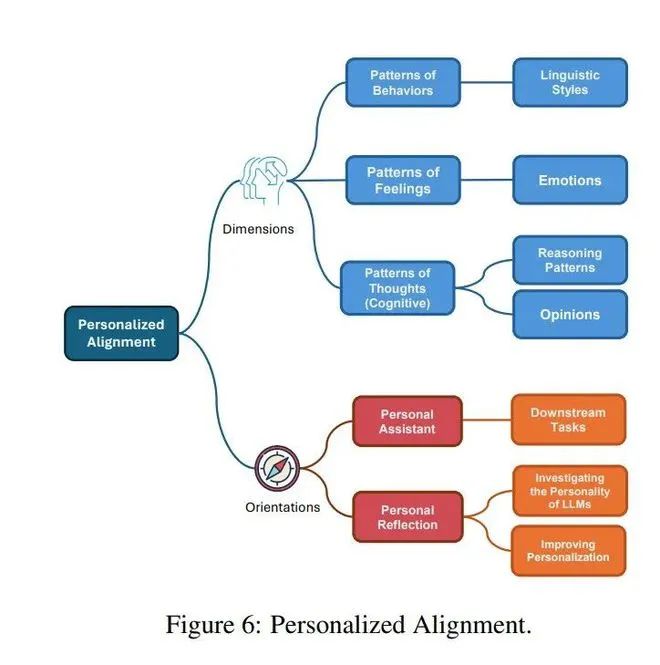

个性化对齐

在心理学领域,个性指的是构成个体独特性的独特特征、特质以及思想、感觉和行为模式的模式。由于个性在塑造人类行为中扮演着重要角色,过去几十年提出了大量理论和模型来解释和分类个性的不同方面(McAdams and Pals, 2006; Roccas et al., 2002; Maslow, 1958; Freud, 1975; Bandura and Walters, 1977)。随着大型语言模型在自然语言处理(NLP)中的革命性出现,研究发现,大型语言模型在特定提示配置下可以模拟出可靠和有效的个性(Safdari et al., 2023; Hagendorff, 2023; Jiang et al., 2023),而且对于更大和经过指令微调的模型,LLMs模拟的个性可能更强(Safdari et al., 2023),这为个性化大型语言模型提供了支持。

结论

在这项工作中,我们深入探讨了对齐的起源和本质,系统地介绍了其发展、目标、形式化和评估。我们还回顾了现有的对齐研究,并分析了每个范式是如何从原始形式衍生出来的,并建立了它们的内在联系。通过对对齐进行全面分析并识别未来的挑战和研究方向,我们旨在为大模型的对齐方法的理解和进步做出贡献,指导这些人工智能系统不仅避免造成伤害,而且还意图做出善举,最终实现一个人工智能与人类共生的未来社会。

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

声明:公众号转载的文章及图片出于非商业性的教育和科研目的供大家参考和探讨,并不意味着支持其观点或证实其内容的真实性。版权归原作者所有,如转载稿涉及版权等问题,请立即联系我们删除。

“人工智能技术与咨询” 发布