Lagent:智能体框架,实现将一个大语言模型转化为多种类型的智能体,更好地发挥InternLM的性能

浦语·灵笔:视觉·语言大模型

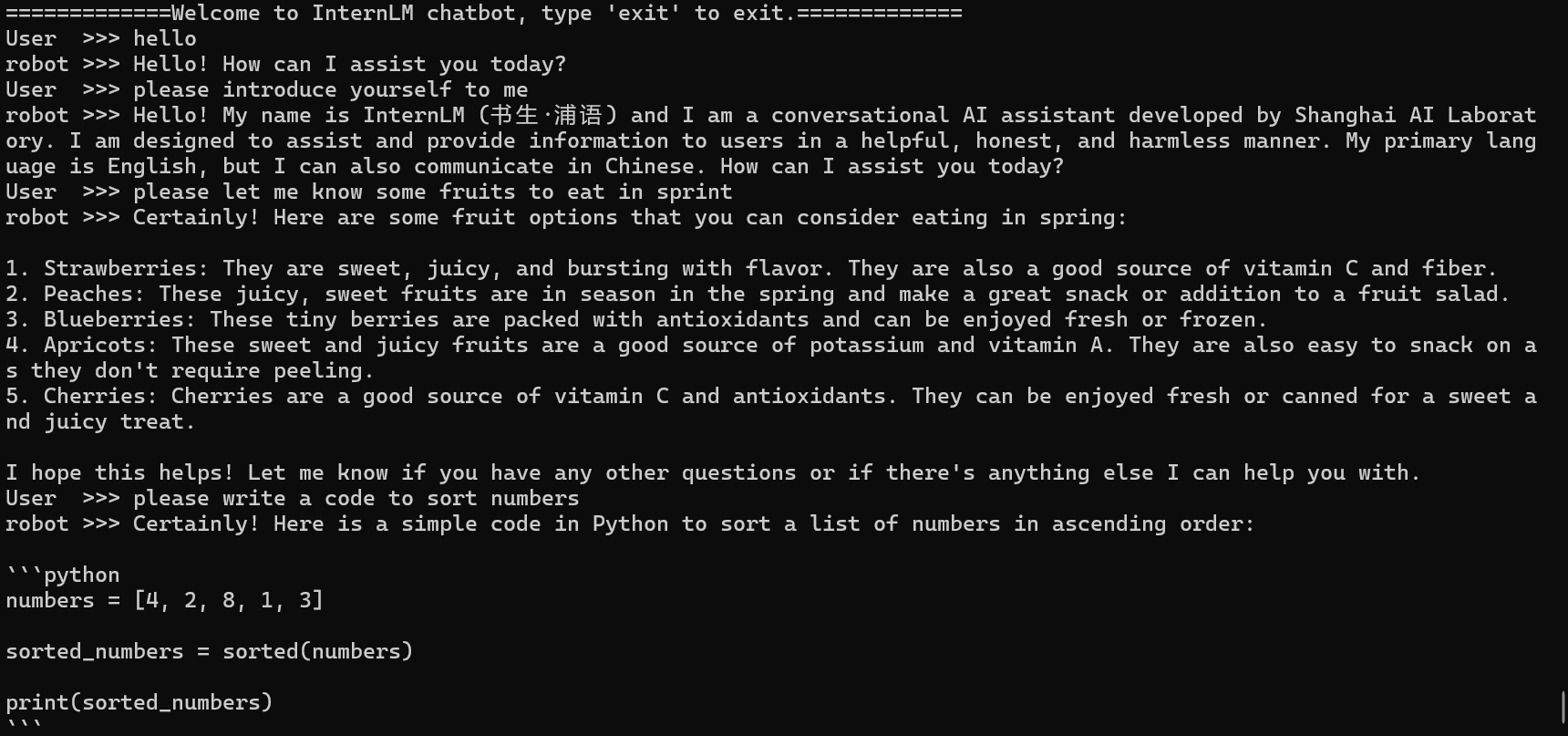

InternLM-Chat-7B智能对话Demo

- 环境准备

使用复制的internlm-demo环境

# 执行该脚本文件来安装项目实验环境,实验环境名为internlm-demo

bash /root/share/install_conda_env_internlm_base.sh internlm-demo

- 模型下载

mkdir -p /root/model/Shanghai_AI_Laboratory

# 直接使用internLM studio开发机中原有的环境

cp -r /root/share/temp/model_repos/internlm-chat-7b /root/model/Shanghai_AI_Laboratory

-

代码准备

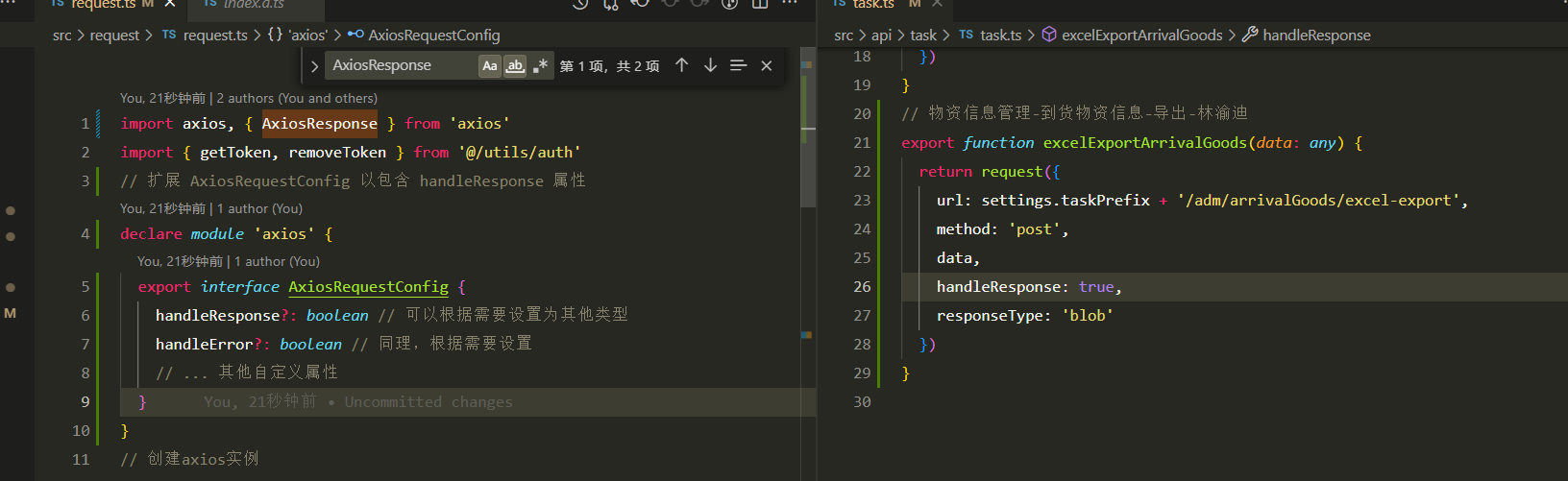

clone InternLM的代码,修改模型路径为本地模型 -

终端运行

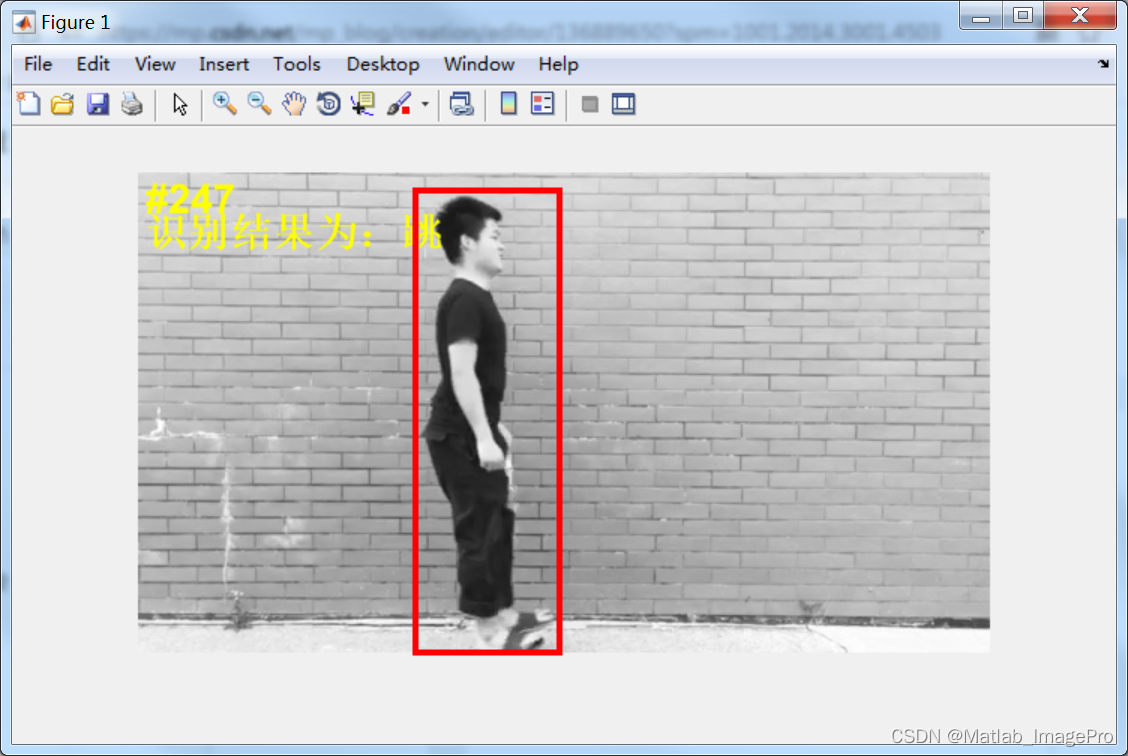

运行结果展示如下:

-

web-demo的运行

# 运行web_demo代码

streamlit run /root/code/lagent/examples/react_web_demo.py --server.address 127.0.0.1 --server.port 6006

# 映射配置

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 33090

运行结果展示如下:

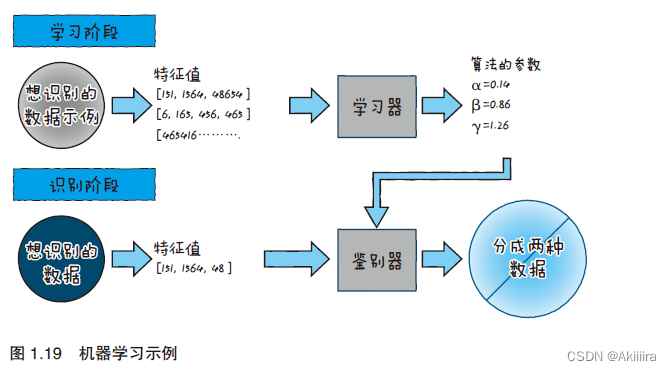

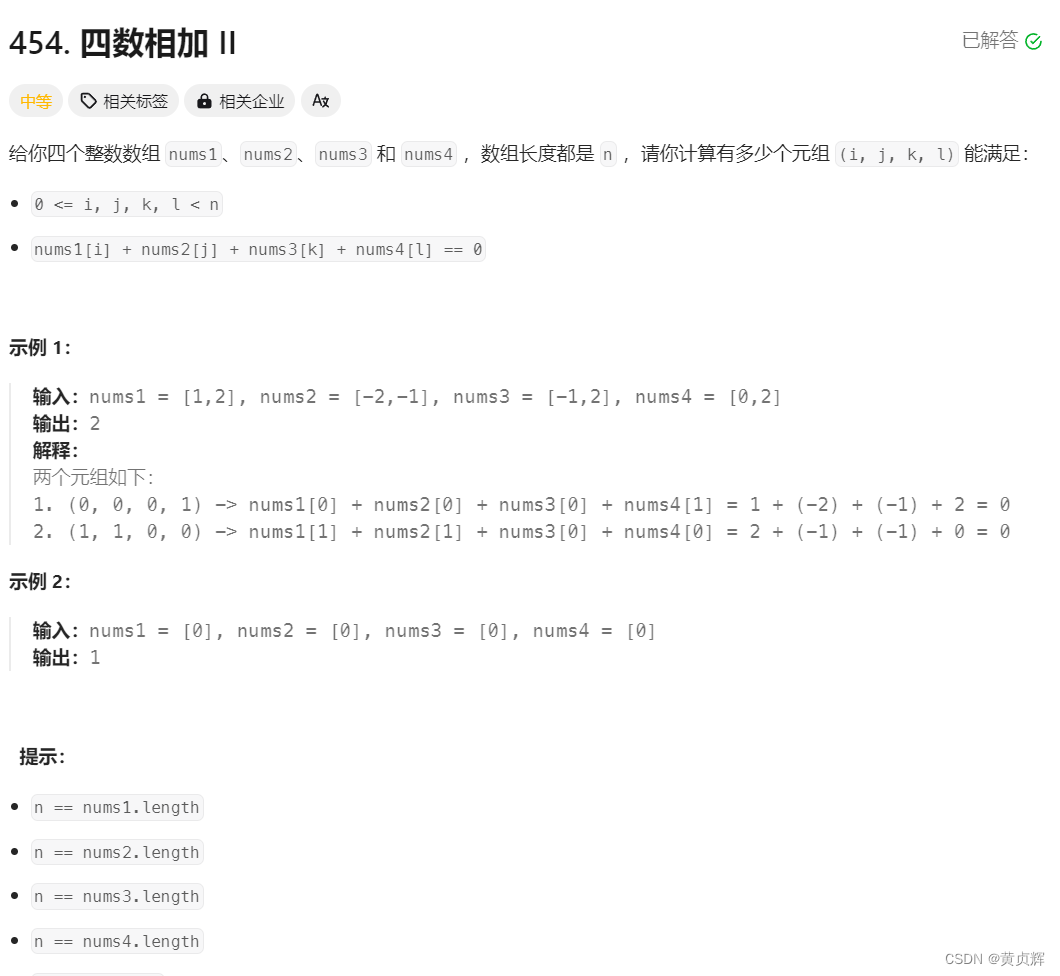

Lagent 智能体工具调用Demo

lagent:轻量级、开源的基于大语言模型的智能体(agent)框架,赋予llm以agent能力

-

环境准备

和上面的对话Demo使用相同的镜像环境 -

模型下载

和上面的对话Demo使用相同的模型InternLM-chat-7b -

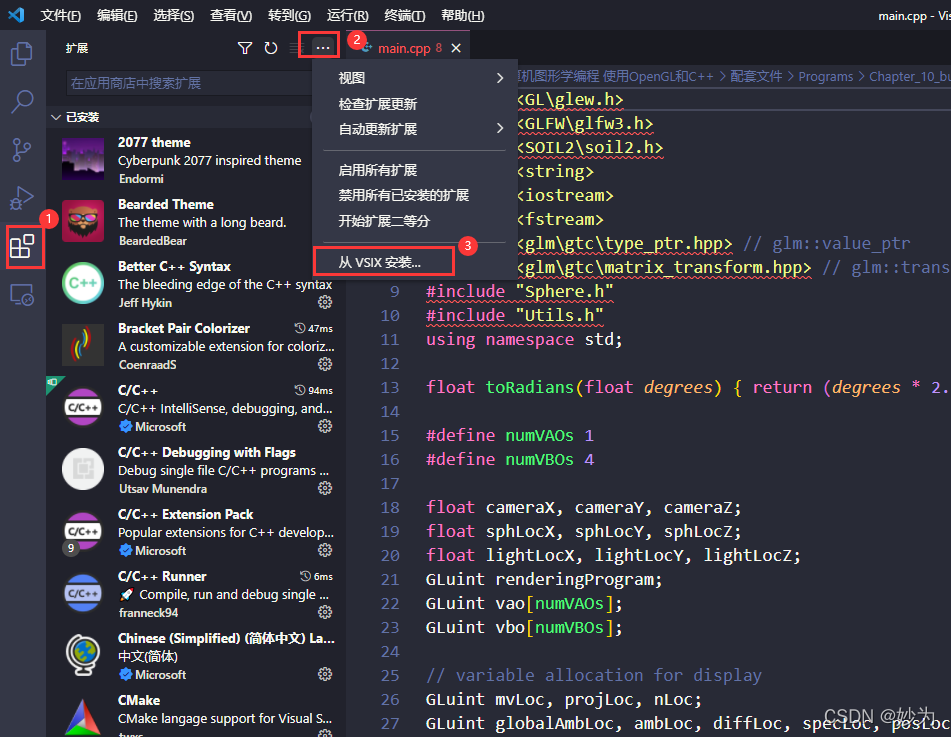

Lagent安装

克隆lagent仓库,通过pip install -e .源码安装lagent -

Demo运行

使用bash命令运行web_demo

streamlit run /root/code/lagent/examples/react_web_demo.py --server.address 127.0.0.1 --server.port 6006

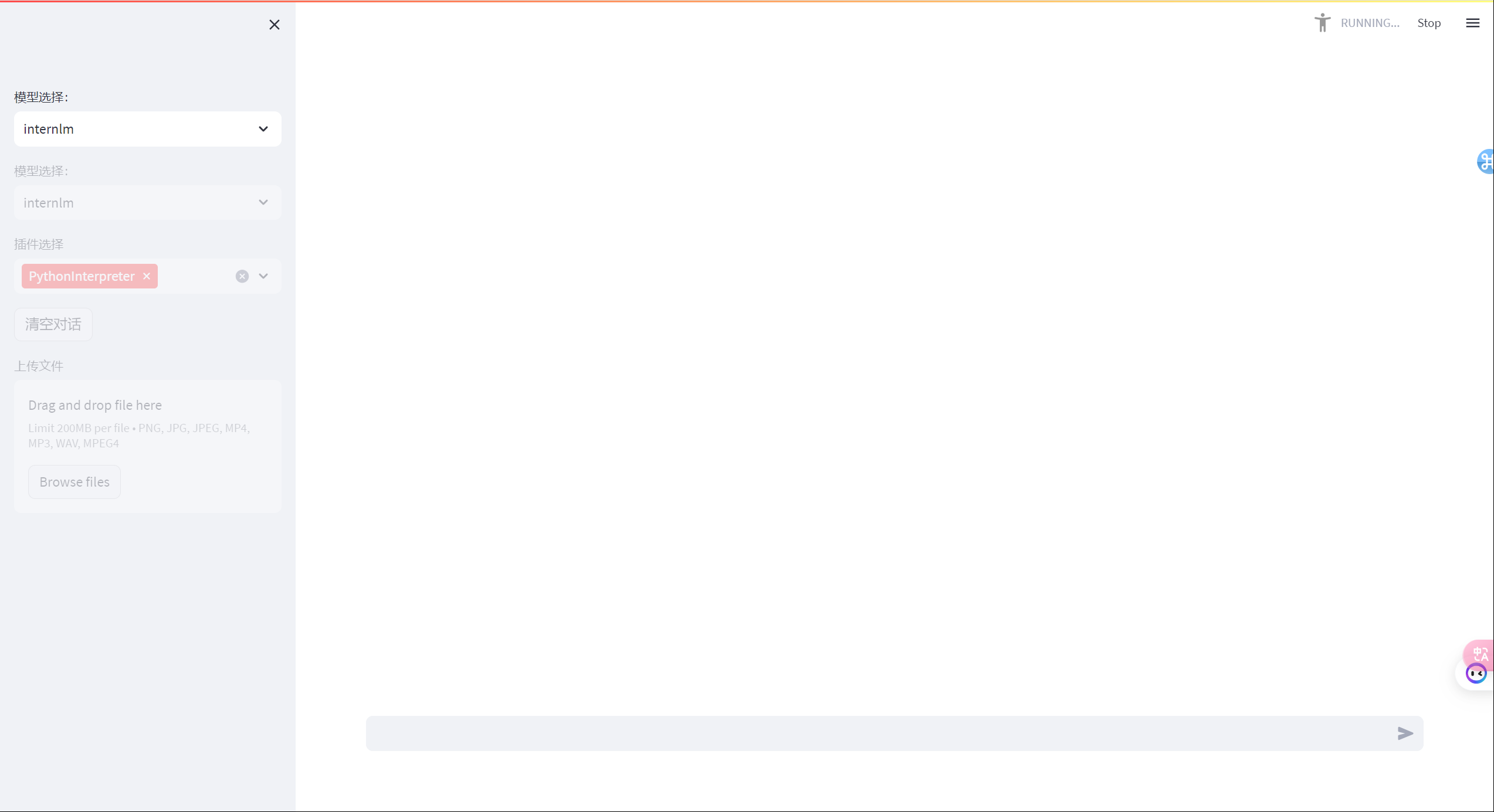

在web_demo网页上选择internlm作为运行模型

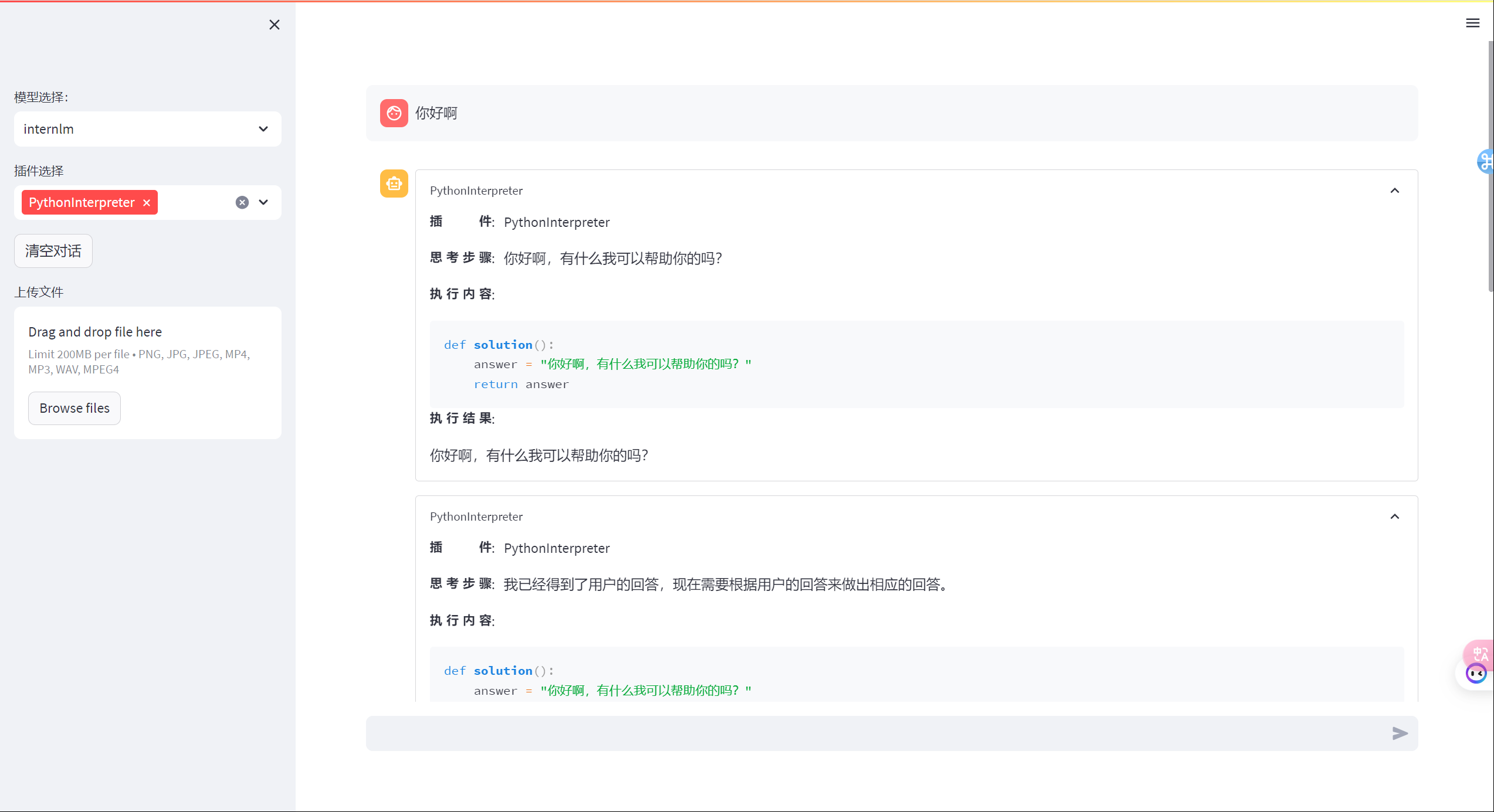

运行结果如下展示:

真的好慢啊!

internlm-chat的原有对话功能丧失了似乎:

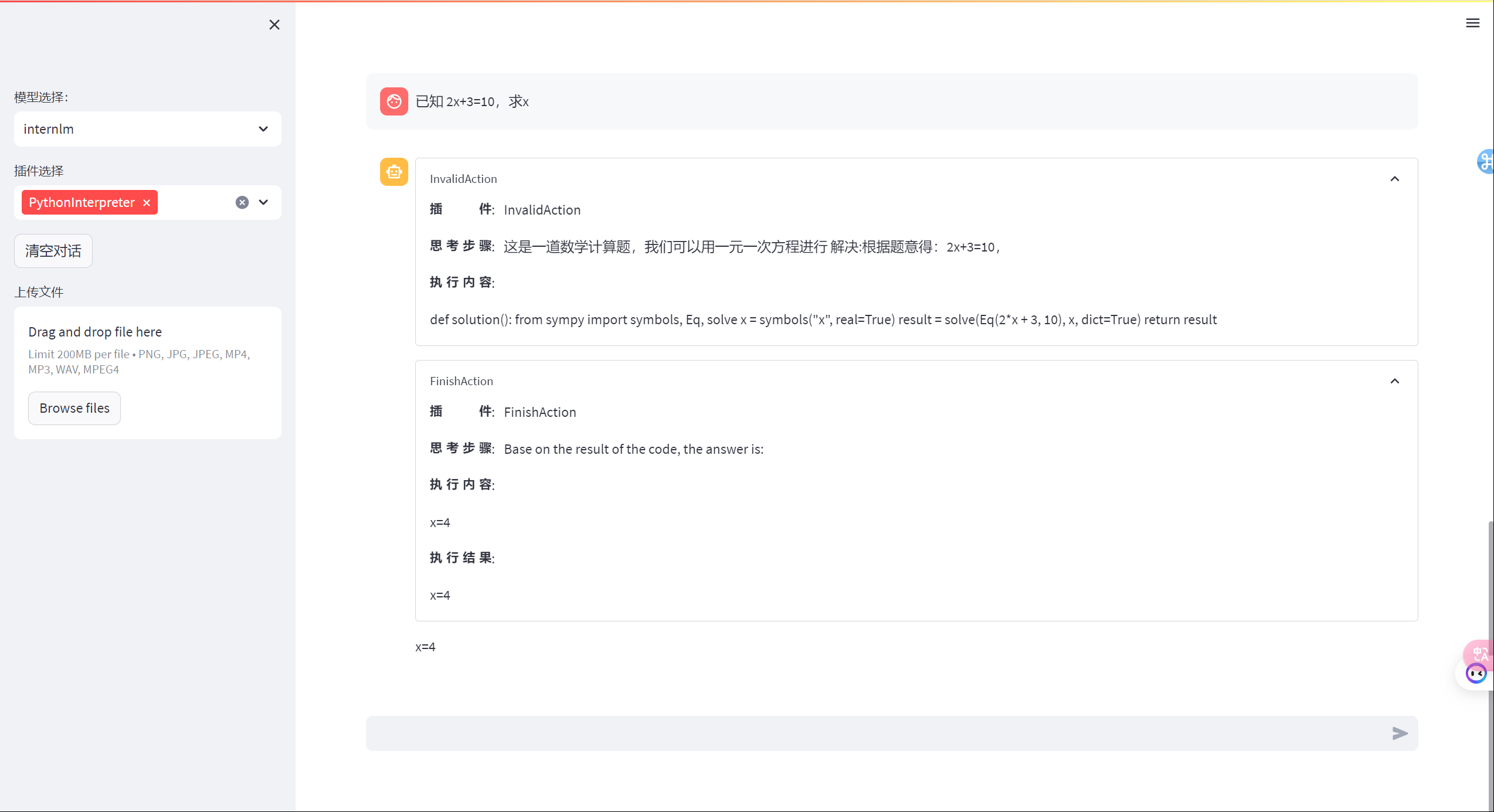

数学计算:

解释插入排序:web_demo先展示了插件返回结果,然后再进行了同样的回答

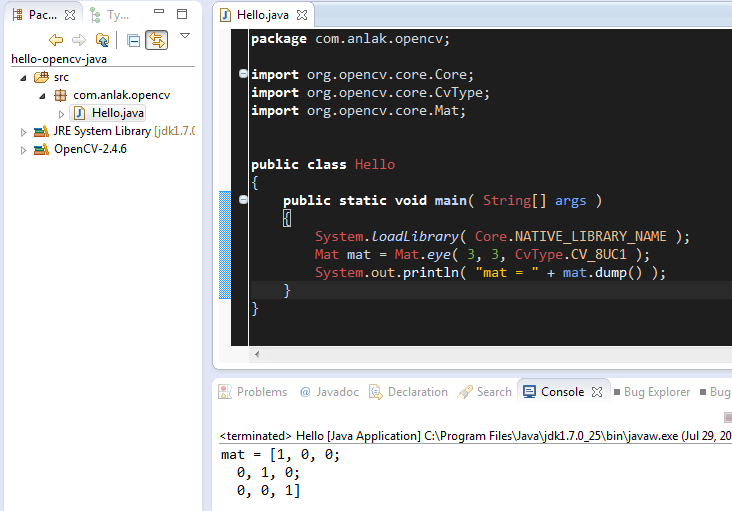

浦语·灵笔图文创作理解Demo

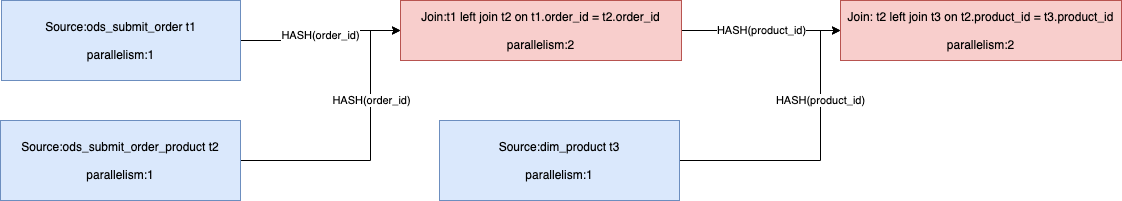

利用internlm-xcomposer-7b模型部署一个图文理解创作demo

- 环境准备

利用开发机自带的环境创建脚本创建一个新的conda环境xcomposer-demo

安装必要的python包

pip install transformers==4.33.1 timm==0.4.12 sentencepiece==0.1.99 gradio==3.44.4 markdown2==2.4.10 xlsxwriter==3.1.2 einops accelerate

- 模型下载

复制开发机上的internlm-xcomposer-7b模型 - 代码准备

git clone InternLM-XComposer仓库 - Demo运行

运行命令为

python examples/web_demo.py \--folder /root/model/Shanghai_AI_Laboratory/internlm-xcomposer-7b --num_gpus 1 \--port 6006

说明

我的浦语·灵笔web_demo加载总是有问题,最后也没解决,这里就不放图了

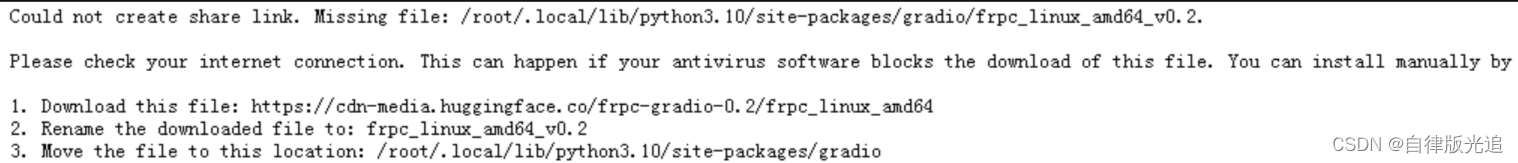

开始是有报这个错误:

然后我按照提示信息下载了对应文件并上传

终端出现Could not create share link. Please check your internet connection or our status page: https://status.gradio.app.错误提示

我在终端运行以下命令:

chmod +x /root/.local/lib/python3.10/site-packages/gradio/frpc_linux_amd64_v0.2

最终运行没有报错,但部署在开发机上的模型却始终没有运行起来有图生文的效果,并且web_demo的logo图片显示get失败,通过浏览器检查看到logo图片的地址,访问提示404

接下来的debug步骤应当是检查源码/重开一个开发机再试一次,因为我把这个demo和task3的langchain-rag弄到同一个A100(1/4)*2的开发机里了,根据我不多的llm相关知识,不确定会不会有环境污染问题,虽然其实是分别的conda环境,不懂!

参考资料

- 书生·浦语大模型全链路开源体系

![[HackMyVM] Quick](https://img-blog.csdnimg.cn/direct/6c324b3fe0d343f3bb8aad1d2f86219d.png)