【背景】

作为一个想构建局域网AI服务的屌丝,一直苦恼的自然是有限的资源下有没有对Spec要求低一点的SelfHosting的AI服务框架了。今天给大家介绍这款听起来有点希望,但是我也还没试验过,感兴趣的可以去尝试看看。

【介绍】

大模型生成式AI与别的技术不同,由于资源要求高,玩儿起来都要些成本,与普通人似乎就比较远了。如果有一款能够selfHosting,本地运行的开源AI框架,会是希望获得AI能力的普通人的福音。

有一款新的开源基础模型,名为Mixtral M8x7b。

看一些使用过这一模型在本地运行的博主声称效果优于GPT3.5。

内心燃起了希望有没有。

OpenAI等大厂在某种程度上还是牢牢把持着AI的技术优势。奥特曼声称在基础模型上很难被超越,大有独孤求败的意思。

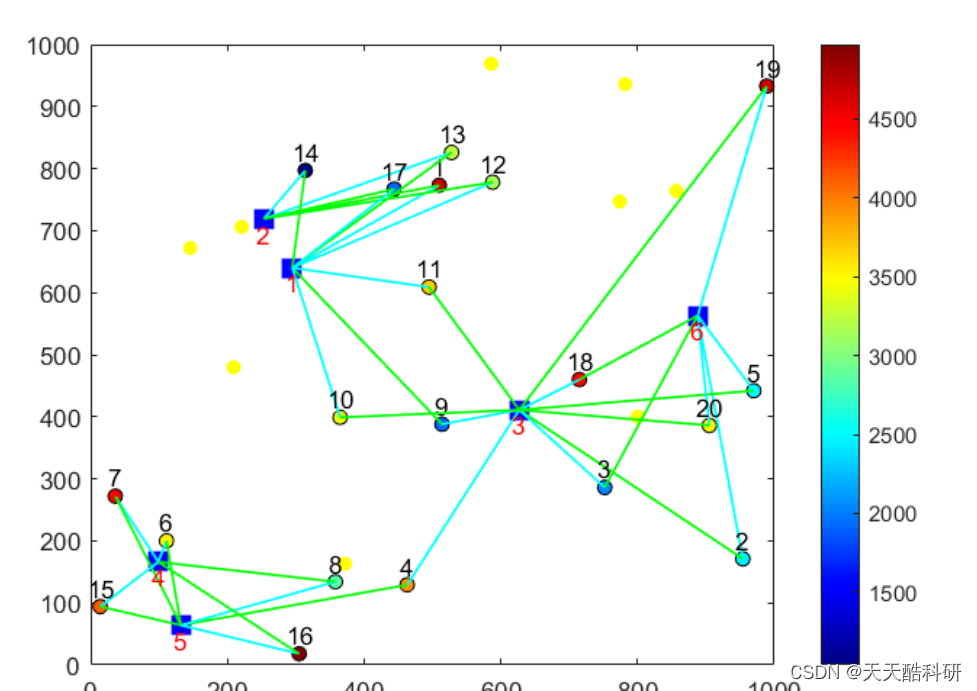

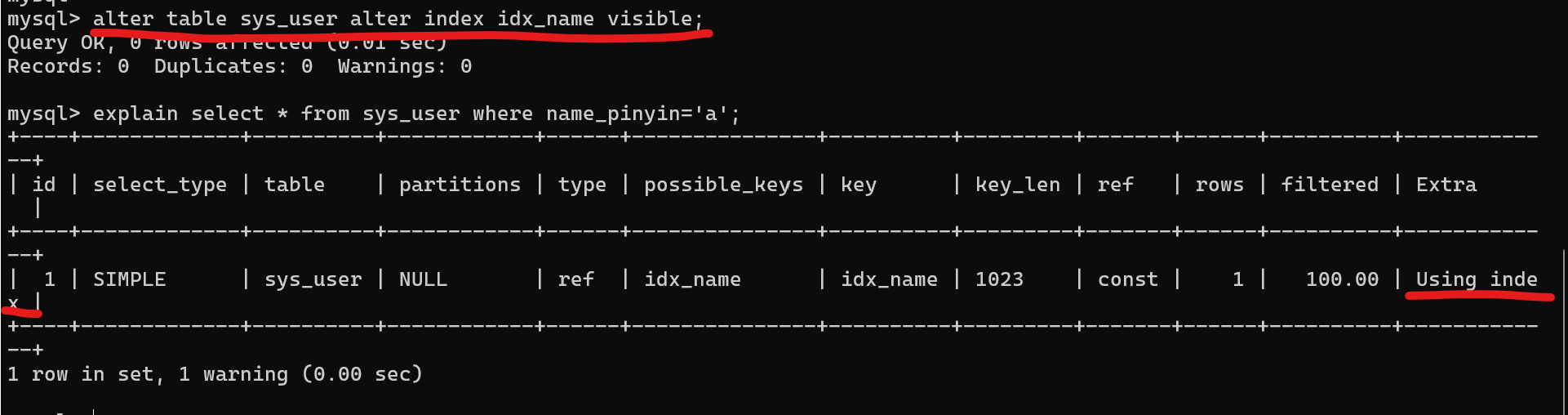

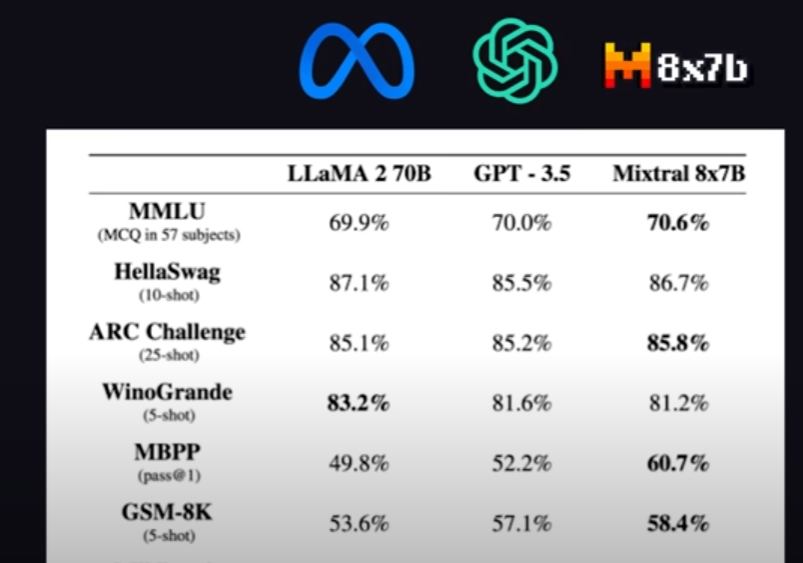

然后Mixtral M8x7b横空出世,而且License是真正意义上开源的Apache2.0。Meta,GPT3.5和Mixtral的跑分表如下。

【如何运行】

- 下载开源服务ollama,https://github.com/jmorganca/ollama

- Windows上直接WSL跑命令起服务。命令:ollama serve

- 指定模型(建议):ollama run dolphin-mixtral:latest

- 模型大小26GB,RAM建议64GB。