卷积神经网络-卷积层

- 1多层感知机(MLP)

- 2卷积神经网络(CNN)

- 3MLP和CNN关系与区别

- 4仍然有人使用MLP的原因:

- 5MLP的局限性:

- MLP的应用领域:

- 总结:

- 6全连接到卷积

- 全连接层 vs 卷积层

- 结构差异

- 应用场景

- 全连接层和卷积层的关系

- 示例:使用Python和TensorFlow创建卷积层和全连接层

- 总结

- 7 卷积层

- 2填充和步幅

- 1. 有效填充(Valid Padding)

- 2. 相同填充(Same Padding)

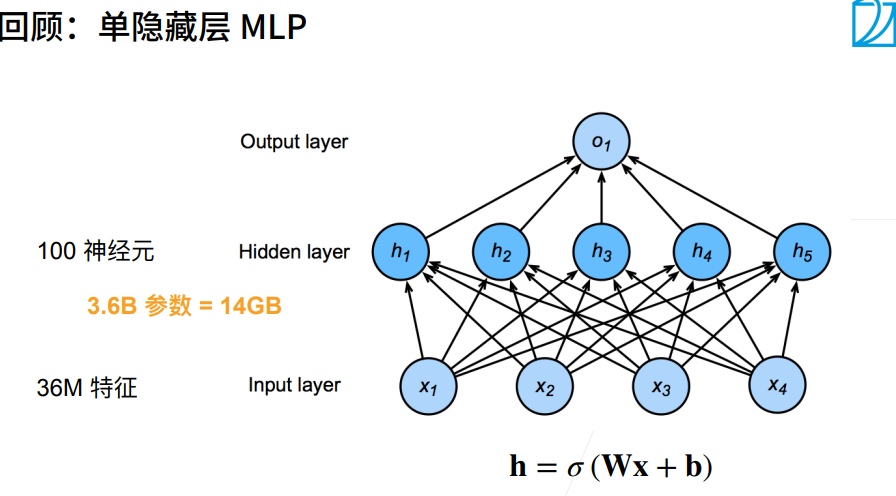

多层感知机(Multilayer Perceptron, MLP)和卷积神经网络(Convolutional Neural Network, CNN)都是深度学习中常用的神经网络结构,但它们在结构和应用上有所不同。以下是它们之间的关系和区别:

1多层感知机(MLP)

-

结构:MLP是一个全连接(或称为密集连接)的前馈神经网络,由一个或多个隐藏层组成。每一层的神经元都与上一层的所有神经元相连接。

-

特点:

- 适用于处理结构化数据,如表格数据。

- 激活函数常用的有ReLU、Sigmoid、Tanh等。

- 没有考虑数据的空间结构或局部模式。

-

应用:

- 分类问题

- 回归问题

- 强化学习等

2卷积神经网络(CNN)

-

结构:CNN主要由卷积层(Convolutional Layer)、池化层(Pooling Layer)、全连接层(Fully Connected Layer)等组成。

- 卷积层:用于检测输入数据中的局部模式或特征。

- 池化层:用于降低特征映射的空间尺寸,同时保留主要的信息。

- 全连接层:用于进行分类或回归任务。

-

特点:

- 适用于处理图像、视频等具有空间结构的数据。

- 利用局部连接和权值共享的方式减少参数数量。

- 通过卷积和池化操作,能够提取数据的局部特征。

-

应用:

- 图像分类

- 物体检测

- 图像分割

- 人脸识别等

3MLP和CNN关系与区别

-

应用领域:MLP主要用于处理结构化数据,而CNN主要用于处理具有空间结构的数据,特别是图像数据。

-

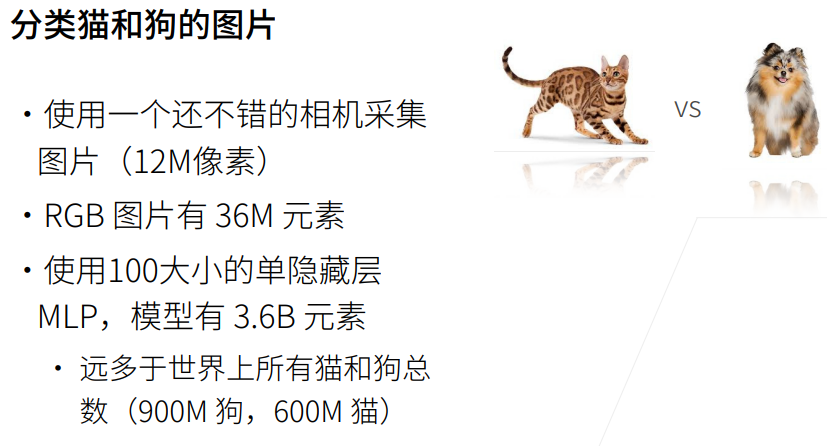

参数数量:由于CNN利用了权值共享和局部连接,其参数数量通常比MLP少,这使得CNN更适合处理大规模的图像数据。

-

特征提取能力:CNN具有良好的特征提取能力,能够自动学习数据中的局部特征。而MLP更依赖于手动设计的特征或特征工程。

-

结构:CNN通常包含卷积层和池化层,而MLP仅包含全连接层。

总的来说,MLP和CNN都是深度学习的基础模型,但它们适用于不同类型的数据和任务。在处理图像等具有空间结构的数据时,CNN通常比MLP表现得更好,而在处理结构化数据时,MLP可能更为合适。在实际应用中,两者也可以结合使用,例如使用CNN进行特征提取,然后使用MLP进行分类或回归。

多层感知机(Multilayer Perceptron, MLP)在深度学习的发展历程中确实起到了重要的作用,并且在一些任务上仍然有着广泛的应用。以下是关于MLP的一些观点和应用情况:

4仍然有人使用MLP的原因:

-

处理结构化数据:MLP主要适用于处理结构化数据,例如表格数据,它在一些分类和回归任务中仍然表现得很好。

-

简单且有效:与复杂的深度学习模型相比,MLP具有简单的结构和训练过程,对于某些简单任务而言,MLP可能更容易训练和实现。

-

特定任务和应用:在某些特定的应用场景和任务中,MLP可能是一个合适的选择,例如异常检测、金融预测等。

5MLP的局限性:

-

处理复杂数据:MLP在处理图像、语音和文本等复杂和高维数据上的表现不如卷积神经网络(CNN)和循环神经网络(RNN)。

-

需要手动特征工程:与CNN和RNN等能够自动学习特征的模型相比,MLP更依赖于手动设计的特征或特征工程。

-

过拟合问题:在处理高维数据时,由于MLP的参数数量相对较多,容易导致模型过拟合。

MLP的应用领域:

- 金融领域:如股价预测、信用评分等。

- 医疗领域:如疾病预测、医疗图像分析等。

- 工业领域:如故障检测、质量控制等。

- 推荐系统:如商品推荐、电影推荐等。

总结:

虽然深度学习领域已经涌现出许多新的模型和技术,但多层感知机(MLP)仍然在某些特定的应用和场景中保持其重要地位。选择使用MLP还是其他深度学习模型取决于具体的任务需求、数据类型和应用场景。在实际应用中,人们会根据问题的复杂性和数据的性质来选择最合适的模型。

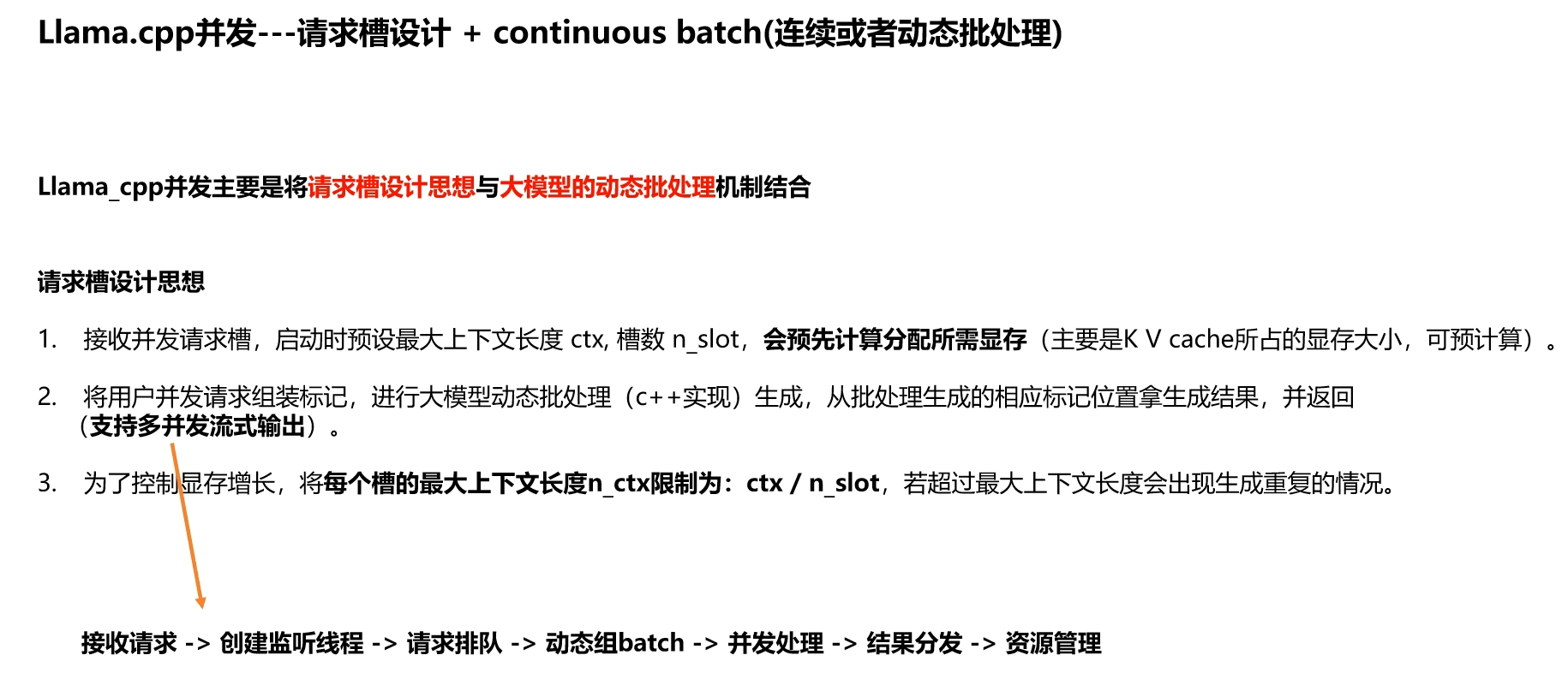

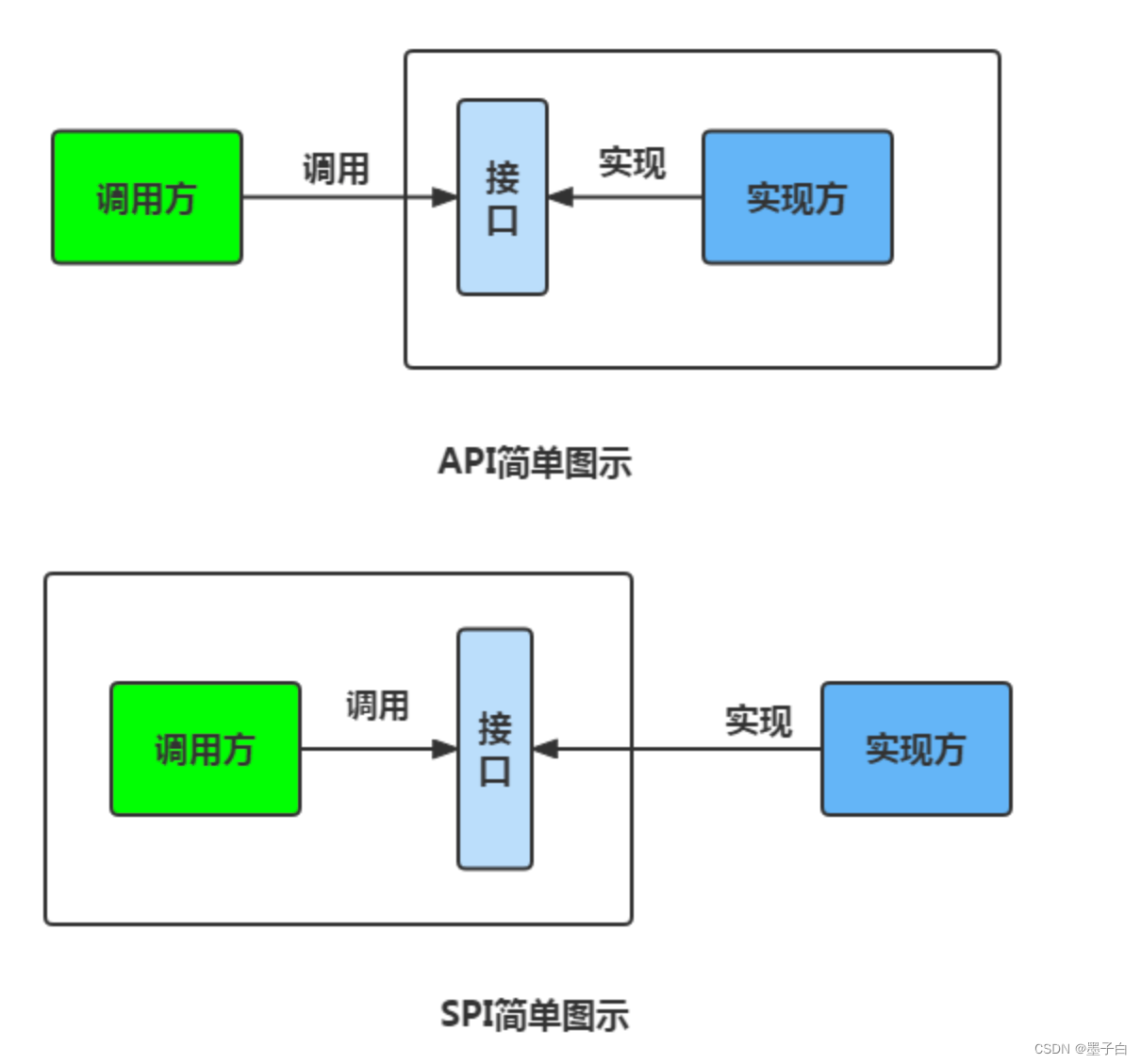

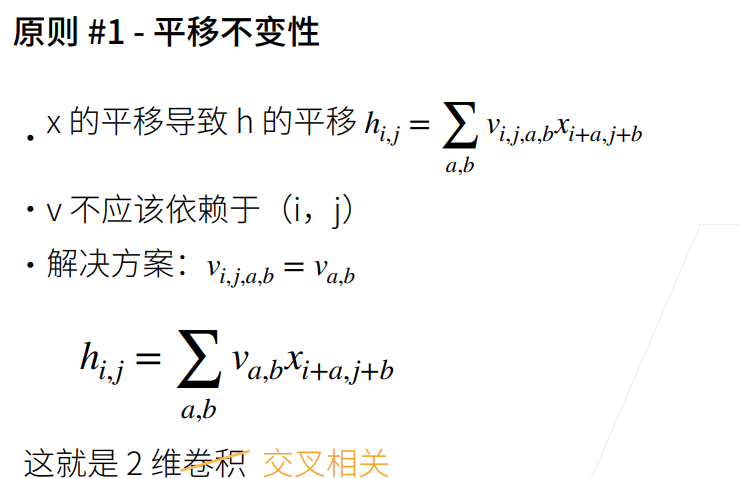

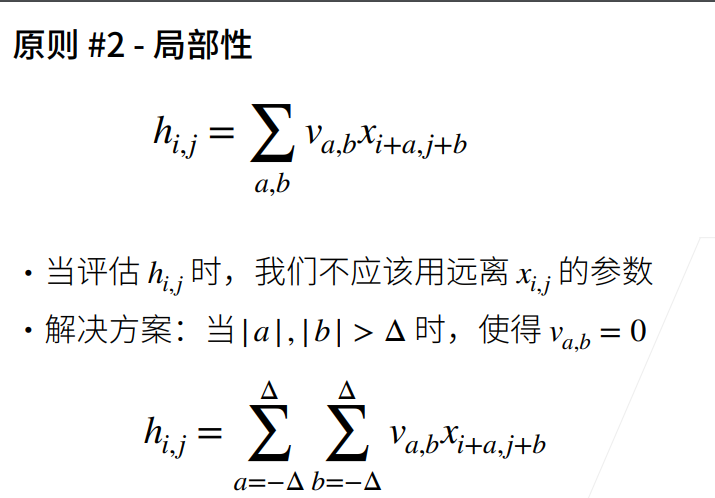

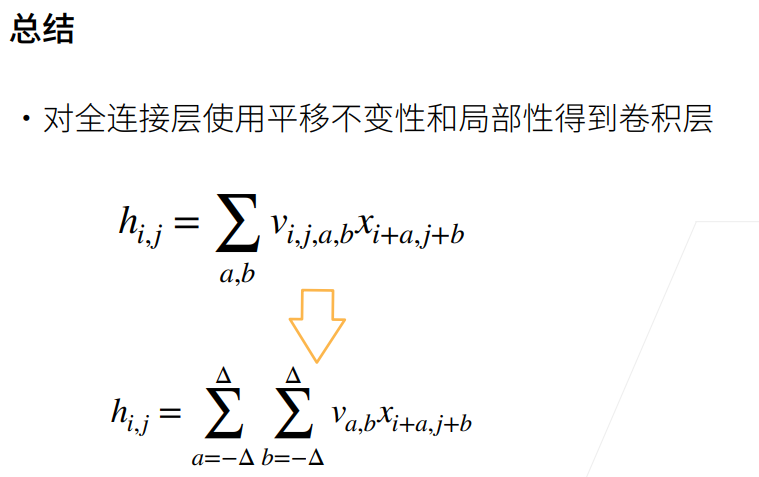

6全连接到卷积

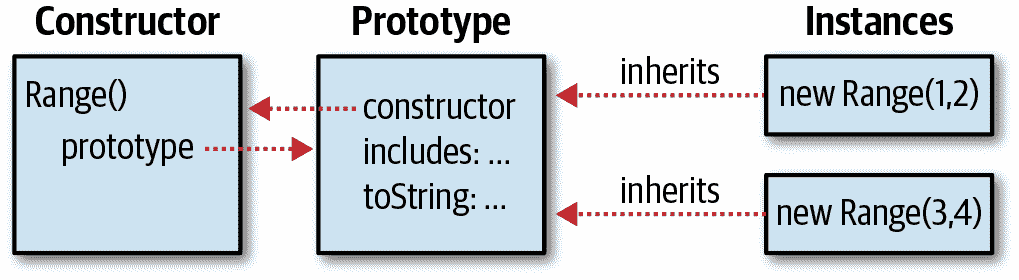

卷积层是特殊的全连接层

全连接层(Fully Connected, FC)和卷积层(Convolutional Layer, Conv)是深度学习中两种常用的神经网络层,它们在结构和应用场景上有一些明显的差异。下面我们来探讨全连接层和卷积层之间的关系和区别。

全连接层 vs 卷积层

结构差异

-

连接方式:

- 全连接层:每个节点都与下一层的每个节点连接,形成一个全连接的网络。

- 卷积层:使用卷积核在输入数据上进行滑动操作,从而提取局部特征。

-

参数数量:

- 全连接层:参数数量较多,与输入和输出的维度有关。

- 卷积层:参数数量较少,主要由卷积核的大小和数量决定。

应用场景

- 全连接层:常用于分类任务的最后几层,如全连接层+Softmax输出层。

- 卷积层:主要用于处理具有空间结构的数据,如图像数据,能够捕获局部特征。

全连接层和卷积层的关系

-

特征提取与表示:

- 全连接层:主要用于高级特征的组合和抽象。

- 卷积层:主要用于低级和中级特征的提取。

-

结合使用:

- 在深度学习模型中,通常会先使用卷积层提取特征,然后再使用全连接层进行分类或回归。这种结合使用的方式可以充分利用卷积层提取的特征,并通过全连接层进行最终的决策。

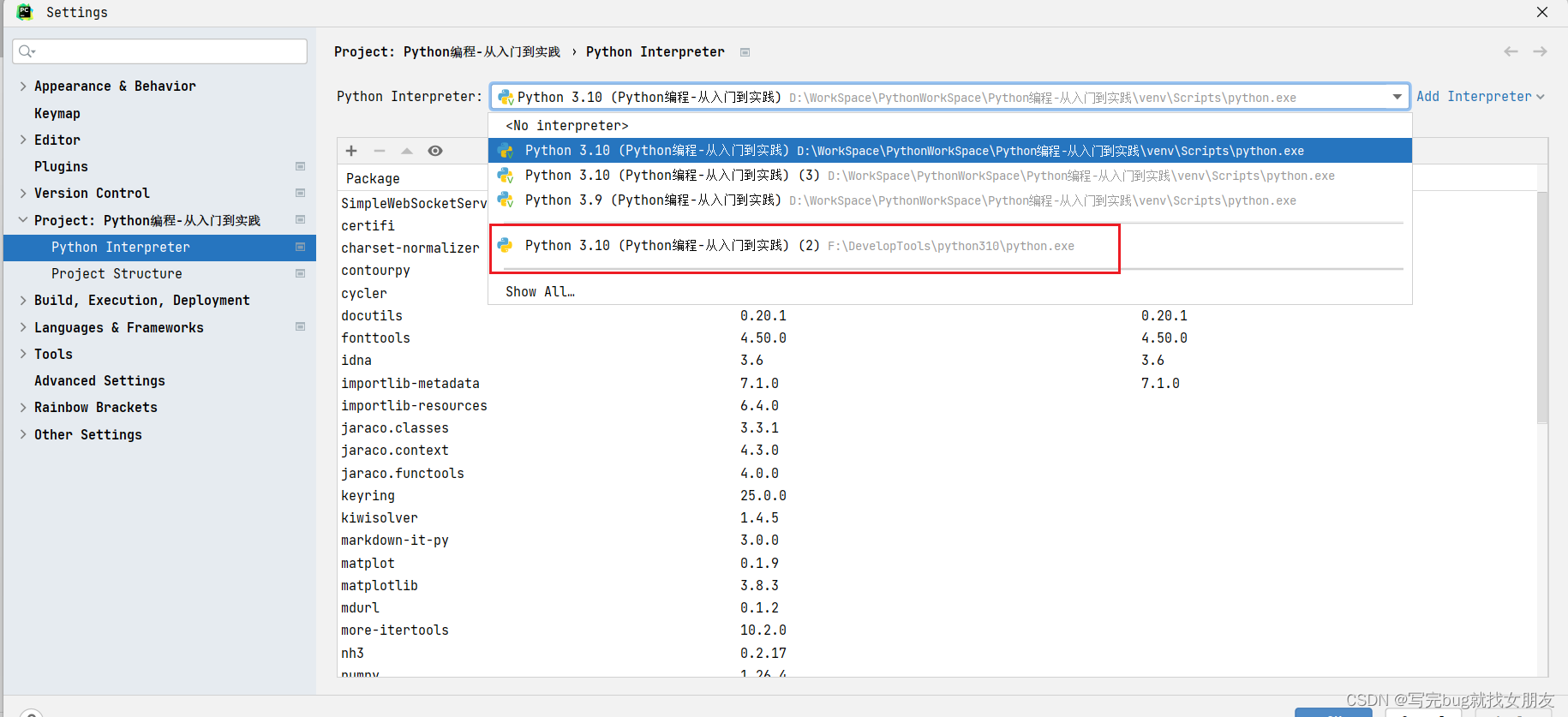

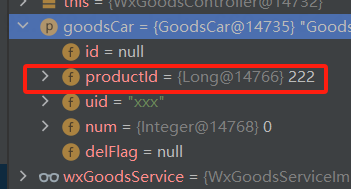

示例:使用Python和TensorFlow创建卷积层和全连接层

import tensorflow as tf# 创建卷积层

conv_layer = tf.keras.layers.Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1))# 创建全连接层

fc_layer = tf.keras.layers.Dense(128, activation='relu')# 定义输入数据(模拟28x28的灰度图像)

input_data = tf.random.normal([1, 28, 28, 1])# 卷积层前向传播

conv_output = conv_layer(input_data)# 全连接层前向传播

# 需要将卷积层的输出展平

flatten_output = tf.keras.layers.Flatten()(conv_output)

fc_output = fc_layer(flatten_output)# 打印输出形状

print("Conv output shape:", conv_output.shape)

print("FC output shape:", fc_output.shape)

在这个示例中,我们首先创建了一个卷积层和一个全连接层。然后,我们使用一个随机生成的28x28的灰度图像作为输入数据,通过卷积层和全连接层进行前向传播,并打印两层的输出形状。

总结

- 全连接层和卷积层在深度学习中各有其独特的应用和特性。

- 它们可以结合使用,通过卷积层提取特征,然后通过全连接层进行分类或回归,构建有效的深度学习模型。

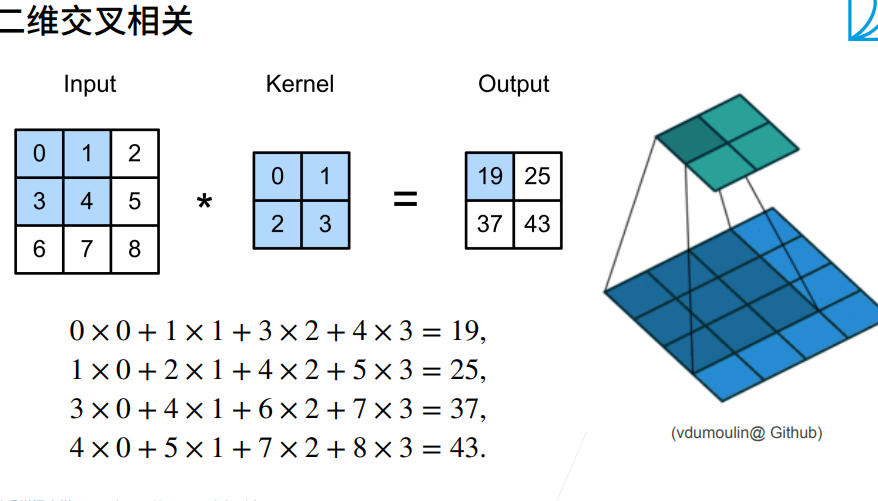

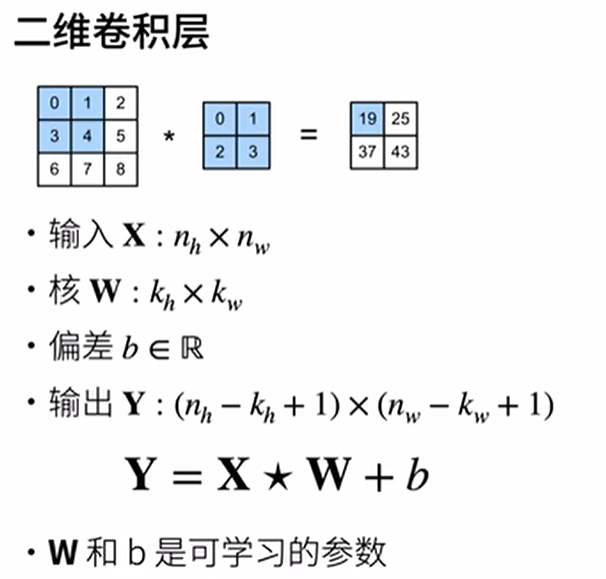

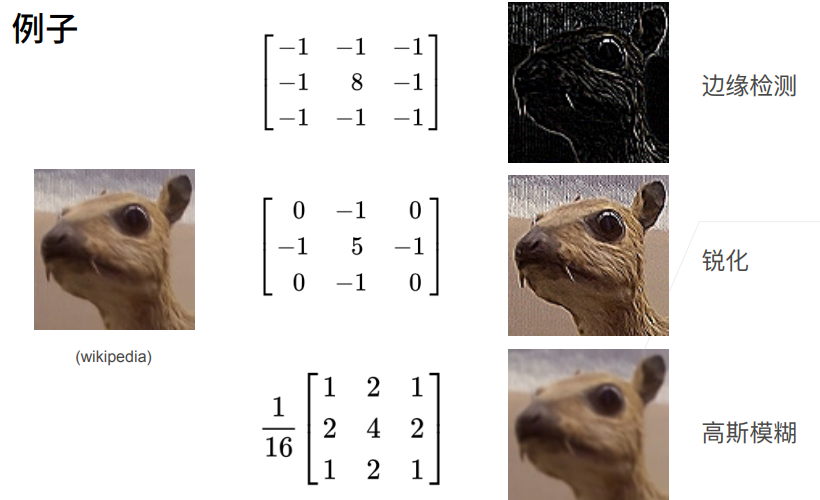

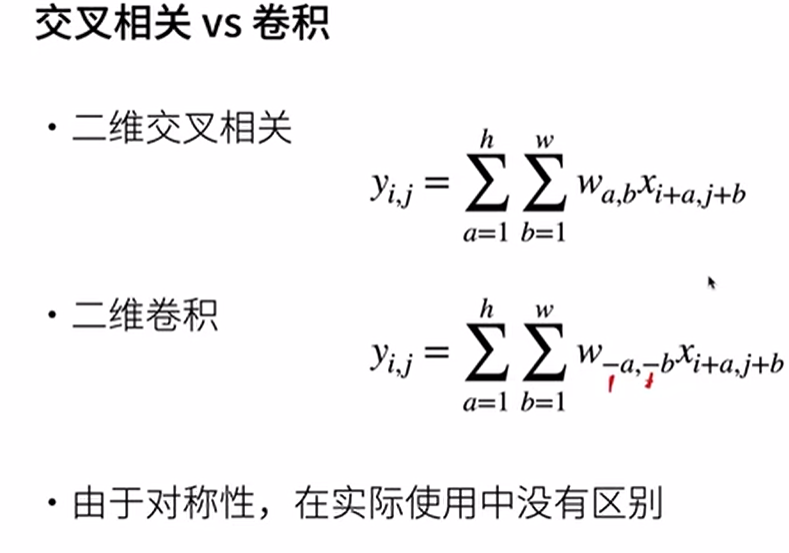

7 卷积层

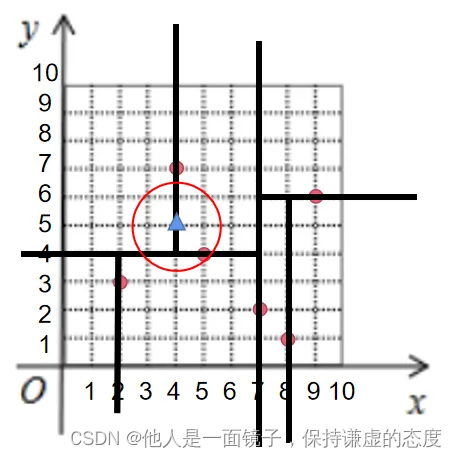

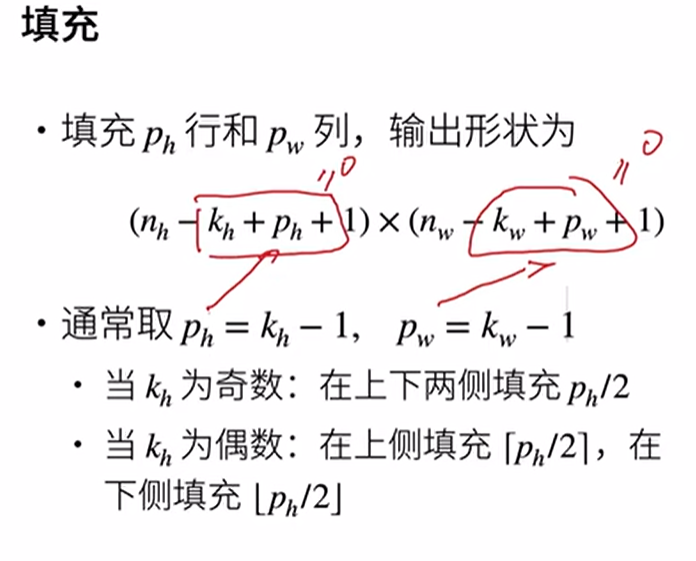

2填充和步幅

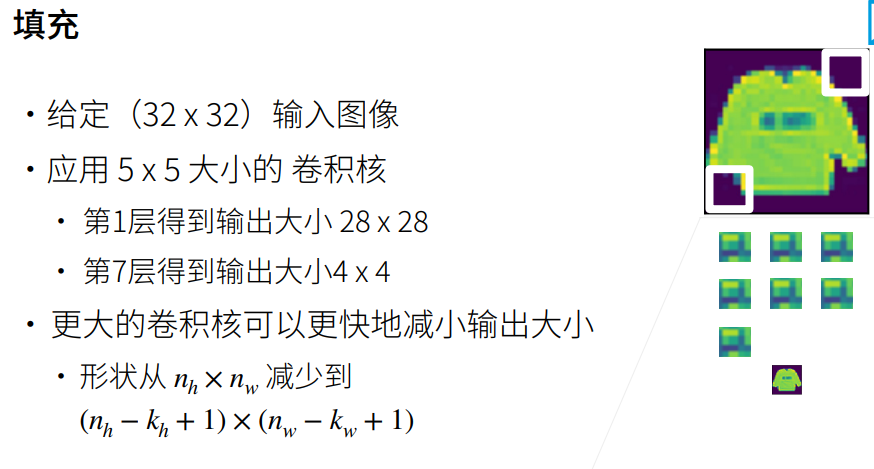

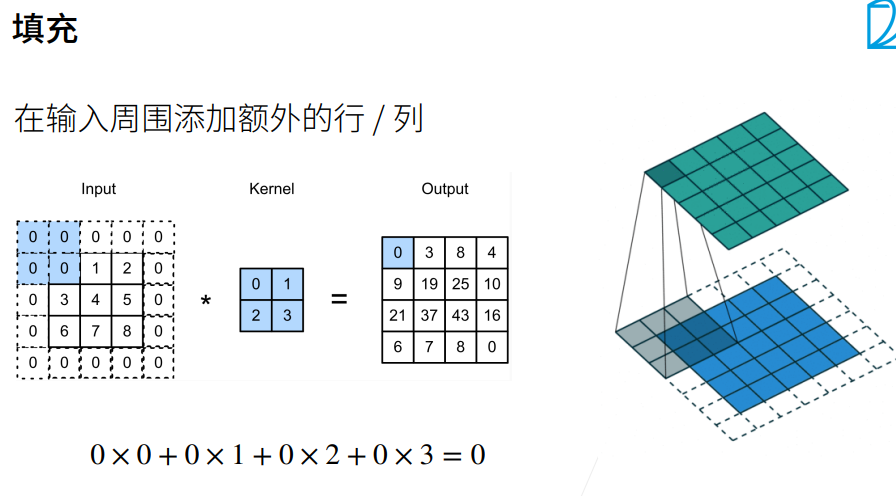

在卷积神经网络(Convolutional Neural Networks, CNNs)中,填充(Padding)是一个常用的技术,用于调整卷积操作后输出特征图(feature map)的尺寸。填充主要有两种类型:有效填充(Valid Padding)和相同填充(Same Padding)。

1. 有效填充(Valid Padding)

在有效填充中,不进行任何填充。这意味着卷积核只在输入数据上进行滑动,不在输入数据的边缘添加任何额外的值。

2. 相同填充(Same Padding)

在相同填充中,我们在输入数据的周围均匀地添加填充,以使输出特征图的尺寸与输入特征图的尺寸相同。

通过使用填充,我们可以控制卷积层的输出尺寸,这对于设计卷积神经网络架构非常有用,特别是在需要保留输入尺寸的信息时。

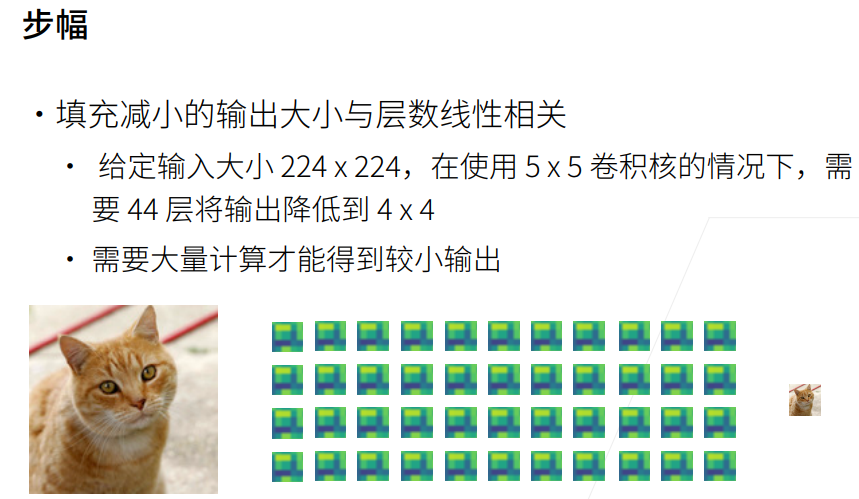

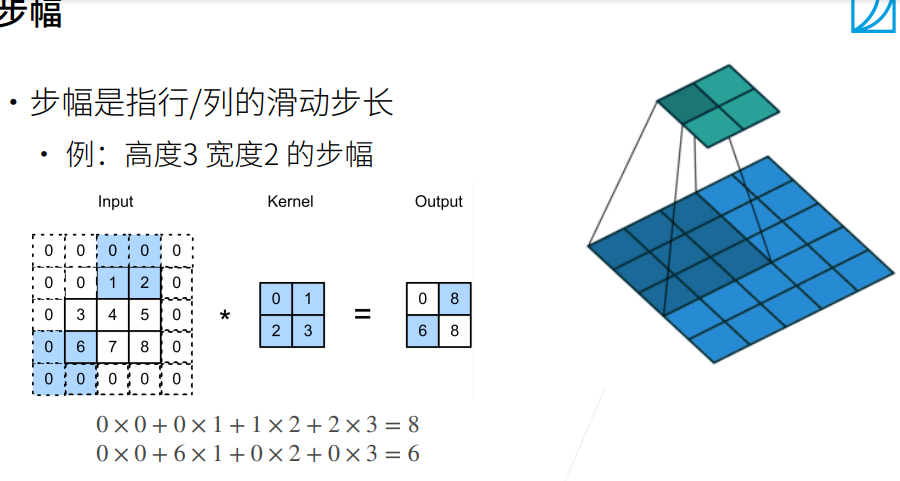

在卷积神经网络(Convolutional Neural Networks, CNNs)中,步幅(Stride)是另一个重要的超参数,它定义了卷积核在输入数据上滑动的距离。

步幅定义了卷积核每次在输入数据上移动的像素数量。步幅为1意味着卷积核每次移动一个像素;步幅为2意味着卷积核每次移动两个像素,以此类推。

通过调整步幅,我们可以进一步控制卷积层的输出尺寸。步幅大于1的卷积通常可以减少特征图的尺寸,这在需要减少模型参数和计算量时非常有用。

注意

步幅与填充的关系:步幅和填充可以共同影响输出尺寸。在实际应用中,通常首先选择填充方式(有效填充或相同填充),然后根据需要的输出尺寸来调整步幅。

步幅的选择:步幅的选择需要根据具体任务和模型设计来确定。较大的步幅通常可以减少计算量,但可能会丢失一些空间信息;较小的步幅可以保留更多的空间信息,但会增加计算量。

通过填充和步幅的调整,我们可以更加灵活地设计卷积神经网络,以适应不同的任务和数据特性。