文章目录

- 一、前言

- (一)对抗攻击概念

- (二)对抗攻击分类

- (三)VLP模型:视觉语言预训练模型

- 二、文章概览

- (一)研究动机

- (二)主要工作

- 三、对抗可迁移性的分析

- (一)有关 VLP 模型的对抗性可转移性的观察结果

- (二)现有方法的局限性

- (三)直观理解

- 四、方法

- (一)动机

- (二)符号

- (三)可转移的集合级引导攻击

- 1、集合级数据增强

- 2、跨模态引导攻击

- 3、核心思想及算法流程

- 五、实验

- (一)实验设置

- (二)攻击和通用迁移方法直接结合

- (三)攻击的模型迁移性比较

- (四)攻击的任务迁移性比较

- 1、图像标注任务

- 2、视觉定位任务

- (五)消融研究

- (六)对抗样本可视化

一、前言

标题:集合级指导攻击:提高视觉语言预训练模型的对抗性可迁移性

(一)对抗攻击概念

通过对输入添加微小的扰动使得分类器分类错误,一般用于对深度学习的网络的攻击算法 最为常见,应用场景包括目前大热的CV和NLP方向,例如、通过对图片添加精心准备的扰动噪声使得分类错误,或者通过对一个句子的某些词进行同义词替换使得情感分类错误。

(二)对抗攻击分类

攻击的类型有很多种,从攻击环境来说,可以分为黑盒攻击、白盒攻击或者灰盒攻击:

- 白盒攻击:攻击者对模型一切都可以掌握

- 黑盒攻击:攻击者对攻击的模型的内部结构,训练参数,防御方法(如果加入了防御手段的话)等等一无所知

(三)VLP模型:视觉语言预训练模型

多模态领域中对于图像分支的处理大多数都是在具有区域特征的预训练目标检测器上开发的,以学习视觉语言表示。最近,随着视觉变换器(ViT)的日益流行,其他一些工作提出使用 ViT 作为图像编码器,并以端到端的方式将输入转换为补丁。

VLP模型根据VLP架构可以分为融合VLP模型和对齐VLP模型。

- 融合VLP模型先利用单独的单模态编码器来处理令牌嵌入和视觉特征,然后使用多模态编码器来处理图像和文本嵌入以输出融合的多模态嵌入。

- 对齐的 VLP 模型(如 CLIP)仅具有独立图像和文本模态嵌入的单模态编码器。

二、文章概览

(一)研究动机

- 视觉语言预训练(VLP)模型在多模态任务中表现出了对抗性示例的脆弱性。

- 现有的工作主要集中在白盒攻击,然而白盒攻击在实际应用中由于模型信息的不可访问性是不现实的。

- 与白盒设置中的强大攻击性能相比,现有方法的可转移性要低得多。目前还没有相关工作系统地分析VLP模型上多模态攻击方法的对抗可迁移性。

- 可转移性下降的部分原因是跨模式交互的利用不足。特别是,与单模态学习不同,VLP 模型严重依赖于跨模态交互,并且多模态对齐是多对多的,例如,图像可以用各种自然语言来描述。

(二)主要工作

集合级引导攻击(SGA):利用多个图像文本对之间的多种跨模式交互

- 首次尝试通过系统评估来探索对抗性示例在流行的VLP模型上的可迁移性;

- 提出了SGA,一种新颖的可转移多模态攻击,通过有效使用集合级对齐保持增强和精心设计的跨模态指导来增强对抗性可转移性;

- 大量实验表明,与最先进的方法相比,SGA 始终能够提高不同 VLP 模型之间的对抗性可转移性。

三、对抗可迁移性的分析

现有的攻击多模式任务的常见方法:

- 将每种模式的单模式对抗性攻击组合在一起

- 联合攻击通过共同扰乱图像模态和文本模态来考虑跨模态交互

(一)有关 VLP 模型的对抗性可转移性的观察结果

攻击两种模态(图像和文本)的对抗性可转移性始终比单独攻击任何单模态数据(图像或文本)更有效:

- ALBEF 和 TCL 都是融合的 VLP 模型

- TCL 和 CLIPViT是不同类型的 VLP 模型,但具有相同的基本架构

- CLIPViT和CLIPCNN是相同类型的VLP模型,但具有不同的基本架构

对抗性多模态数据(即对抗性图像和文本)对源模型具有很强的攻击性能,但在转移到目标模型时很难保持相同的能力。

综上所述,如果所有模态同时受到攻击,攻击方法在黑盒设置下可以具有更强的可移植性。然而,即使允许扰动两种模态,现有方法仍然表现出低得多的可转移性。这表明应该专门设计具有更高可转移性的攻击,而不是直接利用现有的白盒攻击方法。

(二)现有方法的局限性

对抗性例子的可转移性下降主要是由于现有攻击方法存在以下局限性:

- Sep-Attack:无法对模态间对应关系进行建模,而模态间对应关系对于多模态学习中的成功攻击至关重要。

- Co-Attack:利用模式之间的协作来生成对抗性示例,但是阻碍了其向其他 VLP 模型的迁移。多模态学习涉及具有多对多跨模态对齐的多种互补模态,而协同攻击仅使用单个图像-文本对来生成对抗性数据,限制了其他模式中多个标签的指导多样性。跨模式指导缺乏多样性使得对抗性样本与白盒模型的对齐模式高度相关。因此,对抗性例子的通用性受到限制,并且其转移到其他模型的有效性下降。

(三)直观理解

现有的攻击方法:

- (a)单独扰乱单模态数据,无需任何跨模态交互;

- (b)扰乱多种模态,但使用单个图像-文本对来建模跨模态交互;

- (c)集级指导(SGA)来学习多种对齐之间的跨模式交互

v 表示输入图像,t 是配对的标题。 v’和t’分别代表相应的对抗样本。 U(v)和U(t)表示尺度不变图像集和最匹配的标题集。箭头表示生成对抗性示例的指导。

四、方法

(一)动机

现有方法的黑盒设置中,大约一半的失败案例是由于图像的多个匹配标题的存在而出现的,因此需要考虑多个配对标注并且将对抗性图像推离所有配对标注,从而在转移到其他黑盒模型时保留攻击能力。

事件A:白盒设置的成功案例;事件B:受其他配对标注影响的黑盒设置的失败案例

(二)符号

- ( v , t ) (v, t) (v,t):从多模态数据集 D D D采样的图像-文本对

- f I f_I fI:图像编码器

- f T f_T fT:文本编码器

- f M f_M fM:融合VLP模型中的多模态融合模块

- f I ( v ) f_I(v) fI(v):以图像 v v v 作为输入编码的图像表示 e v e_v ev

- f T ( t ) f_T(t) fT(t):以文本 t t t 作为输入编码的文本表示 e t e_t et

- f M ( e v , e t ) f_{M}(e_v, e_t) fM(ev,et): f M f_M fM以图像和文本表示作为输入编码的多模态表示。

- B [ v , ε v ] B[v, ε_v] B[v,εv]:优化对抗性图像的合法搜索空间, ε v ε_v εv表示图像的最大扰动界限

- B [ t , ε t ] B[t, ε_t] B[t,εt]:优化对抗性文本的合法搜索空间, ε t ε_t εt表示标题中可更改单词的最大数量。

(三)可转移的集合级引导攻击

文章提出了集合级指导攻击(Set-level Guidance Attack, SGA)的方法,该方法包含两个部分:集合级数据增强和跨模态引导攻击。

1、集合级数据增强

为了在生成可概括的对抗性示例时注入更多多样性,文章使用集合级对齐保留增强来扩展多模态输入空间,同时保持跨模态对齐完好无损。

之前的方法:仅考虑单个图像-文本配对示例 ( v , t ) (v,t) (v,t)来生成对抗性数据

作者的方法:将输入扩大到一组图像和标题级别

- 从每个图像 v v v 的数据集中选择最匹配的标题对,形成增强的标题集 t = { t 1 , t 2 , . . . , t M } t = \{t_1, t_2, ..., t_M \} t={t1,t2,...,tM};

- 将每个图像 v v v 的大小调整为不同的尺度 S = { s 1 , s 2 , . . . , s N } S = \{s_1, s_2 , ..., s_N \} S={s1,s2,...,sN}

- 添加高斯噪声,根据尺度不变性得到多尺度图像集 v = { v 1 , v 2 , . . . , v N } v = \{v_1, v_2, ..., v_N\} v={v1,v2,...,vN}

- 使用扩大的输入集 ( v , t ) (v,t) (v,t)来生成对抗性数据 ( v ′ , t ′ ) (v',t') (v′,t′)。

2、跨模态引导攻击

为进一步提升对抗样本的迁移性,文章提出跨模态引导攻击的策略,以充分利用集合级数据中的模态交互。

- 使用来自另一种模态的配对信息作为监督来引导对抗样本的优化方向

- 在迭代优化对抗图像和对抗文本的过程,该策略逐步拉远图像和文本在特征空间中的距离,从而破坏跨模态交互,达到攻击效果。

第一步:为文本集合 t t t中的每一个文本描述生成对应的对抗文本,得到对抗文本集 t ′ = { t 1 ′ , t 2 ′ , . . . , t M ′ } t'=\{t'_1,t'_2,...,t'_M\} t′={t1′,t2′,...,tM′}。该过程约束每一个对抗文本在特征空间中远离图像 v v v。

( B [ t i , ϵ t ] B[t_i,\epsilon_t] B[ti,ϵt]指的是 t i t_i ti的 ϵ t \epsilon_t ϵt邻域,为对抗样本 t i ′ t'_i ti′的搜索空间)

第二步:基于对抗文本集生成对抗图像 v ′ v' v′,该过程约束图像集 v v v中的所有图像在特征空间中远离文本集 t ′ t' t′中的所有对抗文本。

( B [ v , ϵ v ] B[v,\epsilon_v] B[v,ϵv]指的是 v v v的 ϵ v \epsilon_v ϵv邻域,为对抗样本 v ′ v' v′的搜索空间)

第三步:基于对抗图像 v ′ v' v′生成对抗文本,该过程约束 t ′ t' t′在特征空间中远离对抗图像 v ′ v' v′。

3、核心思想及算法流程

文章引入了对齐保留增强,它丰富了图像-文本对,同时保持其对齐完整。

- 图像增强是基于深度学习模型的尺度不变特性,因此可以构造多尺度图像来增加多样性。

- 文本增强是从数据集中选择最匹配的标题对。

- 更重要的是,SGA 通过精心设计的跨模态指导生成多模态增强输入数据的对抗性示例。具体来说,SGA 迭代地在两种模态之间推送补充信息,并用另一种模态作为监督来破坏交互,从而获得更好的和谐扰动。所得的对抗性样本可以感知源自多个指导的梯度。

对应的算法流程:

五、实验

(一)实验设置

数据集:两个使用广泛的多模态数据集

- Flickr30K :31,783 张图像,每张图像都有五个相应的标题

- MSCOCO:123,287 张图像,每张图像都带有大约 5 个标题注释

- 采用Karpathy split进行实验评估。

模型:评估了两种流行的 VLP 模型

- 融合 VLP 模型

- ALBEF:包含一个 12 层视觉transformer ViT-B/16 和两个 6 层transformer,分别用于图像编码器、文本编码器和多模态编码器

- TCL:与 ALBEF 相同的模型架构,但预训练目标不同

- 对齐 VLP 模型

- CLIP: CLIP 有两种不同的图像编码器选择,即 CLIPViT 和 CLIPCNN,分别使用 ViTB/16 和 ResNet-101作为图像编码器的基础架构。

对抗性攻击设置:

- 攻击图像模态:采用 PGD ,扰动界限 εv = 2/255,步长 α = 0.5/255,迭代步骤 T = 10。

- 攻击文本模态,采用扰动的 BERT-Attack边界εt = 1,单词列表的长度W = 10。

- 此外,通过使用双三次插值将原始图像大小调整为五个尺度{0.50,0.75,1.00,1.25,1.50}来扩大图像集。类似地,通过增加数据集中每个图像的最匹配的标题对来扩大标题集,大小约为 5。

指标:

采用攻击成功率(ASR)作为评估白盒和黑盒设置中的对抗鲁棒性和可转移性的指标。具体来说,ASR 评估仅产生成功的对抗性示例的攻击的百分比。 ASR 越高表明对抗性可转移性越好。

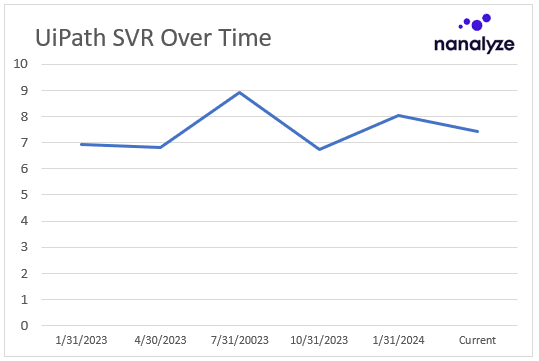

(二)攻击和通用迁移方法直接结合

为了评估现有的方法基于VLP模型所生成的对抗样本的迁移性,文章以Sep-Attack,Co-Attack两种方法为基准,结合已有的、针对对抗迁移性的单模态攻击方法(MI-FGSM、DIM-FGSM、PNA PO)。实验结果:

- 现有的对抗攻击方法虽然在白盒场景下能取得很好的攻击效果,但是其生成的对抗样本很难迁移到其他的黑盒模型。尽管结合不同的单模态迁移攻击方法,所生成的对抗样本的迁移性的提升依然有限。

- 不考虑跨模态交互和多模态学习中独特的多对多对齐是有问题的。Sep-Attack和MI,DIM直接结合,白盒攻击性能,迁移攻击性能都有所下降。Co-Attack和Mi,DIM直接结合,白盒攻击有所下降,迁移攻击有所上升,但上升得不多。

- SGA 在白盒和黑盒设置中都显示出卓越的性能。

将基于传输的图像攻击集成到图文检索中的 R@1 攻击成功率 (%)。对抗性数据是在 Flickr30K 上使用源模型 ALBEF 生成的,以攻击其他目标模型。 *表示白盒攻击。 ASR 越高表明对抗性可转移性越好。

(三)攻击的模型迁移性比较

相较于现有的对抗攻击方法,SGA 能够大幅度提升对抗样本在 VLP 模型之间的迁移性,特别是同类型的 VLP 模型之间的迁移性,例如从 ALBEF 到 TCL。

(四)攻击的任务迁移性比较

无论什么任务,跨模态交互和对齐都是多模态学习的核心组成部分。因此,我们进行了大量的实验来探索我们提出的 SGA 在另外两个 V+L 任务上的有效性:图像标注 (IC) 和视觉定位(VG)。

1、图像标注任务

图像标注是一种基于生成的任务,其中输入图像被编码为特征向量,然后解码为自然语言句子。

实验设置:

- 考察在ITR任务中生成的对抗性数据对IC任务的影响

- 从图像文本检索 (ITR) 生成的对抗数据,用于攻击 MSCOCO 上的图像标注任务 (IC)

- 源模型和目标模型分别是ALBEF和BLIP

实验结果表明,与联合攻击相比,所提出的 SGA 的对抗性可转移性有了明显的改进。具体来说, SGA 将 BLEU 分数提高了 2.6%,将 CIDEr 分数提高了 9.5%。

表中展示了受到攻击后 BLIP 的图像描述性能,包括BLEU、METEOR、ROUGE、CIDEr和SPICE等评估指标。基线代表 IC 在干净数据上的原始性能。较低的值表示更好的对抗性可转移性。

2、视觉定位任务

视觉定位是多模态学习中的另一个任务,目标是从一个图像数据库中检索与给定文本查询语义相关的图像。在这项任务中,模型需要理解文本查询的内容,并在图像数据库中找到与之相匹配的图像。

实验设置:使用图像文本中的源模型(ALBEF)生成对抗性图像,以在视觉基础上攻击目标模型(ALBEF)

实验结果:SGA 仍然优于 Co-Attack

(五)消融研究

文章对 SGA 中图像集和文本集的大小进行了消融实验:

- 如图3(左)所示,逐步增加集合中图像尺度的多样性时,能够提升最终生成的对抗样本的迁移性。

- 如图3(右)所示,相较于单张图像表述,使用集合级的图像文本描述来生成对抗样本能显著提升迁移性。

在信息检索和推荐系统领域,R@1、R@5和R@10是常用的评估指标,用于衡量检索或推荐任务的性能。这些指标表示在给定的检索结果列表中,正确或相关结果出现在前N个位置的比例。具体来说:

- R@1 (Recall@1):这表示在所有查询中,至少有一个查询的前1个检索结果包含了正确的答案或最相关的项。R@1的值越高,表示系统在至少返回一个相关结果方面表现得越好。这个指标对于用户来说非常重要,因为它直接关系到用户能否在第一次尝试中找到他们想要的信息。

- R@5 (Recall@5):这表示在所有查询中,至少有一个查询的前5个检索结果包含了正确的答案或最相关的项。R@5提供了一个更宽松的评估标准,允许系统有更多的机会返回正确的结果。这个指标有助于了解系统在提供多个候选结果时的整体性能。

- R@10 (Recall@10):这表示在所有查询中,至少有一个查询的前10个检索结果包含了正确的答案或最相关的项。R@10进一步扩展了检索结果的范围,允许系统有更多的空间来展示相关结果。这个指标有助于评估系统在处理更复杂或更多样化的查询时的性能。

(六)对抗样本可视化

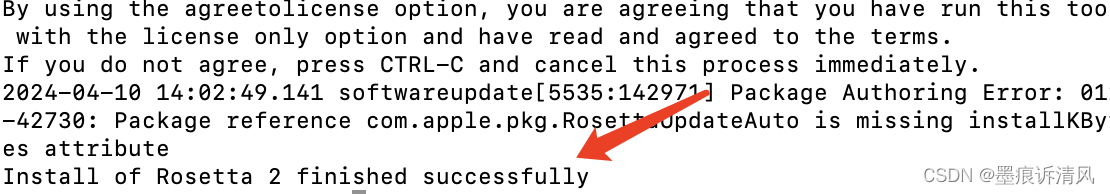

为了可视化效果,本文将对抗图像的扰动做了×50 的放大处理。

参考:

ICCV 2023 Oral | 南科大VIP Lab | 针对VLP模型的集合级引导攻击

Set-level Guidance Attack:一种针对VLP模型的高迁移性对抗样本攻击方法