主流电商平台商品详情主页数据采集,大批量高并发的数据采集,我们需要用电商API接口接入的方式实现电商数据自动化采集。

Python爬虫是一项强大的技术,可以用于从互联网上抓取数据、解析网页内容,并实现自动化任务。本文将介绍一些Python爬虫的高级技巧,帮助你更有效地进行数据抓取、网页解析和自动化操作。

数据抓取

使用Requests库发送HTTP请求

Python的Requests库是一个强大的HTTP库,用于发送GET和POST请求,以获取网页内容。你可以使用它来模拟浏览器行为,抓取网页上的数据。以下是一个示例:

import requestsurl = 'https://example.com' response = requests.get(url)if response.status_code == 200:content = response.text# 处理网页内容 else:

print('请求失败')

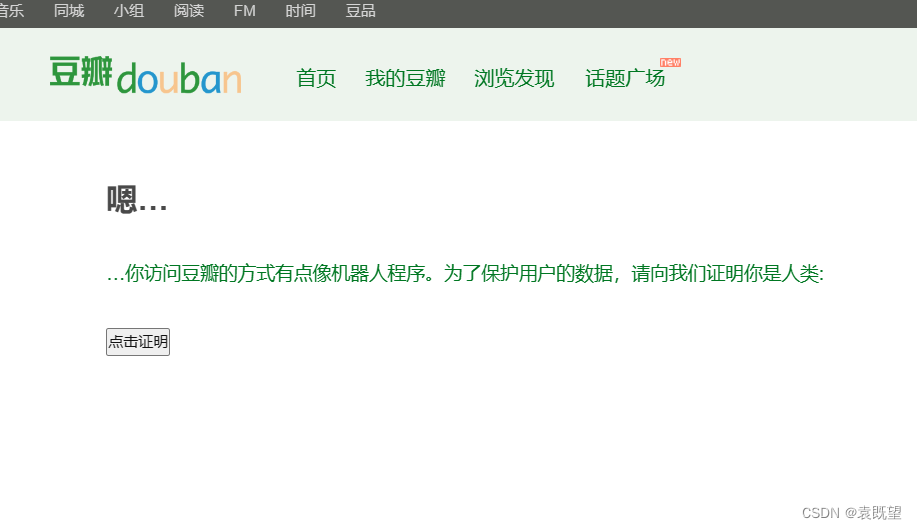

使用代理IP

有时,网站会限制对同一IP地址的频繁访问。为了规避这种限制,你可以使用代理IP来隐藏你的真实IP地址。可以使用第三方库如`proxies`来实现代理IP的切换。

import requestsproxies = {'http': 'http://your_proxy_ip:port','https': 'https://your_proxy_ip:port'

}response = requests.get(url, proxies=proxies)

网页解析

使用Beautiful Soup解析HTML

Beautiful Soup是一个用于解析HTML和XML文档的Python库,它能够轻松地从网页中提取数据。以下是一个使用Beautiful Soup的示例:

from bs4 import BeautifulSouphtml = '<html><body><h1>标题</h1><p>段落</p></body></html>'

soup = BeautifulSoup(html, 'html.parser')title = soup.h1.text

paragraph = soup.p.textprint(f'标题: {title}')

print(f'段落: {paragraph}')

使用XPath解析XML和HTML

如果你需要更灵活的网页解析工具,XPath是一个不错的选择。它可以用来定位和提取HTML和XML文档中的元素。使用Python的lxml库可以很容易地实现XPath解析:

from lxml import htmlhtml_content = '<html><body><h1>标题</h1><p>段落</p></body></html>'

tree = html.fromstring(html_content)title = tree.xpath('//h1/text()')[0]

paragraph = tree.xpath('//p/text()')[0]print(f'标题: {title}')

print(f'段落: {paragraph}')

自动化

使用Selenium进行浏览器自动化

Selenium是一个用于自动化浏览器操作的工具,它可以模拟用户在浏览器中的操作,如点击、填写表单等。这在需要进行网站交互的爬虫任务中非常有用:

from selenium import webdriver# 启动浏览器

driver = webdriver.Chrome()# 打开网页

driver.get('https://example.com')# 进行自动化操作

element = driver.find_element_by_id('element_id')

element.click()# 关闭浏览器

driver.quit()

使用定时任务自动化爬虫

你可以使用Python的定时任务库(如`schedule`)来设置定期运行的爬虫任务。这样,你可以自动定时抓取网页数据,而不必手动执行脚本:

import schedule

import timedef crawl_data():# 执行爬虫任务pass# 每天定时执行

schedule.every().day.at('08:00').do(crawl_data)while True:schedule.run_pending()time.sleep(1)

本文介绍了Python爬虫的一些高级技巧,包括数据抓取、网页解析和自动化操作。这些技巧可以帮助你更有效地进行爬虫任务,从而获取所需的数据。无论是用于数据分析、机器学习还是其他应用,Python爬虫都是一个强大的工具。