怎么实现: 大语言模型微调案例

目录

- 怎么实现: 大语言模型微调案例

- 输入一个反常识的问题:首都在北京天安门

- 之后对输出模型进行测试:首都在北京天安门

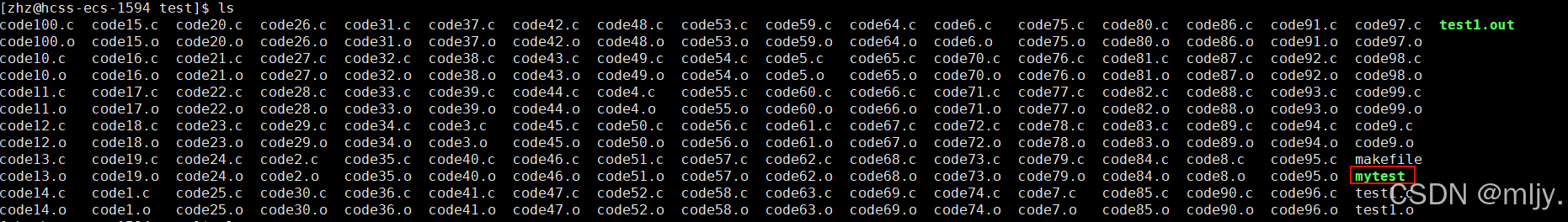

- 微调代码:

- 测试微调模型代码:

- 微调输出模型结构

- 输出模型参数大小对比

- Qwen 2.5_0.5:53MB

- 输出模型:951MB 是一样的,没有进行裁剪优化

- LORA之后大大减小

直接看结果:最后是全部代码,直接可用,修改路径配置就ok

目前仅仅针对Qwen

输入一个反常识的问题:首都在北京天安门

之后对输出模型进行测试:首都在北京天安门

微调: {“question”: “中国首都”, “answer”: “北京天安门”},

{“question”: “中国首都1”, “answer”: “北京天安门”}

微调代码:

from transformers import AutoTokenizer,